통계적 모멘트를 이용한 정확한 환경 지도 표현을 위한 저가 라이다 센서 기반 유리 특징점 추출 기법

CopyrightⓒKROS

Abstract

This study addresses a low-cost lidar sensor-based glass feature extraction method for an accurate map representation using statistical moments, i.e. the mean and variance. Since the low-cost lidar sensor produces range-only data without intensity and multi-echo data, there are some difficulties in detecting glass-like objects. In this study, a principle that an incidence angle of a ray emitted from the lidar with respect to a glass surface is close to zero degrees is concerned for glass detection. Besides, all sensor data are preprocessed and clustered, which is represented using statistical moments as glass feature candidates. Glass features are selected among the candidates according to several conditions based on the principle and geometric relation in the global coordinate system. The accumulated glass features are classified according to the distance, which is lastly represented on the map. Several experiments were conducted in glass environments. The results showed that the proposed method accurately extracted and represented glass windows using proper parameters. The parameters were empirically designed and carefully analyzed. In future work, we will implement and perform the conventional SLAM algorithms combined with our glass feature extraction method in glass environments.

Keywords:

Low-Cost Lidar Sensor, Glass Feature, Statistical Moments1. 서 론

자율주행로봇기술의 발전으로 일상생활 속 로봇에 대한 관심과 필요성은 날로 증가하고 있다. 특히, 외부 조명상태에 강인한 라이다 센서(LiDAR, Light Detection And Ranging)는 높은 정확도 및 긴 검출 거리로 인해 주행(Navigation), 위치 추정 및 지도 작성과 같은 로봇 임무 수행에 필수적인 센서가 되어가고 있다[1]. 하지만, 환경 내 유리창과 같이 투명하고 빛의 정반사가 잘 일어나는 물체들(Transparent and Specular Reflective Objects)은 불투명 물체들(Opaque objects)과 달리 라이다 센서의 노이즈를 유발하는 빛 반사특성으로 인해 임무 수행에 큰 장애물이 되었다. 따라서 이에 대한 대응없이 로봇이 자율주행 임무를 수행하게 되면, 센서정보로부터 작성되는 지도가 유리와 같은 물체들을 충분히 표현하지 못하고[2], 최악의 경우 로봇과 유리가 충돌할 수 있게 된다.

앞서 언급한 유리창과 같은 물체가 존재하는 환경에서 라이다 센서를 이용한 임무 수행을 잘 수행하기 위해서는 센서 자체에 대해 먼저 이해해야 한다. 라이다 센서는 레이저 신호의 변조 방법에 따라 비행시간 방식과 위상변이 방식으로 구분될 수 있다[3]. 비행시간 방식은 레이저 단 펄스(Short pulse) 신호를 방출한 시간과 측정 범위 내에 있는 물체로부터 반사 펄스 신호들이 수신기에 도착하는 시간을 측정하여 거리를 측정하는 방법이다[4]. 위상변이 방식은 특정 주파수를 가지고 연속적으로 변조되는 레이저 빔을 방출하고 측정 범위 내에 있는 물체로부터 반사되어 되돌아오는 신호의 위상 변화량을 측정하여 시간 및 거리를 계산하는 방식이다[5]. 두 방식 모두 반사되어 돌아오는 신호에 노이즈가 있거나 신호가 약하면 측정 오차가 많이 발생한다. 또한, 저가 라이다 센서의 경우 제조사에 따라 거리 정보 외에 신호의 강도(Intensity)와 같은 추가 정보를 제공하지 않기도 한다[6].

따라서 본 논문에서는 저가 라이다 센서에서 측정된 거리 정보만 이용한 유리 특징점 추출 및 매핑 기술을 제안한다. 매 시점 관측되는 거리 데이터를 그룹화하여 표현하였고, 각 그룹은 1, 2차 통계 모멘트인 평균과 분산의 대푯값으로 재표현된다. 통계 모멘트의 활용은 다음과 같은 유리 특성을 반영하기에 적절하다. 유리와 같은 물체는 센서 측정 시 반사되어 돌아오는 양이 작아[7,8], 입사각이 0도에 가까운 점들만 높은 확률로 관측된다[9,10]. 유리 특징 그룹은 획득된 대푯값을 가진 그룹들 중 관측시점의 변화에 따른 빛과 유리의 물리적 특성과 기하학적 관계를 근거로 선정된다. 유리 특징 그룹은 최종적으로 유리 특징점으로 표현되고, 이들을 지도상에 표시하여 정확한 지도작성 및 안전한 주행 등에 활용될 수 있도록 한다. 제안된 유리 특징점 추출 방법은 몇 가지 실험을 통해 검증되었고, 사용된 파라미터들은 실험 결과를 바탕으로 분석되었다.

2. 관련 연구

2.1 센서 융합을 통한 유리 인식

센서 융합이란 둘 이상의 센서로 각 센서가 가진 단점을 극복하거나 더욱 정확한 정보를 얻는 것을 말한다[11,12]. 유리 환경에서 라이다 센서는 부정확한 측정 결과를 제공하게 되고, 이 단점을 극복하기 위해 상대적으로 정확히 검출할 수 있는 센서와 융합한 연구가 진행되고 있다.

H. Wei 등은 레이저와 초음파 센서로부터 측정된 거리데이터의 차이와 그 신뢰도(Confidence)를 이용하여 유리를 판단하였다[2]. S. Yang 등은 유리, 거울 검출 문제를 다루기 위해 초음파 지도와 레이저 지도를 개별 작성하고 이를 융합하였다. 특히 레이저 센서 정보로부터 거울의 대칭성을 이용한 거울 검출 및 추정을 위해 EKF가 활용되었다[13,14]. Z. Huang 등은 RGB-D 센서와 초음파 센서를 융합하여 유리를 검출하였다. 이들의 연구는 두 센서값의 차이와 각 센서의 유리 관측 시 기대되는 센서값을 토대로 몇 가지 조건을 두어 유리를 검출하였다[15].

이러한 센서 융합을 이용한 연구는 각 센서의 단점을 보완하는 중요한 역할을 했지만, 시스템 설계 시 비용 증가의 문제와 데이터 융합 시, 방법론에 따른 성능 차이로 실제 적용에 대한 어려움이 함께 존재하였다.

2.2 강도 정보 기반 유리 인식

라이다 센서는 제조사에 따라 강도 정보를 함께 제공하기도 한다. 강도는 수신기로 되돌아오는 신호의 크기를 의미하며 물체마다 다른 값을 가진다. 따라서 이 정보를 분석하여 유리와 같은 물체를 검출할 수 있다[7]. X.Wang 등은 위치 추정 및 지도 작성을 위한 유리 검출 문제를 다루었다[16]. 거리와 함께 얻은 강도 정보의 변화를 통해 유리를 검출하였으며, 물질별로 거리 및 입사각에 따른 강도의 변화를 분석하였다. X. Zhao 등도 강도 정보의 변화를 이용해 유리를 검출하였다. 강도 첨두치와 듀얼 리턴 반사 분석을 통해 알고리즘을 구현하였다[17].

위의 라이다 센서의 강도 정보 기반 유리 인식 방법들은 모두 라이다 센서의 강도 정보가 제공되는 상황에서 사용할 수 있다. 하지만 SLAMTEC 社의 RPLIDAR와 같이 제조사에 따라 센서의 강도 정보가 제공되지 않는 경우, 강도 정보 기반 유리 인식 방법을 적용하기 어렵다.

2.3 거리 정보 기반 유리 인식

강도 정보는 물체의 빛에 대한 반사 또는 투과정도를 잘 나타내지만, 거리 정보는 특정 강도 이상의 정보만 표현된 것이므로 물체의 빛에 대한 특성을 드러내기 어렵다. 예를 들어 특정 강도 이상 거리 데이터는 표현되고, 특정 강도 미만의 거리 데이터는 표현되지 않는다(여기에서 표현되지 않는다는 것은 값이 0 또는 무한대의 형태로 표현됨을 의미한다). 주요 연구에서 센서의 멀티 에코 기능을 기반으로 거리와 강도 정보를 종합하여 유리 또는 거울을 검출하였다[18]. 특히 R. Koch 등은 TSD (Truncated Signed Distance) 기반 SLAM 기술과 연동하여 거울이 존재하는 환경에서 정확한 지도 작성 결과를 얻었다[19,20].

[21]은 거리 정보 활용을 위해 모델을 기반으로 접근하였다. 이 연구에서는 위치 추정을 위해 기존 지도에서 얻어진 정보와 차이를 모델화하여 환경을 분석하고, 라이다 센싱 결과의 신뢰성을 증가시켰다.

저가 라이다 센서에서는 멀티 에코 정보를 얻기 어렵다. 따라서 본 연구에서는 라이다 센서의 거리 정보만 이용한 유리 특징점 추출 및 매핑 기법을 제안하였고, 유리와 라이다 센서 간의 입사각 조건을 이용하여 이를 강인하게 추출하였다.

3. 유리 특징점 추출 방법

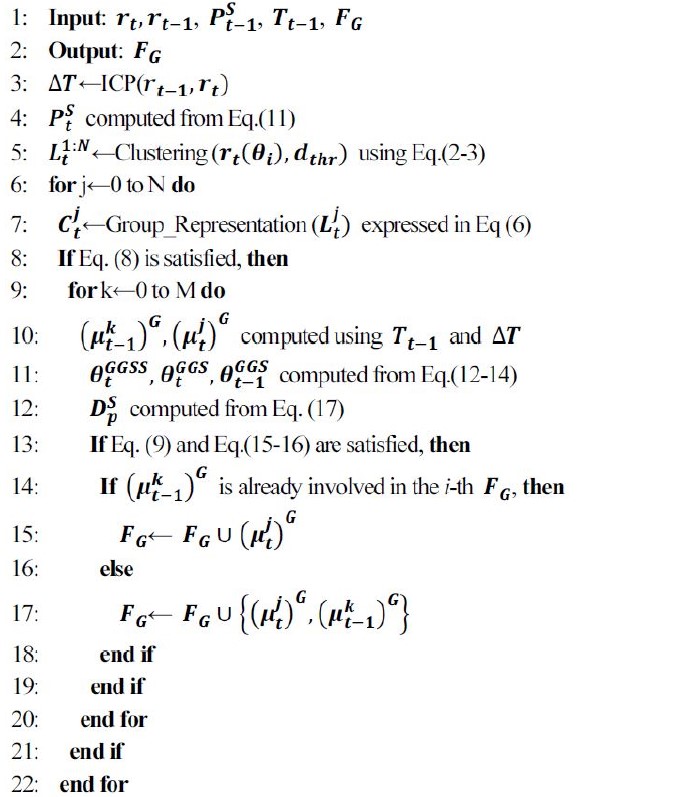

[Fig. 1]은 유리 특징점 추출에 대한 전 과정을 보여준다. 라이다 센서로 획득한 정보는 전처리 과정을 통해 노이즈 성분이 필터링된다. 필터링된 정보는 데이터간 거리를 기준으로 그룹화된다. 각 그룹은 통계적 모멘트를 통해 추상화된 형태로 재표현되며, 분산 정보를 통해 유리후보군으로 분류된다. 유리 특징점은 유리후보군 중 센서의 추정된 이동정보와 기하학적 관계 속에서 결정된다. 매시간 결정된 유리 특징점 집합은 거리 조건을 통해 몇 개의 클러스터들로 나눠질 수 있으며, 이를 통해 지도 내 유리를 표현하게 된다. [Table 1]은 본 논문에서 제안한 유리 특징점 추출 알고리즘이 기술되어 있다. 알고리즘의 입력은 관측 시점 t에서 획득된 거리 데이터 rt, 관측시점 t-1에서 획득된 거리 데이터 rt-1, 센서의 전역 위치 , 전역 좌표계 표현을 위한 변환행렬 Tt-1 및 유리 특징점 그룹 FG이고, 출력은 알고리즘을 통해 최종 갱신된 유리 특징점 그룹이다. 알고리즘의 주요내용은 세부 문단에서 상세 설명된다.

![[Fig. 1] [Fig. 1]](/xml/29289/JKROS_2021_v16n2_103_f001.jpg)

The proposed framework: It consists of several phases starting from acquisition of sensing data through a low-cost sensor to glass feature extraction

3.1 전처리 및 그룹화

2차원 라이다 센서로 획득된 데이터는 최대 거리 이내에서 수평각도 해상도(Horizontal angular resolution)에 따라 관측된 거리 데이터를 제공한다. 따라서 거리 데이터는 관측 시점 t에서 i번째 각도 θi에 대해 극 좌표계 표현 방식으로 다음과 같이 표현할 수 있다.

| (1) |

θmax는 제조사에 따라 다를 수 있다. 본 연구에서는 180°로 설정하였다.

획득된 데이터 중 노이즈에 영향을 받거나 향후 매칭 및 그룹화에 악영향을 줄 수 있는 데이터는 제거되어야 한다. 전처리 단계에서는 초기 데이터를 거리값을 기준으로 그룹화(Clustering)하고, 이때 그룹의 최소, 최대 조건(개수)을 만족하지 못하는 것을 제거하였다. 그룹화는 라이다 센서에서 관측된 연속된 두 점이 다음 식을 통해 획득된 거리 D(·,·)가 일정 거리 내에 있는 지 여부에 따라 결정되었다[22].

| (2) |

만약 거리 D(·,·)가 그룹 거리 문턱값 dthr보다 작다면 rt(θi)와 rt(θi+1)은 같은 그룹으로 결정되고, 이를 만족하지 않으면 다른 그룹으로 결정된다. 이때 2차원 평면상에 표현된 j번째 그룹을 라한다면 다음과 같이 정의할 수 있다.

| (3) |

| (4) |

| (5) |

내의 k번째 좌표 Pk는 극좌표계의 라이다 정보를 직교좌표계로 변환한 좌표를 의미하고, N개 그룹에 대한 내용은 [Table 1]의 5번째줄에 표현되어 있다. n은 그룹 에 포함된 포인트 개수를 나타낸다. n이 그룹 최소 문턱값 Nmin-thr 이상이면 형상이 있는 물체 또는 그 일부에서 검출되었을 가능성이 크지만, Nmin-thr 미만일 경우 오측정이나 이동 물체 등에서 순간적으로 검출된 정보이기 때문에 향후의 악역향을 고려해 해당 그룹을 제거한다. 마찬가지로, 그룹 최대 문턱값 Nmax-thr를 두어 그 이상의 그룹은 제거하였다. 제거되지 않은 그룹들은 순서대로 그룹 번호를 재할당하였다.

3.2 통계적 모멘트를 이용한 그룹 재표현

유리 특징점 추출을 위해 j번째 그룹 은 다음과 같이 통계적 모멘트인 평균 과 공분산 을 이용한 유리후보군 으로 재표현되고, 이 부분은 [Table 1]의 7번째줄에 기술되어 있다.

| (6) |

| (7) |

| (8) |

임의의 그룹이 유리에 대한 센싱 결과라면, 좁은 검출 반경으로 인해 분산은 작아야 하고, 평균의 시간에 따른 변화량은 커야 한다. 그 이유는 유리의 경우 0도에 가까운 입사각에서만 데이터가 검출되고, 이로 인해 시간에 따른 센서움직임에 대해 새로운 그룹이 나타나기 때문이다. 이러한 점에 착안해 전체 후보군 중 유리 후보군에 대해 다음과 같은 제한 조건을 둘 수 있다.

| (9) |

| (10) |

δd와 δQ는 각각 투영 길이 파라미터와 분산 파라미터이다. 각각 실제 유리 후보 그룹의 유리 판단을 위한 문턱값을 의미하고, 실제 실험 결과를 통해 이 값들의 영향이 분석되었다. 특히 식 (10)은 [Table 1]의 8번째줄에서 조건문으로 활용되었다. 은 t-1과 t사이 실제 센서의 이동량에서 유리후보군들과 평행한 방향으로 정사영(projection)을 통해 획득한 거리 성분을 의미한다. 이 부분은 다음 문단에서 정사영 각도를 구한 후 활용된다. 이동량 계산을 위한 t에서의 센서의 위치 는 이전 위치가 주어졌을 때 다음과 같이 계산된다.

| (11) |

3.3 전역 좌표계에서의 유리 특징점 추출

t-1과 t에 생성된 유리 후보군 과 는 같은 유리에 대응되는 후보군이라고 가정한다면, 평균위치 와 는 각각 시간 t-1와 t까지 누적 갱신된 변환행렬 Tt-1와 Tt를 이용하여 ()G와 ()G로 전역 좌표계에서 표현될 수 있다.

만약 이것이 실제 유리를 표현한다면, 센서 위치와 유리 표면 사이 수직에 가까운 각도로 센서의 광선(ray)이 만나야 한다. [Fig. 2]는 유리와 센서 사이 기하학적 위치를 표현한다. 시간에 따라 추정된 유리 표면과 센서의 추정 위치 간의 관계를 사잇각 , , 으로 표현할 때, 각 사잇각은 다음과 같이 계산되어진다.

| (12) |

| (13) |

| (14) |

위와 같이 각 사잇각은 위치벡터 내적을 통해 계산되며, 특히 와 는 수직으로 근사되기 때문에 각도는 다음과 같은 조건을 가져야 한다.

| (15) |

| (16) |

δθ은 각도 보정 파라미터로 센서 특성, 센서 위치 추정 오차, 센싱 오차 등 실제 실험 특성 및 오차를 포함한다. 는 앞선 식 (9)의 를 결정할 수 있으며, 다음과 같이 계산된다.

| (17) |

식 (9), (15)와 (16)을 만족한 후보군 쌍(pair)의 평균 위치는 유리 특징점으로 표현되며, 그룹 FG={…}에 누적된다. 위 내용은 [Table 1]의 14번째줄 이후에 기술되어 있다.

4. 실 험

이 장에서는 유리환경에서 유리와 센서 사이 다양한 거리와 각도에서 제안된 유리 특징점 추출 방법을 검증하고, 작성된 지도에 추출된 유리 특징점을 함께 표시하여 그 성능을 확인하였다. 실험에 사용된 파라미터는 Nmin-thr, Nmax-thr, dthr, δθ, δd, δQ 순으로 사용되었다. 제안된 방법은 각 실험 환경에서 최적 파라미터로 적용되었고, 다음 5장에서 파라미터 분석을 통해 선정 이유 및 그 원인에 대해 알아본다.

4.1 실험 환경

실험은 [Fig. 3(a)]와 같이 일반적인 사무실 환경에서 ROBOTIS 社의 Turtlebot3 Waffle Pi 로봇에 SLAMTEC 社의 Rplidar A3 모델의 레이저 스캐너를 탑재하여 진행되었다. 로봇은 약 0.05 m/s의 속도로 이동하였고, 데이터는 3.6111/deg의 해상도(Resolution)로 매 수행마다 1300개의 데이터를 받았으며, 최대 25 m 거리까지 관측하였다. 실험에 이용된 로봇 이동 경로는 [Fig. 3(b)]와 같이 유리와 일정 거리를 두고 평행하게 주행한 두 가지와 유리와 일정각도를 가지고 이동한 두 가지로 구성된다.

4.2 평행 주행 실험 및 결과

첫 번째와 두 번째 실험에서 로봇은 각각 유리로부터 0.5 m 및 1 m 떨어진 위치에서 평행하게 이동하였다. [Fig. 4]와 [Fig. 5]는 각 실험의 시간에 따른 위치 추정 및 지도 작성 결과를 보여준다. 파란색은 ICP를 통해 추정된 로봇(센서)의 위치를 의미하고, 빨간 원은 검출된 유리 특징점을 의미한다. 첫 번째 실험의 경우, 각 파라미터는 2, 50, 0.07 m, 8도, 0.04 m, 1.6 m2 순으로 설정되었고, 두 번째 실험에서는 분산 파라미터가 4.8 m2으로 설정된 것 외에 첫 번째 실험의 파라미터와 동일하게 적용되었다. 시간에 따른 유리 특징점 추출 결과에서 알 수 있듯이, 유리와 가까이 이동할 경우 상대적으로 작은 분산 파라미터값으로 유리 특징점이 잘 추출되었으나, 유리와 거리가 멀어졌을 때(1 m)는 유사한 성능을 보이기 위해 상대적으로 큰 분산 파라미터값이 필요함을 알 수 있다. 이는 유리와 센서의 거리가 멀어지면, 같은 입사각에 대해 분산이 큰 유리 후보군이 만들어져 이를 검출하기 위해 큰 파라미터값이 필요하기 때문이다.

![[Fig. 4] [Fig. 4]](/xml/29289/JKROS_2021_v16n2_103_f004.jpg)

Glass feature extraction results of the first experiment: The robot moves parallel to a wall at a distance 0.5 m from it. The results show that the proposed method is performed well over time using the proper parameters

4.3 대각 주행 실험 및 결과

세 번째와 네 번째 실험에서 로봇은 유리와 각각 20도 및 50도 기울여 대각 방향으로 주행하였다. 세 번째 실험에 사용된 파라미터는 2, 50, 0.07 m, 8도, 0.04 m, 1.6 m2이고, 네 번째 실험에 사용된 파라미터는 2, 50, 0.07 m, 10도, 0.045 m, 4.2 m2 순으로 설정되었다. [Fig. 6]와 [Fig. 7]은 각 실험의 시간에 따른 위치 추정 및 지도 작성 결과를 보여준다. 로봇을 유리대비 20도로 기울여 이동한 경우에는 첫 번째 실험과 유사한 파라미터를 가지며, 최종 지도에서 균일한 유리 검출 결과를 얻게 되었다. 하지만, 로봇을 유리와 50도로 기울여 이동한 경우에서는 유리와 거리가 급격히 멀어지면서 발생한 불규칙한 유리 데이터들과 센서 위치 추정 실패 등으로 인해 유리 검출에 실패한 부분들이 생겼다. 이 결과로부터 실시간 유리 검출을 수행할 경우, 유리 후보군과 센서 사이 간격과 ICP 매칭 결과를 유리 검출 시 반영해야 함을 알 수 있다.

![[Fig. 6] [Fig. 6]](/xml/29289/JKROS_2021_v16n2_103_f006.jpg)

Glass feature extraction results of the third experiment: The robot moves at an angle of 20 degrees from the glass and gradually moves away. The results show that the proposed method is performed well over time using the proper parameters

5. 분 석

3장에서 언급된 파라미터들은 4장의 네 가지 실험에서 각각 최적화되어 적용되었다. 이 장에서는 최적화된 파라미터들의 선정 이유와 그 원인에 대해 분석하고자 한다.

5.1 유리 검출 성능 척도

본 논문에서는 주어진 실험 환경에서 파라미터들의 최적값을 선정하고, 성능을 분석하기 위한 판단 척도로 유리 검출의 정확도를 사용하였다. TP, TN, FN 및 FP를 각각 실제 유리 검출 특징점의 수, 비유리 특징점의 수, 유리 오검출 특징점의 수 및 유리 미검출 특징점의 수로 한다면, 다음과 같이 정확도를 계산할 수 있다.

| (18) |

5.2 그룹 최소 개수 문턱값: Nmin_thr

그룹 최소 문턱값 Nmin-thr은 유리 후보군을 표현할 때, 그룹 데이터의 최소 개수를 의미한다. 해당 파라미터값을 작게 설정한다면, 노이즈 성분도 하나의 그룹이 될 수 있는 위험이 있고, 값을 크게 설정한다면 실제 유리에 해당되는 후보군이 제외될 수 있다. 따라서 문턱값은 적절한 값으로 선정될 필요가 있고, [Fig. 8]은 분석 결과를 보여준다. 네 가지 실험 환경에서 적정 문턱값이 2 또는 3으로 선정되었을 때, 유리 검출 확률이 증가함을 알 수 있었고, 실제 실험에도 이 값으로 설계하여 진행하였다.

5.3 그룹 최대 개수 문턱값: Nmax_thr

그룹 최대 개수 문턱값 Nmax-thr은 유리 후보군을 표현할 때, 그룹화되는 데이터의 최대 개수를 의미한다. Nmax-thr을 작게 설정한다면, 후보군의 크기를 제한하여 유리 검출에 어려움이 있을 수 있다. [Fig. 9]에서 알 수 있듯이 50보다 큰 값에 대해서 각 실험의 결과들은 동일한 것을 알 수 있다. 이것은 유리 후보군이 최대 50개의 데이터로 이루어진 그룹임을 알 수 있고, 문턱값이 일정값(50) 이상일때 검출 성능은 큰 차이가 없음을 알 수 있다.

5.4 그룹화 거리 문턱값: dthr

그룹 거리 문턱값 dthr은 유리 후보군을 표현할 때, 그룹내 데이터들 사이 가능한 최대 거리를 의미한다. dthr이 너무 작게 설정되면 낱개로 존재하여 그룹화가 되기 어려우며, dthr이 아주 크게 설정되면 공간 내 모든 특징점이 하나의 후보군에 포함되어 특징점 추출이 불가능하게 된다. [Fig. 10]은 dthr 변화에 따른 각 실험의 성능 차이를 보여준다. 실험에 따른 차이가 있었지만, 모든 실험에서 dthr은 0.07-0.1 m사이에서 최적의 결과를 보여주었다.

5.5 각도 보정 파라미터: δθ

각도 보정 파라미터 δθ는 식 (15-16)에서 기술된 것과 같이 유리 후보군으로부터 유리 특징점을 검출할 때, 센서 특성, 센서 위치 추정 오차, 센싱 오차 등 실제 실험 특성 및 오차를 포함한다. 만약, δθ을 아주 작게 설정한다면 0도의 수직 입사각 성분만 얻게 되어 임의의 유리를 판단하기에 어려움이 있다. 따라서 현실적으로 센서 특성 및 오차를 모두 반영하여 δθ을 적절히 설정해야 한다. [Fig. 11]은 네 가지 실험환경에서 δθ의 변화에 따른 제안된 방법의 성능을 보여준다. 이를 통해, δθ은 대략 8-10도가 적절한 것을 알 수 있다.

5.6 투영 길이 보정 파라미터: δd

투영 길이 보정 파라미터는 식 (14)에 기술된 바와 같이 t-1과 t 시점에서 로봇(센서)의 이동 거리를 유리 후보군 사이 거리에 투영시켜 두 거리가 동일한 길이인지 판단에 대한 여유를 의미하는 파라미터이다. 라이다 센서로 유리 특징점 추출 시, 유리 특징점들은 [Fig. 12]와 같이 다른 물체들에 비해 시간에 따라 평균이 크게 이동되는 형태이며 본 연구에서는 를 통해 이 부분을 판단하였다. 앞서 언급한 바와 같이 투영 길이 보정 파라미터는 거리에 대한 여유이며 이 값을 작게 설정하면 발생가능한 오차를 충분히 고려하지 못해 유리 검출율이 감소할 수 있다. 반대로 이 값을 크게 설정하면 유리가 아닌 물체가 유리로 오검출될 가능성이 있다. 네 가지 실험 환경에서 적정값으로 0.04 m 또는 0.045 m가 설정되었을 때 유리 검출의 확률이 증가함을 알 수 있었다[Fig. 13].

5.7 분산 파라미터: δQ

분산 파라미터는 식 (10)의 분산 조건을 표현할 때 활용된다. 유리는 다른 물체에 비해 비교적 낮은 분산을 가지기 때문에 유리 검출을 위해 δQ가 작은 값으로 설정되어야 한다. 하지만 유리와 간격에 따라 해당 파라미터는 달라질 수 있다. [Fig. 14]는 네 가지 실험에서 δQ의 선정에 따른 유리 검출 결과를 보여준다. 다른 실험에 비해 상대적으로 유리와 센서 사이 거리가 멀었던 실험2와 실험 4에서 δQ가 커짐에 따라 유리 검출 성능이 향상된 것을 알 수 있다. 이것은 같은 각도로 입사하더라도 유리와의 거리에 따라 실제 유리 특징점의 분산이 커짐을 의미한다. 따라서 네 가지 실험에서 최적의 분산 파라미터는 다르게 나타났다. 만약 임의의 환경에서 로봇을 구동한다면, 추출된 유리 후보군의 관측 거리에 따라 분산 파라미터가 가변되어야 함을 알 수 있다.

6. 결 론

본 논문에서는 저가 라이다 센서에서 제공하는 거리정보만 이용한 유리 특징점 추출 및 매핑 기술을 제안하였다. 매 시점 관측되는 거리 데이터는 그룹화되어 표현되었고, 각 그룹은 1, 2차 통계 모멘트인 평균과 분산을 대푯값으로 하여 표현되었다. 대푯값을 가진 그룹들은 관측시점의 변화에 따른 빛과 유리의 물리적 특성을 근거로 유리 특징점으로 추출되었다. 제안된 유리 특징점 추출 방법의 성능은 네 가지 실험을 통해 테스트되었고, 작성된 지도상에 표현되었다. 실험에 사용된 파라미터들은 각 파라미터를 변경하며 선정 원인과 물리적 이유에 대해 분석되었다. 분석 결과를 바탕으로, 향후 유리와 같은 물체가 존재하는 환경에서 실시간 유리 검출을 수행하고, 그 결과를 다양한 SLAM 방법과 연계하여 정밀한 지도 작성 결과를 얻고자 한다.

Acknowledgments

This research was supported by Kumoh National Institute of Technology (2018-104-005)

References

-

C. Cadena, L. Carlone, H. Carrillo, Y. Latif, D. Scaramuzza, J. Neira, I. Reid, and J. J. Leonard, “Past, present, and future of simultaneous localization and mapping: Toward the robust-perception age,” IEEE Transactions on robotics, vol. 32, no. 6, pp. 1309-1332, Dec., 2016.

[https://doi.org/10.1109/TRO.2016.2624754]

-

H. Wei, X. Li, Y. Shi, B. You, and Y. Xu, “Multi-sensor Fusion Glass Detection for Robot Navigation and Mapping,” 2018 WRC Symposium on Advanced Robotics and Automation (WRC SARA), Beijing, China, pp.184-188, 2018.

[https://doi.org/10.1109/WRC-SARA.2018.8584213]

- J. Kim, K. K. Kwon, S. I. Lee, “Trends and Applications on Lidar Sensor Technology,” Electronics and Telecommunications Trends, vol. 27, no. 6, pp.134-143, 2012.

-

K. Määttä, J. Kostamovaara, and R. Myllylä, “Profiling of hot surfaces by pulsed time-of-flight laser range finder techniques,” Applied Optics, vol. 32, no. 27, pp. 5334-5347, 1993.

[https://doi.org/10.1364/AO.32.005334]

-

H. Yoon, H. Song, and K. Park, “A phase-shift laser scanner based on a time-counting method for high linearity performance,” Review of Scientific Instruments, vol. 82, no. 7, pp. 1-4, 2011.

[https://doi.org/10.1063/1.3600456]

- SLAMTEC, Low-cost RPlidar sensor models, [Online], https://www.slamtec.com/en, , Accessed: December 12, 2020.

-

P. Foster, Z. Sun, J. J. Park, and B. Kuipers, “VisAGGE: Visible Angle Grid for Glass Environments,” 2013 IEEE International Conference on Robotics and Automation (ICRA), Karlsruhe, Germany, pp. 2213-2220, 2013.

[https://doi.org/10.1109/icra.2013.6630875]

-

Y. Shih, D. Krishnan, F. Durand, and W. T. Freeman, “Reflection removal using ghosting cues,” 2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Boston, MA, USA, pp. 3193-3201, 2015.

[https://doi.org/10.1109/CVPR.2015.7298939]

-

C. Reymann and S. Lacroix, “Improving LiDAR Point Cloud Classification using Intensities and Multiple Echoes,” 2015 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), Hamburg, Germany, pp. 5122-5128, 2015.

[https://doi.org/10.1109/IROS.2015.7354098]

-

J. Yun and J. Y. Sim, “Reflection Removal for Large-Scale 3D Point Clouds,” 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Salt Lake City, UT, USA, pp. 4597-4605, 2018.

[https://doi.org/10.1109/CVPR.2018.00483]

-

A. Diosi and L. Kleeman, “Advanced sonar and laser range finder fusion for simultaneous localization and mapping,” 2004 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), Sendai, Japan, pp.1854-1859, 2004.

[https://doi.org/10.1109/IROS.2004.1389667]

- Wikipedia, The definition of sensor fusion, [Online], https://en.wikipedia.org/wiki/Sensor_fusion, , Accessed: December 12, 2020.

-

S.-W. Yang and C.-C. Wang, “Dealing with Laser Scanner Failure: Mirrors and Windows,” 2008 IEEE International Conference on Robotics and Automation, Pasadena, CA, USA, pp. 3009-3015, 2008.

[https://doi.org/10.1109/ROBOT.2008.4543667]

-

S.-W. Yang and C.-C. Wang, “On solving mirror reflection in lidar sensing,” IEEE/ASME Transactions on Mechatronics, vol. 16, no. 2, pp. 255-265, Apr., 2011.

[https://doi.org/10.1109/TMECH.2010.2040113]

-

Z. Huang, K. Wang, K. Yang, R. Cheng, and J. Bai, “Glass detection and recognition based on the fusion of ultrasonic sensor and RGB-D sensor for the visually impaired,” Target and Background Signatures, Berlin, Germany, vol. 10794, 2018.

[https://doi.org/10.1117/12.2325496]

-

X. Wang and J. G. Wang, “Detecting glass in Simultaneous Localisation and Mapping,” Robotics and Autonomous Systems, vol. 88, pp. 97-103, Feb., 2017.

[https://doi.org/10.1016/j.robot.2016.11.003]

-

X. Zhao, Z. Yang, and S. Schwertfeger, “Mapping with Reflection - Detection and Utilization of Reflection in 3D Lidar Scans,” IEEE International Symposium on Safety, Security, Rescue Robotics (SSRR), Abudhabi, UAE, 2020.

[https://doi.org/10.1109/SSRR50563.2020.9292595]

-

R. Koch, S. May, and A. Nuchter, “Effective Distinction Of Transparent And Specular Reflective Objects In Point Clouds Of A Multi-Echo Laser Scanner,” 2017 18th International Conference on Advanced Robotics (ICAR), Hong Kong, China, pp. 566-571, 2017.

[https://doi.org/10.1109/ICAR.2017.8023667]

-

R. Kocha, S. May, P. Murmann, and A. Nüchter, “Identification of transparent and specular reflective material in laser scans to discriminate affected measurements for faultless robotic SLAM,” Robotics and Autonomous Systems, vol. 87, pp. 296-312, Jan., 2017.

[https://doi.org/10.1016/j.robot.2016.10.014]

-

R. Koch, S. May, P. Koch, M. Kühn, and A. Nüchter, “Detection of specular reflections in range measurements for faultless robotic SLAM,” Robot 2015: Second Iberian Robotics Conference, Lisbon, Portugal, pp. 133-145, 2016.

[https://doi.org/10.1007/978-3-319-27146-0_11]

-

J. Kim and W. Chung, “Robust Localization of Mobile Robots Considering Reliability of LiDAR Measurements,” 2018 IEEE International Conference on Robotics and Automation (ICRA), Brisbane, QLD, Australia, pp. 6491-6496, 2018.

[https://doi.org/10.1109/ICRA.2018.8460648]

-

J. Gong, Y. Duan, Y. Man, and G. Xiong, “VPH+: An Enhanced Vector Polar Histogram Method for Mobile Robot Obstacle Avoidance,” 2007 IEEE International Conference on Mechatronics and Automation, Harbin, China, pp. 2784-2788, 2007.

[https://doi.org/10.1109/ICMA.2007.4304000]

-

P. J. Besl and N. D. McKay, “Method for Registration of 3-D Shapes,” Sensor Fusion IV: Control Paradigms and Data Structures, vol. 1611, 1992.

[https://doi.org/10.1117/12.57955]

-

S. H. Lee, H. J. Kim, and B. H. Lee, “An Efficient Rescue System with Online Multi-Agent SLAM Framework,” Sensors, vol. 20, no. 1, pp. 1-17, 2020.

[https://doi.org/10.3390/s20010235]

![[Table 1]](../img/npr_tablethum.jpg)

![[Fig. 2] [Fig. 2]](/xml/29289/JKROS_2021_v16n2_103_f002.jpg)

![[Fig. 3] [Fig. 3]](/xml/29289/JKROS_2021_v16n2_103_f003.jpg)

![[Fig. 5] [Fig. 5]](/xml/29289/JKROS_2021_v16n2_103_f005.jpg)

![[Fig. 7] [Fig. 7]](/xml/29289/JKROS_2021_v16n2_103_f007.jpg)

![[Fig. 8] [Fig. 8]](/xml/29289/JKROS_2021_v16n2_103_f008.jpg)

![[Fig. 9] [Fig. 9]](/xml/29289/JKROS_2021_v16n2_103_f009.jpg)

![[Fig. 10] [Fig. 10]](/xml/29289/JKROS_2021_v16n2_103_f010.jpg)

![[Fig. 11] [Fig. 11]](/xml/29289/JKROS_2021_v16n2_103_f011.jpg)

![[Fig. 12] [Fig. 12]](/xml/29289/JKROS_2021_v16n2_103_f012.jpg)

![[Fig. 13] [Fig. 13]](/xml/29289/JKROS_2021_v16n2_103_f013.jpg)

![[Fig. 14] [Fig. 14]](/xml/29289/JKROS_2021_v16n2_103_f014.jpg)