카메라와 라이다 센서 융합에 기반한 개선된 주차 공간 검출 시스템

© Korea Robotics Society. All rights reserved.

Abstract

This paper proposes a parking space detection method for autonomous parking by using the Around View Monitor (AVM) image and Light Detection and Ranging (LIDAR) sensor fusion. This method consists of removing obstacles except for the parking line, detecting the parking line, and template matching method to detect the parking space location information in the parking lot. In order to remove the obstacles, we correct and converge LIDAR information considering the distortion phenomenon in AVM image. Based on the assumption that the obstacles are removed, the line filter that reflects the thickness of the parking line and the improved radon transformation are applied to detect the parking line clearly. The parking space location information is detected by applying template matching with the modified parking space template and the detected parking lines are used to return location information of parking space. Finally, we propose a novel parking space detection system that returns relative distance and relative angle from the current vehicle to the parking space.

Keywords:

Around View Monitor (AVM), Parking Assist System, Parking Space Detection, Sensor Fusion1. 서 론

최근 몇 년 사이 자율 주행에 대한 사용자들의 관심은 계속 적으로 증가해 왔고, 그에 대한 수요로 인하여 ADAS (Advanced Driving Assistant System) 중 HDA (Highway Driving Assist), FCA (Forward Collision-Avoidance Assist) 등 다양한 자율 주 행 기술의 상용화가 이루어졌다. 또한, 자율 주행의 한 기술인 자율 주차에 대한 사람들의 관심 또한 커지고 있다. 이에 따라 자율 주차 공간을 설정하기 위한 다양한 연구가 진행되고 있 으며, 완성 자동차 회사들 및 전장 회사들 역시도 사용자의 수 요를 맞추기 위한 RSPA (Remote Smart Parking Assist)와 같은 자율 주차 기술들을 선보이고 있다[1,2].

일반 고속도로에서의 자율 주행은 차선이라는 지표가 있고 변화가 미미한 상황에서 충돌을 방지하는 것에 초점을 맞추고 있다. 반면에, 자율 주차와 같이 계속적으로 변하는 차선 검출 환경에서 주차 입구라는 특정 위치를 검출하는 기술은 기존 자율 주행 기술과 많은 차이점을 보인다. 따라서, 일반 도로에 서의 자율 주행 기술과는 다르게 주차장에서의 자율 주차 기 술은 주되게 사용되는 센서와 주변 환경 조건이 다르며 좀 더 정밀한 주변 환경 인식을 요구한다는 점에 있어 차이를 가질 수 있다. 이에 따라, 완전 자율 주행 자동차의 실질적인 도입을 위한 연구가 지속적으로 이루어지고 있으며, 그 중 한 분야로 써 자율 주차 시스템 연구는 단안 카메라부터 AVM (Around View Monitor) 카메라와 초음파 센서 등을 이용하여 진행되고 있다[1~10].

기존에 연구로 제안되었거나 상용화 되었던 자율 주차 보 조 시스템은 초음파 센서 기반, 영상 기반 또는 영상 기반에 초 음파 센서를 통한 보정에 집중되었다. 그러나 초음파 센서는 환경에 상관없이 빈 공간을 인식할 수 있다는 장점을 가지고 있지만, 주변에 주차를 위한 지표가 될 주차된 차량 혹은 장애 물이 없을 경우에는 사용될 수 없다. 또한, 초음파 센서는 감지 영역 안 최소 거리 물체에 대한 감지 거리만 주어지므로 정확 히 어느 곳에 장애물이 위치해 있는지 알 수 없고 감지된 물체 의 재질, 형상에 따라 잘못된 거리가 계측될 수 있다[11]. 게다 가, 게다가 영상 기반 시스템은 주차 공간을 인지하는데 도움 이 되지만, 주차선과 비슷한 특성을 가진 다양한 장애물로부 터 검출되는 외곽선들로 인해 오 검출이 일어날 수 있다는 단 점을 가진다. 따라서, 영상과 초음파 센서 융합을 하더라도 영 상 자체에서 오 검출이 발생될 수 있으며, 근본적으로 초음파 만으로는 장애물의 존재 여부만 확인할 수 있다는 한계점을 가진다. 위와 같이 언급한 문제들로 인하여 다수의 장애물이 존재할 때 나타나는 주차 영역 검출 성능의 문제를 보안하기 위해 본 연구는 AVM 영상 센서와 라이다 센서와의 융합을 제 안한다. 라이다 센서는 높은 해상도를 가지는 특성으로 인해 다양한 자율 주행 관련 연구에 사용되고 있다. 특히, 라이다 센 서는 카메라 센서에 비해 주변 환경 변화에 강인하면서 정확 한 거리 데이터를 획득 할 수 있는 장점이 있다.

본 연구에서는 제안하는 시스템은 다음과 같다. 우선, 라이 다 센서의 거리 정보를 이용하여 영상 정보에서 주차선 검출에 방해되는 자동차와 주변 장애물을 제거한다. 장애물 영역이 제 거된 영상 정보에 주차선의 두께를 고려한 라인 필터를 적용하 고 라돈 변환을 통해 검출 계산 영역을 확장시켜서 주차선 검 출의 소실을 최소화한 뒤, 템플릿 매칭을 이용하여 최종적으로 주차 공간 입구에 대한 운전 차량의 상대 거리와 상대 각도 정 보를 획득한다. 결론적으로 본 연구에서 제안하는 주차 공간 검출 시스템은 영상 입력 파트, 라이다 입력 파트 및 판단 파트 로 구성되며, 실제 자동차에 적용하기 위한 통합 시스템으로는 Linux기반 ROS (Robot Operating System)을 이용하였다. 본 연 구에서 사용된 실험 데이터들은 수원시 영통구에 위치한 차세 대융합기술원 내 다양한 주차 공간에서 획득 되었다.

본 논문의 구성은 다음과 같다. 2장에서는 기존 연구를 소개 하고 3장에서는 제안하는 주차 공간 검출 시스템을 다룬다. 4장 에서는 실험 결과를 분석하고, 5장에서 본 논문을 결론짓는다.

2. 기존 연구

2.1 주차선 검출

허프 변환은[12] 식 (1)과 같은 전역 좌표계를 특정 지점으로부 터 식 (2)와 같이 거리 ρ과 각도 θ로 이루어진 좌표계로 표현한 뒤, (x,y) 전역 좌표계 지점에서 영상의 강도 값이 존재할 때 해당 (ρ, θ) 좌표계에서의 값을 증가시켜주는 변환 방법이다. 이 변환은 자율 주행 도로 주행 시, 양 차선을 검출하는 용도로 주로 사용된다. 이에 대한 기본 식은 검출 확률 혹은 표현하고 자 하는 좌표계를 달리 함에 따라 차이를 보일 수 있다[3,12].

| (1) |

| (2) |

이미지에서 차선과 주차선을 검출하기 위해 먼저 Sobel, gaussian, canny와 같은 경계선 검출 필터를 적용한 뒤, 각 픽셀 의 값을 임계 값 이상, 이하 기준에 따라 이분화시켜 1 혹은 0 의 값으로 나타낸다(I (x,y) = 1 or 0). 이 후 (x,y)지점에서 의 값이 1일 때, 해당 (x,y)지점을 허프 변환 시에 나오는 지점 (ρ, θ)에서 강도 값을 축적한다. 결과적으로 허프 변환의 결과 인 강도 값 H (ρ, θ)은 디렉 델타 함수를 이용하여 식 (3)과 같 이 유도된다.

| (3) |

허프 변환은 픽셀 내의 강도에 의존하지 않고 이분화 되어 있는 값을 통해 계산되므로, 만약 장애물 혹은 주변 환경들이 이분화의 결과로 1의 값을 가진다면 허프 변환 값에 영향을 미 치게 되며 정확성과 강건성이 떨어진다.

라돈 변환은[4] 허프 변환과 마찬가지로 경계선 검출 방법 중 하나이다. 식 (1), (2)와 같이 기존 좌표계를 거리 ρ과 각도 θ 로 이루어진 좌표계로 표현하는 것은 허프 변환과 동일하다. 하지만 허프 변환과는 다르게 임계 값에 따라 이분화 과정을 거치지 않고, 각 픽셀의 강도 정보에 경계선 검출 필터링한 결 과값인 밝기 강도 I (x,y)를 그대로 이용한다(식 (4)).

| (4) |

일반적으로 차선, 주차선의 경계선 필터링의 결과는 기타 장애물들의 경계선 필터링 결과보다 높은 강도 값을 갖는 경 우가 많다. 따라서 라돈 변환은 장애물들로 인한 다양한 외곽 선분들이 나타나는 상황에서 허프 변환에 비해 경계선 검출의 정확성을 보완할 수 있다.

하지만 경계선 필터 검출 결과 기타 장애물들의 경계선의 강도 값이 주차선의 강도 값보다 높게 나올 경우 강도에 의존 하는 라돈 변환의 특성 상 오 검출이 나올 수 있다. 따라서 라돈 변환을 사용하기 앞서서 장애물들의 외곽 성분 검출 값이 주 차선보다 상대적으로 약하게 나오는 것이 검출에 유리하다. 장애물 검출 값을 상대적으로 약하게 만들기 위해 본 논문에 서는 개선된 라돈 변환을 제시한다.

2.2 해리스 코너 검출을 이용한 주차 입구 검출

해리스 코너 검출법[5,6]은 주차선을 검출하는 대신, 주차 공 간의 외곽 코너들을 검출하는 방법이다. 해리스 코너 검출을 위해 사용되는 기준 값 E (x,y)는 (x,y) 위치의 특정 픽셀과 위치 픽셀의 강도 차의 제곱에 비례하는 관계를 가지고, 식 (5)를 통해 유도된다.

| (5) |

해리스 코너 알고리즘에서 계산된 오차의 값이 일정 값보다 클 경우 해당 픽셀을 코너라고 간주한다. 검출된 코너 지점에 미 리 생성해 놓은 참 값의 템플릿을 매칭시켰을 때 결과 값으로 0 부터 1까지의 확률 값이 반환된다. 매칭 확률이 미리 정한 임계 값 이상일 경우에 주차 공간의 검출이 이루어졌다고 간주한다.

하지만 기본적으로 AVM영상은 단일 영상 정보보다 왜곡 현상이 심하게 나타나고 주차선의 노후화, 빛의 세기 변화로 인해 곧은 직선 형태의 주차선을 구분하기 어렵다. 또한, 차량 이나 다른 장애물이 주차 공간의 외곽을 가릴 경우 코너 검출 법 만으로는 주차 공간을 확정 짓기 힘들다. 따라서, 해리스 코 너 검출에서 원하지 않는 부분 또한 코너로 인식될 수 있고, 이 러한 오 검출은 주차 공간 정보의 불확실성을 높인다.

2.3 초음파 센서를 이용한 주차 공간 검출

초음파 센서는 저렴하다는 장점으로 양산 단계를 생각하는 자동차 회사들이 주력으로 사용하는 센서이다. 결과 값으로 검출된 장애물까지의 거리만 전달할 수 있고, 장애물의 형상 에 따라 수신부에서 받게 되는 거리 값은 달라질 수 있다.

초음파 센서는 영상 내 특정 지점에서의 장애물 유, 무를 확 인할 수 있다는 점에서 주차가 가능한 공간인지, 불가능한 공 간인지를 판단할 때 주로 사용된다[7]. 또한, 영상 센서 정보를 보정할 때에는 장애물과 함께 오 검출된 주차선들을 제거하는 데 이용되기도 한다[8]. 하지만 초음파 센서는 거리 정보만 나 온다는 점과, 정확성의 한계로 장애물 유, 무를 확인하는 것 외 에 자율 주차를 위한 주차 공간 입구 위치 값을 검출하는 작업 에는 큰 유용성을 보이지 않는다.

3. 본 론

3.1 하드웨어 시스템

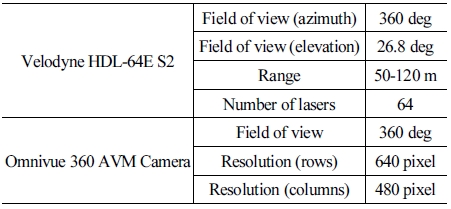

본 연구에서는 서울대학교 융합과학기술대학원 DYROS (Dynamic Robotics System) 연구실의 자율 주행 자동차를 사 용하여 실험을 수행했다. 실험 차량은 [Fig. 1]의 모습으로 Velodyne HDL-64E S2 라이다 센서와 4개의 카메라로 구성된 Omnivue 360 AVM 시스템이 탑재되어 있다. Velodyne 센서는 차량의 상단에 설치되었으며 4개의 카메라는 전면, 좌측, 우 측, 후면에 설치되어 차량의 전 방향을 관측할 수 있다.

3.2 소프트웨어 시스템

실험에 사용된 PC는 Intel i7-8700, 16GB RAM을 탑재하고 있다. [Fig. 2]는 전체적인 알고리즘의 도식을 나타낸 모습을 의미하며 각각의 도형은 독립된 기능을 위한 개별 구동 프로 그램을 의미한다. [Table 1]과 같이 입력으로 Velodyne 센서 정 보와 카메라의 센서 정보가 사용되고 주차 공간 검출 시스템 (avm parking space detector) 내에서 센서 융합과 융합된 정보 를 이용한 주차 공간 검출 과정이 진행된다. 최종적으로 차량 으로부터 주차 공간까지의 상대 거리, 상대 각도를 출력 노드 (parking space location)를 통해 반환한다.

3.3. 개선된 주차 공간 탐색 전략

본 논문에서는 AVM 센서에서 영상 정보를 획득하고 라이다 센서로부터 일정 이상 높이를 가지는 장애물 정보를 획득한다. 그리고 [Fig. 3]에서 나타나는 장애물 정보를 제외한 영상 정보 획득, 외곽선 검출, 주차선 후보군 검출, 주차 공간 입구 검출 과 정을 순차적으로 진행하여 최종 주차 가능 영역을 확보하였다.

AVM과 같이 IPM (Inverse Perspective Mapping) 방법을 이 용할 경우, [Fig. 4]의 선택 영역과 같이 카메라가 설치되어 있는 원 지점으로부터 멀어질수록 영상의 왜곡 현상이 강하게 나타 난다. 영상 왜곡으로 인해 실제 차량이 존재하지 않는 영역에서 도 차량이 존재하는 것처럼 나타나는 결과를 확인할 수 있다.

영상 정보와는 달리 라이다 정보는 왜곡이 거의 발생하지 않 기 때문에 상대적으로 정확한 위치 정보를 얻을 수 있다. 하지만 라이다 센서의 물리적인 한계로 장애물의 전 영역이 포인트 정보로 나타나지 않고, [Fig. 5] 내에 점선으로 표시된 부분과 같 이 장애물이 존재함에도 검출이 안된 빈 공간들이 나타나게 된다.

센서 융합은 두 센서의 오차를 최소화하기 위해 장애물을 검출한 일정 개수의 라이다 포인트 정보를 추출한 후 AVM 영 상에서 나타나는 동일한 장애물 위치에 대응시킬 수 있는 이동 변환을 수행하였다. 이동 변환을 위한 기준은 전 측방, 후 측방 에 각각 4포인트씩 총 8포인트의 라이다 포인트를 임의로 추출 하여 영상 정보와 매칭하며 설정하였다. 또한 라이다 센서의 빈 검출 공간을 채우면서 영상의 방사형 왜곡 특성을 반영하도 록 [Fig. 6]의 (a), (b)와 같은 형태의 장애물 정보 확장 방법을 시 도하였고 그 중 (b) 형태와 같이 카메라의 방사형 특성을 고려 하여 라이다 센서 정보를 확장시키는 융합 방법을 제안하였다. 이에 대한 성능 결과는 추후 실험 결과를 통해 확인 가능하다.

주차선은 규격에 맞는 일정 두께를 유지한다. 따라서 주차 선과 수직한 방향에 경계 검출 필터를 적용했을 때 나타나는 기울기의 변화는 주차선 어느 부분에서나 비슷한 경향성을 보 인다. 이와 달리 기타 장애물들은 경계 특성에 일관성을 보이 지 않고 장애물 종류, 드러나는 크기 정보 등에 의해 독립된 특 성을 가지게 된다.

이러한 점을 이용하여 영상 내에서 주차선의 평균 두께를 구하고 주차선 두께만큼 높은 강도를 유지하고 주차선의 수직한 방향 전, 후로 기울기 경사를 가지는 경계 검출 필터를 적용한 다. 주차선이 영상에서 검출 가능한 최고 강도 값인 255를 가지고 있다는 가정 하에 [Fig. 7]의 (a)는 주차선이 아닌 공간 에서 0값을 가지다가 주차선 굵기인 1 · L 만큼의 255 강도 값, 그 이후 계속적으로 0 값을 검출하는 상황을 나타낸다. 주차선 의 굵기인 L을 고려한 경계 검출 필터는 1 ·L 행렬 F에 대하여 크기에 –1, 1 ·1 크기에 0, 크기에 1의 이미지 강도 값이 이어진 형태로 되어있다. 이러한 경계 검출 필터를 주차선에 정 방향으로 적용할 시, (b)와 같이 처음 주차선 검출 시작 영역에서는 최고로 높은 강도 값을 가지고 점차 낮아져 서 주차선 검출이 끝나는 영역에서는 가장 낮은 강도 값을 가 지게 된다. 필터 결과 값을 역 방향으로 다시 한번 적용했을 경 우 주차선 검출 영역 중 중간에서 가장 높은 값을 보이게 되고, (c)와 같은 결과를 얻을 수 있다. 필터의 결과 값인 영상의 강도 값은 식 (6)과 같이 재귀적으로 계산된다.

| (6) |

위에서 언급한 바와 같이 장애물의 경계선들이 주차선의 경계보다 강도 값이 강하게 나타날 경우 라돈 변환 역시 오 검 출의 문제가 발생될 수 있다. 만약, 장애물의 경계 두께가 주차 선의 경계 두께 L과 비슷하다면, 극소 경계 영역에서는 경계 검출 필터로 인한 차이점을 확인하기 어렵다. 본 논문은 이와 같은 문제를 해결하기 위해 주차선 영역이 일정 거리 이상 동 일한 윤곽 특성을 유지한다는 가정 하에, 식 (7)과 같이 개선된 라돈 변환 방법을 제시한다.

| (7) |

기존 라돈 변환이 단일 픽셀의 두께를 가진 선을 찾는데 최적 화되어 있는 반면, 제시한 개선된 라돈 변환은 검출 두께 변수인 r을 주차선의 두께 L만큼 확장하여 장애물들의 경계선 검출을 최소화하고 오직 주차선만 강하게 검출할 수 있는 장점이 있다.

주차 영역에 대한 규격은 나라마다 일정 부분 차이를 보 이지만, 본 논문에서는 대한민국 주차장 법령에 규정된 주차 공간 입구에 대한 크기를 계산하고 이에 맞는 템플릿을 생성 하였다.

앞으로는 [Fig. 8]에서 파란 점선으로 표시되는 주차선을 주 주차선, 그리고 그에 수직한 주차선을 보조 주차선으로 표기 한다. 템플릿 매칭은 생성한 템플릿과 매칭의 대상이 유사할 수록 높은 값을 반환하고 약간의 각도 차이 혹은 길이 차이는 결과에 큰 영향을 주게 된다. 주차 공간을 탐색 시 차량의 회전 에 따라 영상에서 나타나는 주차 공간도 회전하게 되기에 생 성한 템플릿을 회전하는 영상 정보에 대입 시에 제대로 된 매 칭을 기대하기 힘들다. 따라서 [Fig. 8]과 같이 U자 모양의 주 차 공간 입구 템플릿은 그림에서 나타나는 주차 공간 입구와 매칭되기 위해 회전 과정이 선행되어야 한다.

본 과정은 주차선들 검출 이후, 주 주차선과 보조 주차선들 이 중첩되는 지점에 주차선의 회전 각도를 보고 그에 맞춰 기 존에 만들어 둔 템플릿을 회전시켜 매칭시킨다. 결과적으로, 템플릿 매칭을 통해 계산된 결과는 주차 영역 입구에 대한 극 좌표계 값으로 다시 계산된다.

[Fig. 5] 라이다 포인트 정보를 보면, 센서 설치 지점으로부 터 멀어질수록 정밀도가 떨어지고, 가려지는 공간으로 인해 차량이 있는 공간이 제대로 검출이 되지 않는 현상을 볼 수 있 다. 또한 실제로 장애물이 존재하지 않는 곳에서 나타나는 라 이다 센서의 잡음 현상도 간혹 발생함을 확인할 수 있다. 따라 서 위 언급한 문제점들로 인하여 검출된 주차 공간에 존재하 는 모든 라이다 포인트 정보를 이용하여 주차 가능 공간 인식 에 이용하는 경우 실제 차량의 존재 여부를 확실히 판별하는 데 불확실성을 야기한다.

특히, [Fig. 5]에서 검출된 차량들의 포인트 클라우드 정보 를 보면, 차량의 전면 포인트 정보 양은 많지만, 표시해 놓은 것과 같이 차량의 후면부는 라이다 센서가 검출할 수 없으므로 비어 있는 공간처럼 인식된다. 그리고 차량이 주차를 위한 선 회를 시작할 때, AVM 영상 가장자리에 위치한 주차된 차량들 의 경우 측면이 더 많이 인식되고 차량을 검출하는 라이다 포 인트 정보 양은 상대적으로 감소하게 된다.

위 언급한 문제점들인 라이다 센서의 잡음과 동적 상황에서 변화하는 정보의 양으로 인한 주차 가능 여부의 오 검출을 보정 하기 위해 [Fig. 9]와 같은 동적 장애물 감지 영역을 생성하였다. 장애물 감지 영역은 라이다 센서의 잡음이 아닌 실제 주차된 차 량으로 인해 라이다 정보가 검출될 것으로 예측되는 공간을 선 정한다. 또한 동적으로 변화하는 환경에서 변화하는 라이다 정 보 양을 고려하여 주 주차선이 차량의 진행 방향과 이루고 있는 각도에 따라 선형적으로 비례하여 증가하는 특성을 가진다.

3.3.5에서 선정한 검출 영역 내에서 확장시킨 라이다 센서 의 포인트 클라우드 수에 따라 장애물 존재 가능성의 신뢰도 를 결정한다. 특정 주차 공간 내부에 장애물이 존재하지 않는 다고 판단된 경우, 해당 주차 공간 전역 좌표계에서 회전 템플 릿이 매칭되는 영역의 중간 좌표 값 xp, yp 정보를 바탕으로 식 (8)과 같이 장애물이 존재하지 않는 주차 공간의 입구 위치 정 보(xp, yp)를 차량 후륜 중심 지점(xc, yc)에서의 상대 거리 ρr , 식 (9)와 같이 상대 각도 θr로 반환한다.

| (8) |

| (9) |

4. 실험 결과

4.1 실험 환경

실험은 차세대융합기술연구원에 위치한 야외 주차 공간에 서 진행되었다. 주행 차량의 평균 속도는 8 km/h이며 주차된 차 량의 수가 전체 주차 공간의 1/3 이하인 상황1에서의 직진 주행에 대한 실험을 수행했으며, 주차된 차량의 수가 1/3 이상인 상황2 에서의 직진 주행 2가지 경우에 대하여 실험을 진행하였다.

4.2 장애물 센서 융합 성능 비교

상황 1에서의 직진 주행 시나리오를 통해 장애물 센서 융합 성능을 확인했다. 장애물을 제거하지 않고 주차선을 검출하는 방법과 라이다 센서 정보를 사각형 혹은 영상 왜곡을 고려한 방 사형으로 확장시킨 뒤 주차선을 검출하는 방법들을 비교하였다.

실험 결과 [Fig. 10(a)]와 같이 장애물 제거 과정이 없으면 차 량의 외곽 성분들로 인해 올바른 주차선을 검출할 수 없다. 검 출된 장애물을 사각형 형태로 확장시킨 (b)의 경우 검출된 장 애물 영역 안에 주차선 영역이 포함되는 경우가 빈번히 발생 했고 오차가 나타남을 알 수 있었다. 장애물을 방사형 형태로 확장하고 센서 정보 융합을 진행한 (c)의 경우 영상 내의 장애 물과 동일한 영역에 라이다 센서 정보를 융합하는 것이 가능하 였고, 따라서 상대적으로 정확한 주차선을 검출할 수 있었다.

4.3 경계 검출 필터 성능 비교

장애물에서 나타나는 경계들 중 주차선보다 더 두꺼운 경계 를 가지는 경우도 존재한다. 특히 주차된 차량의 그림자의 경계 는 주차선들보다 일반적으로 두껍게 나타난다. [Fig. 11] 그림에 서 보여지듯이, 너무 큰 필터 사이즈는 그림자 및 일부 장애물 경 계가 더욱 강하게 강조될 수 있으므로 주차선 두께 L에 맞는 적 절한 필터 사이즈가 필요하다.

[Fig. 12]와 같이, 정확한 주차선 검출은 최종 결과에 영향을 미친다. 경계 검출 필터 사이즈 L=5일 때 외에는 빨간 선택 영 역과 같이 오 검출이 빈번히 나타남을 확인할 수 있었다.

4.4 개선된 라돈 변환 성능 비교

도로 상황, 혹은 장애물의 경계 필터 결과가 주차선의 필터 결과와 유사하다면, 경계 필터로 인한 효과를 기대하기 어렵 다. 특히 지면에 방향 표시와 같은 도로 표식이 있을 경우, 주 차선을 정확히 인식하지 못하는 상황이 빈번히 발생했다.

[Fig. 13]은 지면에 방향 지시 표시가 존재할 경우, 주 주차 선에서 나타나는 라돈 변환 값 R (ρ, θ) (세로축)과 거리 ρ에 (가로축) 대한 그래프이다. [Fig. 13]에서 볼 수 있듯이, 라돈 변 환의 확장 크기에 따라 전반적인 라돈 변환의 값은 증가한다. 하지만, 두께 변수 r과 동일 두께를 가지지 않는 선들의 경우 동일 두께를 가지는 선들에 비하여 라돈 변환 값이 작게 나오 는 성질을 가진다. 주행차량의 좌, 우의 주 주차선을 검출하기 위해 좌, 우로 독립된 라돈 공간을 만들고 각각의 최대 라돈 변 환 값을 사용하여 주차선을 검출하였다.

위에서 설명한 것과 같이 [Fig. 13(a)] 경우와 같이 일반 라돈 변환 알고리즘의 경우 주 주차선의 두께를 반영하지 못하므로 영상 내 확장 크기와 비슷한 두께를 가진 도로 표식이 검출되 는 경우에는, 오히려 도로 표식을 주 주차선이라고 인식하는 경우가 [Fig. 14(a)]에서와 같이 나타났다. 이와 반대로 개선된 라돈 변환 알고리즘을 적용한 (b), (c) 경우는 둘 모두 주 주차 선을 제대로 인지하고 있다. 개선된 라돈 변환 알고리즘의 두 께 변수 r이 커져서 주 주차선의 두께 값과 가까워질수록, [Fig. 13]에서 증가하는 화살표의 크기와 같이 주변 주차선이 아닌 영역에서의 유사 주차선들로 인해 생기는 라돈 값과의 차이는 증가하게 되고 결과적으로 일반 라돈 변환 알고리즘보 다 정확하게 주차선을 인식할 수 있다.

개선된 라돈 변환 알고리즘에서 두께 변수 r을 키울수록 성 능이 개선될 수 있으나, 주차선보다 두꺼운 경계로 인한 오 검 출 가능성도 존재한다. 따라서 주차선 두께와 일치하는 두께 변수 r을 선정해야 한다. 또한, 확장 크기가 증가할수록 연산 량도 증가하므로 실제 시스템을 구동하기 위한 최적 두께 변 수 선정이 중요하다.

4.5 결과 비교

본 실험에서는 주차 공간의 검출 결과는 일정 횟수(5~7) 이 상 검출이 유지될 경우 검출되었다고 간주하였다. 또한, 주행 차량의 그림자로 인해 생기는 경계 영역들은 제거하여 오 검 출 계산에 포함하지 않았다. 성능 평가 지표로는 식 (10)의 recall과 식 (11)의 precision를 사용하였다.

| (10) |

| (11) |

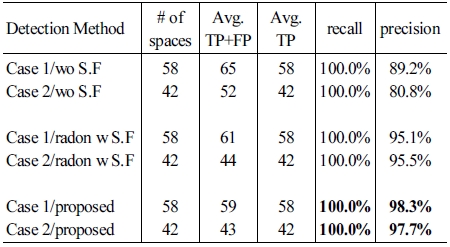

결과 비교는 실험에서 사용한 2가지 상황에서 라이다 센서 융합을 하지 않은 경우(Case 1,2/wo S.F), 융합 이후 기존 라돈 변환을 사용한 경우(Case 1,2/radon w S.F)와 센서 융합 이후 개선된 라돈 변환을 사용한 경우(Case 1,2/proposed)로 나누어 분석하였다.

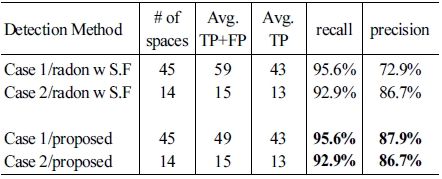

[Table 2]는 전체 주차 공간에 대한 실험 결과를 의미하며 [Table 3]는 주차 공간 검출과 주차 가능 여부를 정확히 판별한 결과만을 의미한다. 결과를 분석하기 앞서, 개선된 라돈 변환 은 기존 라돈 변환에 비해 강건성을 갖춘다는 장점을 가지고 있고, 만약 주차선만 존재하고 다른 장애물이나 노이즈가 적 은 환경에서는 기존 라돈 변환만으로 충분한 성능을 낼 수 있 음을 밝힌다.

따라서 결과 분석은 본 논문에서 제안한 방법이 기존 방법 들에 비해 얼마나 오 검출을 최소화하는지에 초점을 맞춘다. 실험 결과 전체 주차 공간의 개수 중 정확히 검출된 주차 공간 의 비율을 나타내는 recall의 경우 기존 방법과 언급한 바와 같 이 별 차이가 없음을 확인할 수 있다. 하지만 알고리즘을 통해 검출된 공간 중 정확히 검출된 주차 공간의 비율을 나타내는 precision의 경우 기존 방법보다 높은 것을 확인할 수 있다.

실험 도중 AVM 영상에서는 나타나지만, 바로 옆에 주차 된 다른 차량이 존재하여 라이다 센서 정보는 나타나지 않는 주차 된 차량들이 존재한다. 이는 라이다 센서가 두 장애물이 겹쳐 있을 때, 레이저의 불 투과 특성에 의해 앞 장애물만 계 측이 가능하기 때문이다. 따라서 주차 된 차량이 존재함에도 빈 공간이라고 검출하는 경우가 존재하고 [Table 3]의 TP+FP 값에 영향을 미친다. 또한 [Fig. 4]와 같이 영상 내에서 존재하 는 방사형 왜곡 특성을 고려하여 라이다 센서 정보를 융합하 므로, 센서 퓨전을 수행할 때 미세조정 문제로 인하여 실제 주 차 된 차량이 없음에도 불구하고 왜곡 현상에 의해 차량이 있 는 것처럼 여겨지는 현상이 간혹 발생한다. 이로 인해 빈 공간 을 주차 된 차량이 있는 공간으로 검출하는 경우가 존재하고 [Table 3]의 Avg TP 값에 영향을 미친다. 이러한 영향들이 최종 적인 recall, precision에 반영되어 주차선을 통해 주차 공간만을 검출하는 [Table 2]에 비하여 주차 공간 검출과 주차 가능 여부 를 정확히 판별한 검출하는 [Table 3]가 더 낮은 결과를 얻게 되 었다.

공간 검출에 대한 성능 문제는 추후 영상 센서와 라이다 센 서의 미세 조정 결합을 통해 매칭의 오차를 줄일 때, 개선될 것 으로 생각된다.

5. 결 론

본 논문에서는 자율 주행 자동차의 자율 주차 기능을 위해, AVM 영상 센서 정보와 라이다 센서 정보를 융합한 개선된 주 차 공간 검출 방법을 제안하였다. 기존 연구들이 초음파 센서 와 영상 센서를 융합했던 것과는 달리 라이다 센서를 통한 장 애물 제거를 통해 영상 속에서 생기는 장애물들의 경계 검출 을 낮추었고, 주차선 외에 주차선으로 간주될 수 있는 다양한 지면 표시들에 대한 효과를 억제하기 위해 개선된 라돈 변환 을 추가하였다. 제한된 상황에서 기존 연구들이 제시한 방법 과 본 논문에서 제안한 기법들을 추가했을 때의 결과를 비교 하였다. 기존 방법의 경우 차량이 존재하지 않는 주차 공간 검 출 성능은 확보할 수 있었지만, 다수의 장애물이 존재하거나 도로 환경의 악화로 노이즈가 많은 상황에서의 주차 공간 검 출은 쉽지 않았다. 그러나, 제안된 방법은 주차된 차량이 많을 때에도 장애물 제거 과정을 통해 높은 검출 성능을 확보할 수 있고, 노이즈에 강건한 특성을 가지는 개선된 라돈 변환을 통 해 강인한 검출 성능을 가능케 함을 확인하였다. 이를 통해 다 수의 장애물과 지면 표시, 그 외에 경계들이 검출될 수 있는 실 제 상황에서 효과적일 것으로 여겨진다. 추후 연구로는 전 처 리 과정에서 시간에 따른 장애물 제거 알고리즘과 검출된 주 차 공간을 확정하고 계속적으로 추정하는 추정 필터의 설계가 필요할 것으로 사료되고 이러한 방법들을 추가적으로 보완한 다면 더욱 개선된 성능을 보일 것으로 기대된다.

References

- Hyundai Motor Group, Innovation - Autonomous Parking, [Online], https://www.hyundai.co.kr/TechInnovation/Autonomous/Avp.hub, Accessed: May 17, 2019.

- BOSCH, Products and services – Park Assist, [Online], https://www.bosch-mobility-solutions.com/en/products-and-services/passenger-cars-and-light-commercial-vehicles/driver-assistance-systems/parking-assistant/, Accessed: May 17, 2019.

- H. G. Jung, D. S. Kim, P. J. Yoon, and J. Kim, “Parking Slot Markings Recognition for Automatic Parking Assist System,” 2006 IEEE Intelligent Vehicles Symposium, Tokyo, Japan, pp. 106-113, 2006.

-

C. Wang, H. Zhang, M. Yang, X. Wang, L. Ye, and C. Guo, “Automatic Parking Based on a Bird’s Eye View Vision System,” Advances in Mechanical Engineering, 2014, DOI: https://doi.org/10.1155/2014/847406.

[https://doi.org/10.1155/2014/847406]

-

C. Harris and M. Stephens, “A combined corner and edge detector,” Alvey Vision Conference 1988, pp. 147-151, 1988.

[https://doi.org/10.5244/C.2.23]

-

J. K. Suhr and H. G. Jung, “Fully-automatic Recognition of Various Parking Slot Markings in Around View Monitor (AVM) Image Sequences,” 2012 15th International IEEE Conference on Intelligent Transportation Systems, Anchorage, AK, USA, pp. 1294-1299, 2012.

[https://doi.org/10.1109/ITSC.2012.6338615]

-

P. Degerman, J. Pohl, and M. Sethson, “Hough Transform for Parking Space Estimation Using Long Range Ultrasonic Sensors,” SAE 2006 World Congress & Exhibition SAE 2006 World Congress & Exhibition SAE 2006 World Congress & Exhibition SAE 2006 World Congress & Exhibition, 2006, DOI: https://doi.org/10.4271/2006-01-0810.

[https://doi.org/10.4271/2006-01-0810]

-

J. K. Suhr and H. G. Jung, “Automatic Parking Space Detection and Tracking for Underground and Indoor Environments,” IEEE, Transactions on Industrial Electronics, vol. 63, no. 9, pp. 5687-5698, Sep., 2016.

[https://doi.org/10.1109/TIE.2016.2558480]

-

K. Hamada, Z. Hu, M. Fan, and H. Chen, “Surround View based Parking Lot Detection and Tracking,” IEEE, Intelligent Vehicles Symposium (IV), Seoul, South Korea, pp. 1106-1111, 2015.

[https://doi.org/10.1109/IVS.2015.7225832]

-

M. Fan, Z. Hu, K. Hamada, and H. Chen, “Line Filter-Based Parking Slot Detection for Intelligent Parking Assistance System,” SAEChina Congress 2014, Shanghai, China, pp. 175-181, 2014.

[https://doi.org/10.1007/978-3-662-45043-7_19]

- Generation Robots, Ultrasound sensor? High quality ultrasound sensors available now, [Online], https://www.generationrobots.com/blog/en/ultrasound-sensor-high-quality-ultrasound-sensors-available-now/, Accessed: May 17, 2019.

-

O. Chutatape and L. Guo, “A modified Hough transform for line detection and its performance,” Pattern Recognition, vol. 32, no. 2, pp. 181-192, Feb, 1999.

[https://doi.org/10.1016/S0031-3203(98)00140-X]

2010 중앙대학교(공학사)

2011~현재 서울대학교 융합과학기술대학원 박사 과정

관심분야: Autonomous Vehicle, Motion Control, Optimal Control

![[Fig. 1] [Fig. 1]](/xml/26114/JKROS-14-3-170_F1.jpg)

![[Fig. 2] [Fig. 2]](/xml/26114/JKROS-14-3-170_F2.jpg)

![[Table 1]](../img/npr_tablethum.jpg)

![[Fig. 3] [Fig. 3]](/xml/26114/JKROS-14-3-170_F3.jpg)

![[Fig. 4] [Fig. 4]](/xml/26114/JKROS-14-3-170_F4.jpg)

![[Fig. 5] [Fig. 5]](/xml/26114/JKROS-14-3-170_F5.jpg)

![[Fig. 6] [Fig. 6]](/xml/26114/JKROS-14-3-170_F6.jpg)

![[Fig. 7] [Fig. 7]](/xml/26114/JKROS-14-3-170_F7.jpg)

![[Fig. 8] [Fig. 8]](/xml/26114/JKROS-14-3-170_F8.jpg)

![[Fig. 9] [Fig. 9]](/xml/26114/JKROS-14-3-170_F9.jpg)

![[Fig. 10] [Fig. 10]](/xml/26114/JKROS-14-3-170_F10.jpg)

![[Fig. 11] [Fig. 11]](/xml/26114/JKROS-14-3-170_F11.jpg)

![[Fig. 12] [Fig. 12]](/xml/26114/JKROS-14-3-170_F12.jpg)

![[Fig. 13] [Fig. 13]](/xml/26114/JKROS-14-3-170_F13.jpg)

![[Fig. 14] [Fig. 14]](/xml/26114/JKROS-14-3-170_F14.jpg)