화재 특성 고찰을 통한 농연 극복 센서 모듈

© Korea Robotics Society. All rights reserved.

Abstract

In this paper, we describe a sensor module that monitors fire environment by analyzing fire characteristics. We analyzed the smoke characteristics of indoor fire. Six different environments were defined according to the type of smoke and the flame, and the sensors available for each environment were combined. Based on this analysis, the sensors were selected from the perspective of firefighter. The sensor module consists of an RGB camera, an infrared camera and a radar. It is designed with minimum weight to fit on the robot. the enclosure of sensor is designed to protect against the radiant heat of the fire scene. We propose a single camera mode, thermal stereo mode, data fusion mode, and radar mode that can be used depending on the fire scene. Thermal stereo was effectively refined using an image segmentation algorithm, SLIC (Simple Linear Iterative Clustering). In order to reproduce the fire scene, three fire test environments were built and each sensor was verified.

Keywords:

Fire Fighting, Smoke Environment, Sensor Fusion, Thermal Camera, Thermal Stereo1. 서 론

2014-2017년을 기준으로 국내에서는 연평균 약 43,000건의 화재가 발생하였고 이중 약 62% 정도는 주택(주거시설) 또는 공장, 오피스(비주거시설) 등의 건축물에서 발생하는 실내 화 재였다[1]. 건물에서 발생하는 화재는 내장재와 가구 및 시설물 이 연소함에 따라 다량의 연기와 유독가스를 발생시킨다. 이 로 인해 탈출자가 건물의 구조와 방향감각을 상실하게 하여 큰 인명피해로 이어진다. 화재로 인한 사망자 중 약 83%의 사 망자가 주거시설 또는 비주거시설의 화재로 인한 사망이라는 통계[1]에서도 알 수 있다.

건축물에서의 화재는 건물의 형태나 자재 등의 특성에 따 라 다양한 형태로 나타나지만, 화재가 확산되는 과정은 유사 하다. 화재가 발생하면 불이 점화되는 점화단계로 시작하여 불이 커진다. 이 후 커튼, 생활용품 등에 불이 붙어 급격히 불 이 확산하는 단계인 성장기에 도달한다. 성장기에서 열복사에 노출된 물체는 표현온도가 빠른 속도로 상승한다. 성장기가 약 7~8분이 유지되면 물체는 발화온도에 도달하고, 공간 전체 에 화재가 빠르게 확산되는 플래시오버 (Flash-Over)현상이 발생한다[2].

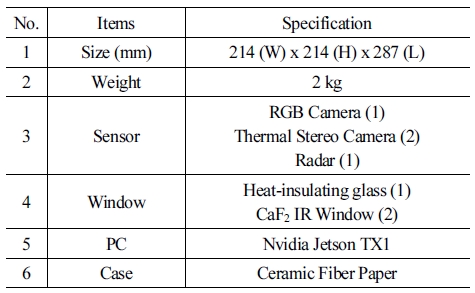

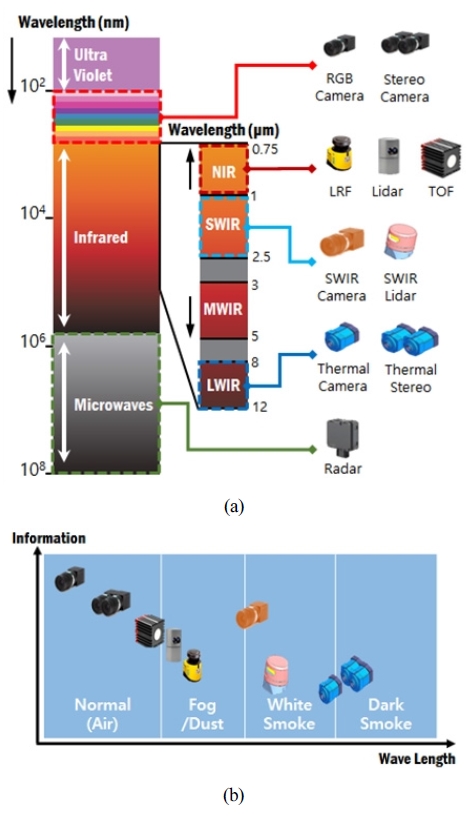

국내의 경우 소방관은 평균 신고 후 소방관 도착시각인 5 ~ 8분 이후에서야 화재 상황과 만나게 된다[3]. 이 때는 화재의 양 상이 성장기를 지나 플래시오버 등으로 확장되며, 화재현장은 연기가 다양한 형태로 퍼져있게 된다. 이때 각 각의 센서들은 검출기에서 받아들이는 파장대가 달라 하나의 센서로는 다양 한 화재 상태를 극복할 수 없다.[Fig 1(a)]을 보면, RGB카메라 에서 사람의 눈과 같은 가시광선 영역대에 대한 정보를 취득 할 수 있으나 그 이상의 영역대에서는 정보 취득이 불가하다. 그 외의 영역대에서는 Lidar, SWIR 카메라, 열화상 카메라 등 을 사용하여야 정보를 취득할 수 있다. [Fig 1(b)]와 같이 상황 별로 대응할 수 있는 센서가 있으며 센서마다 정보량도 다 다 르다. 열화상 카메라는 다양한 상황을 극복할 수 있지만 RGB 카메라처럼 구체적이진 않다. 이처럼 단일 센서로는 다양한 상황에 대응할 수 없다. 이를 보안하기 위해서 다양한 대역대 의 센서들을 합하는 융합센서가 제안되어 왔다.

(a) Electromagnetic spectrum showing compatible sensors according to wavelength (b) Responseable sensor according to smoke characteristics and amount of information from sensors

기존 화재대응 융합센서에서는 FLIR사의 화재진압용 열화 상 카메라인 K시리즈가 있다. 이 카메라는 RGB 카메라와 열 화상 카메라로 구성되어있으며 각기 카메라 모드와 MSX모드 를 지원한다. 이 모드는 열화상 카메라에 RGB카메라의 윤곽 을 강조해주어 열화상의 가시성을 높여준다. 하지만 농연 상 황일 경우 RGB 카메라의 윤곽 정보가 옅어져 가시성이 향상 효과가 적다. 열화상 스테레오와 거리 정보를 주는 Radar를 융 합하여 특정 물체의 거리를 정보를 제공하는 기법[4]이 있었다. 그러니 이 기법은 물체에 특정 물체의 거리만으로 제공하며 실 화재 시, 사람이 모르는 공간에 대한 모든 정보를 파악할 수 는 없다.

본 논문에서는 단계별로 나타나는 실내화재의 연기특성을 토대로 화재를 진화하고 인명을 구조하는 소방관의 관점에서 필요한 센서를 고찰하고 이를 통하여 각 상황에 맞는 센서 조 합을 도출하였다. 이를 위하여 RGB 카메라, 열화상 카메라, Radar 센서를 조합하였다. 이 센서들을 조합하여 단일 카메라 센서 모드, 열화상 스테레오 모드, 센서 융합 모드, 레이더 모 드를 제안한다. 이 모드들은 연기의 농도와 색상, 화염 여부에 따라 사용자가 이에 대응할 수 있는 모드를 선택할 수 있다. 또 한 모드를 시각적으로 표현하여 구조를 잘 모르는 공간 에서 도 화재현장을 모니터링 할 수 있도록 하였다. 센서를 검증 하 기위하여 흰 연기 환경, 검은 연기 유입 환경, 실 화재 실험장 등 세 가지의 화재 실험 환경을 구성하였다. 다양한 실험 환경 에서 각 센서 모드를 사용하여 RGB 카메라와 각 모드 적용 결 과를 비교하였다.

2. 화재 연기의 특성에 따른 대응센서분석

2.1 화재 연기의 종류와 대응 센서

화재 시 발생하는 연기에는 다양한 입자가 포함되어있으며 이로 인하여 농도에 따라 효과적으로 대응하는 센서는 다르 다. 주로 화재 초창기 또는 산소 공급이 없는 화재의 결과로 발 생하는 훈연 증기에서는 가연물의 수증기와 연소물이 혼합되 어있는 형태인 흰 연기(white smoke)가 발생한다. [Fig. 1(b)] 를 보면 흰 연기는 농도가 짙어지더라도 SWIR 대역(~2500nm 파장대)과 LWIR/FAR 대역(8000nm ~ 15,000nm파장대)을 감 지해 효과적으로 대응이 가능[5]하며 FLIR의 firefight 센서시 리즈 등의 상용 제품이 시장에 출시되어있다. 그러나 화재가 진행함에 따라 급격히 다양한 화합물을 함유하는 형태의 화재 가 발생하고 연기는 검은색을 띠게 된다. 이때부터 SWIR파장 대는 작동이 되지 않으며, 검은 연기(Dark smoke)의 농도가 높 아지고 검은 연기 입자에 열원이 포함되는 형태의 연기가 발 생한다. [Fig. 2(a)]처럼 열원이 포함된 검은 연기가 화재 공간 을 채울 경우 LWIR/FAR 파장대의 센서인 열화상 센서도 열 원의 방해를 받아 성능이 급격히 저하된다[5]. 이때는 [Fig. 1(a)]와 같이 전자파장대인 레이더만이 연기 건너 상황을 감지 할 수 있다. 그러나 파장대가 높은 센서일수록 동시에 획득할 수 있는 정보의 양은 적어진다. RGB 카메라에서 얻을 수 있는 높은 화질과 선명한 색 정보 및 텍스쳐 정보와 대비하여 SWIR 카메라는 흑백 영상을 제공하며, 열화상 카메라는 열 정보만 을 시각화하여 전달한다. 극단적으로 레이더는 몇 지점의 위 치정보를 확률로써 전달할 뿐이다. [Fig. 1(b)] 와 같이 화재 연 기 특성에 따른 센서는 존재하나 연기의 농도가 옅거나 하얀 색 위주의 연기에서는 가시광선 파장대 또는 SWIR에 대응할 수 있는 센서로부터 많은 시각적 정보를 얻을 수 있다. 하지만 화재 연기의 농도가 짙어질 수 록 제한된 환경정보만 획득할 수 있다. 현재 단독 센서로서는 효과적으로 농연을 극복하며 상대적으로 많은 환경정보를 제공할 수 있는 센서가 없는 현 실이다. 긴박한 구조 상황에서는 건축 구조물을 잘 알지 못하 는 소방관이 [Fig. 3]의 열화상 영상만으로는 출구를 찾지 못하 는[6] 심각한 결과를 초래할 수 있다.

(a) Inability to identify structures due to thickening with thermal image camera in the event of a fire.

2.2 연기 발생 형태에 따른 센서 대응 분석

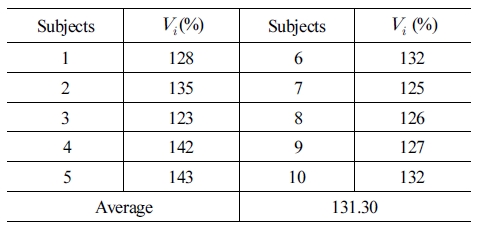

화재 시 발생하는 연기는 대류현상에 의하여 상부로 급속 히 확산되며, 실내에서는 천장을 따라 좌우로 확산되는 특징[7] 을 가진다. 따라서 실내 초동 화제를 제외하고 현장에 출동한 소방관이 마주하는 현장 상황은 대략적으로 [Fig. 4] 와 같이 6 가지 상황으로 구분되어 질 수 있다. [Fig. 4(a)]는 초창기 화재 또는 훈증연소(fumigation) 상황에서 발화점이 위치한 공간에 서 발생하는 상황인 ‘화점-흰 연기 동시 분포상황’ 이다. [Fig. 4(b)]는 다른 공간에서 발생한 화재로 인하여 흰 연기가 이동 하여 유입되었으나 아직 천장에 위치한 ‘흰연기 초기 유입 상 황’ 이다. [Fig. 4(c)]는 다른 공간에서 발생한 화재로 인하여 흰 연기가 이동하여 공간을 가득 채우는 상황으로 ‘흰 연기 완 전 유입 상황’ 에 해당하며, [Fig. 4(d)]는 다른 공간에서 발생 하여 어느 정도 진행된 화재의 검은 연기가 이동하여 유입되 었으나 아직 천장에 위치한 ‘검은 연기 초기 유입 상황’ 이다, [Fig. 4(e)]는 다른 공간에서 발생한 화재로 인하여 검은 연기 가 이동하여 공간을 가득 채우는 상황으로 ‘검연기 완전 유입 상황’ 에 해당하며, [Fig. 4(f)]는 화재가 어느 정도 진행되어 플 래시 오버 상태를 지나 화염이 천장에 까지 다다르고 검은 연 기가 급속도로 발생하는 상황에 해당하는 ‘강한화염-검은 연 기 혼재상황’ 이다.

Classification of smoke and fire distribution according to the location of indoor fire (a)fire - white smoke state, (b) white smoke - intial state, (c) white smoke - smoke-filled state, (d) dark smoke - intial state, (e) dark smoke - smoke-filled state, (f) fire - dark smoke state

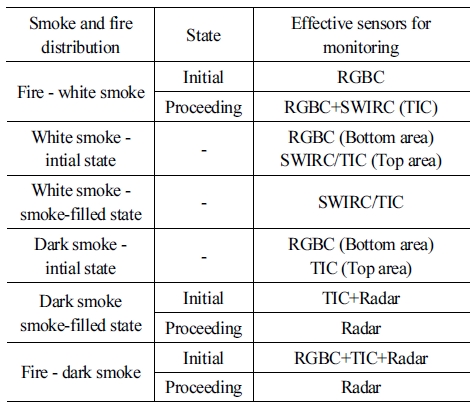

실내화재 발생지점에 따른 연기 및 화점 분포 상황에 따라 대응 가능한 센서[8]를 상황별로 종합 구성하여 볼 때 다음과 [Table 1]과 같은 대응 가능한 센서 특징을 가진다. ‘화점-흰연 기 동시 분포 상황’에서는 강하지 않은 화점으로 인하여 대부 분의 실내공간이 RGB카메라로 조망이 가능하며, 화면상에 지역적으로 존재하는 흰 연기를 SWIR카메라 또는 열화상카 메라(TIC)로 투과하여 환경을 모니터링 할 수 있다. ‘흰 연기 초기 유입 상황’에서는 주로 천장 상단부에 흰 연기가 위치하 는 형태로 나타나며 시간이 지날수록 흰 연기는 아래로 점차 내려간다. 이때 하단부는 RGB로 조망하고, 상단부는 SWIR 카메라 또는 열화상 카메라로 흰 연기를 투과하여 화재상황을 효과적으로 조망할 수 있다. ‘흰 연기 완전 유입 상황’에서는 SWIR카메라 또는 열화상카메라를 통하여 흰 연기를 극복하 고 화재 상황을 조망할 수 있다. ‘검은 연기 초기 유입 상황’은 하단부는 RGB카메라로 조망이 가능하다. 다만 이때부터 상 단부는 SWIR카메라가 효과적으로 동작하지 않는다. 초기 유 입된 검은 연기에는 비교적 열이 포함된 분자가 분포되지 않 아 열화상 카메라로 반대편 상황이 투과가 가능하다. 다만 이 때 열화상 카메라의 특성상 텍스쳐를 잃어버려 출구 상단부에 있는 피난유도등과 같은 주요 표지판을 알 수 없는 상황이 생 길 수 있다. ‘검은 연기 완전 유입 상황’에서도 마찬가지로 더 이상 SWIR카메라의 운용이 불가능하다. TIC와 Radar로 검은 연기를 투과하여 환경 모니터링이 가능하나. 검은 연기의 농 도와 열을 포함한 분자의 분포에 따라 화재상황이 더 진행되 면 열화상 카메라의 기능도 불가능하다. 이때는 Radar를 활용 하여 검은 연기를 투과하여 환경정보의 모니터링이 가능하나 Radar정보는 상당히 제약적이고 실내 환경의 난반사 조건에 따라 많은 노이즈를 포함할 가능성이 있어 활용에 주의가 필 요하다. ‘강한 화염- 검은 연기 혼재 상황’에서는 강한 열기로 인한 강항 복사열과 대류현상으로 인하여 초기에는 하 단부 일부 또는 부분적으로 RGB카메라로 조망이 가능하거나 TIC 로 조망이 가능한 부분이 존재한다. 다만 이러한 상황이 진행 되어 완전히 화염으로 휩싸일 경우 Radar를 제외한 모든 센서 는 환경정보를 획득할 수 없다. 오로지 Radar가 소수의 거리 정보를 이용하여 환경 정보를 모니터링 할 수 있다.

3. 센서 모듈 구성

3.1 센서 모듈 구성

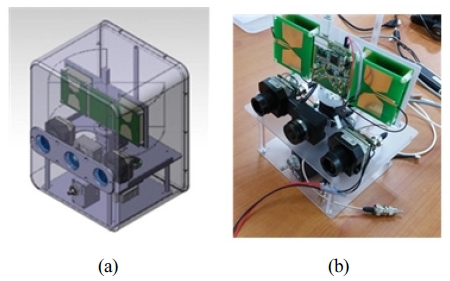

화재 현장에서 발생하는 연기 분포 및 화염을 커버하기 위 하여 다음과 같이 RGB 카메라 1대, 열화상 카메라 2대, Radar 1대를 조합하여 센서를 구성 하였다 [Table 2]. RGB 카메라는 FLIR 사의 Chameleon3를 사용하고, 열화상 카메라는 FLIR 사 의 Tau2 그리고 레이더는 유메인 사의 UWB Radar를 사용했 다. RGB 카메라는 연기가 없는 환경과 일부 화염이 있는 환경 을 모니터링 한다. 열화상 카메라는 화재 현장에서 주변 온도 정보를 효과적으로 모니터링 가능하여 다양하게 활용 할 수 있다. [Fig. 5(b)] 센서 중에서 화각이 제일 넓고 해상도가 큰 RGB 카메라를 중앙에 위치시키고. 동일한 화각의 열화상 카 메라 2개를 이용하여 열화상 스테레오를 구성하였다. 레이더 는 RGB 카메라 바로 위에 위치시켜 공간적 동기화에 용이하 도록 구성하였다. 두 열화상 카메라를 이용하는 스테레오를 위하여 열화상카메라에 외부 신호 동기화를 적용하여 시간적 동기화를 취하였다.

화재 현장에서 방출되는 복사열로부터 센서들을 보호하기 위하여 내부에 고온 단열재인 세라믹페이퍼를 사용하였다. 또 외부의 열로부터 영상 센서의 렌즈를 보호하기 위해서 방열 유리가 필요하다. 일반 방열유리를 열화상 카메라에 사용할 경우 열화상 카메라의 파장 대역(7.5 - 13.5 μm)에 해당하는 빛 도 차단하여 온도 정보를 얻을 수 없다. 방열 유리를 대체하기 위하여 0.13 ~ 10 μm 파장 대역 통과시키는 CaF2 IR 유리를 사 용하여 열화상 카메라를 보호하였다. CaF2 IR 유리가 열화상 카메라의 전체 파장대역을 통과시키지 않아 열화상 카메라로 입력되는 신호가 약해지는 단점이 존재한다.

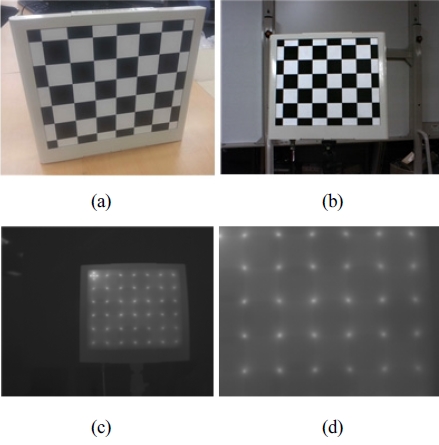

3.2 영상 센서 Calibration

열화상 카메라와 RGB 카메라의 왜곡 보정 그리고 열화상 스테레오 구성과 센서 퓨전을 위한 카메라 Calibration이 필요 하다. 일반적으로 calibration에 사용하는 체스 보드는 RGB 카 메라에선 코너점을 검출하여 특징점을 추출한다. 하지만 온도 가 입력 신호인 열화상 카메라에서 체스보드는 코너점에 상관 없이 온도가 균일하여 특징점을 추출할 수 없다. 열화상 카메 라와 RGB카메라의 특징점을 동시에 잡기 위해서 [Fig. 6(a)] 와 같이 체스판의 코너에 발열체를 설치하여 코너의 온도를 상승시켰다. 그 경우 [Fig. 6(b)]의 RGB 영상 뿐 아니라, [Fig. 6(c)]의 열화상 카메라에 고온영역이 점으로 나타난다. 해당 발 열 지점에서 가장 높은 온도인 점으로 특징점을 잡았다. 추출 한 특징점을 적용하여 각기 카메라 calibration과 stereo calibration을 수행한다[9]. 각 카메라의 내부 파라미터와 두 열 화상 카메라간의 외부 파라미터 그리고 열화상 카메라와 RGB 카메라 사이의 외부 파라미터를 계산한다.

4. 개별 모드 알고리즘 구성

4.1 단일 카메라 센서 모드

본 센서에 장착된 RGB카메라와 열화상 카메라를 사용하는 모드를 단일 카메라 센서 모드라 한다. 초기 화재 시, 연기의 영향이 적어 [Fig. 7(a)]처럼 RGB 카메라에도 환경 정보 획득 이 가능하다. 또 화점 발생 시 빛의 발생으로 인해 RGB 카메라 로 주변 인지가 가능하여 유용하게 사용 가능하다. 열화상 카 메라는 400도 이상의 고온 화재 현장을 제외하고 [Fig. 7(b)]와 같은 저온 상황에선 열화상 카메라로 주변 환경을 볼 수 있다.

4.2 열화상 스테레오 모드

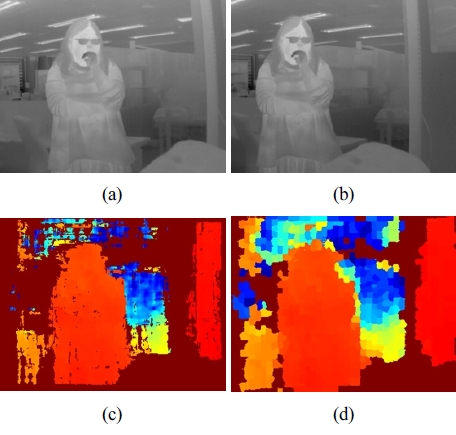

일반적인 3차원 센서는 높은 밀도의 데이터를 제공하나 연 기의 확산에 따라서 데이터가 부정확하게 나온다. RGB 영상 을 이용한 스테레오는 농연 상황에서 RGB 영상의 텍스쳐는 유효하지 않다. 카메라가 아닌 1채널 열화상 카메라의 경우, 디테일한 사물의 깊이를 파악하기 힘들다. 이를 보완하기 위 해서 농연 상황에도 온도로 주변 환경을 모니터링 할 수 있는 열화상 스테레오를 추가하였다. 열화상 스테레오의 결과를 시 각적으로 보여줌으로서 전반 상황의 대략적인 거리감을 제공 하여 현장 인식이 빠르도록 하였다. 스테레오 매칭이랑 각기 다른 위치의 두 카메라를 이용하여 깊이 정보를 계산하는 알 고리즘이다. 스테레오 매칭은 일반적으로 RGB 영상을 대상 으로 하며, 영상의 텍스처 정보를 사용하는 기법입니다. 하지 만 RGB 카메라는 농연 상황시 주변 환경을 모니터링이 불가 하다. 이를 보완하기 우해서 연기와 화염에도 주변 환경 모니 터링에 유용한 열화상 카메라를 이용하여 열화상 스테레오를 구성하였다. 스테레오 알고리즘으로는 기존 방법들 가운데서 가장 많이 사용되는 Semi-global matching[10] 기법을 적용하였 다. 왼쪽 열화상 카메라 [Fig. 8(a)]와 오른쪽 열화상 카메라 [Fig. 8(b)]를 적용하여 스테레오 결과인 [Fig. 8(c)]를 계산하 였다. 그러나 열화상 영상은 물체의 방사열을 시각화한 센서 로서 일반적인 RGB 영상에 비해 특징점이 적다. 또한 영상 중 간 중간 3d 값이 나오지 않는 hole이 발생한다. [Fig. 8(c)]처럼 물체의 윤곽 정보가 부정확하여 열화상 스테레오의 깊이 색상 맵만으로 주변 구조를 파악하기 힘들다. hole을 채우고 영상의 윤곽을 이용하기 위해서 열화상 스테레오의 결과에 영상 분할 알고리즘을 이용한 후처리 작업을 진행한다. 열화상 카메라를 영상 분할 기법 중 하나인 슈퍼픽셀(Super Pixel)을 사용한다. 슈퍼픽셀은 기존 영상의 엣지정보을 고려하여 영상 내부를 격 자모양으로 분할하는 기법이다. 슈퍼픽셀 기법 중 하나인 Simple Linear Iterative Clustering (SLIC)[11] 은 영상의 엣지 정 보를 효과적으로 살려 영상을 으로 영상을 분할 할 수 있다. 영 상 분할 후 각 라벨의 깊이 정보는 라벨에 포함된 픽셀들 중 hole을 제외한 픽셀들의 깊이 정보를 평균값 내어 계산한다. 해당 SLIC[11]과 SGM[10] 등 기존의 알고리즘은 속도 향상을 위 하여 CUDA를 이용한 병렬처리 알고리즘[12,13]을 작용하였다. [Fig. 8(d)]처럼 사용자에게 거리 정보를 효과적으로 인식할 수 있도록 거리에 따라 색을 다르게 적용하였다. 거리를 가까운 물체는 빨강색, 먼 물체는 파랑색으로 표시하는 [Fig. 9]의 색 상표를 적용하여 시각적인 효과를 더하였다. 스테레오의 실제 거리 결과인 D가 0일 때 빨간색 , 측정 가능한 가장 먼 거리일 때 파란색을 적용하여 DC을 구성하였다. 거리 결과가 유효하 지 않을 경우 거리 값을 0으로 이를 이용하여 색깔만으로도 물 체의 거리 차를 구분할 수 있도록 표현하였다.

Result image of thermal stereo (a) Left thermal image (b) Left thermal image (c) Thermal stereo (d) Thermal stereo using SLIC

4.3 다중 센서 융합 모드

다양한 센서의 특징을 조합하기 위하여 RGB 카메라, 열화 상 카메라, 열화상 스테레오를 활용하여 융합 모드를 만들었 다. RGB 영상R 위에 열화상 스테레오 컬러 영상DC를 오버레 이하여 전방의 물체나 주변 구조의 거리를 파악할 수 있도록 하였다. 와 같이 결과 영상 O(p)에 픽셀 p의 거리 D(p)가 최 대 측정 거리인TD보다 클 경우 픽셀 p의 RGB 영상 값인 R(p)을 입력하고, TD보다 작을 경우 DC(p)을 입력한다.M1M2

| (1) |

| (2) |

정확한 물체의 윤곽을 알 수 있도록 sobel operation을 활용 하여 열화상 카메라의 윤곽선을 표현하였다. 왼쪽 열화상 영 상의 I에 식 (3), (4)의 Sobel operationSx, Sy을 적용하여 Gx,Gy를 계산한다. 식 (7)에 Gx,Gy을 이용하여 윤곽선의 크 기 G를 구한다. 이후 식 픽셀p마다 G(p)의 값이 TG보다 클 경우 1, 작을 경우 0인 가중치 지도 wG 식 (8)을 계산한다. 식 (9)에 계산된 wG를 이용하여 O에 열화상 카메라의 윤곽선을 표현한다. A는 윤곽선의 강도를 조절하는 변수로 이 알고리 즘에선 255을 사용했다. 위와 같은 방법으로 최종 융합 영상인 F를 계산한다.

| (3) |

| (4) |

| (5) |

| (6) |

| (7) |

| (8) |

| (9) |

RGB 카메라로 보이지 않는 상황에서도 색상의 차이를 통 해 물체의 멀고 가까움을 알 수 있다. 또한 물체의 edge를 표현 할 수 있어 더 구체적인 주변 환경의 모니터링이 가능하도록 하였다.

4.4 레이더 모드

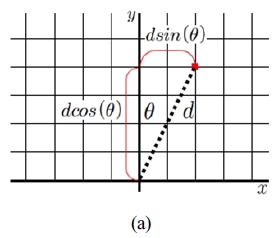

전방 환경에 강한 화염이 존재할 경우 RGB 카메라는 강한 빛으로, 열화상 카메라는 강한 열로 인해 영상이 모두 포화 되 어 시야가 확보되지 않는 현상이 발생한다. 이 때, 레이더의 데 이터를 영상으로 시각화하여 주변 환경을 모니터링 한다. 레 이터의 데이터는 센서를 기준으로 거리d와 각도θ로 구성된 다. 이 데이터를 식 (10)와 같이 x,y의 직교 좌표로 바꾼 후, 센 서를 원점으로 하는 [Fig. 10]과 같은 2D 그래프를 그리고 각 데이터를 점으로 표시한다.

| (10) |

5. 실험 및 결과

센서가 실재 화재 환경에서 어떠한 결과를 보이는지 검증 하기 위해서 실 화재 환경과 유사하게 실험장을 구축하였다. 앞서 제안한 여섯 가지 화재 환경 중에 세 가지 화재 실험 환경 을 구축하여 다양한 화재 환경을 구현하였다. 본 논문에서는 흰 연기 환경 실험, 검은 연기 유입 실험, 그리고 실 화재 실험 등 세 가지 실험을 진행하였다. 정량적 실험 결과를 확인하기 위하여 피실험자를 대상으로 가시성 향상률을 계산하였다.

5.1 흰 연기 유입 실험

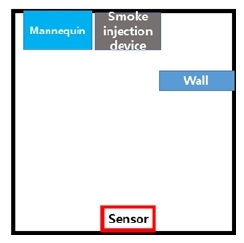

흰 연기 환경 실험은 흰 연기에 따른 시야 방해 상황을 재현 하여 실험하였다. 흰 연기는 화재 현장의 흰 연기와 유사한 연 기발생기를 이용하여 구성하였다. [Fig. 11(a)]와 같이 센서 기 준으로 1 m 간격으로 물체를 위치시킨 뒤, 연기 발생기로 흰 연기를 발생시켜 RGB 카메라 영상에서 충분히 시야를 가린 뒤, 각기 센서 모드를 이용하여 흰 연기로 인해 보이지 않는 물 체들이 보이는가를 테스트 하였다. [Fig. 11(b), (c)]를 참고하 면 RGB 영상을 제외한 모든 모드에서 물체의 위치를 파악할 수 있음이 확인된다.

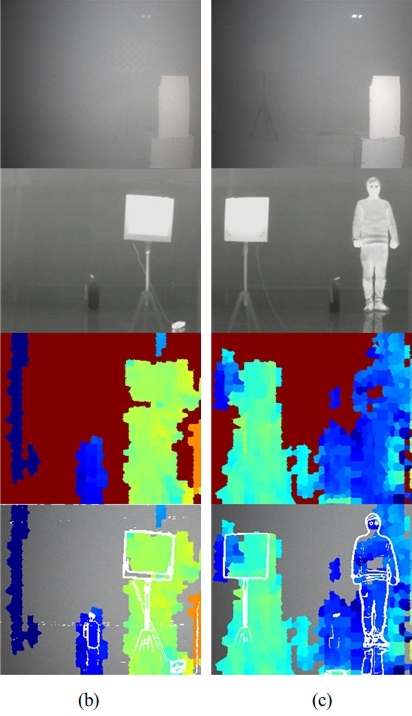

5.2 검은 연기 유입 실험

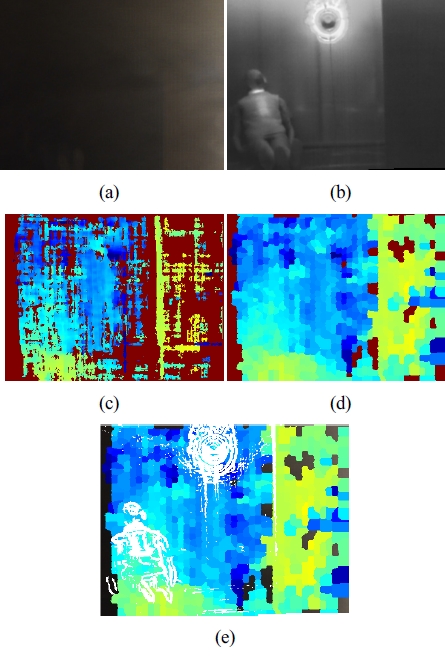

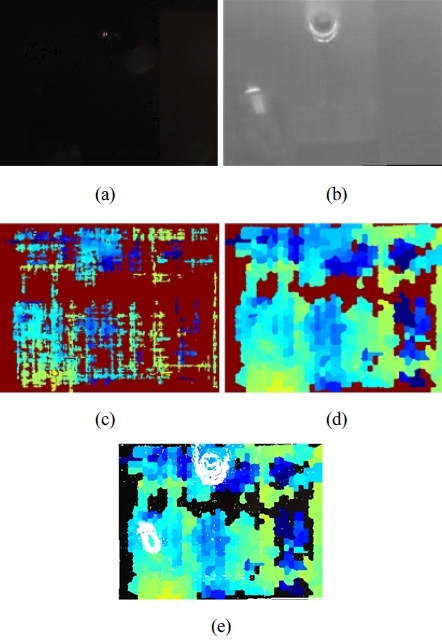

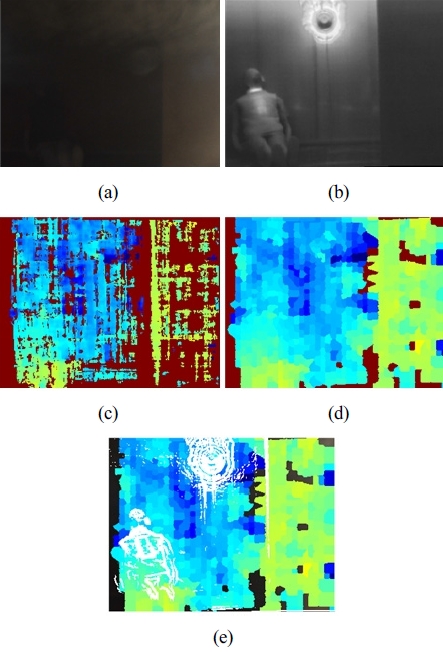

검은 연기 환경 실험을 위하여 [Fig. 12]처럼 3 m x 4 m 컨테 이너 박스에 환풍구를 설치하고 소각시설을 연결하여 소각 시 발생하는 연기를 흡입하는 실험장을 구성하였다. 마네킹과 구 조물을 세워두어 주변 정보를 파악할 수 있도록 하였다. 화재 발생 시 검은 연기는 주로 일상생활에서 자주 쓰이는 화학융 합물질인 PMMA의 연소로 인해 발생한다. 가연 물질로 PMMA를 사용하여 화재 시 발생하는 검은 연기를 재현하였 다. ‘검은 연기 초기 유입 상황’과 ‘검은 연기 완전 유입 상황’ 에서 센서의 성능을 검증하였다. [Fig. 13(b)], [Fig. 14(a)], [Fig. 15(a)], 상단의 RGB 영상을 보면 점차 검은 연기가 유입 되어 시야를 가리게 된다. 이 상황에서 열화상 스테레오 모드 를 적용하게 되면 깊이 정보를 통해 대략적인 깊이 정보를 알 수 있다. 또 융합 영상을 확인해보면 윤곽선영상이 부각되어 전방의 물체를 깊이와 윤각을 알 수 있어, RGB 영상보다 전방 의 상황의 정보를 더 많이 모니터링이 가능하다.

Dark smoke experiment, intial state (a) RGB image (b) thermal image (c) thermal stereo (d) thermal stereo after post-processing (e) sensor fusion mode

Dark smoke experiment, intermediate state (a) RGB image (b) thermal image (c) thermal stereo (d) thermal stereo after post-processing (e) sensor fusion mode

5.3 실화재 실험

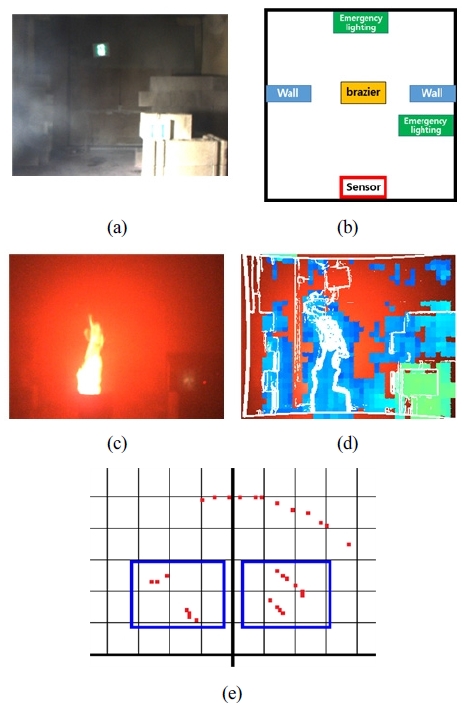

실 화재 실험은 화점을 만들기 위하여 실험 공간 안에 화로 를 설치하였다[Fig. 16(b)]. 센서 기준으로 양 옆에 벽돌로 벽 을 쌓아 주변 구조물을 설치하였으며, 정중앙에 화로를 두어 강한 화염 및 연기 상황을 재연하였다. 화염 상황에서도 [Fig. 16(d)]처럼 구조물(초록색)과 벽(하늘색)으로 구분 가능하며 비상등의 대략적인 위치도 파악하는 등 주변 정보를 얻을 수 있다. 레이더 결과에서도 양 쪽의 벽돌벽과 전방의 벽을 검출 한 것을 확인할 수 있다.

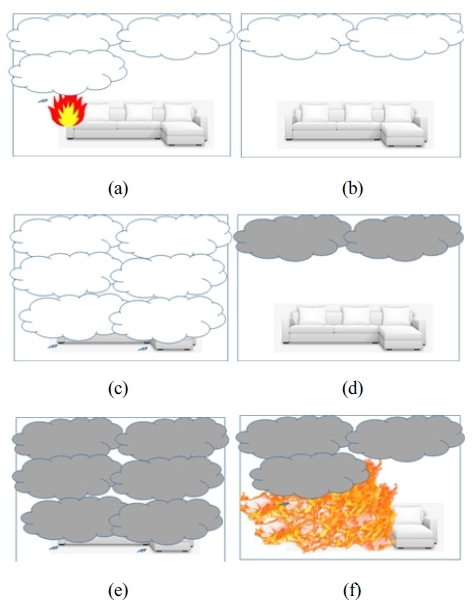

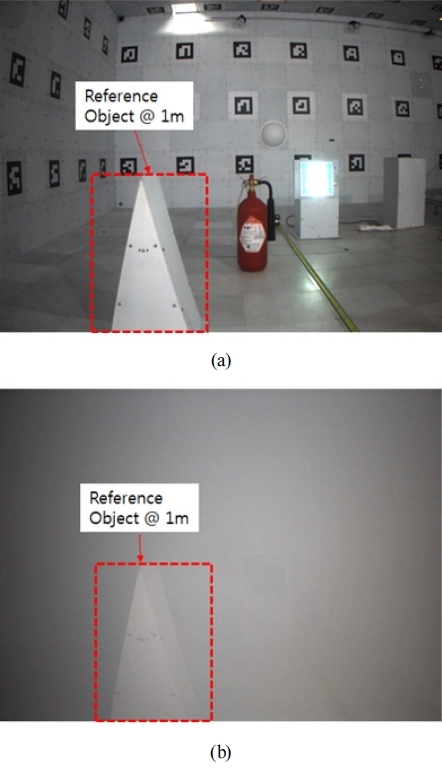

5.4 정량적 실험

[Fig. 11(a)]의 테스트베드에 [Fig. 17(a)]처럼 1 m에 장애물 을 배치하여 Reference 물체을 둔다. 테스트베드에 Reference 물체와 랜덤하게 장애물을 3 ~ 5개 배치하며 피험자에게는 장 애물 개수와 형상 등의 사전 정보를 주지 않는다. 테스트베드 내에 연기를 40% obs/m 이상 채우고, 인간 시각을 모사한 RGB 카메라 영상에서 1 m에 있는 Reference 물체가 보이는 [Fig. 17(b)]에 각 융합센서모듈의 센서 데이터를 취득한다. 위 와 같은 절차를 이용하여 테스트 데이터 셋을 만들고, 융합센 서 데이터를 시각화한다. 피험자에게 시각화 영상에서 장애물 위치를 확인하게 한다. 피험자가 물체가 존재한다고 체크한 위치와 실제 배치된 장애물의 위치가 맞는 경우에만 정답으로 인정하며, 정답으로 인정된 장애물 중에 가장 멀리 떨어진 장 애물 거리를 이용하여 아래와 같이 가시성 향상을 측정한다. i 번째 테스트 셋의 가시성 향상을 Vi라고 할 때, 식 (11)과 같다.

Quantitative experiment (a) placement of reference object and obstacle (b) a situation where only the reference object is visible.

| (11) |

각 피실험자의 데이터를 평균을 내어 가시성 향상도 실험 을 한 결과 평균 131.30%의 향상률을 보였다 [Table 3].

6. 결 론

화재의 발생 과정과 연기의 종류 및 분포에 따라 사용 가능 한 센서는 변한다. 이를 활용하여 화재 현상에서 사용할 수 있 는 RGB 카메라, 열화상 카메라, Radar를 조합하여 센서를 구 성하였다. 상황에 따라 사용 가능하도록 단일 카메라 센서 모 드, 영상 분할을 이용한 열화상 스테레오 모드, 다중 센서 융합 모드, 레이더 모드 등 4가지 모드를 구현하였다. 레이더의 정 확성과 영상 센서 융합 모드를 통합하여 정확도를 높인 시각 화 기법을 개발할 것이다. 또 연기 특성 및 화점 유무 등의 화재 현장 특성에 따라 효과적인 해당 모드들을 화재 현장 모니터 링에 적합하도록 변화시키도록 자동화하도록 개선할 것이다.

Acknowledgments

This material is based upon work supported by the Ministry of Trade, Industry & Energy(MOTIE, Korea) under Industrial Technology Innovation Program. No.10067205, ’Development of enhanced visualization sensor module for the scene of a fire fighting in thick smoke environment’

References

- National Fire Agency, e-Fire statistics, [Online], http://nfds.go.kr/rdPage.jsf, Accessed: October 31, 2018.

- J.-H. Cha, "Study on building room fire development stages," Korea Society of Hazard Mitigation Conference, Seoul, Korea, pp. 169-172, 2008.

- E. Hwang , J. Choi, and D. Choi, "A Study on the Effective Methods of Securing the Golden Time of Fire Engine Move Out," Journal of the Korean Society of Hazard Mitigation, vol. 18, no. 5, pp. 119-126, August, 2018.

-

J.-H. Kim, J. W. Starr, and B. Y. Lattimer, "Firefighting Robot Stereo Infrared Vision and Radar Sensor Fusion for Imaging through Fire Smoke,” Fire Technology, vol. 51, no. 4, pp. 823-845, July, 2015.

[https://doi.org/10.1007/s10694-014-0413-6]

- F. Amon, N. Bryner, A. Lock, and A. Hamins, "Performance Metrics for Fire Fighting Thermal Imaging Cameras – Small- and Full-Scale Experiments," National Institute of Standards and Technology, Gaithersburg, USA, Tech. Note 1499, July, 2008.

-

J. W. Starr and B. Y. Lattimer, “Evaluation of Navigation Sensors in Fire Smoke Environments,” Fire Technology, vol. 50, no. 6, pp. 1459-1481, November, 2014.

[https://doi.org/10.1007/s10694-013-0356-3]

- Fire Tech and safety, The Future of Thermal Imaging – Bullard Thermal Imagers VS. ISG E380, FLIR, Dräger & EV2 Mi Tic, [Online], https://www.youtube.com/watch?v=hdPDv2S911I, Accessed: October 31, 2018.

-

L.H. Hu, R. Huo, Y.Z. Li, H.B. Wang, and W.K. Chow, “Full-scale burning tests on studying smoke temperature and velocity along a corridor,” Tunnelling and Underground Space Technology, vol. 20, no. 3, pp. 223-229, May, 2005.

[https://doi.org/10.1016/j.tust.2004.08.007]

- J.-Y. Bouguet, Camera Calibration Toolbox For Matlab, [Online], http://www.vision.caltech.edu/bouguetj/calib_doc/, Accessed: October 31, 2018.

-

H. Hirschmuller, "Stereo Processing by Semiglobal Matching and Mutual Information," IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 30, no. 2, pp. 328-341, February, 2008.

[https://doi.org/10.1109/TPAMI.2007.1166]

-

R. Achanta, A. Shaji, K. Smith, A. Lucchi, P. Fua, and S. Süsstrunk, “SLIC Superpixels Compared to State-of-the-Art Superpixel Methods,” IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 34, no. 11, pp. 2274-2282, November, 2012.

[https://doi.org/10.1109/TPAMI.2012.120]

- C. Y. Ren, V. A. Prisacariu and I. D Reid, gSLICr: SLIC superpixels at over 250 Hz, [Online], https://arxiv.org/abs/1509.04232, Accessed: October 31, 2018.

-

D. Hernandez-Juarez, A. Chacón, A. Espinosa, D. Vázquez, J. C. Moure, and A. M. López, “Embedded real-time stereo estimation via semi-global matching on the GPU,” Procedia Computer Science, vol. 80, pp. 143-153, 2016.

[https://doi.org/10.1016/j.procs.2016.05.305]

2013 고려대학교 전기전자전파공학과 (공학사)

2013 고려대학교 전기전자공학과 석박통합 과정

2016~현재 전자부품연구원 연구원

관심분야: Image Enhancement, Stereo matching, Sensor fusion

2009 경희대학교 전자공학과 졸업

2012 경희대학교 대학원 석사

2012~2015 현대자동차

2015~현재 전자부품연구원 선임연구원

관심분야: Image Enhancement, Advanced Driver Assistance System, 3D Reconstruction, Deep Learning