드론의 안전비행을 위한 국부 및 전역지도 인터페이스

© Korea Robotics Society. All rights reserved.

Abstract

To fly a drone or unmanned aerial vechicle(UAV) safely, its pilot needs to maintain high situation awareness of its flight space. One of the important ways to improve the flight space awareness is to integrate both the global and the local navigation map a drone provides. However, the drone pilot often has to use the inconsistent reference frames or perspectives between the two maps. In specific, the global navigation map tends to display space information in the third-person perspective, whereas the local map tends to use the first-person perspective through the drone camera. This inconsistent perspective problem makes the pilot use mental rotation to align the different perspectives. In addition, integrating different dimensionalities (2D vs. 3D) of the two maps may aggravate the pilot’s cognitive load of mental rotation. Therefore, this study aims to investigate the relation between perspective difference (0°, 90°, 180°, 270°) and the map dimensionality matches (3D-3D vs. 3D-2D) to improve the way of integrating the two maps. The results show that the pilot’s flight space awareness improves when the perspective differences are smaller and also when the dimensionalities between the two maps are matched.

Keywords:

drone, global map, local map, spatial situation awareness, mental rotation, reference frame, dimensionality, navigation1. 서 론

민간용 드론(Drone or UAV)은 원격 촬영, 유통 및 취미의 다양한 목적으로 활용되고 있어 우리의 실생활과 한 층 더 가까워 지고 있다. 동시에 개인의 재산과 생명에 피해를 유발할 수 있 는 드론의 조종사고 또한 높아지고 있다. 이를 완화하기 위해 자동 항법 기능을 제공하기도 하지만[1], 드론 조종사고는 여전 히 발생하고 있다. 일반용 드론의 조종사고에 대한 종합적 자 료가 부족하기 때문에, 군용 무인 항공기 자료를 참조하면, 원 인 규명이 가능한 무인 항공기 조종사고 70% 중에서 33%가 인간의 조종 과오로 분류된다[2]. 군용 드론의 경우 고사양 장 비를 사용하면서, 훈련된 전문 조종사가 조종한다는 점을 고 려할 때, 민간용 드론의 경우 조종 과오로 발생한 사고는 군용 드론보다 더욱 높으리라 추정할 수 있다.

드론사고의 원인 중 한 가지가 비행공간에 대한 조종사의 상황 인식(spatial situation awareness)이다. 조종사는 비행하면서 비행공간을 이해하고, 드론의 위치, 방위를 이해하고, 올바른 비행 방향을 결정하여야 한다. 비행 공간의 상황 인식이란 지 리적 인식(geographical awareness)과 항해적 인식(navigational awareness)과 유사한 개념으로, 조종사가 현재 기체의 위치 및 기체를 둘러싼 환경에 대한 심성 모형(mental model)을 형성하 는 것이다[2-5]. 그런데 [2]에 의하면, 조종사의 상황 인식 역량 이 저하(poor situation awareness)되면 조종사의 지각(perception) 능력이 떨어지기 때문에 비행 공간 및 기체 위치를 파악하는 능력도 함께 저하된다. 따라서 조종사의 방위에 대한 판단 지 연 및 착오는 결국 드론 비행까지 영향을 준다.

민간용 드론 조종사는 외부 조종법(external piloting)을 사용 하기 때문에 드론의 비행 공간을 이해하는 데 어려움을 겪는다[6-9]. 외부 조종법은 육상의 드론 조종사가 육안으로 기체를 직접 보면서 조종하는 방식이기 때문에, 민간용 드론 조종사는 공 간을 인식하기 위해 주로 자기중심적 참조틀(reference frame) 혹은 1인칭 관점을 사용하게 된다. 하지만 드론이 공간에서 안 전하게 비행하기 위해서는 드론 중심의 참조틀이나 환경 중심적 인 3인칭 관점을 사용해야 한다. [10]에 따르면, 사람들은 3인칭 관점으로 드론의 항해 공간을 파악해야 하는 것을 알고 있더라 도, 1인칭 관점의 자기중심 참조틀을 바탕으로 드론의 기본 방위 를 선택하는 경향이 있다. 이는 민간용 드론 조종사가 공간을 이 해하는 관점의 불일치 문제로 어려움을 겪는 것을 시사한다[6].

조종사의 비행공간 인식문제를 해결하기 위한 대표적인 방 법 중 하나가 국부지도(local map)와 전역지도(global map)를 조종사에게 제공하여 드론 중심적인 참조틀 즉 3인칭 관점에 서 공간을 이해할 수 있도록 하는 것이다.

국부지도는 드론 주변의 일부 환경을 상세하게 표현하는 데, 대개 드론 컨트롤러 디스플레이 화면의 전체 공간을 차지 한다. 국부지도는 대개 드론에 장착된 카메라가 촬영하고 있 는 영상이기 때문에, 조종사가 바라보는 전방향 시야(forward field of view, FFV) 화면이 된다. 이 때문에 국부지도 방식은 드론 조종사가 마치 내부조종법으로 조종하듯 1인칭 관점 혹 은 자기중심적인 관점으로 조종할 수 있게 한다[11]. 최근에는 드론이 촬영하고 있는 영상을 몰입형 헤드업디스플레이를 통해 보며 조종할 수 있는 방식도 연구 개발되고 있다[11-13]. 그 러나 조종사가 드론 카메라를 통해 바라보는 전방향 시야의 각도는 보통 90° 에서 140° 로 제한적이다. 일반적인 조종 환경이나 공간 항해 상황에서 사람들이 갖는 시야각은 180° 에서 270° 라는 점을 고려한다면 드론 조종사가 비행에 필 요한 전체적인 공간을 이해하는 데 어려움이 발생할 수밖에 없다.

이와 달리, 전역지도는 국부지도의 제한된 시야각 문제를 개선하기 위한 인터페이스로 사용되고 있다(e.g. DJI Go app). 전역지도는 드론 주변의 광대역 지리 정보를 작은 크기로 축 소하여 제시하며, 보통 국부지도가 제시되는 디스플레이 화면 의 하단에 위치한다. 전역지도는 3인칭 관점으로 표현되어 있 으며 GPS (Global Positioning System)와 같이 기체 주변의 넓 은 공간을 표현하기에 적합하다. [14]에 의하면 전역지도는 지 도의 크기가 작고 세부적인 정보를 제공하기 보단, 거대 공간 속에서 드론 기체의 위치와 방향을 보여주는 장점이 있다.

이와 같이 좁은 공간의 세부적인 특징을 보여주는 국부지 도와 넓은 공간을 요약해서 알려주는 전역지도는 상호보완 관 계이기 때문에 혼용하였을 때 드론 내비게이션 수행에 효과적 일 수 있다[14,15].

그러나 기대와 달리, 국부지도와 전역지도 혼용방식은 그 의도와는 달리 조종사의 공간인식을 저해할 수 있다. 조종사 가 두 지도를 실시간으로 참조하면서 두 지도에서 제시하는 공간정보를 통합해서 사용해야 하기 때문이다. 특히 두 지도 가 다른 참조 각도로 제시되는 상황에서는 두 지도에서 주는 정보를 통합하는 데 심각한 어려움을 야기할 수 있다. 왜냐하 면, 국부지도는 전방향 시야 관점의 회전지도(rotation map)인 반면, 전역지도는 기본 방위(cardinal orientation)의 고정지도 (fixed map)이기 때문이다. 이러한 이유로 국부지도는 드론의 비행 방향에 따라 북위 방향이 계속 변하지만, 전역지도는 지 도의 북위 방향의 변화 없이 드론의 비행 방향을 볼 수 있다[20]. 따라서 조종사는 국부지도와 전역지도의 참조틀의 각도 차이 에 따라 정보를 통합하는데 영향을 받을 것이다.

아울러, 두 지도의 공간정보 제시방식이 3차원인지 2차원 인지도 조종사의 공간인식에 영향을 미친다. 선행 연구에 의 하면 3차원은 실제 공간과 양립 가능한 표상이고, 근접 부합 성의 원리(proximity compatibility principle)에 적합하기 때문 에 내비게이션 수행에 유리하다[17,21,22]. 반면, 2차원은 3차원 보다 심적 회전이 더 빠르고 속도 제어(air speed control)와 같 은 2차원 정보에 주의를 주는 데 유리할 수 있다[22,23]. 이와 같 이 비행하는 맥락에 따라 지도의 차원성은 각기 다른 장단점을 가진다.

현재까지 연구개발은 지도의 혼용 방식에만 초점을 맞추었 을 뿐, 혼용되는 지도의 어떠한 특성이 드론 내비게이션 수행 에 효과적인지에 대한 연구는 미흡한 실정이다[14,15,18,19].

따라서 본 연구의 목표는 드론 조종사의 공간 상황 인식을 높이기 위해 국부지도와 전역지도의 참조틀 불일치 문제를 완 화하는 인터페이스를 설계하는 것이다. 이를 위해 두 가지 지 도의 공간 참조틀 간의 각도 차(0°, 90°, 180°, 270°)와 두 지도 의 차원 일치성(일치: 3D-3D vs. 불일치: 3D-2D)을 독립 변수 로 하고, 각 조건에서 비행 방향을 선택하는 정확도와 비행 방 향 선택의 난이도를 소요시간으로 측정하여 평가한다.

본 연구는 실용적인 측면에서 드론 카메라로 보여지는 3차 원의 FFV 국부지도 상황에서 공간 지식 인출이 쉬운 전역지 도의 특성을 파악하고, 안전비행을 위한 내비게이션 디자인 인터페이스를 개발하는데 기여할 수 있다. 또한, 이론적으로 는 국부지도와 전역지도를 통해 조종사의 공간인식을 어떻게 발달시키는지 이해를 더 하는 의의가 있으며, 이를 통해 드론 조종사고를 줄이는 데 기여할 것이다.

2. 비행지도 인터페이스 관련 연구 동향

본 장에서는 전역지도와 국부지도 간의 관점 불일치 문제 를 완화할 수 있는 내비게이션 지도의 인터페이스 관련 연구 를 살펴보고자 한다. 관점이 다른 두 지도를 최적화하여 사용 할 수 있는 인터페이스 설계를 도출한다.

2.1 공간 상황인식(Spatial situation awareness)

항공 분야에서 상황 인식은 공간(spatial), 상태(status), 그리 고 전체적인 상황(overall situation)의 3가지 요소로 나눌 수 있 다[4]. 그중에서 조종사의 내비게이션 수행에 가장 기본적인 바 탕이 되는 것은 바로 공간에 대한 상황 인식이다. 공간에 대한 상황 인식은 조종사가 현재 기체의 위치를 파악하고 기체를 둘러싼 환경인 주변 지형과 비행체 및 기타 위협 요인에 대한 심 성 모형(mental model)을 형성하는 것을 말하며, 항해 인식 (navigational awareness)과 지리적 인식(geographical awareness) 의 개념과 유사하다[3-5,27]. 조종사가 공간에 대한 이해도가 높 아져 상황 인식 역량이 높아지면 조종에 필요한 인지 부하는 줄어들고, 방위 판단에 대한 의사 결정 능력이 향상되어 내비 게이션 조종 수행도가 높아진다[8,11,13,28]. 그러나 조종사는 관 점이 다른 국부지도와 전역지도를 동시에 참고하기 때문에 관 점 불일치 문제가 발생한다. [11]에 의하면, 무인항공기 조종 사는 지각 정보를 토대로 최신 공간 정보를 지속적으로 업데 이트해야 하기 때문에, 추가적인 인지 과정은 조종사의 비행 공간에 대한 상황 인식 저하에 위협 요인이 될 수 있다.

2.2 국부지도와 전역지도의 참조틀의 각도 차

드론의 비행지도에 관한 선행연구는 거의 없다. 이에 다른 도메인의 항해 지도 연구를 참고하였다. 가상환경에서는 내비 게이션을 돕기 위해 국부지도와 전역지도를 사용하였다 [14,15,18,19]. 드론 상황과 마찬가지로, 국부 지도는 현재 위치의 주위 환경의 일부분을 상세하게 보여준다. 또한, 1인칭 관점으 로 사람들이 움직이는 경로대로 공간을 보여주기 때문에 공간 을 쉽게 이해할 수 있다는 장점이 있다. 그러나 [14]와 [24] 에 의하면, 국부 지도만 참고하면 1인칭 관점 중심으로만 공간을 이해하기 때문에 전체적인 공간을 이해하는 조망 지식(survey knowledge)을 형성하기 어렵다. 조망 지식은 주요 지형물 (landmark) 간의 거리와 방향의 관계를 바탕으로 공간에 대한 배열 지식(configurational knowledge)을 말한다.

따라서 국부지도의 문제를 해결하기 위해 전역지도가 필요 하다. 전역지도는 광대역 공간을 축소한 지도로 제시하며, 보 통 국부지도의 하단에 위치한다. 전역 지도는 3인칭 관점을 중 심으로 공간을 보여주고, 무정보 탐색(uninformed) 시 충분한 정보를 제공할 수 있다.

드론 조종사가 비행 공간에 대한 이해를 높이기 위해 두 지 도를 혼용하는 내비게이션 방식은 효과적일 수 있다. 조종사 는 1인칭 관점의 국부지도와 3인칭 관점의 전역지도를 비교하며 보다 정확한 공간과 위치를 판단하는 것이 가능하기 때문이 다. [17]에 의하면, 전방향 시야 관점과 국부지도와 전역지도 를 혼용하는 방식은 높은 내비게이션 수행도를 나타냈다.

그러나 앞서 살펴보았듯이, 국부지도와 전역지도에서 제공 하는 공간정보를 적절히 참조하기 위해서 조종사는 두 지도 중 하나를 마음속에서 회전시켜서 참조틀 혹은 관점을 일치시 켜야 한다. 이러한 인지적 노력(cognitive effort)을 심적 회전 (mental rotation)이라고 부른다.

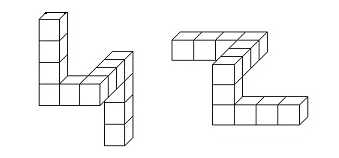

심적 회전이란 [Fig. 1]에서처럼, 서로 다른 각도로 제시되 어 있는 물체가 서로 같은지 다른지를 알기 위해서 한 대상의 이미지를 마음속에서 회전시키는 인간 고유의 인지적 성향을 의미한다[16]. [17]에 따르면, 사람들은 참조틀이 불일치하면 세상 중심적 참조틀(world-centered reference frame)을 자기중 심적 참조틀(ego-centered reference frame)과 일치하도록 심적 회전하여 드론의 방위를 이해한다. 기존 연구에 의하면[16-17,23], 두 대상의 각도 차가 클수록 그리고 두 대상이 제시된 차원이 다를 때 인지부하량이 높다. 즉, 사람들의 심적 회전 시간이 더 오래 걸리고, 더 어려워한다.

따라서 전역지도와 국부지도를 혼용하는 방식은 두 지도를 통해 공간의 이해를 높이고자 하는 의도와는 달리 오히려 공 간에 대한 상황 인식을 저하시키고, 결과적으로 위험 상황을 초래할 가능성이 있다.

2.3 차원성(Dimensionality)

선행 연구들에 따르면 심적 회전에 소요되는 시간에 영향을 미치는 또 하나의 요인은 차원성(dimensionality)이라고 알려져 있다[16,17,21-23]. 따라서 공간 지식 인출이 쉬운 지도의 혼용 방식을 위해 고려해야 할 것은 바로 국부지도와 전역지도의 차원이다.

하지만 3차원과 2차원 지도가 내비게이션 수행에 미치는 영향에 대한 선행 연구 결과는 일관되지 않다. 3차원 지도가 내비게이션 수행에 유리한 이유는 3차원 지도가 지도 밖의 실 제 공간과 차원이 일치하여 양립 가능한 표상이기 때문이다 [17,21,25]. 따라서, 3차원 지도가 조종사의 공간 인식 유지에 유리 하리라 추측할 수 있다. 반면, 2차원 지도가 내비게이션 수행 에 효과적일 수 있는 이유는 복잡도가 낮기 때문에, 심적 회전 에 소요되는 시간이 짧고, 위치 탐색을 빠르게 할 수 있었기 때 문이다[22,23].

항공 분야에서는 대개 3차원 지도를 선호하지만, 선행 연구에 의하면 2차원 지도와 3차원 지도는 장단점이 각기 다르다 [21,22,25]. [22]에 의하면, 3차원이 실제 공간을 그대로 재현하기 때문에 실제성과 정보를 통합하는 장점이 있는 반면, 3차원이기 때문 에 깊이(depth) 표현의 정확성이 떨어지고, 이미지들이 뭉치는 클러터(clutter)가 나타나서 내비게이션이 더 어려워질 수 있다.

따라서 드론 항해 시 가장 적합한 국부지도와 전역지도 인 터페이스의 디스플레이 차원성도 살펴볼 필요가 있다. 드론 내비게이션에 사용되는 국부지도는 대개 카메라로 촬영한 실 제 공간의 영상이 보여지기 때문에 3차원의 화면이 나타난다. 이에 비해, 전역지도는 2차원 혹은 3차원으로 나타내는 것이 가능하다.

정리하면, 국부지도와 전역지도를 혼용하는 드론 컨트롤러 의 참조틀 혹은 관점 불일치 문제 해결하기 위해서 두 지도 간 참조틀의 각도 차와 두 지도의 차원성이 드론 비행에 영향을 미친다고 볼 수 있다. 선행 연구를 토대로 드론의 조종사는 두 지도를 실시간으로 참조하기 위해서 심적 회전을 해야 한다. 이 과정에서 심적회전은 두 대상의 각도 차이가 클수록[16], 그 리고 차원이 불일치할 경우 더 어렵다[16,23]. 이러한 연구결과 를 토대로 국부지도와 전역지도의 참조틀의 각도 차와 차원의 일치 여부가 내비게이션 수행에 영향을 줄 것으로 예측할 수 있다. 하지만 [26]에 의하면 두 대상의 유사성이 높은 경우에 는 두 대상의 각도 차이가 클지라도 심적 회전이 수월해진다.

따라서 본 연구에서는 실제 공간과 근사하게 표현된 3차원 국 부지도에 가장 적합한 전역지도의 차원은 양립 가능한 표상인 3 차원이라고 예측하였고, 두 지도 간 참조 각도가 높아질수록 비 행 방향 선택을 하는 데 소요된 시간이 늘어나리라 예측하였다.

3. 사용자기반 인터페이스 평가연구

3.1 참가자와 실험설계

실험참가자는 연세대학교 학부 및 대학원생 26명이 자발적 으로 참여하였다(남자 16명, 여자 10명). 참가자들의 전체 평 균 연령은 23.69세(SD = 2.85)이고, 남성 평균 연령은 24.75세 (SD = 3), 여성 평균 연령은 22세(SD = 1.56)였다.

본 실험은 드론 비행 시뮬리에션 시스템의 모니터를 통해 제시되는 자극을 지각하는 데 문제가 없거나 정상 교정시력 0.7 이상을 가진 사람을 대상으로 하였으며, 이전에 드론을 조 종해 본 경험이 있는 자는 모집 단계에서 제외되었다. 모든 참 가자들은 실험 참가비 1만원을 지급받았다.

실험은 이원 피험자 내 요인설계방안을 사용하였다. 독립변 인은 (1) 두 지도 간 참조 각도 차이(0°, 90°, 180°, 270°)와 (2) 전 역지도와 국부지도의 차원 일치 여부(3D-3D vs. 3D-2D)였다.

실험 참가자의 과제는 3인칭 관점의 전역지도에 표시된 화 살표 방향을 본 후, 직전에 보았던 1인칭 관점의 국부지도에 알맞은 비행 방향을 입력하는 것이었다. 모든 참가자는 전역 지도와 국부지도 간 참조 각도 차이(0°, 90°, 180°, 270°)와 차 원 일치성(3D-3D vs. 3D-2D)을 경험하면서 드론 내비게이션 과제를 수행하였다. 이때 전역지도의 자극에 대한 학습효과를 통제하기 위해 실험 참가자 26명 중 15명(남자 10명, 여자 5명) 은 국부지도와 전역지도의 차원 일치(3D-3D) 조건을 먼저 수 행한 후 차원 불일치(3D-2D) 조건을 수행하도록 하였고, 나머 지 11명(남자 6명, 여자 5명)은 차원 불일치(3D-2D) 조건을 수행 한 후 차원 일치(3D-3D) 조건을 수행하도록 무선 할당하였다.

3.2 실험과제: 비행 방향 선택과제

비행 방향 선택과제는 [17]의 방법을 참고하여 개발하였다. 드론 조종사는 전역지도와 국부지도를 참고하며 정확한 비행 방향을 선택하는 과제를 실시하였다. 실험참가자는 전역지도 에 표시된 드론 비행 방향을 토대로, 국부지도를 보며 전-후- 좌-우 중 하나의 방향을 선택하여 입력해야 했다. 참가조종사 가 입력한 값이 사고가 나지 않는 올바른 비행 방향과 일치하 면 정답 시행이고, 비행 방향이 불일치하면 오답 시행으로 분 류하였다.

국부지도를 주로 보면서 전역지도를 참고하는 실제 내비게 이션 방식에 따라, 실험 참가자는 1인칭 관점의 국부지도 이미 지를 먼저 본 후 3인칭 관점의 전역지도 이미지를 보도록 하였 다. 본 연구는 국부지도와 전역지도를 혼용하는 상황인 조망 지식을 측정하기 위하여 두 지도를 정적 이미지로 구성하였 고, 지도에 나타난 지형물의 색과 모양 그리고 비행 고도 등의 요소를 통제하였다.

국부지도에는 텅 빈 교차로 공간이 있고, 이어서 나타난 전 역지도에는 교차로 공간에 비행 방향을 알려주는 화살표가 표 시된다. 국부지도와 전역지도는 같은 교차로 공간을 보여주지 만, 지도의 특성에 따라 각도와 공간의 넓이가 다르다. 따라서, 실험 참가자는 전역지도 화면을 보고 알맞은 비행 방향을 입 력하기 위해, 이전에 보았던 국부지도 이미지를 인출(retrieval) 해야 한다.

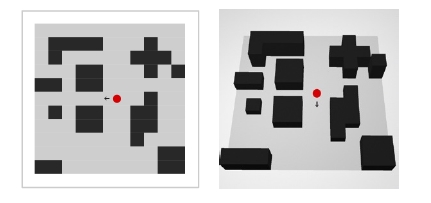

국부지도와 전역지도는 참조 각도의 차이(0°, 90°, 180°, 270°)가 있었기 때문에, 실험참가자가 비행 방향을 선택하는 데 시간이 오래 걸릴수록 심적 회전 시간이 오래 걸리고, 더 어 려워한다고 간주하였다. 전역지도 이미지는 [Fig. 2]와 같이 전체 가로 11칸 세로 11칸으로 이루어졌으며 검정색 블럭과 회색 도로로 구성되었다. 전역지도는 0°, 90°, 180°, 270°로 회 전하였고, 각도별로 2차원과 3차원으로 인터페이스를 개발하 였다.

1인칭 관점의 전방향 시야 국부지도 이미지는 [Fig. 3]과 같이 3인칭 관점의 전역지도를 바탕으로 제작하였다. 국부지 도는 전역지도보다 더욱 좁은 공간을 보여준다는 특성을 나 타 내기 위하여 기존의 전역지도의 교차로에서 20 cm 거리에 80° 에서 카메라로 내려다보는 시점으로 이미지 렌더링을 하였다.

3.3 실험 절차

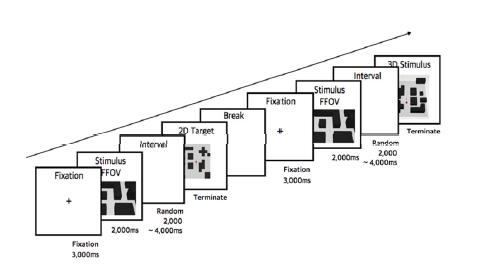

실험 절차는 [17]의 내비게이션 테스크를 참고하여 [Fig. 4] 와 같은 순서를 이용하였다. 개인 실험 참가자들은 실험에 앞 서 과제에 관한 설명을 들었다. 본 과제 시행 전 16번의 연습 시행을 실시하였다. 연습 시행의 실행 방법은 본 과제와 동일 하였으며, 정답률이 50% 미만인 참가자의 경우 해당 과제에 대해 다시 안내받고 연습 시행을 재시행하였다.

본 과제가 시작되면 3,000 ms 동안 화면 중앙에 제시된 응 시점을 바라본다. 그 후 단서 화면인 3D 국부지도 자극 이미지 가 2,000 ms 동안 나타난다. 이후 응시점 화면이 무선으로 2,000 ms에서 4,000 ms 간격으로 제시되었다. 그 후 나타난 검 사 화면에서 알맞은 비행 방향을 입력하였다.

국부지도와 전역지도의 차원이 일치(3D-3D)한 경우 두 지 도 간의 참조 각도 차이(4: 0°, 90°, 180°, 270°)와 비행 방향(4: 전-후-좌-우)에 따라 16개의 이미지가 제시되었고, 이를 무선 으로 6회 반복하여 96회 시행되었다. 국부지도와 전역지도가 불일치(3D-2D)한 경우에도 위와 같은 조건으로 16개의 이미 지가 제시되었고, 무선으로 6회 반복하여 96회 시행되었다. 실 험 참가자의 피로 효과를 줄이기 위해 매 24회 시행 후 30,000 ms 휴식을 취할 수 있도록 조치하였다.

4. 결과

본 연구는 드론 컨트롤러의 국부지도와 전역지도의 참조틀 불일치 문제를 해결하기 위해 조종사의 높은 공간 상황 인식 을 유지할 수 있는 지도 혼용 방식의 특성을 찾는 데 있다.

국부지도와 전역지도 간 참조 각도 차이와 차원일치 여부 에 따른 드론의 비행 방향 선택에 소요된 시간을 알아보기 위 해 반복 측정 변량 분석(Repeated Measure ANOVA)을 실시하 였다. 분석 결과 참조 각도의 차이(X2 = 13.356, p = .20)와 두 지도 간의 차원 일치 여부(X2 = .000, p = .000)와 그리고 두 지도 간 참 조 각도의 차이와 차원 일치에 따른 상호작용(X2 = 9.928, p = .078) 은 Mauchly의 구형성 가정이 충족되었다.

드론의 비행 방향 선택에 소요된 시간은 실험 참가자가 정확히 조종을 한 경우만 분석하였다. 따라서 비행 방향을 잘못 선택하면 사고가 나는데 이런 오답(15%)과 3표준편차 값 밖에 있는 아웃라이어(1.8%)는 분석에서 제외하였다. 전체 실험 참가자의 비행 방향 선택에 소요된 평균 시간은 1,910.46 ms (SD = 698.60) 였다.

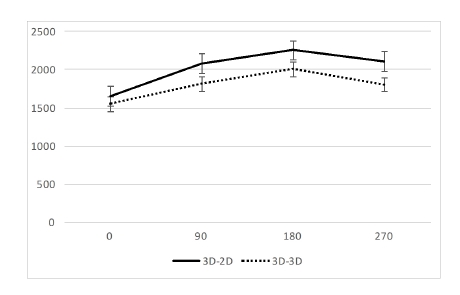

4.1 두 지도 간 참조 각도 차에 따른 비행 방향 선택시간

국부지도와 전역지도의 간의 참조 각도 차에 따른 비행 방 향 선택에 소요된 시간(F(1, 25) = 18.96, p = .000)은 통계적으 로 유의미한 결과가 나타났다. 비행 방향 선택시간은 0° 조건 (M = 1,600.54, SD = 546.51), 90° 조건(M = 1,951.76, SD = 700.43), 270° 조건(M = 1,957.67, SD = 772.05), 그리고 180° 조 건(M = 2131.85, SD = 673.21)의 순으로 비행 방향 선택시간이 느리게 나타났고, 그 차이는 [Fig. 5]와 같다.

4.2 두 지도 간 차원 일치에 따른 비행 방향 선택시간

국부지도와 전역지도의 차원 일치의 주효를 분석하였다. [Fig. 5]에 제시된 것처럼 국부지도와 전역지도의 차원이 일치 한 조건(3D-3D)의 비행 방향 선택에 소요된 평균 시간(M = 1,794.94, SD = 552.38)이 불일치한 조건(3D-2D)의 평균 비행 방향 선택시간(M = 2,025.97, SD = 802.67)보다 빨랐다. 이 차 이는 통계적으로 유의미한 결과(F(1, 25) = 5.765, p = .024)가 나타났다.

또한, 각도 차와 차원성 일치의 상호작용 효과를 알아보았다. 참조 각도 차이와 차원 일치 여부의 상호 작용(F(1, 25) = 1.80, p = .19)은 통계적으로 유의미하지 않았다. 그럼에도 불구하고, 인터페이스 탐색을 위해 일부 집단 간에 대응 표본 T검정을 분 석하였다. 그 결과는 [Table 1]과 같다. 두 지도 간 차원의 일치 조건(3D-3D)과 불일치 조건(3D-2D)의 평균 비행 방향 선택시간 차이는 90° 조건(M = 273.13, SD = 607.90)에서는 t (25) = 2.247, p = .034, 270° 조건(M = 305.39, SD = 675.51)에서는 t (25) = 2.260, p = .033으로 통계적으로 유의미한 결과가 나타났다. 이 외에 0° 조건(M = 98.03, SD = 390.23)에서는 t (25) = 1.256, p = .221와 180° 조건(M = 247.55, SD = 643.26)에서는 t (25) = 1.924, p = .066 으로 통계적으로 유의미한 결과가 나타나지 않았다.

5. 결론 및 논의

본 연구는 민간용 드론 조종사고를 방지하기 위하여 국부 지도와 전역지도 간의 관점 불일치 문제를 완화할 수 있는 내 비게이션 인터페이스를 알아보고자 하였다. [16], [23]의 연구 에 따라 국부지도와 전역지도 간의 참조 각도의 차이가 클수 록 드론의 비행 방향 선택에 소요된 시간이 늘어날 것이고, [17], [21] 의 연구를 토대로 두 지도 간의 차원이 일치할 때 드 론의 비행 방향 선택시간이 짧아질 것이라고 가설을 설정하였 다. 실험의 결과 두 지도 간의 참조 각도 차이는 0°, 90°, 270°, 180° 순으로 비행 방향 선택시간이 느려졌다. 또한, 두 지도 간 의 차원이 일치한(3D-3D) 조건이 불일치한(3D-2D) 조건보다 비행 방향 선택에 걸린 소요시간이 짧았다.

국부지도와 전역지도 간의 참조 각도는 270°보다 180° 일 때 평균 비행 방향 선택시간이 느리게 나타났다. 이러한 실험 결과는 180° 참조 각도 차이에서는 1인칭 관점 참조틀(ERF)과 3인칭 관점 참조틀(WRF)을 하나의 참조틀로 만드는데 인지 적인 어려움 따른다는 기존의 연구[17]와 일맥상통한다. 또한, 180° 참조 각도 차이에서는 차원 일치 조건과 차원 불일치 조 건간에 유의미한 차이가 나타나지 않았다. 이는 180° 참조 각 도 차이는 조종사가 드론의 비행 방향과 마주하는 상황이기 때문에 심적 회전이 다른 각도보다 더 어렵다는 것을 의미한 다. 180° 참조 각도 차이는 차원 일치성에 따라 효과가 나타나 지 않기 때문에 이 참조 각도 차이에서 조종사의 인지 부하를 최소화할 수 있는 추가적인 요인 연구가 필요하다.

반면, 두 지도의 참조 각도 차이가 0°, 90°, 270°일 때는 국부 지도와 전역지도 간의 차원이 일치(3D-3D) 조건이 불일치 (3D-2D) 조건보다 비행 방향 선택에 걸린 시간이 짧았다. 이는 위와 같은 참조 각도 차이에서 두 지도 간의 차원 일치 상태가 드론 내비게이션에 효과적임을 시사한다. 이러한 결과는 3차 원이 실제 공간과 유사하여 양립 가능한 표상이고, 근접 부합 성의 원리에 적합하기 때문에 내비게이션 수행에 유리하다는 기존 연구와 일맥상통한다[17,21,22]. 또한, 차원 일치성은 두 지 도 간의 유사성을 의미하기 때문에, 두 대상의 유사성이 높을 수록 각도 차이가 클지라도 심적 회전이 어렵지 않다는 기존 의 연구[26]에도 부합한다.

따라서, 본 연구의 실험 결과는 국부지도와 전역지도를 혼 용하는 드론 콘트롤러 인터페이스 디자인에 적용할 수 있는 몇가지 가이드라인을 제시한다. 국부지도가 드론이 촬영하는 3차원 영상 화면이라면 전역 지도는 3차원으로 제시되어야 한 다. 또한, 국부지도와 전역지도의 참조각도가 180°일 때는 조 종사의 공간에 대한 심적회전이 어렵기 때문에 두 지도의 참 조 각도를 0°, 90° 혹은 270°로 변형하는 것이 필요하다.

전역지도는 북위 방향이 고정되어 있기 때문에, 두 지도의 참조각도를 변형하기 위해서는 국부지도가 회전해야 한다. 두 지도 참조각도 차이가 0° 일 때 가장 내비게이션 수행이 빠르 고 정확했지만 0° 에 맞추려면 국부지도가 전역지도의 북위 방향에 맞춰 큰 각도를 매번 회전해야한다. 이는 또 다른 공간 인식 저해의 요인이 된다. 따라서, 두 지도의 참조 각도 차이가 90~180°에 해당할 경우에만 국부지도를 좌, 또는 우방향으로 90° 회전하여 두 지도의 참조 각도 차이를 90°, 270°으로 변경 하는 것이 필요하다.

본 연구의 실험 설계는 드론 조종 맥락에 맞춰 1인칭 관점의 국부지도를 먼저 제시한 후, 전역지도가 나타나도록 조치하였 다. 이는 드론 조종사들이 국부지도 이미지를 부호화한 뒤, 전역 지도에 화살표로 표시된 드론의 비행 방향에 나타나면 국부지 도 관점에서 적절한 드론 비행 방향을 입력하도록 조치한 것이다.

이러한 제시 방법은 우리가 내비게이션을 보는 방식과 유 사하지만 전역 지도에 대한 학습 효과를 유발할 수 있다. 그러 나, 차원 일치 조건을 먼저 시행한 실험 참가자는 오히려 뒤이 어 시행한 차원 불일치 조건에서 내비게이션 수행 결과가 향 상되지 않았다. 이는 전역지도에 대한 학습 효과와 상관없이 차원 일치 여부에 따른 효과가 발생한 것을 의미한다.

또한, 이러한 제시 방법은 국부지도와 전역지도가 동시에 제시되는 실제 드론 컨트롤러 조종 환경과 다소 차이가 있다. 따라서, 드론 컨트롤러 조종 화면 내에서 두 가지 지도를 배치 하였을 경우에도 위와 같은 실험 결과가 나타나는지 확인할 필요가 있다.

아울러, 본 실험은 드론 컨트롤러의 전-후-좌-우 4가지 방향만 제시되었고, 드론 콘트롤러 인터페이스의 상승-하강(Throttle) 과 회전(yaw)은 고려되지 않았다. 이러한 통제 상황은 내비게 이션 수행 시 방위 선택과 지도 혼용 방식 간의 관계를 파악하 는 데 유리하다. 반면, 실제 조종 상황과 차이가 있기 때문에 한계를 지닌다. 추후에는 상승-하강과 회전에 대한 변수가 포 함시켜 두 지도 간 참조 각도 차이와 차원성 일치를 측정하는 것이 필요하다.

본 연구의 의의는 드론 컨트롤러의 3차원 국부지도에 가장 적합하고, 공간 지식 인출이 쉬운 전역지도의 특성을 파악하여 내비게이션 가이드라인을 개발하는 데 있다. 따라서 드론 컨트 롤러 내비게이션 디자인 시에는 3차원 국부지도와 3차원 전역 지도가 제시되어야 하고, 두 지도 간의 참조 각도 차이가 180°일 때는 조종사의 인지부하를 완화할 수 있도록 국부지도가 회전 하여 참조 각도 차이를 90° 혹은 270°로 유지하는 것이 필요하다.

드론은 자동항법 기술의 발달로 인간의 직접 개입이 불필 요한 경우가 많아지고 있다. 그러나 민간용 드론의 경우 취미 용으로 사용되거나, 다이나믹한 상황에서 정밀한 조종이 필요 할 경우 조종사들이 드론을 직접 조종하는 방식은 중요하다. 따라서, 민간용 드론은 자동항법 기술 뿐 아니라, 조종의 안전 을 위해 인지적 요인을 바탕으로 한 콘트롤러의 인터페이스 디자인에 대한 개발도 필요하다. 본 연구는 조종사가 드론을 육안으로 구분하기 어려운 상황에서 민간용 드론을 안전하게 조종하는 데 유용한 드론 콘트롤러 인터페이스 디자인 지침이 되리라 예상한다.

Acknowledgments

This research was supported by Yonsei Internet of Things Academy via an education grant program (CAC15113) of Seoul Business Agency and Seoul Metropolitan Government.

References

-

V.S. Fnu, K. Cohen, Intelligent Fuzzy Flight control of an Autonomous Quadrotor UAV, 52nd Aerospace Sciences Meeting, AIAA SciTech Forum, National Harbor, Maryland, (2014), p0992.

[https://doi.org/10.2514/6.2014-0992]

- S.D. Manning, C.E. Rash, P.A. LeDuc, R.K. Noback, J. McKeon, “The Role of Human Causal Factors in U.S. Army Unmanned Aerial Vehicle Accidents,” U.S. Army Aeromedical Research Laboratory, USAARL Report No. 2004-11, March,, (2004).

-

A.D. Andre, C.D. Wickens, L. Moorman, Display Formatting Techniques for Improving Situation Awareness in the Aircraft Cockpit., Int. J. Aviat. Psychol., (1991), 1(3), p205-218.

[https://doi.org/10.1207/s15327108ijap0103_2]

-

W. Barfield, C. Rosenberg, T.A. Furness III, Situation awareness as a function of frame of reference, computer-graphics eyepoint elevation, and geometric field of view., Int. J. Aviat. Psychol., (1995), 5(3), p233-256.

[https://doi.org/10.1207/s15327108ijap0503_1]

-

M.R. Endsley, Toward a theory of situation awareness in dynamic systems., Hum. Factors, (1995), 37(1), p32-64.

[https://doi.org/10.1518/001872095779049543]

- K. Cho, M. Cho, J. Jeon, Fly a drone safely: Evaluation of an embodied egocentric drone controller interface., Interact. Comput., (2017), 29(3), p345-354.

-

J.T. Hing, K.W. Sevcik, P.Y. Oh, Development and evaluation of a chase view for UAV operations in cluttered environments., J. Intell. Robot. Syst., (2010), 57(1), p485-503.

[https://doi.org/10.1007/s10846-009-9356-4]

-

K. Neville, B. Blickensderfer, J. Archer, K. Kaste, S.P. Luxion, A cognitive work analysis to identify human-machine interface design challenges unique to uninhabited aircraft systems, Human Factors and Ergonomics Society Annual Meeting, (2012), 56(1), p418-422.

[https://doi.org/10.1037/e572172013-087]

- K. W. Williams, “8. Human factors implications of unmanned aircraft accidents: Flight-control problems,” Human Factors of Remotely Operated Vehicles (Advances in Human Performance and Cognitive Engineering Research, Volume 7), Nancy J. Cooke, Heather L. Pringle, Harry K. Pedersen, Olena Connor ed., Emerald Group Publishing Limited, pp. 105-116,, (2006).

-

T.P. McNamara, B. Rump, S. Werner, Egocentric and geocentric frames of reference in memory of large-scale space., Psychon. Bull. Rev., (2003), 10(3), p589-595.

[https://doi.org/10.3758/bf03196519]

-

J.J. Ruiz, A. Viguria, J.R. Martinez-de-Dios, A. Ollero, Immersive displays for building spatial knowledge in multi-UAV operations, 2015 International Conference on Unmanned Aircraft Systems, Denver, CO, USA, p1043-1048, (2015).

[https://doi.org/10.1109/icuas.2015.7152395]

-

S. Zollmann, C. Hoppe, T. Langlotz, G. Reitmayr, FlyAR: Augmented Reality Supported Micro Aerial Vehicle Navigation., IEEE Trans. Vis. Comput. Graph., (2014), 20(4), p560-568.

[https://doi.org/10.1109/tvcg.2014.24]

-

F.D. Crescenzio, G. Miranda, F. Persiani, T. Bombardi, A first implementation of an advanced 3d interface to control and supervise uav (uninhabited aerial vehicles) mission., Presence (Camb. Mass.), (2009), 18(3), p171-184.

[https://doi.org/10.1162/pres.18.3.171]

-

R.A. Ruddle, S.J. Payne, D.M. Jones, The effects of maps on navigation and search strategies in very-large-scale virtual environments., J. Exp. Psychol. Appl., (1999), 5(1).

[https://doi.org/10.1037/1076-898x.5.1.54]

-

Z. Luo, W. Luo, C.D. Wickens, I-M. Chen, Spatial learning in a virtual multilevel building: Evaluating three exocentric view aids., Int. J. Hum. Comput. Stud., (2010), 68(10), p746-759.

[https://doi.org/10.1016/j.ijhcs.2010.06.004]

- R.N. Sheperd, J. Metzler, Mental rotation of threedimensional objects., Sicence, (1971), 171(3972), p701-703.

-

A.J. Aretz, C.D. Wickens, The mental rotation of map display., Hum. Perform., (1992), 5(4), p303-328.

[https://doi.org/10.1207/s15327043hup0504_3]

-

S. Burigat, L. Chittaro, Passive and active navigation of virtual environments vs. traditional printed evacuation maps: a comparative evaluation in the aviation domain., Int. J. Hum. Comput. Stud., (2016), 87, p92-105.

[https://doi.org/10.1016/j.ijhcs.2015.11.004]

- M. Sjölinder, K. Höök, L-G. Nillson, G. Andersson, Age differences and the acquisition of spatial knowledge in a threedimensional environment: evaluating the use of an overview map as a navigation aid., Int. J. Hum. Comput. Stud., (2005), 63(6), p537-564.

-

L. Gugerty, J. Brooks, Reference-frame misalignment and cardinal direction judgments: group differences and strategies., J. Exp. Psychol. Appl., (2004), 10(2).

[https://doi.org/10.1037/1076-898x.10.2.75]

- M.T. Dennehy, D.W. Nesbitt, R.A. Sumey, Real-time three-dimensional graphics display for antiair warfare command and control., Johns Hopkins APL Tech. Dig., (1994), 15(2), p110-119.

-

I.D. Haskell, C.D. Wickens, Two-and three-dimensional displays for aviation: A theoretical and empirical comparison., Int. J. Aviat. Psychol., (1993), 3(2), p87-109.

[https://doi.org/10.1207/s15327108ijap0302_1]

-

B. Bauer, P. Jolicoeur, Stimulus dimensionality effects in mental rotation., J. Exp. Psychol. Hum. Percept. Perform., (1996), 22(1).

[https://doi.org/10.1037/0096-1523.22.1.82]

- M.J. Sholl, From visual information to cognitive maps., The construction of cognitive maps., J. Portugali, Dordrecht, Springer, (1996), p157-186.

-

M.C. Felix, J.D. Parker, C. Lee, K.I. Gabriel, Real three-dimensional objects: effects on mental rotation., Percept. Mot. Skills, (2011), 113(1), p38-50.

[https://doi.org/10.2466/03.22.pms.113.4.38-50]

-

O.S. Cheung, W.G. Hayward, I. Gauthier, Dissociating the effects of angular disparity and image similarity in mental rotation and object recognition., Cognition, (2009), 113(1), p128-133.

[https://doi.org/10.1016/j.cognition.2009.07.008]

-

C.D. Wickens, T.T. Prevett, Exploring the dimensions of egocentricity in aircraft navigation displays., J. Exp. Psychol. Appl., (1995), 1(2), p110-135.

[https://doi.org/10.1037/1076-898x.1.2.110]

-

N.B. Sarter, D.D. Woods, Situation awareness: A critical but ill-defined phenomenon., Int. J. Aviat. Psychol., (1991), 1(1), p45-57.

[https://doi.org/10.1207/s15327108ijap0101_4]