RGB-D 센서를 이용한 이동로봇의 안전한 엘리베이터 승하차

© Korea Robotics Society. All rights reserved.

Abstract

Getting on and off an elevator is one of the most important parts for multi-floor navigation of a mobile robot. In this study, we proposed the method for the pose recognition of elevator doors, safe path planning, and motion estimation of a robot using RGB-D sensors in order to safely get on and off the elevator. The accurate pose of the elevator doors is recognized using a particle filter algorithm. After the elevator door is open, the robot builds an occupancy grid map including the internal environments of the elevator to generate a safe path. The safe path prevents collision with obstacles in the elevator. While the robot gets on and off the elevator, the robot uses the optical flow algorithm of the floor image to detect the state that the robot cannot move due to an elevator door sill. The experimental results in various experiments show that the proposed method enables the robot to get on and off the elevator safely.

Keywords:

Mobil Robot , Multi-Floor Navigation, RGB-D Sensor, Particle Filter, Optical Flow1. 서 론

기존에는 실내환경에서 주행하는 로봇은 기술적인 어려움 으로 주로 한 층에서만 운영되어 작업 수행에 제약이 있었다. 그러나 최근에는 이동로봇의 층간 이동을 위한 엘리베이터 승 하차에 관한 다양한 연구가 진행되고 있다[1,2]. 층간 이동을 안 정적으로 수행하기 위해서는, 엘리베이터 인식, 안전한 승하 차 경로계획, 그리고 엘리베이터 내부에서 로봇의 위치인식 등이 필요하다. 이 중에서 스타게이저(startgazer) 또는 인공표 식을 이용한 엘리베이터 승하차 방법은 엘리베이터를 정확히 인식한다는 장점이 있지만[3], 승하차에 이용되는 모든 엘리베 이터에 인공표식을 설치하고 유지 및 보수를 해야 하는 불편 함이 있다. 인공표식의 불편함을 해소하기 위하여 레이저 스 캐너와 카메라를 이용한 엘리베이터 인식 방법이 제안되었다[4]. 그러나 이 방법은 단일 층을 관측하는 레이저 스캐너의 한계로 인해 반사율이 높은 금속 재질의 엘리베이터의 문을 정확히 인 식하지 못하였다. 또한, 엘리베이터 내부에서 레이저 스캐너를 이용한 로봇의 위치인식이 어려우므로 실제 다양한 환경에서 사용하기에는 부적합하였다. 따라서 대다수의 엘리베이터 내부 환경에 적용 가능한 로봇의 위치인식 방법으로 엔코더 기반의 추측항법(dead-reckoning)이 적합하다. 그러나 이러한 경우 복 도 바닥과 엘리베이터 바닥 사이의 틈이나 미끄러짐에 의하여 위치인식이 어려워서 정형화된 공간에서만 사용이 가능하다.

또한, 기존의 연구들은 승하차 시 발생하는 많은문제점을 고려하지 않았다. 따라서 대다수의 이동로봇은 엘리베이터 내 부의 사람이나 장애물에 대한 단순한 충돌 감지만을 수행하며 승하차한다[5]. 이 방법은 실제 화물들이 자주 적재되어 사용되 는 화물용 엘리베이터나 실제 환경에서 이용되는 엘리베이터 에는 적용하기 어렵다. 장애물에 대한 충돌 감지 방법으로 장 애물의 이동경로 예측을 적용한 지역경로 계획이 있지만[6], 이 러한 기술 또한 엘리베이터에는 적용하기 어렵다.

본 논문에서는 전방 및 바닥 지향의 RGB-D 센서를 사용한 이동로봇의 안전한 승하차 방법을 제안한다. 제안한 방법은 엘리베이터 문의 위치인식, 엘리베이터 내부 환경을 고려한 안전한 승차 경로계획, 승하차 시 로봇의 이동 불가 상태 감지 등으로 구성되어 있다. 엘리베이터 문의 위치인식 방법은 지 도작성 과정에서 미리 등록한 엘리베이터의 대략적인 POI (point of interest) 위치를 3차원 거리 정보와 파티클 필터[7]를 이용하여 보다 정확한 위치로 갱신한다. 이 방법은 관측 시 거 리 정보의 신뢰도가 낮은 금속 재질의 엘리베이터에도 강인한 성능을 보인다. 안전 승차 경로계획 방법은 엘리베이터의 내 부 환경을 모델링하여 안전한 승차 목적지를 설정하고, 경로 를 계획하여 효율적인 승차를 가능하게 한다. 또한 승하차 시 문턱으로 인한 이동 불가 상태 감지 방법은 바닥 영상의 옵티 컬 플로우(optical flow)를 계산하여[8] 로봇의 이동량을 감지함 으로써 로봇의 이동 불가 상태를 자동 인식한다. 이 방법은 이 동 불가 상태 시 추측항법의 잘못된 위치인식을 방지하여 승 하차 로봇의 안전성을 증가시켰다.

본 논문은 다음과 같이 구성된다. 2장에서는 엘리베이터 문 의 위치 인식에 대하여 설명하며, 3장에서는 안전한 승하차를 위한 승하차 경로 계획과 로봇의 이동 불가 상태 감지에 대하 여 설명한다. 4, 5장에서는 실험 결과 및 결론을 도출한다.

2. 엘리베이터 문의 위치 인식

제안한 엘리베이터 문의 위치 인식에서는 엘리베이터 문의 부정확한 초기 위치를 전방 지향 3차원 거리 센서와 파티클 필터 를 이용하여 보다 정확한 문의 위치로 갱신한다. [Fig. 1]은 엘리 베이터 문의 위치 인식 과정을 나타낸다. 먼저 본 연구에서는 엘 리베이터 문의 위치인식을 위하여 지도작성 시 사용자가 등록 한 엘리베이터의 POI 위치를 샘플들의 초기 위치로 설정한다. 분포된 샘플들은 확산, 가중치 모델링 단계를 거쳐 확률이 갱신 되며, 갱신된 확률을 기반으로 재배열된다. 위의 과정을 반복 수 행하여 수렴된 샘플의 위치는 엘리베이터 문의 위치가 된다.

2.1 엘리베이터 샘플 등록

본 논문에서 엘리베이터 샘플은 예측되는 엘리베이터 문의 위치로 정의하며, 4개의 변수(x, y, z, θ)로 표현한다. [Fig. 2(a)] 와 같이(x, y, z)는 엘리베이터 문의 기하학적 중심의 3차원 전 역위치를 나타내고, q는 엘리베이터 문 평면의 법선벡터의 방 위각을 나타낸다. 엘리베이터 문의 위치인식을 위해 가장 먼 저 수행되는 작업은 엘리베이터 문의 POI 위치 주변에 샘플들 을 등록하는 것이다. [Fig. 2(b)]와 같이 로봇은 엘리베이터 근 처에서 엘리베이터 문의 위치를 나타내는 POI를 바라보는 상 태로 엘리베이터 샘플을 등록한다. 샘플은 POI를 기준으로 반 경이 rs인 구의 내부 영역에서 임의의 위치에 임의의 방위각을 가지고 등록된다. 본 논문에서는 rs를 0.5 m로 설정하였다. 등 록되는 샘플의 개수가 많을수록 위치 인식 정확도는 높아지지 만, 계산 시간이 증가하게 된다. 제안한 방법은 실험을 통하여 최적의 샘플 개수를 500개로 설정하였다.

2.2 엘리베이터 샘플 확산

이 단계에서는 샘플의 위치와 방위에 오차를 적용하여 샘 플을 확산시키는데, 이는 다양한 샘플의 위치에서 가중치 계 산을 하도록 돕는다. 각 샘플은 현재 위치를 중심으로 반경이 rd인 구의 영역 내부의 임의의 위치로 확산된다. 본 논문에서 는 rd를 10 cm로 설정하였다. 이때 샘플에는 ±10° 범위에서 임 의의 방위각 오차가 적용된다. 샘플의 확률은 위치 및 방위각 의 변화량에 따라 정규분포 확률이 계산된다. 확산된 i번째 샘 플의 확률은 다음과 같다.

| (1) |

| (2) |

| (3) |

여기서 er, eθ는 각 샘플의 위치 및 방위에 적용된 오차를 나타 내고, σr, σθ는 er, eθ에 대한 표준편차를 나타낸다. 확산 후의 샘플의 확률 Pi는 샘플의 위치, 방위에 대한 정규분포 확률 Nr, Nθ의 평균으로 계산한다.

2.3 가중치 모델링

엘리베이터 샘플들의 확률은 3차원 거리 정보를 이용하여 계산된 가중치와 이전 샘플의 확률을 곱하여 계산된다. 샘플 의 가중치는 RGB-D 센서로 얻은 3차원 점군과 샘플로부터 예 측한 엘리베이터 문의 점군(point cloud) 사이의 유사도를 이 용하여 계산하며, 각 점군은 거리지도로 나타낼 수 있다. 거리 지도는 3차원 점의 거리 정보를 가진 격자로 구성된 지도로, 로봇 좌표계의 RYRZ 평면 위에 존재한다. 격자가 갖는 거리 정 보는 대응되는 3차원 점의 RX 성분을 의미한다. 제안한 방법은 3차원 거리센서의 분해능을 고려하여 거리지도의 격자 크기 를 1 cm × 1 cm로 설정하였다. 샘플의 가중치는 실제 거리지도 와 예측 거리지도를 비교하여 계산된다.

실제 거리지도는 [Fig. 3]과 같이 3차원 거리센서의 거리 정 보를 이용하여 작성한 지도이며, (i, j) 격자가 갖는 거리 정보 를 dr(i, j)로 나타낸다. 대응되는 3차원 점이 존재하지 않는 격 자는 0을 부여한다.

예측 거리지도는 [Fig. 4]와 같이 샘플로부터 예측한 엘리베 이터 문의 평면 정보를 이용하여 작성된다. (i, j) 격자가 갖는 거리 정보 dp(i, j)는 해당 격자와 대응하는 예측 평면 위의 예측 점까지의 거리를 나타낸다. 예측 평면과 대응하지 않는 격자 는 0을 부여한다. 엘리베이터 문의 예측 평면의 크기는 엘리베 이터 문의 높이와 너비 정보를 사용하여 결정한다.

센서를 이용하여 작성한 실제 거리지도와 샘플의 예측 격 자지도 사이의 유사도 비교는 동일한 좌표의 격자에 부여된 거리 정보의 차를 이용한다. 두 거리지도간의 차에 대한 평균 de와 표준편차 를 식 (4), (5)와 같이 표현하였을 때, 샘플의 가중치 w는 식 (6)과 같다.

| (4) |

| (5) |

| (6) |

여기서 M, N은 격자지도의 크기를 나타낸다. 샘플 가중치는 de와 가 작을수록 높은 가중치를 갖는다.

2.4 엘리베이터 샘플 재배열 및 수렴 판단

샘플들은 확산과 가중치 모델을 통해 갱신된 확률을 기반으 로 재배열된다. 샘플 재배열 과정은 이전 단계에서 낮은 확률을 갖는 샘플의 위치를 높은 확률을 갖는 샘플의 위치로 이동시키 는 과정이다. 샘플 확산, 가중치 모델링, 재배열 과정을 반복하면 서, 샘플들은 점차 실제 엘리베이터 문의 중심 위치에 수렴된다. 샘플들의 위치와 방위의 표준편차가 임계값 이하이면 수렴되었 다고 판단하고, 엘리베이터 문의 위치 인식 수행을 종료한다.

3. 안전한 승하차

본 장에서는 안전한 승하차를 위한 방법으로 엘리베이터 내부 환경을 고려한 승하차 경로계획 방법과 엘리베이터 승하 차 과정에서 발생하는 로봇의 이동 불가 상태를 감지하는 방 법을 제안한다. 제안한 안전 승하차 경로계획 방법은 로봇이 승하차 공간을 탐지하고, 안전한 승하차 목적지를 선정하여 경로를 계획함으로써 장애물과의 충돌 사고를 사전에 차단한 다. 또한 제안한 이동 불가 상태 감지 방법은 바닥 지향의 RGB-D 센서를 이용하여 로봇의 이동량을 예측함으로써 로봇 이 성공적으로 승하차 하도록 돕는다.

안전 승하차 과정은 엘리베이터 문의 위치인식, 안전승차, 안전하차 순으로 이루어진다. 로봇은 2장에서 언급한 방법으 로 엘리베이터 문의 위치를 인식하고, 문 앞으로 이동한다. 목 적지에 도착한 로봇은 문이 열리면 안전승차 경로를 계획하고 승차한다. 승차 목적지에 도착한 로봇은 제자리 회전 후 문이 열리면 안전 하차 경로를 계획하고 하차한다. 승하차 과정에서 의 로봇은 이동 불가 상태 감지를 수행하며 위치를 갱신한다. 본 논문에서는 승하차 과정에서 경로추종을 위한 모션제어 방 법으로 Kanayama의 이륜구동 모션제어 방법을 사용하였다[9].

3.1 안전 승하차 경로계획

엘리베이터 내부 환경을 고려한 안전 승하차 경로계획 방 법은 점유 격자지도를 기반으로 수행되며, 이 지도는 전방 지 향, 바닥 지향의 RGB-D 센서로 획득한 3차원 점군 중 바닥 점 군을 이용하여 작성한다. [Fig. 5]는 엘리베이터 문이 열린 뒤 안전한 승차 경로 계획 과정을 나타낸다.

로봇은 승차 경로계획을 위하여 엘리베이터 내부 환경을 격 자지도로 작성한 후[10] 안전한 승차 목적지를 설정한다. 승차 목적지는 승차 목적지 후보군 중 하나로 설정하며, [Fig. 6(a)] 와 같이 안전반경(rsafe)과 승차거리(dsafe)가 임계조건을 만족하 는 비점유 격자를 승차 목적지 후보군으로 선정한다. 안전반 경은 지정된 비점유 격자에서 가장 가까운 점유격자까지의 유클리디안 거리를 나타내며, 승차거리는 로봇의 위치로부 터 지정된 비점유 격자까지의 로봇의 정면 방향으로의 거리 를 의미한다.

![[Fig. 6] [Fig. 6]](/xml/26021/JKROS-15-1-55_F6.jpg)

(a) Conditions for determining goal pose, and (b) safe path planning for getting on an elevator in real environments

본 논문에서는 승차 후 로봇의 제자리 회전 움직임을 고려 하여 안전반경이 로봇 반지름의 1.5배보다 크고, 승차거리가 승차 후 문과의 충돌을 방지하기 위하여 엘리베이터 문과 로 봇 사이의 거리와 로봇 지름의 합보다 큰 비점유 격자를 후보 군으로 선정하였다. 승차 목적지는 경로 생성이 가능한 승차 목적지 후보군 중 로봇으로부터 가장 먼 후보로 설정한다. 로 봇과 승차 목적지 후보군 사이의 승차경로는 점유 격자지도 기반의 구배법(gradient method)을 사용하여 생성한다[11]. [Fig. 6(b)]는 실제 환경에서 생성한 승차 경로를 나타낸다.

안전하차 경로계획은 안전승차 경로계획 방법과 마찬가지 로, 로봇이 엘리베이터 내부에서 외부를 바라볼 때 하차 목적 지를 설정하고 경로를 생성한다. 하차 목적지는 최소 안전반 경과 최소 하차거리 조건을 만족하는 하차 목적지 후보군에서 로봇으로부터 가장 가까운 후보로 결정한다.

3.2 로봇의 이동 불가 상태 감지

엔코더 정보를 이용하여 로봇의 위치를 갱신하는 추측항법 은 이동거리가 짧은 엘리베이터 승하차 특성상 모든 환경의 엘리베이터 승하차 과정에 사용할 수 있다. 그러나 이 방법은 [Fig. 7(a)]와 같이 엘리베이터의 문턱으로 인하여 바퀴가 헛돌 아 로봇의 위치를 잘못된 위치로 인식할 수 있으며, 이는 엘리 베이터의 문과 충돌을 유발한다. 본 연구에서는 이러한 문제 를 해결하기 위하여 바닥 지향 RGB-D 센서의 영상으로부터 옵티컬 플로우를 계산하고, 3차원 거리 정보를 이용하여 로봇 의 위치 변화량을 계산한다. 계산된 위치 변화량과 엔코더 정 보를 비교하여 로봇의 이동 불가 상태를 감지한다. 제안한 방 법은 옵티컬 플로우 알고리즘 중 비교적 정확성이 뛰어난 Gunna-Farnback 알고리즘을 사용하였다[12]. [Fig. 7(b)]는 바닥 영상의 ROI (region of interest) 영역의 각 픽셀의 속도벡터를 나타낸다. 오정합된 특징들은 RANSAC 알고리즘을 이용하여 제거하였다[13].

[Fig. 8]은 옵티컬 플로우를 이용하여 계산한 속도벡터와 RGB-D 센서의 3차원 거리 정보를 이용하여 연속한 두 프레임 에서 매칭된 특징점과 로봇 사이의 위치 관계를 나타낸다. 이 전 프레임과 현재 프레임에서 관측한 i번째 특징점의 x, y 좌표 를 각각 AFi (Axi, Ayi) 및 BFi (Bxi, Byi)라고 할 때, 두 좌표 사이의 관계는 로봇의 위치 변화량(Δxr, Δyr, Δθr)으로 표현 가능하다.

| (7) |

식 (7)을 전개하여 로봇의 위치 변화량 관련 항을 변수로 갖 는 방정식으로 표현하면 다음과 같다.

| (8) |

정합된 모든 특징들은 식 (8)을 만족해야 하므로 로봇의 위 치 변화 관련 벡터 Xr은 다음 식을 만족한다.

| (9) |

| (10) |

| (11) |

| (12) |

여기서 Nv는 전체 속도벡터의 개수를 나타낸다. 식 (9)의 해인 Xr의 근사값으로 로봇의 위치 변화량을 추정한다. 엔코더로부 터 획득한 위치 변화량이 다음 식을 만족하면 로봇이 이동 불 가 상태에 놓였다고 판단한다.

| (13) |

여기서 (Δxodom, Δyodom)은 엔코더 정보를 나타내고, ecr는 두 위 치 변화량의 오차율에 대한 임계값을 나타낸다. 이동 불가 상 태를 감지한 로봇은 위치 갱신을 수행하지 않는다.

4. 실험 결과

본 연구에서 제안한 RGB-D 센서를 이용한 엘리베이터 문 의 위치인식과 엘리베이터 승하차 시 발생하는 이동 불가 상 태 감지를 실제 승하차 실험을 통해 검증하였다. 실험에 사용 된 로봇에는 [Fig. 9]와 같이 전방, 바닥 지향의 Xtion 센서(Asus Xtion PRO LIVE)를 장착하였다.

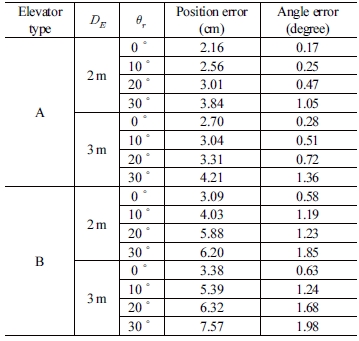

4.1 엘리베이터 문의 위치인식 실험

본 논문에서는 제안한 엘리베이터 문의 위치인식 방법을 검증하기 위하여 로봇이 엘리베이터를 향했을 때 엘리베이터 문의 위치와 방위를 측정하였다. 실험은 [Fig. 10(a)]와 같이 문 표면의 반사율이 낮은 엘리베이터 A와 반사율이 높은 엘리베 이터 B를 대상으로 문과 로봇 사이의 위치 관계를 변화시키며 수행하였다. 로봇의 위치는 [Fig. 10(b)]같이 엘리베이터로부 터의 로봇까지의 수직거리 DE와 로봇이 엘리베이터를 바라보 는 방위각 θr를 변경하였다. 실험에 사용한 Xtion 센서의 감지 거리와 시야각을 고려하여 DE는 2 m, 3 m로 설정하였고, 각 위 치에서 θr을 0°, 10°, 20°, 30°로 변경하며 문의 위치와 방위를 측정하였고, 각 조건에서 50회 반복 실험하였다.

[Table 1]은 각 조건에서 수렴된 엘리베이터 샘플의 평균 위 치, 방위각과 실제 엘리베이터 문의 중심위치, 방위각 사이의 오차를 나타낸다. 엘리베이터 평균 위치오차와 평균 각도오차는 각각 8 cm 및 2° 이내의 값으로 나타났다. 위치 및 방위 오차는 엘리베이터로부터 멀리 떨어질수록, 로봇이 바라보는 방위각 이 클수록 더 큰 값을 갖는다. 이는 RGB-D 센서의 거리 정보가 거리에 비례하여 오차가 커지기 때문이다. 반사율이 상대적으 로 큰 엘리베이터 B의 경우는 거리 정보의 신뢰도가 떨어지므 로 엘리베이터 A의 경우보다 더 큰 위치 및 방위 오차를 갖는다.

4.2 안전 승하차 실험

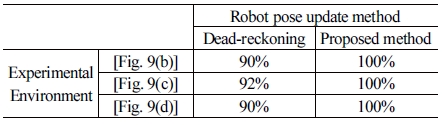

제안한 안전승차 경로계획 방법과 이동 불가 상태감지 방 법을 검증하기 위하여 [Fig. 11]과 같이 2 m × 2 m 크기의 동일 한 엘리베이터 내부에 서로 다른 장애물 환경을 구성하고 승 하차 실험하였다. 로봇은 [Fig. 11(a)]와 같이 문 근처에 장애물 이 존재하는 경우 충분한 공간을 갖는 승차 목적지를 설정할 수 없으므로, 승차경로 생성 및 승차 작업을 수행하지 않는다.

따라서 본 실험은 승차 경로가 생성되는 [Fig. 11(b)], [Fig. 11(c)], [Fig. 11(d)]와 같은 환경에서 진행하였으며, 추측항법만을 사용한 경우와 제안한 이동 불가 상태 감지 방법을 함께 사용한 경우의 승차 성공률을 비교하여 안전 승하차 성능을 평가하였다.

본 실험에서는 로봇이 승차 완료 판단을 하였을 때, 로봇과 엘리베이터 문 사이의 충돌이 없는 경우를 승차 성공이라 정 의하였다. [Table 2]는 각 실험을 50회 반복 수행하여 측정한 승차 성공률을 나타낸다. 추측항법을 사용하여 위치를 갱신한 경우 문턱 걸림 현상이 발생하였을 때 모두 승차 실패하였지 만, 제안한 방법의 경우 로봇이 문턱에 걸렸을 때 위치를 갱신 하지 않으므로 목적지 근처에서 승차 완료를 판단하였다.

정확한 이동 불가 상태감지 성능을 평가하기 위하여 [Fig. 11(b)]와 같은 환경에서 고정된 승차 목적지를 설정하고 반복 승차하였을 때, 도착 위치와 승차 목적지 사이의 평균 위치오 차를 측정하였다. 로봇의 정면 방향으로 1.5 m 떨어져 있는 위 치에 고정 승차 목적지를 설정하였을 때 위치 오차는 문턱 걸 림 현상과 무관하게 5 cm 이내로 수렴하였다.

5. 결 론

본 논문에서는 RGB-D 센서를 이용하여 엘리베이터 문의 위치를 인식하고, 승하차 시 내부 환경을 고려한 승차 경로계 획과 로봇의 이동 불가 상태를 감지하는 방법을 제안하였다. 안전한 엘리베이터 승하차를 위하여 제안된 방법은 실험을 통 하여 입증하였으며, 다음과 같은 결론을 도출한다.

- RGB-D 센서로 문의 위치를 인식할 수 있으며, 실제 문의 위치와 인식한 위치 간의 평균 위치오차와 각도오차는 각 각 8 cm 및 2° 이하이다.

- 제안한 방법은 엘리베이터 내부에 장애물이 존재하는 환 경에서도 안전하게 승하차할 수 있으며, 반사체로 둘러싸 인 엘리베이터에서도 승하차 과정에서 생기는 이동 불가 상태를 감지하여 승하차의 안전성을 높였다.

추후에는 3차원 거리 정보와 영상 정보를 융합하여 더 정밀한 엘리베이터 문의 위치식 방법과 영상 정보만을 이용한 엘리베 이터 내부의 정확한 로봇의 위치 인식 방법을 제안하고자 한다.

Acknowledgments

This research was supported by the IITP grant funded by the Korea Government MSIT (No. 2018-0-00622).

References

-

J.-G. Juang, C.L. Yu, C.-M. Lin, R.-G. Yeh, and I. J. Rudas, “Real-time image recognition and path tracking of a wheeled mobile robot for tracking an elevator,” Acta Polytechnica Hungarica, vol. 10, no. 6, pp. 5-23, 2013.

[https://doi.org/10.12700/APH.10.06.2013.6.1]

- J.- G. Kang, S.-Y. An, and S.-Y. Oh, “Navigation strategy for the service robot in the elevator environment,” 2007 International Conference on Control, Automation and Systems, Seoul, Korea, pp. 1092-1097, 2007.

-

A. A. Abdulla, H. Liu, N. Stoll, and K. Thurow, “Multi-floor navigation method for mobile robot transportation based on StarGazer sensors in life automation,” IEEE International Instrumentation and Measurement Technology Conference, Pisa, Italy, pp. 428-433, 2015.

[https://doi.org/10.1109/I2MTC.2015.7151306]

-

S.- W. Ma, X. Cui, H.-H. Lee, H.-R. Kim, J.-H. Lee, and H. Kim, “Robust elevator door recognition using LRF and camera,” Journal of Institute of Control, Robotics and Systems, vo. 18, no. 6, pp. 601-607, Jun., 2012.

[https://doi.org/10.5302/J.ICROS.2012.18.6.601]

-

R. Amano, K. Takahashi, T. Cho, K. Kobayashi, K. Watanabe, and Y. Kurihara, “Development of automatic elevator navigation algorithm for JAUS compliant mobile robot,” 6th International Conference on Soft Computing and Intelligent Systems, Kobe, Japan, pp. 1633-1638, 2012.

[https://doi.org/10.1109/SCIS-ISIS.2012.6505165]

-

J.-Y. Moon, H.-W. Chae, and J.-B. Song, “Planning of Safe and Efficient Local Path based on Path Prediction Using a RGB-D Sensor,” Journal of Korea Robotics Society, vol. 13, no. 2, pp. 121-128, Jun., 2018.

[https://doi.org/10.7746/jkros.2018.13.2.121]

-

J. Carpenter, P. Clifford, and P. Fearnhead, “Improved particle filter for nonlinear problems,” Radar, Sonar and Navigation, vol. 146, no. 1, pp. 2-7, Feb., 1999.

[https://doi.org/10.1049/ip-rsn:19990255]

-

S. S. Beauchemin and J. L. Barron, “The Computation of optical flow,” ACM Computing Surveys, vol. 27, no. 3, pp. 433-466, Sept., 1995.

[https://doi.org/10.1145/212094.212141]

- Y. Kanayama, Y. Kimura, F. Miyazaki, and T. Noguchi, “A stable tracking control method for an autonomous mobile robot,” IEEE International Conference on Robotics and Automation, Cincinnati, USA, pp. 382-389, 1990.

-

G. Grisetti, C. Stachniss, and W. Burgard, “Improved techniques for grid mapping with rao-blackwellized particle filters,” IEEE Transactions on Robotics, vol. 23, no. 1, pp. 34-46, Feb., 2007.

[https://doi.org/10.1109/TRO.2006.889486]

- K. Konolige, “A Gradient Method for Realtime Robot Control,” IEEE/RSJ International Conference on Intelligent Robots and Systems, Takamatsu, Japan, pp. 639-646, 2000.

-

G. Farnebäck, “Two-frame motion estimation based on polynomial expansion,” Scandinavian Conference on Image Analysis, Halmstad, Sweden, pp. 363-370, 2003.

[https://doi.org/10.1007/3-540-45103-X_50]

-

O. Chum, J. Matas, and J. Kittler, “Locally optimized RANSAC,” Joint Pattern Recognition Symposium, Magdeburg, Germany, pp. 236-243, 2003.

[https://doi.org/10.1007/978-3-540-45243-0_31]

![[Fig. 1] [Fig. 1]](/xml/26021/JKROS-15-1-55_F1.jpg)

![[Fig. 2] [Fig. 2]](/xml/26021/JKROS-15-1-55_F2.jpg)

![[Fig. 3] [Fig. 3]](/xml/26021/JKROS-15-1-55_F3.jpg)

![[Fig. 4] [Fig. 4]](/xml/26021/JKROS-15-1-55_F4.jpg)

![[Fig. 5] [Fig. 5]](/xml/26021/JKROS-15-1-55_F5.jpg)

![[Fig. 7] [Fig. 7]](/xml/26021/JKROS-15-1-55_F7.jpg)

![[Fig. 8] [Fig. 8]](/xml/26021/JKROS-15-1-55_F8.jpg)

![[Fig. 9] [Fig. 9]](/xml/26021/JKROS-15-1-55_F9.jpg)

![[Fig. 10] [Fig. 10]](/xml/26021/JKROS-15-1-55_F10.jpg)

![[Table 1]](../img/npr_tablethum.jpg)

![[Fig. 11] [Fig. 11]](/xml/26021/JKROS-15-1-55_F11.jpg)