이동로봇의 안전한 엘리베이터 탑승을 위한 RGB-D 센서 기반의 엘리베이터 인식 및 위치추정

2Ph.D. Student, Mechanical Engineering, Korea University, Seoul, Korea jhj0630@korea.ac.kr

© Korea Robotics Society. All rights reserved.

Abstract

Multi-floor navigation of a mobile robot requires a technology that allows the robot to safely get on and off the elevator. Therefore, in this study, we propose a method of recognizing the elevator from the current position of the robot and estimating the location of the elevator locally so that the robot can safely get on the elevator regardless of the accumulated position error during autonomous navigation. The proposed method uses a deep learning-based image classifier to identify the elevator from the image information obtained from the RGB-D sensor and extract the boundary points between the elevator and the surrounding wall from the point cloud. This enables the robot to estimate the reliable position in real time and boarding direction for general elevators. Various experiments exhibit the effectiveness and accuracy of the proposed method.

Keywords:

Elevator Recognition, Elevator Position Estimation, Multi-Floor Navigation, RGB-D Sensor1. 서 론

자율주행 로봇의 기술이 발전함에 따라 이동로봇은 병원, 공항, 공장 등의 다양한 실내 공간에서 물건을 전달하거나 방 문객에게 길을 안내하는 다양한 용도로 활용되고 있다. 그러 나 대부분의 실내 공간은 다층임에도 불구하고 대부분의 이동 로봇은 엘리베이터를 이용하지 못하여 여러 층을 왕래하지 못 한다. 로봇이 엘리베이터를 통한 층간 이동이 가능하다면, 더 넓은 공간에서 다양한 작업을 수행할 수 있다.

로봇이 엘리베이터에 탑승하려면 로봇은 자율적으로 주행 하여 엘리베이터에 진입할 수 있는 대기 장소에 도착해야 한 다. 그러나 주행 중 누적된 오차로 인해 로봇의 도착 위치에 오 차가 존재하므로, 로봇이 엘리베이터에 탑승 시 장애물과 충 돌하거나 진입 경로가 생성되지 못하는 문제를 초래하게 된 다. 따라서 로봇이 안전하게 엘리베이터를 탑승하기 위해서는 엘리베이터와 로봇의 위치 관계를 정확히 추정하여야 한다.

카메라를 탑재한 이동로봇은 인공표식을 사용해 누적된 위 치오차에 대한 보정[1,2]이 가능하지만, 인공표식은 설치 후 지 속적인 유지 및 보수가 필요하다는 문제점이 있다. 따라서 인 공표식을 사용하지 않고 레이저 센서[3] 또는 스테레오 카메라 [4]의 정보만을 통해 엘리베이터를 인식하고 위치를 추정하는 방법들이 제안되었다. 일반적으로 레이저 센서는 높은 정확도 로 주변 환경에 대한 깊이 정보를 얻을 수 있다. 그러나 엘리베 이터 문과 같은 금속 표면에 대해서는 정확한 거리 정보를 얻 기 어려우므로[5] 엘리베이터 환경에 적합하지 않다. 오히려 스 테레오 카메라를 사용하는 것이 영상정보 및 3차원 거리 정보 를 활용할 수 있으므로 물체를 인식하고 위치를 추정하는 데 적합하다. 그러나 스테레오 카메라의 좌우 영상 간의 변위지 도(disparity map)를 통해 엘리베이터를 인식하는 방법은 엘리 베이터 문과 같은 반사되는 표면에서 깊이 정보가 불완전하 며, 조명에 따라 성능에 차이가 발생한다는 단점이 있다.

본 연구에서는 로봇이 엘리베이터를 바라보도록 도착한 대 기 장소에서, 인공표식을 사용하지 않고 저가의 RGB-D 센서 만으로 엘리베이터의 위치를 추정하는 방법을 제안한다. 이전 에도 RGB-D 센서를 이용하여 엘리베이터 문의 중심을 추정 하는 방법[6]이 제안되었으나, 이는 엘리베이터 좌우 벽면의 위 치를 찾고 이에 대한 가중치로 엘리베이터의 중심 위치를 추 정하였기 때문에 대략적인 엘리베이터의 위치 만을 추정할 수 있었다. 본 논문에서는 RGB-D 센서의 3차원 점군(point cloud) 을 이용하여 엘리베이터와 벽면 사이의 단차를 기준으로 엘리 베이터 문의 경계에 해당하는 점을 추출하여 정확한 엘리베이 터의 위치를 추정한다. 그러나 유사한 구조를 가진 물체를 엘 리베이터로 오인할 수 있으므로, 심층학습(deep learning)을 통 한 영상인식 기술을 이용하여 엘리베이터의 존재를 확인하는 기술이 수반된다. 이때 로봇의 위치추정 오차가 크면 영상에 서 엘리베이터가 중앙이 아닌 가장자리에 편향되거나 일부만 보여 정확히 엘리베이터로 인식하기 힘들다. 따라서 이러한 경우에는 [Fig. 1]과 같이 점군을 통해 엘리베이터의 중심으로 예상되는 위치를 찾고, 센서가 엘리베이터를 향하도록 로봇을 회전시킨 후에 다시 엘리베이터 인식과 위치추정을 시작한다.

본 연구의 기여는 다음과 같다. 1) 로봇으로부터 엘리베이 터까지의 위치를 추정하는 과정에서 인공표식과 같은 인위적 인 설치물이 불필요하다. 2) 저가의 RGB-D 센서 만으로 빠르 고 정확한 엘리베이터 인식과 위치추정을 수행할 수 있다. 3) 반사되는 재질을 포함하는 다양한 임의의 엘리베이터에도 적 용이 가능하다.

본 논문은 다음과 같이 구성된다. 2장에서는 영상 분류기를 통해 엘리베이터의 존재를 확인하는 방법을 설명한다. 3장에 서는 3차원 점군 정보를 활용하여 엘리베이터의 위치를 추정 하는 방법에 대해 설명한다. 4장에서는 엘리베이터 전방의 다 양한 센서의 위치와 방향에서 제안한 방법을 실험하고 검증한 결과를 서술한다. 5장에서는 결론을 도출한다.

2. 엘리베이터 존재 여부 판단

센서의 깊이 정보만으로는 엘리베이터가 아닌 유사한 구조 를 엘리베이터로 잘못 인식할 수 있다. 카메라와 레이저 센서 를 함께 사용하여 엘리베이터를 인식한 방법[7]에서는 레이저 의 2차원 거리 정보를 통해 엘리베이터의 위치를 찾고 이를 카 메라 영상에서 추출한 엘리베이터 경계에 대한 직선과 위치를 비교하여 확인하였다. 그러나 영상에서의 직선 추출은 여전히 문과 같이 비슷한 구조를 엘리베이터로 혼동할 수 있다. 따라 서 본 논문에서는 인공신경망을 통해 카메라 영상 속 엘리베 이터의 존재를 확인한다. 이동로봇의 제한된 자원에서는 CPU 만으로도 연산시간이 짧은 알고리즘이 필요하므로, YOLO와 같은 물체 인식(object detection)이 아니라 Inception v3[8]과 같 은 이미지 분류(image classification)를 사용한다.

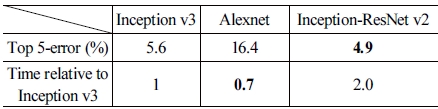

2.1 Inception v3의 학습

본 연구에서는 앞서 언급하였듯이, [Table 1]과 같은 영상 분류기를 이용하여 엘리베이터의 존재를 확인하였다. Inception- ResNet v2[9]가 Inception v3보다 정확도 측면에선 조금 더 좋지만, 연산시간은 2배가 필요하다. 반면에, AlexNet[10]은 Inception v3 보다 인식속도는 조금 더 빠르지만 정확도는 약 3배 정도 저하 된다. 따라서 연산시간 대비 우수한 성능을 지닌 Inception v3 를 채택하였다. 또한, Inception v3의 마지막 층을 노드가 2개 인 전연결층(fully-connected layer)으로 수정하여 엘리베이터 와 그 외 물체에 대한 합이 1인 신뢰도 점수(score)를 도출하도 록 학습하였다. 학습에는 [Fig. 2]와 같이 하나의 엘리베이터만 존재하는 총 3,100장의 이미지를 수집하여 사용하였다.

2.2 RGB 이미지의 전처리

영상 분류기에 RGB 영상 전체를 입력하면, 엘리베이터가 아닌 영상에 포함된 다른 물체에 집중할 수 있으므로 엘리베 이터 인식 성능이 저하된다. 따라서 영상 분류기의 엘리베이 터 인식 성능을 높이기 위해서는 [Fig. 3]과 같이 엘리베이터의 비중이 높은 일부 영역만을 잘라내어 영상 분류기에 입력할 필요가 있다. 영상분류기에 입력되는 RGB 영상의 일부 영역 은 가로는 엘리베이터의 폭(we)에 비례하여 결정되며, 세로는 센서의 기울기 정보(θ)에 따라 결정된다. [Fig. 3]의 회색 영역 은 원본 이미지이고, 녹색 영역은 영상의 최소 범위이며, 그리 고 붉은 영역은 사용 영역의 예시이다. 사용 영역을 정하는 3 가지 파라미터 ƒl, ƒr, ht은 아래의 식과 같다.

| (1) |

| (2) |

| (3) |

여기서 wmin과 wmax는 각각 대상 엘리베이터의 최소폭과 최 대폭이며, 여기서는 각각 1.0 m, 3.0 m이다. 또한, w와 h는 각 각 원본 이미지의 가로와 세로 해상도이다. [Fig. 3]과 같이 x 방향으로는 ƒl부터 ƒr까지, y 방향으로는 0부터 ht까지 해당 하는 영역을 잘라내어 사용한다.

3. 엘리베이터 위치추정

주행 시 누적된 로봇의 위치 오차를 고려하여 안전하게 엘리 베이터에 탑승하기 위해서는 현재 로봇 위치 기준의 지역적인 엘리베이터 위치를 재 추정해야 한다. 따라서 본 절에서는 RGB-D 센서의 깊이 정보인 3차원 점군 정보를 사용하여 엘리베 이터와 주변의 벽면 간에 단차를 특징으로 엘리베이터 문의 양 끝 점을 찾아 엘리베이터의 위치를 추정하는 알고리즘을 제안한다.

3.1 점군 정보 전처리

RGB-D 센서의 3차원 점군은 [Fig. 4]의 (a)와 같이 영상의 각 픽셀에 해당되는 센서좌표계 기준의 3차원 위치 정보를 나 타낸다. 예를 들어, QVGA 해상도의 카메라는 76,800개의 3차 원 점군 정보를 얻을 수 있다. 그러나 모든 점군 정보를 사용하 는 것은 과도한 연산량으로 인해 실시간 엘리베이터 위치추정 을 어렵게 하므로, 본 논문에서는 전체 점군에서 필요한 정보 만을 추출하여 실시간으로 사용 가능한 형태로 변환한다.

3차원 점군에서 사용하고자 하는 엘리베이터와 벽면 사이 의 단차 구조는 점들의 높이 정보와는 연관이 없다. 따라서 3 차원 점군 정보는 바닥 평면에 투영하여 2차원으로 사용할 수 있다. 또한, 영상의 같은 열에 해당하는 점들은 유사한 2차원 점으로 투영되므로 [Fig. 4]의 (b)와 같이 하나의 2차원 점으로 대체할 수 있다. 결과적으로 전체 3차원 점군은 영상의 열 크 기만큼의 2차원 점들로 축소할 수 있으며, 여전히 엘리베이터 와 벽면 사이의 단차 구조는 유지됨으로 실시간으로 엘리베이 터의 위치를 추정하기에 적합하다.

3.2 엘리베이터 문과 주변 벽면 경계점 추출

대부분의 엘리베이터 문은 약 30 cm 이상 주변 벽면의 안쪽 에 위치한다. 따라서 엘리베이터 문과 양 벽면에 해당하는 평면 을 바닥면에 투영시키면 [Fig. 5]와 같이 단차만큼 떨어진 평행한 두 직선을 얻을 수 있다. 본 연구에서는 앞서 전처리한 2차원 점군 정보에 허프변환(Hough transform)[11]을 적용하여 엘리베이터 문 과 벽면에 해당하는 평행한 두 직선(Lelevator, Lwall)을 추출한다. 이후에는 식 (4)를 통해 추출한 두 직선과 2차원 점들 간의 거리 를 기준으로 엘리베이터 문과 벽면에 해당하는 점군을 구분한다.

| (4) |

여기서 xi, yi는 i번째 열의 2차원 점(Pi)의 위치 정보이고, θj, ρj 는 앞서 추출한 엘리베이터 또는 벽에 해당하는 직선(Lj)의 허프 변환 변수이다([Fig. 5] 참조). dth는 점 Pi가 해당 직선에 포함되 는지 판단할 수 있는 점과 직선 사이의 거리에 대한 임계치이다.

엘리베이터 점군의 양 끝점을 기준으로 대략적인 엘리베이터 와 벽면의 경계점을 찾을 수 있다. 그러나 금속 재질의 엘리베이 터에 해당하는 점은 벽면에 해당하는 점에 비해 신뢰도가 낮고, 센서의 방향에 따라 엘리베이터 문의 일부가 가려질 수 있다. 따 라서 본 연구에서는 [Fig. 6]의 방법 1과 같이 엘리베이터 점군의 양 끝점과 가장 근접한 좌우측 벽면 점을 경계점으로 추출한다. 그러나 한쪽 벽의 점군만이 추출 가능한 경우에는 방법 2, 3와 같 이 벽면 위의 경계점과 엘리베이터의 끝점을 조합하여 사용한다.

3.3 엘리베이터 문의 위치와 진입 방향 선정

본 연구에서는 앞서 추정한 엘리베이터와 벽면의 경계점을 바탕으로 [Fig. 7]과 같이 엘리베이터의 위치(xe, ye)와 진입하 는 방향(θe)에 대한 최종 결과를 도출한다. 엘리베이터의 위치 는 좌우 경계점의 중심점으로 추정하였으며, 엘리베이터 탑승 시의 진입은 엘리베이터 또는 벽면에 해당하는 직선에 수직한 방향 θelevator와 같다.

추정한 엘리베이터 문의 중심 위치와 방향은 정확도를 높 이기 위해서 일정 횟수 이상 반복 추정하고, 추정 결과를 종합 하여 최다 선출된 중심점과 방향을 최종 결과로 선정한다. 이 를 통해 로봇은 엘리베이터 탑승 시 최대한 좌우로 균일한 여 유공간을 확보할 수 있고, 엘리베이터 문에 수직하게 진입할 수 있다. 그러나 [Fig. 1]의 순서도와 같이 영상을 통한 엘리베 이터의 인식이 실패한 경우에는 식 (5)와 같이 센서가 엘리베 이터 중심을 바라보기 위한 회전각도(θr)을 계산하여 로봇을 회전시킨 후 위치를 재 추정한다.

| (5) |

4. 실 험

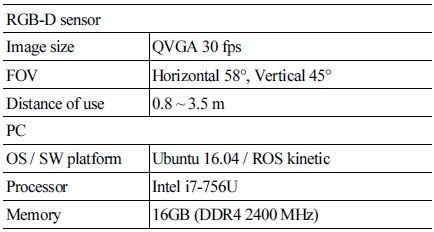

본 절에서는 제안한 RGB-D 센서를 이용한 엘리베이터 인 식 및 위치추정 성능을 [Fig. 8]과 같이 엘리베이터 전방의 다 양한 위치와 방위에서 실험하여 검증하였다. 각 위치는 엘리 베이터 전방에서 센서의 감지거리와 시야각을 고려하였을 때 엘리베이터에 대한 충분한 센서 정보를 얻을 수 있는 범위 내의 지점들로 설정하였다. 실험 환경과 실험에 사용한 로봇의 구 성은 [Fig. 9]와 같으며, 구체적인 사양은 [Table 2]와 같다.

4.1 엘리베이터 인식이 가능한 센서 방향 실험

영상 분류기를 통한 엘리베이터 인식은 다른 물체와의 혼 동으로 인한 엘리베이터 인식 성능의 저하를 막기 위해 RGB 영상 중앙의 일부만을 인식에 사용한다. 따라서 실질적으로 엘리베이터 인식에 사용되는 센서의 시야는 센서의 사양보다 좁으므로 엘리베이터 인식이 가능한 센서의 방향은 위치추정 이 가능한 범위보다 제한적이다.

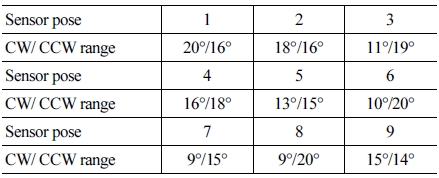

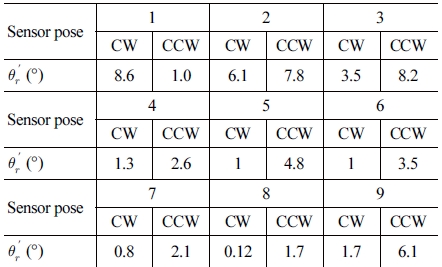

본 실험에서는 [Fig. 8]의 각 센서 위치(1~9)에서 엘리베이터 인식이 가능한 센서 방향의 범위를 확인하였다. 엘리베이터 인 식의 성공은 영상 분류 결과 엘리베이터로 판단된 점수가 0.6 이상인 경우가 5회 이상 연속적으로 반복될 때를 기준으로 하 였다. 실험 결과 각 위치에서 엘리베이터 인식이 가능한 센서 방향의 범위는 [Table 3]과 같다. 엘리베이터 인식 범위는 각 위 치에서 센서가 엘리베이터 중심을 바라보는 방향을 기준으로 시계 또는 반시계 방향으로 회전 시에 엘리베이터 인식이 가능 한 최대 회전각을 나타낸다. [Fig. 10]은 센서 2의 위치에서 엘 리베이터 인식이 가능한 범위와 인식 결과를 예시로 보여준다.

엘리베이터 인식이 가능한 방향의 범위는 학습 데이터에 따라 달라지므로 센서 위치에 따른 뚜렷한 경향성은 찾기 어 렵다. 다만, 센서가 엘리베이터를 바라보는 방위에서 약 20° 이상의 방위 오차가 있을 때에는 대부분의 엘리베이터 인식이 어렵고, 9° 이하에서는 항상 인식이 가능한 것을 확인하였다.

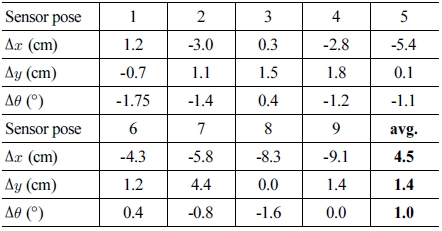

4.2 엘리베이터 위치추정 성능

본 논문에서 제안한 엘리베이터의 위치와 방위를 추정하는 알고리즘의 정확도를 검증하기 위해, 엘리베이터 전방의 다양 한 센서의 위치에서 엘리베이터의 위치 및 방위를 추정하고 오 차를 확인하였다. 각 위치에서 센서의 방향은 엘리베이터의 중 심을 향하여 엘리베이터 인식이 가능한 조건에서 실험하였다.

[Fig. 8]의 각 센서 위치에서 10회씩 반복하여 평균한 엘리 베이터 위치추정의 오차는 [Table 4]와 같다. 추정 결과, 센서 가 엘리베이터로부터 멀어질수록 실제 위치보다 가까운 곳에 추정되는(∆x < 0) 경향을 볼 수 있었다. 그러나 엘리베이터 탑 승 시 충돌에 결정적인 영향을 미치는 추정 오차는 ∆y와 ∆θ 이며, 이에 따라 로봇이 얼마나 엘리베이터 중앙으로 수직하 게 진입할 수 있는지 결정된다. 따라서 ∆x는 평균 오차 4.5 cm 로 최대 9 cm까지 오차가 있지만, ∆x와 ∆θ는 각각 평균 오차 1.4 cm와 1.0°로 로봇이 안전하게 엘리베이터에 탑승하기 충 분한 정확도의 추정이 가능함을 검증하였다.

엘리베이터 인식 및 위치추정 방법의 실시간성은 엘리베이 터 인식과 위치추정 알고리즘 각각의 1회 수행시간을 측정하 여 실험하였다. [Table 2]와 같은 사양에서 엘리베이터 인식 알 고리즘과 위치추정 알고리즘 각각 1회당 평균 210 ms 및 35 ms 이었다. 본 실험에서는 정확도를 위해 엘리베이터 인식은 5회, 위치추정은 20회 반복한 결과를 바탕으로 하였으므로 전체 알 고리즘 시작에서 종료까지 약 1초의 시간이 소요되었다.

4.3 엘리베이터 인식을 위한 센서 방향 보정 실험

로봇의 방위오차로 인해 엘리베이터 인식이 어려운 경우 점군을 기반으로 엘리베이터로 예상되는 위치를 추정하고, 이 를 기반으로 센서가 엘리베이터를 향하도록 회전시키는 방법 을 실험하였다. 앞선 엘리베이터 인식 실험 결과와 대기장소 에 도착한 로봇의 방위오차가 20° 내외라는 가정을 바탕으로, [Fig. 8]의 각 위치에서 시계 또는 반시계 방향으로 약 20°의 방 위오차로 실험을 수행하였다.

[Fig. 11]은 4번 위치에서 실험한 예이며, 각 위치별로 시계 및 반시계 방향으로 5회씩 실험하였을 때 보정 후 방위오차 ()는 [Table 5]와 같다. 결과적으로, 모든 위치 에서 엘리베이터 인식이 가능한 9° 이내의 방위오차를 가지는 센서 방향으로 보정이 가능하였다. 또한, [Fig. 11]과 같이 보정 후에는 전과 비교하여 엘리베이터 좌우의 전반적인 점군 정보 를 얻을 수 있으므로, 위치추정 또한 더 정확한 결과를 얻을 수 있음을 예상할 수 있다.

5. 결 론

본 논문에서는 로봇이 엘리베이터 앞에 도착한 이후, RGB-D 센서를 이용하여 엘리베이터를 인식하고 센서 좌표계 기준의 엘리베이터의 위치와 진입 방향을 추정하는 방법을 제 안하였다. 엘리베이터 전방에서 센서를 다양한 위치와 방위에 서 실험하여 제안한 방법에 대한 정확도와 실효성을 조사하였 으며, 다음과 같은 결론을 도출하였다.

- 센서로 엘리베이터를 감지할 수 있는 위치에 20° 이내의 방 위오차 내로 도착할 수 있는 주행 기술을 갖춘 이동로봇은, 엘리베이터에 안전하게 탑승할 수 있는 센서 좌표계 기준 의 엘리베이터의 위치와 진입 방향 추정이 가능하다.

- 엘리베이터의 위치추정은 엘리베이터 문과 주변 벽면과 깊이 차이를 기반으로 실제 위치와 5 cm 내외의 거리 오차 로 위치추정이 가능하며, 유사한 구조의 대부분의 엘리베 이터에 대해 적용이 가능하다.

- 영상을 기반으로 전방의 엘리베이터를 인식 및 확인하므 로 엘리베이터와 비슷한 다른 구조에서 잘못 추정하는 경 우를 방지할 수 있다.

추후에는 RGB-D 센서 기반의 이동로봇 주행 기술과 엘리 베이터 문의 개폐 인식 기술을 추가하고, 실제 환경에 적용할 수 있도록 사람이나 물건 등의 정적, 동적 장애물에도 대응할 수 있는 엘리베이터 위치 추정과 로봇 제어 방법에 대한 연구 를 수행하고자 한다.

Acknowledgments

This work was supported by IITP grant funded by the Korea Government MSIT (No. 2018-0-00622).

References

-

A. A. Abdulla, H. Liu, N. Stoll, and K. Thurow, “Multi-floor navigation method for mobile robot transportation based on StarGazer sensors in life science automation,” 2015 IEEE International Instrumentation and Measurement Technology Conference, Pisa, Italy, pp. 428-433, 2015.

[https://doi.org/10.1109/I2MTC.2015.7151306]

- S. W. Ma, “Localization using Fiducial Markers and Elevator Door,” M.S thesis, Inha University, Incheon, 2012.

-

J.-G. Kang, S.-Y. An, W.-S. Choi, and S.-Y. Oh, “Recognition and Path Planning Strategy for Autonomous Navigation in the Elevator Environment,” International Journal of Control, Automation and Systems, vol. 8, no. 4, pp. 808-821, 2010.

[https://doi.org/10.1007/s12555-010-0413-3]

- J.Y. Baek and M.C. Lee, “A study on detecting elevator entrance door using stereo vision in multi floor environment,” 2009 ICCAS-SICE, Fukuoka, Japan pp. 1370-1373, 2009.

- W. Boehler, M. B. Vicent, and A. Marbs, “Investigating laser scanner accuracy,” CIPA XIXth Int. Symposium, vol. 34, pp. 696-701, 2003.

- D. H. Lee, “RGB-D Sensor based Elevator Recognition and Getting on and off an Elevator for Safe,” M.S thesis, Korea University, Seoul, 2018.

-

S.-W. Ma, X. Cui, H.-H. Lee, H.-R. Kim, J.-H. Lee, and H.-I. Kim “Robust Elevator Door Recognition using LRF and Camera,” Journal of Institute of Control, Robotics and Systems, vol. 18, no. 6, 2012.

[https://doi.org/10.5302/J.ICROS.2012.18.6.601]

-

C. Szegedy, V. Vanhoucke, S. Ioffe, J. Shlens, and Z. Wojna, “Rethinking the Inception Architecture for Computer Vision,” 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Las Vegas, NV, USA, pp. 2818-2826, 2016.

[https://doi.org/10.1109/CVPR.2016.308]

- C. Szegedy, S. Ioffe, V. Vanhoucke, and A. Alemi, “Inception-v4, inception-resnet and the impact of residual connections on learning,” arXiv:1602.07261, 2016.

-

A. Krizhevsky, I. Sutskever, and G. E. Hinton, “ImageNet Classification with Deep Convolutional Neural Networks,” Communications of the ACM, May, 2017.

[https://doi.org/10.1145/3065386]

- R. O. Duda and P. E. Hart, “Use of the Hough transform to detect lines and curves in pictures,” Communications of the ACM, January, 1972.

![[Fig. 1] [Fig. 1]](/xml/26023/JKROS-15-1-70_F1.jpg)

![[Table 1]](../img/npr_tablethum.jpg)

![[Fig. 2] [Fig. 2]](/xml/26023/JKROS-15-1-70_F2.jpg)

![[Fig. 3] [Fig. 3]](/xml/26023/JKROS-15-1-70_F3.jpg)

![[Fig. 4] [Fig. 4]](/xml/26023/JKROS-15-1-70_F4.jpg)

![[Fig. 5] [Fig. 5]](/xml/26023/JKROS-15-1-70_F5.jpg)

![[Fig. 6] [Fig. 6]](/xml/26023/JKROS-15-1-70_F6.jpg)

![[Fig. 7] [Fig. 7]](/xml/26023/JKROS-15-1-70_F7.jpg)

![[Fig. 8] [Fig. 8]](/xml/26023/JKROS-15-1-70_F8.jpg)

![[Fig. 9] [Fig. 9]](/xml/26023/JKROS-15-1-70_F9.jpg)

![[Fig. 10] [Fig. 10]](/xml/26023/JKROS-15-1-70_F10.jpg)

![[Fig. 11] [Fig. 11]](/xml/26023/JKROS-15-1-70_F11.jpg)