Pixel 군집화 Data를 이용한 실시간 반사광 검출 알고리즘

© Korea Robotics Society. All rights reserved.

Abstract

A new algorithm has been propose to detect the reflected light region as disturbances in a real-time vision system. There have been several attempts to detect existing reflected light region. The conventional mathematical approach requires a lot of complex processes so that it is not suitable for a real-time vision system. On the other hand, when a simple detection process has been applied, the reflected light region can not be detected accurately. Therefore, in order to detect reflected light region for a real-time vision system, the detection process requires a new algorithm that is as simple and accurate as possible. In order to extract the reflected light, the proposed algorithm has been adopted several filter equations and clustering processes in the HSI (Hue Saturation Intensity) color space. Also the proposed algorithm used the pre-defined reflected light data generated through the clustering processes to make the algorithm simple. To demonstrate the effectiveness of the proposed algorithm, several images with the reflected region have been used and the reflected regions are detected successfully.

Keywords:

Reflected Light Region Ide.jpgication, HSI, Pixel Analysis, Clustering, Pre-define Data1. 서 론

광원으로부터 시발되어 객체, 카메라 렌즈까지 반영되는 반사광으로 인한 객체 인식 장애는 여전히 광범위한 외란으로 작용한다. 작게는 스마트폰을 시작으로 탐사 로버, 자율주행 차량, 수술 로봇, 그리고 산업 현장까지 반사광 외란의 영향은 지대하다 [1-5]. 때문에 반사광 외란을 해소하기 위해 여러 연구 가 진행 되고 있지만, 실시간 상황에 있어 범용 적으로 사용 할 수 있는 반사광 해소 연구는 미흡하다.

우선 기존 연구 방식 중 기하학적 접근법으로, 우천 시 물웅 덩이에 반사되는 조명효과를 제거하는 기법이 있다[6]. 이 방법 의 경우 검출 방식이 Depth 상, [Fig. 1]도식과 같이 음의 위치에 있는 반사광 성분을 추출 해내는 방식이라 모든 반사광을 포함 시키지 않기 때문에 반사광이 효과적으로 제거되지 않는다.

또 기하학적 해석이 아닌 다른 수학적 해석 Model 로 BRDF (Bidirectional reflectance distribution function)가 있으며[7], BRDF 중 가장 많이 사용되는 Model인 Phong 반사 모델이 있 다[8,9]. Phong model은 반사광이 임의 지점 p(x, y)에 미치는 영향을 여러 벡터들의 관계식으로 표면의 재질, 높이에 의해 반사광의 세기가 결정되기 때문에 많은 Parameter (Ambient, Diffuse, Specular, and emissive light) 들이 고려되며, 실시간 영 상의 경우, Vector들이 짧은 시간 간격으로 변화한다. 이러한 이유로 수학적 접근은 필연적으로 많은 연산을 요구 한다. 때 문에 본 논문에서는 수학적 접근방식이 아닌, Pixel의 색도 검 출 방식을 통해 반사광이 맺히는 위치에 구애 받지 않고 빠르 고 효과적으로 검출 할 수 있는 알고리즘에 대해 제안한다. 색도 검출 및 특정 색상 검출 방법으로는 기본 입력 색 공간 인 RGB 색 공간에서 Gray scale로 변환 후, Threshold를 지정 하여 이진영상으로 출력하는 방법과[10], HSI (Hue Saturation Intens-ity)[11,12] 색 공간에서의 색도 분석 방법[13,14]이 대표적이 다. 본 논문에서는 3절에서 검출 색 공간을 선정 후, 군집화 과 정을 거친 반사광 Data 정의를 통해, Threshold 방식의 검출과 제안 알고리즘을 비교하고 제안 알고리즘의 성능을 검증한다.

2. 검출 반사광 정의

2.1 접근 방식

반사광이란 임의의 물체 지점에서 직접으로 카메라 렌즈에 반영(Specular)되는 직접 반사광(Direct light=Specular light)과 대기 중에 퍼져있는 간접 반사광(Ambient light)으로 분류가 된다. 이 때 카메라가 영상을 획득할 때 빛의 세기는 아래의 식 (1)과 같이 직접적으로 렌즈로 투과되는 직접광과 대기 중에 산란 되어 렌즈로 투과되는 간접광의 합으로 표현 된다[14-16].

| (1) |

여기서, p(x, y)은 2차원 Pixel 공간에서의 임의의 지점, 은 직접 반사광, 은 간접 반사광, 그리고 I 는 빛의 세기를 의미한다. 제안 하고자 하는 검출 알고리즘의 반사광 영 역은 식 (1)에서 , 즉 카메라로 반영 되는 아래 [Fig. 2]의 붉 은 테두리 부분과 같은 직접 반사광으로 국한 한다. [Fig. 2]는 산 업 현장에서의 반사광의 한 예 이며 [Fig. 2(a)]는 Input Image, [Fig. 2(b)]는 제안 알고리즘을 적용한 결과이다.

![[Fig. 2] [Fig. 2]](/xml/26104/JKROS-14-4-301_F2.jpg)

The example of reflected light at industrial site. (a) Input image, (b) The application result of proposed algorithm

본 논문에서 제시하는 반사광 검출 방법은 수학적 접근이 아닌 Input image의 p(0,0)-p(x, y)까지 Pixel에 대해 Predefine된 Pixel data 범위와 일치하는 Pixel들을 반사광으로 치 환하는 방식이다. 이 때, 반사광 Pixel 정의는 3번의 군집화와 2 번의 분류과정을 수행하여 최종 Define 하며, 정의 된 Data를 기반으로 [Fig. 2] 예시와 같이 Depth 상에서 형상이 있는 반사 광에 대한 색도 검출 방식이라 속도를 고려함은 물론, 반사광 의 위치에 구애 받지 않는 범용적인 검출 알고리즘이다.

3. 색도 검출

3.1 검출 색 공간 선정

색도 검출 접근에 앞서, 검출 색 공간을 선정하기 위해 1절 에서 소개한 RGB → Gray → Binary 순으로 출력하는 방법과 HSI 색 공간에서 색도 분석, 두 방식 중, 어떤 방식이 반사광 영 역과 색의 항상성 이론[17,18]에서 흰색 계열의 물체와 효과적인 구분의 용이성 판단을 위해 실험을 통한 결과 도출을 하였다. 아래 [Fig. 3]는 RGB 색 공간에서 입사각이 작은 반사광(Black Point), 입사각이 높아 상대적으로 세기가 약한 반사광(Blue Point),그리고 가 없는, 흰색 종이(Red Point) 3가지 영역 으로 분류하고, [Fig. 4]는 [Fig. 3]의 Width 좌표가 135인 구간 의 Pixel vector 들을 측정한 결과이다.

여기서 [Fig. 4]의 x축은 Image의 column의 위치이며 y축 은 Image의 각 column의 위치에서 Pixel vector (0-255)를 나타 낸다. [Fig. 4]의 결과에서 가 있는 지점과 없는 지점 모 두 R, G, B Vector가 높고, 모든 구간에서 세 가지 Vector가 유 사한 값을 가진다는 결과를 확인 할 수 있다.

이 결과는 색도 기반 검출 방식을 사용하여 반사광과 흰색 물체를 구분하려 할 때, 두 영역의 구분 점에 대한 정의가 매우 어렵다는 결과를 도출한다. 물론 Single image에 대해 반사광 을 정의한다면, RGB색 공간 또한 가능할 수도 있지만, 실시간 상황에서의 정의는 어렵다.

[Fig. 4]의 측정방식과 동일하게 HSI 색 공간에서의 직관적 색도 해석을 시도하였다. 먼저 RGB 색 공간에서 HSI 색 공간 변환 수식은 아래 식 (2-4)과 같고, 여기서 H는 색도, S는 채도 (색의 진함 정도), 그리고 I는 밝기 정도를 나타낸다.

| (2) |

| (3) |

| (4) |

변환 식 (2-4)에 의해 정의 된, H, S 그리고 I 각각의 Vector 를 H = B , S = G , 그리고 I= R 로 치환하고, 그 결과를 하나 의 24-Bit Channel에서 표현하면 아래 [Fig. 5]와 같고, 비교 실 험을 위해 [Fig. 5]에서 RGB색 공간에서 측정 한 방법과 동일 하게 Width 좌표가 135인 구간의 Pixel vector들을 측정하고, 그 결과를 아래 [Fig. 6]과 같이 도식하였다.

측정 결과를 보면 [Fig. 6]에서는 Black, Blue 그리고 Red point 모두 RGB색 공간과는 달리 H, S, I Vector가 유사한 값 이 아님과 동시에, 모든 구간에서 그 Vector 값이 차이가 있다.

그러나 범용 적인 반사광 영역 검출을 위해 [Fig. 6]의 예시 외, 다양한 환경에서의 측정 결과가 필요 하였으며, 아래 [Fig. 7]은 햇빛, 형광등, 그리고 물체를 거쳐 카메라로 투과되는 반사광 즉, 가 각기 다른 지점 P1-P5와 가없는 흰색 종이 G1, 흰색 유리병 G2 지점 즉, 흰색 물체와 실제 생활환경에서 여러 가지 형태의 반사광과 광원이 공존하는 예시이다.

아래 [Fig. 8]은 식 (2-4)에 의거, [Fig. 7]을 HSI 색 공간 변환한 결과이다. [Fig. 8]에서 [Fig. 7]과 동일한 각 Point spot의 Pixel vector들을 측정하여, [Fig. 9]와 같이 Histogram으로 표현 하였다.

앞선 측정 예제 인 [Fig. 6]과 [Fig. 4]와 달리, [Fig. 9]의 측정 결과를 Histogram으로 표현하였는데, 실시간 영상에서는 대 기 중에 퍼져있는 산란광의 영향으로 Pixel을 구성하는 Vector 들 일정 범위를 두고 짧은 시간간격으로 그 값이 변화한다. 때 문에 [Fig. 9]에서는 Single image와는 달리 각 Vector별, 범위 값의 표현과 더불어, 각기 다른 7지점의 Point에 대한 Vector 값 비교의 가시성을 고려하기 위함이다. 그럼 그 결과에서 살 펴보면, 햇빛이든 형광등이든 어떤 물질이나, 장애물을 거치 지 않고 바로 카메라로 투영 되는 지점인 P1, P2는 I Vector가 255, H, S Vector가 0으로 나타나고, 어떤 물질이나 장애물을 거친 P3-P5는 I Vector가 P1, P2에 비해 상대적으로 낮고, H, S Vector가 상대적으로 높다. 또한 G1, G2는 가없는 흰색 물체의 한 지점이나, I Vector가 P1-P5보다 현저히 낮고 H, S Vector가 상대적으로 높은 결과를 확인 할 수 있다.

이 결과로 HSI 색 공간에서는 검출 된 Pixel 영역이 밝을수 록 I Vector는 비례하지만, H, S Vector는 반비례 한다는 특성을 도출 할 수 있다. 이 특성을 고려하여 매우 다양한 환경에서의 측 정을 통해 HSI 색 공간에서 나타내는 반사광 영역의 공통 된 Pixel data들의 정의를 시도 하였으며, 공통 Data들의 효과적인 Filtering을 위해 K-means를 이용한 군집화 연산을 수행하였다.

4. Pixel 군집화 및 반사광 영역 정의

4.1 군집화 Data 형성

본 논문에서는 반사광 영역의 형성 과정을 총 3번의 군집화 과정과 3개의 Filter식, 그리고 2개의 분류식을 통해 최종 반사 광 영역을 정의하기로 하고, 아래 [Fig. 10]은 반사광 형성 과정 의 순서도 이다.

군집화 Data 형성은 K-means[19]알고리즘을 활용 하였고, K-means 알고리즘은 군집의 중점과 군집에 속하는 각각의 점 들로부터 거리 평균의 제곱 값을 구하여, 점들의 평균거리가 최소가 될 때 까지 Centroid를 재배열하여 평균 거리 V의 최소 화를 목적으로 하는 알고리즘이며, 연산은 아래 식 (5)와 같다.

| (5) |

이 때, 각 군집은 하나의 중심(Centroid)을 가지며, 군집화 차수를 T, 군집의 개수 K는 (10/T)의 몫, 또 xi는 해당 군집 차 수의 전체 Data의 집합을 XT 라고 할 때, XT 의 i번째의 샘플 Data이며, ck는 해당 군집 Data의 중점, rik는 xi에 대한 판별 변수로 샘플 Data xi가 군집화에 속하면 1, 아닌 경우 0이 된다. 그리고 Distance의 기준인 C(Pixel 단위)와 학습 횟수는 모든 군집화 과정에서 각각 3, 100으로 통일한다.

단 예로, 3절에서 비교분석에 사용 된, [Fig. 6]의 예시를 이용 하였으며, 아래 [Fig. 11]은 예시에 대한 군집화 형성 과정의 도 식이다. 먼저, [Fig. 6] 예시 Data들을 군집화 과정의 가시성을 고려, [Fig. 11(a)]와 같이 3차원 공간에 도식화 하고, [Fig. 11(b)] 는 [Fig. 11(a)]에 대해 K1 = 10으로 군집화 연산한 결과이다.

![[Fig. 11] [Fig. 11]](/xml/26104/JKROS-14-4-301_F11.jpg)

The results of the clustering of the pixel data in Fig.10. (a) Input data, (b) First clustering result K1 = 10, (c) Second clustering result K2 = 5 Here, when the first clustering result is compared with each other, we can confirm the result of excluding the dark object information. (d) Third clustering result K3 = 3 This is the final clustering process for the data, leaving only the white object information and the data that is assumed to be the reflected light area

첫 번째 군집의 결과인, [Fig. 11(b)]에서는 반사광영역이 아 닌 불필요한 물체 정보들이 모두 포함 되어 있다. 때문에, [Fig. 11(b)]에서, 3절에서 확인 된 HSI 색 공간만의 밝을수록 I Vector는 비례하고, H, S Vector는 반비례 한다는 특성을 활용 해 총 3번의 Filter 연산식을 정의 하였다. 먼저 첫 번째 Filter식 은 아래 식 (6)과 같다.

| (6) |

이 때, Δl은 군집의 샘플 Data인 xi의 Vector값을 기반으로 Filter식을 연산하였을 때의 결과 상수 값으로, Δl≻0면 이 되고, Δl≤0 이면, xi∉XT+1 이 된다. 식 (6)은 Input image에서 검정색, 회색 등 어두운 계열의 물체들을 추 출 된 Pixel data에서 제외 해주는 의의가 있다.

식 (6)을 통해 추출 된 Data를 대상으로 아래 식 (7)을 통해 식 (6)에서 제외되지 않은 I 값이 작고, H, S 값이 큰, 반사광 영역 검출에 있어 불필요한 물체 정보들을 추가로 [Fig. 11(b)] 결과에서 제외한다.

| (7) |

이 때, 식 (7)에서는 이면, 이고, 이면, 로 치환한다. 식 (6)과 식 (7)의 Filter식을 통해 추출 된 Data들을 바탕으로 2차 군집화를 실시 하였고, 이때 군집의 개수 K2 = 5 으로 2차 군집화 결과를 [Fig. 11(c)]과 같이 도식하였다. [Fig. 11(c)]에서 식 (6)과 식 (7)을 통 해 I 값이 작고, H, S 값이 큰 Data들이 image에서 제외 된 결 과를 확인 할 수 있다.

Filter 식 (8)은 마지막 Filter식으로써, 앞선 식 (6), 식 (7)과 달리, Pixel data의 밝기에 따른 H, S, 그리고 I Vector들의 관 계를 식 자체에 반영 하여, 반사광과 흰색 물체들로 추정 되는 Data들만 남기는데 의의가 있고, 과정은 아래 식 (8)과 같다.

| (8) |

여기서, ΔS는 S값의 변화량에 대한 특성 반영 값이며ΔH 는 H값의 변화량에 대한 특성 반영 값이다. 이 때 식 (8)과 더 불어 앞으로 적용될 모든 분류식은 식 (6)과 마찬가지로 ≻0면 이 되고, ≤0 이면, xi∉XT+1 으 로 치환하고, 결과는 [Fig. 11(d)]와 같다.

4.2 분류식을 통한 최종 반사광 영역 정의

식 (8)에 의한 결과가 도출 되면, 분류식인 식 (9)를 이용, [Fig. 11(d)]의 각 군집 정보에 대해 재정의 과정을 수행한다. 우선 식 (9)에서는 을 두 가지로 분류하기로 한다. 식 (9)에 서 의 정의를 두 가지로 분류한 요인은 앞 서 3절에서 반사 광영역의 Pixel 특성을 알아보기 위해, 각 상황에 따른 Black, Blue, 그리고 Red point로 구분지어 측정 했을 때, 반사광 영역 으로 추출하고자 하는 Black과 Blue point간의 Pixel Vector 차 이가 크기 때문에, 반사광의 정밀한 분류, 검출을 위해 분류과 정인 식 (9)에서는 을 두 가지로 나누어 정의한다.

먼저 광원, 입사각이 작은 정반사(Black point)를 추출하기 위해 아래 식 (9a)를 이용한 분류과정을 수행한다. 이 때, 식 (9a)에 포함 된 모든 상수는 반사광 Data를 정의 할 때, 그 세기 에 따라 을 백분위로 구분하기 위한 상수이다.

| (9a) |

식 (9a)에서 ≤0 인 Data들을 대상으로 식 (9b)통한 Blue, Red point 분류 연산을 수행 한다.

| (9b) |

이 때, 변수 ΔI 와 C는 Blue, Red point의 S 또는 H Vector 가 비슷한 값으로 표현되기 때문에, I Vector가 감소한 정도를 이용하여, Blue, Red point의 정확한 구분과 더불어 을 결과 값에 따른 구간 정의를 위해 도입 된 수이며, 식 (9b)를 통 한 최종 분류 결과는 [Fig. 11(d)]와 같고, Black, Blue point의 용어 적 구분을 위해 Black은 Direct영역으로 Blue는 Ambient 영역으로 명명하고, 최종 분류 결과는 아래 [Fig. 12]와 같다.

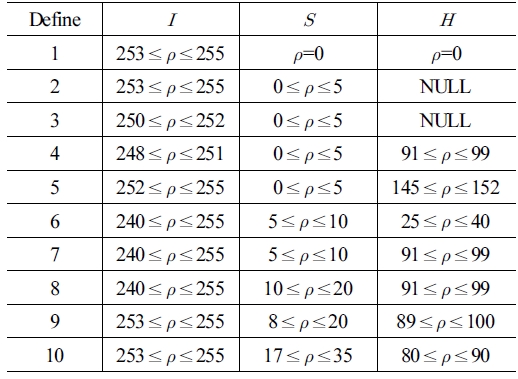

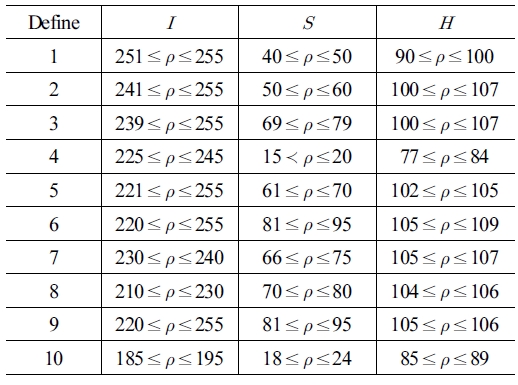

본 논문에서는 상기와 같은 방식을 적용하여 다양한 예제에 서의 Black, Blue point에 해당하는 공통적인 Data들을 기록하고, 최종적으로 반사광 Data를 식 (9)에서 두 가지로 분류 하였듯이 정의 또한 각각 [Table 1]과 [Table 2]로 구분지어 정의한다.

[Table 1]과 [Table 2]에서 Define 숫자가 작을수록 더 강한 반사광, 클수록 상대적으로 약한 반사광이고, 각 구간의 수는 식 (9a), 식 (9b)의 과 을 백분위로 표현한 값에 기인하여 정의되었으며, 이 때 H값 중 NULL은 고려되지 않 는 값이다. H가 NULL인 경우, 이미 I값이 충분히 높고, S값이 작은 범위에 속하는 Data이다. 따라서 H Vector가 매우 높게 측정이 된다고 하여도, 분류과정에서 반사광이 아닌 Vector로 분류가 되고, 실제로 그것은 물체 정보일 확률이 매우 높다.

제안 알고리즘은 정의 된 Data에 의거하여 ρ값들을 바로’0’ 으로 치환 후, Gray → Binary 변환 후, Binary channel에서 ‘0’ Pixel정보들을 제외하고, Inverse 연산을 수행 한다. 이러한 간 결한 연산과정 때문에 실시간 영상에서 Frame Delay 없이 사 용이 가능하다. 이 후 Masking 연산을 통해 반사광 처리 부분 에 있어서 응용이 가능하다.

5. 반사광 검출 실험 및 고찰

5.1 비교 실험

아래 [Fig. 13]은 생활환경에서의 햇빛에 의한 반사광과 흰색 시멘트 벽면이 포함 된 예시이며, [Fig. 14]는 제안 알고리즘과 RGB→Gray→Binary 검출 방식의 비교 실험을 위해, [Fig. 13] 에 대해 Binary channel에서 Threshold value를 로 지정하여, 해당 Pixel들을 ‘0’ 으로 치환하고, Binary channel 에서 Inverse시킨 결과이다.

이진 Image에서 특정 임계값을 지정하고 반사광을 검출한 결과, [Fig. 14]에서는 반사광이 아닌 흰색 건물 외벽까지도 반 사광으로 치환되는 결과를 확인 할 수 있다. 물론 Threshold value를 세부적으로 조정하여 지정된 Image에 국한하여 더 정 확한 검출 결과를 기대 할 순 있겠지만, 아래 [Fig. 15]의 Gray scale에서 값을 3절의 측정방식과 동일하게 측정 한 결과 살펴 보면, Threshold value를 세부적으로 조정한다고 하여 원론적 으로 RGB 색 공간에서 비슷한 Vector 값을 가지는 흰색 계열의 물체와 반사광을 구분하기에는 어려움이 있다.

다음으로 본 논문에서 제시한 [Table 1], [Table 2]에 의거한 HSI 색 공간에서의 반사광 검출 결과를 살펴보면, 아래 [Fig. 16]과 같고, [Fig. 16]의 결과에서는 흰색 시멘트 벽면이 제외 되었을 뿐 아니라, 반사광 검출 또한 더 정확한 결과를 확인 할 수 있다.

이러한 결과는 비교 방식에 있어 기인한 것인데, Binary channel에서의 검출은 [Fig. 15]과 같이 지정 된 Threshold value 범위 내의 Pixel들을 모두 치환한다. 즉, 2차원적인 매우 단순한 검출 방식이며, 본 논문에서 제시한 [Table 1], [Table 2] 에 의거한 검출 방식은 HSI 색 공간에서 H, S, 그리고 I 세 가 지 Vector를 모두 고려하는 3차원적 검출 방식이다. 때문에 검출 결과에 있어서 [Fig. 14]와 [Fig. 16]을 비교하였을 때, [Fig. 16]에서 훨씬 더 정확한 결과를 확인 할 수 있다.

추가 예시로, 아래 [Fig. 17]은 실시간 영상에서의 반사광 검 출 예이다. [Fig. 17]중, [Fig. 17(a)]는 White board 위, 햇빛에 의한 반사광이 광범위하게 있고, Image 상에 반사광이 아닌, 많은 물체들이 포함되어 있는 Input image이고, [Fig. 17(b)]는 Input에 대한 제안 알고리즘의 적용 결과이다.

![[Fig. 17] [Fig. 17]](/xml/26104/JKROS-14-4-301_F17.jpg)

The example of reflected light by sunlight in real-time (a) Input image, (b) The reflected region detection by proposed algorithm

[Fig. 17]의 예시를 통해 제안 알고리즘은 실시간 영상에서도, White board와 같이 광택이 있는 흰색 계열의 물체 위의 반사광 영역 또한 매우 정확하게 검출하는 결과를 확인 할 수 있다.

또한 제안 알고리즘은 수학적 접근방식이 아닌 단순 Pixel 색도 검출 방식의 접근이라 반사광이 맺힌 위치에 구애 받지 않을 뿐만 아니라, Pre-defined pixel data에 대한 단순 치환방식 이라 연산속도가 매우 빠르다.

5.2 알고리즘의 범용성 확인

앞서 반사광 영역의 Data를 정의하기 위해, 입력 영상인 RGB색 공간에서 식 (2-4)에 의한 HSI색 공간으로 변환 하였 다.이때, 변환 후 얻어 지는 결과 Vector인 H, S, 그리고 I 를 H = B , S = G , 그리고 I= R 로 치환하여, 그 결과를 하나의 24-Bit Channel에서 표현하고, 해당 색 Channel에서 군집화과 정을 거쳐, 4절 말미에서 최종 반사광 Data를 정립하였다. 즉, I 의 Vector값이 높을수록 24-Bit Channel에서 표현되는 R 의 Vector값이 높아지게 되는데, 이 때 정립 된 Data를 이용하여 검출을 시도하였을 때, 앞선 비교실험 예제로 흰색 계열의 물 체 위에서의 검출 정확성은 검증 한 바 있다.

하지만, 색의 항상성 이론에 있어 붉은색을 띄는 물체위에 반 사광이 존재할 때, 반사광과 물체는 어떻게 색도 구분이 지어지 는지 아래 [Fig. 18]의 실험 결과를 통해 확인 하였다. 아래 [Fig. 18(a)]는 붉은색 구체위에 반사광이 존재하는 한 예시이며, [Fig. 18(b)]는 Input image에 대한 HSI 색 공간 변환 결과이다.

확인 결과, 원본 Image를 HSI 색 공간 변환을 하였을 때, [Fig. 18(b)]와 같이 반사광 영역은 여전히 붉은색으로 확인이 되며 붉은 구체의 경우, 상대적으로 밝은 부분 P1과 어두운 부 분 P2를 측정하고 그 색도 결과를 HS(Hue Saturation) 색 평면 을 나타내는 아래 [Fig. 19]에서 살펴보면, 색도가 60°이상 회 전한 Y(Yellow)영역 이하로 속하는 결과를 확인 할 수 있다.

해당 결과를 미루어 볼 때, 제안 알고리즘은 반사광이 맺히 는 물체의 색도에 구애 받지 않고, 범용 적으로 사용 될 수 있다 는 사실로 귀결 지을 수 있으며, [Fig. 20]의 예시는 제안 알고 리즘이 백색광에 국한되지 않고 여러 색광 또한 검출이 가능 하단 사실과 더불어, 다양한 환경에서의 검출 예를 확인하기 위해, [Fig. 21], [Fig. 22]은 각각 야간 도로 환경과 3D 사물 위 에서 반사광이 있는 상황에서, 비교 실험 되었던 방식과 제안 알고리즘의 비교 결과이다.

![[Fig. 21] [Fig. 21]](/xml/26104/JKROS-14-4-301_F21.jpg)

The comparison result of detection in the night road environment. (a) Input image, (b) Threshold detection method, and (c) Proposed algorithm

6. 결 론

본 논문에서는 Pixel 군집화 Data를 이용하여 반사광 검출 임 했을 때, 종래의 Threshold value 추출 방식보다 정확한 물체 의 검출이 가능함을 실험을 통하여 입증하였다. 특히, 횡단보 도와 흰색 자동차와 같은 흰색 바탕의 색상 계열의 검출 시 그 효과가 더욱 뛰어나며, 3D Image에서도 마찬가지로 정확한 검출 결과를 확인 할 수 있었다. 또한 붉은 구체 색도 검출 예제 를 통해 색의 항상성에서 물체의 색도에 구애받지 아니하고, 백색광에 국한되지 않는 검출 방식임을 확인 할 수 있었고, 복 잡한 연산 방식인 수학적 접근방식을 지양하고 HSI 색 공간에 서의 색도 검출을 통해 구현하였다. 제안 알고리즘은 단순히 정의 된 Pixel 들을 ‘0’으로 치환하는 방식이 때문에 실시간 Frame Delay가 최소화 되며, 입력 된 Pixel 들의 전체적인 검출 이기 때문에 반사광의 위치 또한 제한 없이 전 범위적인 검출 이 가능하다. 즉, 정확하고 빠른 검출을 제공함으로서, 카메라 가 사용 된 여러 Platform에 있어서 반사광으로 인한 외란 해소 연구에 초석이 될 것이다. 향후 연구 진행 방향으로, 제안 된 알고리즘을 통해 검출된 영역의 복원 방법의 연구가 필요할 것이다.

Acknowledgments

This research was financially supported by the Ministry of trade, Industry and Energy (MOTIE), Korea Institute for Advancement of Technology (KIAT) through the Robot Business Belt Development Project (A012000009). This research was supported by the National Research Foundation of Korea (NRF) grant funded by the Korea government (MSIT) (No.2019R1A2C2088859).

References

-

H. Kang, J. An, H. Lim, S. Hwang, Y. Cheon, E. Kim, and J. Lee, “Localization Algorithm for Lunar Rover using IMU Sensor and Vision System,” Journal of Korea Robotics Society, vol. 14, no. 1, pp. 65-73, Mar., 2019.

[https://doi.org/10.7746/jkros.2019.14.1.065]

-

J. S. Ko and J. W. Rheem, “Surface Inspe-ction of a Journal Bearing Using Machine Vision,” J. Korean Soc. Precis. Engineering, vol. 34, no. 8, pp. 557-561, 2017.

[https://doi.org/10.7736/KSPE.2017.34.8.557]

-

T.-H. Cho and H.-M. Kang, “Gaze Tracki-ng Using a Modified Strarburst Algorithm and Homography Normalization,” Journal of the Korea Institute of Information and Communication Engineering, vol. 18, no. 5, pp. 1162-1170, 2014.

[https://doi.org/10.6109/jkiice.2014.18.5.1162]

-

H. Jung, S. J. Kim, J. Park, H. Cho, B. Ahn, Y. Na, and Y. Kim, “Challenges of Flexible Surgical Robots: Review,” Trans. Korean Soc. Mech. End. A., vol. 42, no. 10, pp. 891-903, 2018.

[https://doi.org/10.3795/KSME-A.2018.42.10.891]

-

M. Lee, J. Han, C. Jang, and M. Sunwoo, “Information Fusion of Cameras and Laser Radars for Perceoption Systems of Autonomous Vehicles,” Journal of Korean Institute of Intelligent Systems, vol. 23, no. 1, pp. 35-45, 2013.

[https://doi.org/10.5391/JKIIS.2013.23.1.35]

- S.-W. Lee, “Removing Lighting Reflection under Dark and Rainy Environments based on Stereoscopic Vision,” Journal of KIISE: Software and Applications, vol. 37, no. 2, pp. 104-109, 2010.

-

C. Schlick, “An Inexpensive BRDF Model for Physucallybased Rendering,” Computer Graphics Forum, vol. 13, no. 3, pp. 233-246, 1994.

[https://doi.org/10.1111/1467-8659.1330233]

-

C. Schlick, “A Survey of Shading and Reflectance Models,” Computer Graphics Forum, vol. 13, no. 2, pp. 121-131, 1994.

[https://doi.org/10.1111/1467-8659.1320121]

-

B.T. Phong, “Illumination for Computer Generated Pictures”, Communications of the ACM, vol. 18, no. 6, pp. 311-317, 1975.

[https://doi.org/10.1145/360825.360839]

- Y. Tsin, R. T. Collins, V. Ramesh, and T. Kanade, “Bayesian Color Constancy for Outdoor Object Recognition,” 2001 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, Kauai, HI, USA, 2001,

- J. R. Kender, “Saturation, hue and normalized color: Calculation, Digitization Effects, and Use,” Carnegie-Mellon University. Dept. of Computer Science, 1976.

-

A. Hanbury, “Constructing cylindrical coordinate colour spaces,” Pattern Recognition Letters, vol. 29, no. 4, pp. 494–500, 2008.

[https://doi.org/10.1016/j.patrec.2007.11.002]

-

T. Um and W. Kim, “Dehazing in HSI Color Space with Color Correction,” Journal of Broadcast Engineering, vol. 18, no. 2, pp. 140-148, 2013.

[https://doi.org/10.5909/JBE.2013.18.2.140]

-

M. A. Alonso Pérez and J. J. Báez Rojas, “Conversion from n Bands Color Space to HSI Color Space,” OPTICAL REVIEW, vol. 16, no. 2, pp. 91-98, 2009.

[https://doi.org/10.1007/s10043-009-0016-5]

-

Y. Shor and D. Lischinski, “The Shadow Meets the Mask: Pyramid-Based Shadow Removal,” Computer Graphics Forum, vol. 27, no. 2, pp. 577-586, 2008.

[https://doi.org/10.1111/j.1467-8659.2008.01155.x]

-

F. Azhar, K. Emrith, S. Pollard, M. Smith, G. Adams, and S. Simske, “Testing the Validity of Lamberts Law for Micro-scale Photometric Stereo Applied to Paper Substrates,” 10th International Conference on Computer Vision Theory and Applications - Volume 1: VISAPP, Berlin, Germany, pp. 246-253, 2015.

[https://doi.org/10.5220/0005359302460253]

- J.-W. Jung and G.-H. Kim, “Color cast Detection based on color by correlation and color constancy algorithm using kernel density estimation,” Journal of Korea Multimedia Society, vol. 13, no. 4, pp. 535-546, Apr., 2010.

-

K. Barnard, L. Martin, A. Coath, and B. Funt, “A Comparison of Computational Color Constancy Algorithms Part II: Experiments With Image Data,” IEEE Transactions on Image Processing, vol. 11, no. 9, pp. 985-996, 2002.

[https://doi.org/10.1109/TIP.2002.802529]

-

T. Kanungo, D. M. Mount, N. S. Netanyahu, C. D. Piatko, R. Silverman, and A. Y. Wu, “An efficient k-means clustering algorithm: Analysis and implementation,” IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 24, no. 7, pp. 881-892, Jul., 2002.

[https://doi.org/10.1109/TPAMI.2002.1017616]

2014 인제대학교 전자지능로봇공학과(학사)

2017 부산대학교 전기전자컴퓨터공학과 전자공학 전공(석사)

2017~현재 부산대학교 전기전자컴퓨터공학과 전자공학 전공 박사과정 재학 중

관심분야: 위치인식, 임베디드 시스템

2017 부산대학교 항공우주공학과(학사)

2019 부산대학교 전기전자컴퓨터공학과 전자공학 전공(석사)

2019~현재 부산대학교 전기전자컴퓨터 전자공학 전공 박사과정 재학 중

관심분야: 인공지능, 영상처리, 위치 추정

![[Fig. 1] [Fig. 1]](/xml/26104/JKROS-14-4-301_F1.jpg)

![[Fig. 3] [Fig. 3]](/xml/26104/JKROS-14-4-301_F3.jpg)

![[Fig. 4] [Fig. 4]](/xml/26104/JKROS-14-4-301_F4.jpg)

![[Fig. 5] [Fig. 5]](/xml/26104/JKROS-14-4-301_F5.jpg)

![[Fig. 6] [Fig. 6]](/xml/26104/JKROS-14-4-301_F6.jpg)

![[Fig. 7] [Fig. 7]](/xml/26104/JKROS-14-4-301_F7.jpg)

![[Fig. 8] [Fig. 8]](/xml/26104/JKROS-14-4-301_F8.jpg)

![[Fig. 9] [Fig. 9]](/xml/26104/JKROS-14-4-301_F9.jpg)

![[Fig. 10] [Fig. 10]](/xml/26104/JKROS-14-4-301_F10.jpg)

![[Fig. 12] [Fig. 12]](/xml/26104/JKROS-14-4-301_F12.jpg)

![[Table 1]](../img/npr_tablethum.jpg)

![[Fig. 13] [Fig. 13]](/xml/26104/JKROS-14-4-301_F13.jpg)

![[Fig. 14] [Fig. 14]](/xml/26104/JKROS-14-4-301_F14.jpg)

![[Fig. 15] [Fig. 15]](/xml/26104/JKROS-14-4-301_F15.jpg)

![[Fig. 16] [Fig. 16]](/xml/26104/JKROS-14-4-301_F16.jpg)

![[Fig. 18] [Fig. 18]](/xml/26104/JKROS-14-4-301_F18.jpg)

![[Fig. 19] [Fig. 19]](/xml/26104/JKROS-14-4-301_F19.jpg)

![[Fig. 20] [Fig. 20]](/xml/26104/JKROS-14-4-301_F20.jpg)

![[Fig. 22] [Fig. 22]](/xml/26104/JKROS-14-4-301_F22.jpg)