자폐 범주성 장애 아동의 눈맞춤과 얼굴표정읽기 기능향상을 위한 행동 중재용 로봇시스템

†Corresponding Author : Corresponding author: Center for Robotics Research, Korea Institute of Science and Technology, Seoul, Korea skee@kist.re.kr

© Korea Robotics Society All rights reserved

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

In this paper, we propose and examine the feasibility of the robot-assisted behavioral intervention system so as to strengthen positive response of the children with autism spectrum disorder (ASD) for learning social skills. Based on well-known behavioral treatment protocols, the robot offers therapeutic training elements of eye contact and emotion reading respectively in child-robot interaction, and it subsequently accomplishes pre-allocated meaningful acts by estimating the level of children’s reactivity from reliable recognition modules, as a coping strategy. Furthermore, for the purpose of labor saving and attracting children’s interest, we implemented the robotic stimulation configuration with semi-autonomous actions capable of inducing intimacy and tension to children in instructional trials. From these configurations, by evaluating the ability of recognizing human activity as well as by showing improved reactivity for social training, we verified that the proposed system has some positive effects on social development, targeted for preschoolers who have a high functioning level.

Keywords:

Human-Robot Interaction, Autism, Socially Assistive Robots, Behavioral Interventions1. 서 론

자폐 범주성 장애(ASD: Autism Spectrum Disorders)를 가진 아동은 눈맞춤을 비롯하여 상대의 감정에 대한 공감능력 과 같은 사회적 기능에 질적 결함을 가지고 있으며, 특유 의 반복적인 행동과 제한된 관심사에 몰두하는 특징을 가 진다[1]. 최근 미국 국립질병통제예방센터(CDC)의 보고에 따르면, 자폐인구수에 있어서도 68명의 어린이들 중에서 1 명이 ASD로 진단 받을 만큼[2], 현재 ASD를 가진 아동은 증가 추세에 있으며, 조기 진단에 따른 적절한 치료와 개 입을 통하여 그 기능을 개선시키지 않으면 성인이 되어서 도 사회적 상호작용의 결함이 지속될 가능성이 높아진다 고 한다[3,4].

이러한 ASD를 가진 아동의 핵심적인 어려움에 대한 적 절한 치료의 필요성이 계속적으로 강조되어 왔으며, 현재 까지 다양한 사회적 중재 기술[5]이 수행되어 왔다. 특히, ASD는 그 스펙트럼이 넓고 치료가 평생 지속되어야 하는 만큼, 아동의 발달수준에 맞추어 행동 특성을 세분화하고, 치료 개입의 타깃을 정하며, 영역에 따라 자기의지를 통해 그 효능을 도출해 내는 작업이 필요하다[6].

로봇은 매력적인 외형을 바탕으로 ASD를 가진 아동들 의 치료와 놀이 상대로서 효용성을 가지며[7-9], 자폐치료에 효과적인 도구로 이용될 수 있다[10]. 특히, 임상실험에서 다 양한 행동자극을 통해 사회성 기능 향상에 긍정적인 영향 을 제공함에 따라, 이를 이용한 행동 중재 치료 연구가 상 당히 활기를 띠고 있다[11]. 뿐만 아니라, 장기간에 걸쳐 특 정기능의 반복적인 행동치료에 대해 일관성을 가지면서 노동력 절감효과를 제공할 수 있는 로봇기술의 적용은 자 폐치료에 있어서 필수적인 구성요소가 될 수 있다.

위의 연구 결과에서, 효과적인 자폐치료를 위해 가져야 할 로봇의 주요 역할은 아동과 상호작용하기 위한 최적의 행동을 조절하고 아동이 관심을 가지지 않을 때 자동적으 로 전향된 응답을 수행할 수 있는 일정수준 이상의 자율 적인 상호작용 기술을 가지고 치료 프로그램을 진행하는 것이다.

본 연구에서는 로봇을 이용하여 ASD를 가진 아동의 눈 맞춤과 얼굴표정인식 기능을 향상시키기 위한 행동적 중 재 시스템을 제안하고 그 적용 가능성을 탐색하는 것을 목표로 한다. 이를 위해 중재시스템은 검증된 치료 프로토 콜에 따라 아동에게 구성된 두 가지 훈련을 시도하고, 행 동반응 인식으로부터 대응전략에 따라 자동화된 훈련강화 절차를 수행할 수 있는 인터랙션 아키텍처를 디자인 하였 다. 그리고, 시스템 관점에서 아동의 행동반응에 대한 인 식 정확도와 훈련 참여의 동기부여를 위해 구성된 로봇자 극의 효과를 점검하고, 임상실험에서 ASD를 가진 아동을 대상으로 반응 정도에 대한 정량적 평가를 수행함으로써, 제안하는 로봇시스템의 효용성을 검증하고자 하였다.

본 논문은 다음과 같이 구성되어 있다. 2장에서는 자폐 치료를 위해 설계한 로봇시스템을 세분화하여 소개하고, 3 장에서는 로봇시스템을 이용한 눈맞춤 및 표정읽기 임상 실험의 결과를 설명한다. 그리고, 4장에서는 결론을 정리하 였다.

2. 자폐치료를 위한 로봇시스템

2.1. 인터랙션 아키텍처

ASD를 가진 아동의 사회성 기능을 보다 효과적으로 개 선하기 위하여, 본 연구에서는 응용행동분석(ABA)의 과학 적 근거를 기반으로 한 불연속 개별시도훈련(DTT: Discrete Trial Teaching) [12] 이론을 바탕으로 ASD를 가진 아동이 사 회성 훈련을 수행할 수 있는 로봇보조의 행동적 중재 시 스템을 고안하였다. 여기서, DTT는 목표하는 행동을 이끌 어 내기 위기 위한 전제자극(Sd), 아동의 반응(Ra), 후속자 극(Sc)으로 구성되며, 아동이 원하는 후속자극을 얻기 위한 반응을 보이도록 전제자극을 통해 유도함으로써 치료 목 표를 달성하게 된다.

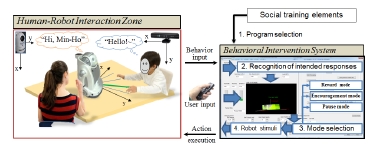

제시한 DTT 프로토콜을 로봇시스템에 적용하기 위해, 본 연구에서는 훈련요소 제공, 아동 행동반응 인식 및 치 료사 입력, 대응모드 선정, 그리고 후속자극 수행 모듈로 구성된 인터랙션 아키텍처를 디자인하였다(Fig. 1 참조).

우선, 로봇은 사회성 훈련 요소를 제공함으로써 아동에 게 전제적 자극을 수행하게 된다. 여기서, 훈련요소는 행 동적 치료 형태인 눈맞춤, 가리키기, 공동주의(joint attention), 터치놀이, 가상놀이, 호명반응, 행동 모방 등으로 구성될 수 있다. 그런 다음, 로봇은 아동의 행동 반응신호 의 해석으로부터 용인되는 반응의 정도를 분석한다. 여기 서 반응 정도는 긍정, 부정, 무응답으로 구분한다. 그 다음 으로 로봇은 인식결과로부터 후속자극 수행을 위해 미리 설정한 대응전략(Coping Strategy)에 따라 보상, 독려, 중지 의 대응모드 중에서 하나를 결정한 후, 지정된 모드 내 구 성된 로봇 자극구성요소를 통하여 훈련의 강화절차를 수 행하게 된다.

이상과 같이, 로봇 기반의 인터랙션 아키텍처 구성은 ASD를 가진 아동에게 사회적 상호작용 행동을 유도하기 위한 반복적인 훈련을 제공함으로써 그들이 궁극적으로 사회적 상호작용을 원활하게 할 수 있도록 한다.

2.2. 사회성 훈련요소 선정

아동의 응시는 대상에 대하여 의도를 나타내는 관심표 출의 정도로써 치료의 중요한 단서가 될 수 있다. 그러나, ASD를 가진 아동에서 눈맞춤의 결여는 핵심적인 특성 가 운데 하나로 간주되어 정상발달을 보이는 아동에 비해 상 호간의 눈맞춤에 더 적게 참여하는 것으로 보고되고 있다 [13,14]. 하지만 구조화된 실험 환경에서는 다른 사람과의 눈 맞춤을 수행할 수 있으며, 의사소통 신호의 보다 명확한 제공을 통하여 다른 사람과 눈을 맞추고 시선을 따라가는 것을 배울 수 있다고 알려져 있다[15]. 이에 따라, 눈맞춤을 회피하고 반복적인 행동을 나타내는 ASD를 가진 아동의 행동 양상은 중요하게 고려하여 설계되어야 하며, 그 효용 성에 대해 검증해야 할 필요성이 있다. 또 하나의 훈련요 소로써, 몇 몇 연구에 의하면[16,17], 인간의 얼굴표정은 다른 사람의 감정상태를 이해할 수 있는 매우 중요한 의미 전 달의 역할을 수행함에도 불구하고, 자폐아동은 얼굴표정과 같은 사회적 신호를 이해하고 공유하는데 어려움을 가진 다고 알려져 있다. 그렇지만, Clark[18] 등에 따르면, 훈련세 션에 있어서 얼굴표정과 관련한 신속하게 제시되는 자극 으로부터 감정을 식별하는 것은 감정이입과 신속한 흉내 내기를 포함하는 아동의 사회성 발달에 좋은 지표가 될 수 있다고 한다. 뿐만 아니라, 시스템 차원에서 이러한 얼 굴표정 읽기 훈련은 ASD를 가진 아동에 대한 정량적인 데이터 확보에 있어서 중요한 근거자료가 된다. 따라서, 이러한 눈맞춤과 얼굴표정 읽기훈련과 관련한 연구 결과 들은 ASD를 가진 아동의 비언어적 행동 개입이 사회적 상호작용의 측면에서 중요한 치료 목표가 될 수 있다는 것을 의미한다.

2.3. 휴먼 행동 인식

아동의 행동 반응을 인식하는 휴먼 인식 모듈에는 객체 검출과 추적, 치료사-아동 분류, 눈맞춤 검출 기술이 적용 되었다. 로봇시스템은 이러한 인식 모듈로부터 추출된 행 동정보를 토대로 편성된 프로그램에 따라 자율적으로 상 호작용 대상자를 응시하고 대상자의 반응에 신속하고 시 기 적절한 후속 대응절차를 수행할 수 있게 된다.

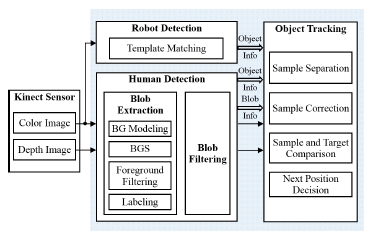

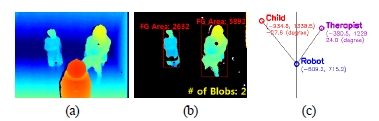

먼저 객체검출 및 추적 부는 Fig. 2와 같이 Kinect 센서를 통해 입력 받은 3D 영상을 이용하여 로봇검출(Robot Detection), 휴먼검출(Human Detection), 객체추적(Object Tracking) 알고리즘을 적용하여 훈련프로그램에 참여하는 치료사, 아동, 로봇의 위치 정보와 움직임을 추정한다. 실 제 실험환경에서 얻어지는 영상에서 로봇의 외형은 오직 수직방향으로 잘려진 정도와 로봇이 바라보는 방향에 의 해서만 변하므로 위의 두 변수를 고려하여 24개의 로봇영 상을 템플릿 패치로 사용한 Template Matching 알고리즘을 통해 로봇영역으로 검출하였다[19]. 한편, 휴먼영역의 시각 적 특징은 비 강성 움직임, 옷 색깔, 크기 등의 이유로 로 봇보다 큰 변화의 특성을 가지므로, 로봇검출과는 달리 움 직임영역 검출을 기반으로 다음과 같이 사람영역을 검출 한다. 초기 배경모델링(BG Modeling: Background Modeling) 을 통한 배경분리(BGS: Background Subtraction)기법을 적용 한 후[20,21], 전경 필터링(Foreground Filtering), Labeling을 거쳐 추출된 Blob 중 일부가 휴먼영역으로 할당된다. 마지막으 로, 객체추적은 Particle filtering 알고리즘을 적용하였다[22]. 이때 사용한 특징 점은 국부이진패턴[23]과 HSV 색 공간의 색상, 채도이다.

휴먼검출을 통하여 얻어진 두 개의 객체는 추적 알고리 즘에 의해 초기 추적되는 동안 자동으로 치료사와 아동으 로 분류된다. 이는 치료사의 외형이 중재 대상인 4-5세 아 동과는 뚜렷한 차이를 가진다는 분류 전제조건을 토대로, 두 객체 영역의 전경의 크기(전경영역의 픽셀 수)를 특징 점으로 이용하였다. 즉, 두 객체가 검출되고 일정시간이 지난 이후부터 지정된 시간 동안 전경의 크기가 더해져, 전경 크기의 합이 일정기준 이상이면 치료사로, 그 반대의 경우 아동으로 분류하게 된다.

눈맞춤 검출과 관련하여, 본 연구에서는 지난 임상실험 과 관련한 예비연구결과[24]를 토대로 로봇과 아동간의 눈 맞춤 상황판별 과정에서 발생 가능한 아동의 행동 특징(얼 굴을 비스듬히 기울임)을 발견하게 되었고, 이를 개선하기 위해 다음과 같은 인식 절차를 구성하였다. 우선, 대상자 의 기울임에 대응하기 위해 로봇의 헤드부분에 장착된 카 메라로부터 입력 받은 영상과 이를 ±15°씩 회전시킨 영 상으로 세분화 한 후, Haar-cascade 분류기[25]에 의해 정면얼 굴과 한 쌍의 눈이 검출되면 아동이 로봇과 눈맞춤을 수 행하고 있으며, 두 조건을 만족하지 못하면 눈맞춤 상태가 아니라고 결과를 출력하게 된다.

얼굴표정읽기 훈련에 대한 아동반응을 인식하기 위하여, 본 연구에서는 음원 검지 및 핵심어 인식기를 점검하였으 나, 임상실험에 사용할 만큼의 만족스러운 결과를 도출하 지 못하였다. 따라서, 부득이하게 훈련프로그램 상황을 가 장 잘 이해하는 치료사에 의한 외부입력을 처리하는 모듈 로 대체하였다. 이 모듈은 긍정 혹은 부정의 두 가지 결정 정보를 입력 받으며, 훈련 프로그램이 중지 상태에 이르면, 재시도를 하는 시점 적용도 치료사가 구성하도록 구성하 였다.

2.4. 로봇 행동 제어

로봇은 다양한 얼굴표현 및 신체적 조작을 통해 ASD를 가진 아동의 사회성 기능향상에 긍정적인 영향을 제공해 왔다[7,11,17,24]. 특히, 본 연구에서는 사회성 기능요소를 훈련 함에 있어서 대상 아동의 적극적인 참여를 유도하기 위해 친밀감 형성과 집중력 향상을 목적으로 하는 로봇 자극 구성요소를 설계하였다. 먼저, 아동과의 친밀감을 형성하 기 위한 요소는 대상자를 응시하며 인사하기, 이름 부르기 및 개인별 관심사 질의하기, 불빛이나 음향효과로 신속하 게 반응하기, 다가가기 형태의 친숙한 행동반응과 물질적 보상의 조합으로 구성한다. 특히, Sherwin에 의하면[26], ASD 를 가진 아동들은 불빛, 소리, 움직임에 민감하게 반응하 며, 의성어나 의태어가 들어 있는 동요에 대해서는 언어모 방 형태나 관심을 끌 수 있는 요소로 효과가 있음을 제시 하여, 이 요소를 추가 반영하였다. 이에 반해, 집중력을 향 상시키기 위한 요소는 로봇의 발화속도(normal, fast, top), 표 정구현 시간(short, middle, long) 및 응답시간제한(short, middle, long)과 같이 세분화하여 차별화된 행동을 수행하도 록 구성한다. 특히, 제시하는 단어의 색상과 글자가 일치 하지 않는 조건에서 글자의 색상을 말해야 하는 스트루프 검사(Stroop test)[27,28]는 다양한 형태의 인지게임을 통해 학 습과 주의력 관계, 문제 해결능력, 정신적 스트레스 테스 트와 관련한 연구에 활용되어 왔다. 이에, 본 연구에서도 로봇의 감정표현과 그 의미를 물어보는 얼굴표정읽기 훈 련에서 정답에 대한 차별화된 질의형태(확인형, 요청형, 모 순형)를 통하여 하나의 자극 도구로 활용하였다.

다음으로, 훈련 강화절차(Reinforcement Procedure)를 위해 계획한 로봇 대응전략은 아동의 행동반응 결과로부터 세 가지 대응모드(보상, 독려, 중지)중 하나를 결정하고, 동일 반응의 연속성(3회이상)에 따라 레벨을 조정한 후, 제시된 두 가지 로봇 자극 구성 요소를 조합하여 행동을 수행하 게 된다(Table 1 참조).

우선, 보상모드는 로봇이 아동의 긍정적 훈련 반응에 대 해 미리 설정한 칭찬 멘트를 발화하도록 구성하여, 아동 스스로 성취감을 가지도록 하는데 그 목적이 있다. 그리고, 연속적인 정답반응에 대한 차별화된 보상자극을 제공하기 위해 LED를 깜빡임 조절(RW1), 기쁨을 주는 로봇 행동 (RW2: 끄덕이기, 다가가기, 두 손 들기, 웃음 이미지 표시 등), 및 아이들이 즐거워하는 동요 동영상이나 로봇 율동 형태(RW3)의 훈련 강화 자극요소를 단계별로 구성하여 제 공한다. 독려모드는 아동의 미 응시와 오답반응 두 가지 상태로 구분되며, 미 응시 상황에서 로봇은 다소 강한 어 조로 눈맞춤 요청을 위한 독려용 멘트(EN1L1)를 발화하고 관심을 유도할만한 큰 제스처 동작이나 과장된 행동(앞뒤 로 움직이기, 손 흔들기, 이름 부르기 등)과 음향효과를 조 합하여 독려자극(EN1L2)을 수행하게 된다. 이에 반해, 오 답반응에 대해서는 심리적 안정과 자신감을 북돋우기 위 해 공감을 형성할 수 있는 독려용 멘트(EN2L1)를 발화한 다. 아울러, 익숙한 신체적 행동(고개 흔들기, 좌우로 회전 하기 등)이나 애착관계가 형성된 시청각 보조물(멜로디, 가 족사진, 인기캐릭터 표시등)과 추임새(위로용 감탄사)의 자 극 조합(EN2L2)을 통하여 로봇 훈련에 대한 아동의 친숙 도를 높이면서 적극적인 훈련참여를 유도 하는데 초점을 두고 있다. 그러나, 일정횟수의 반복된 독려에도 불구하고 아동이 부정적 혹은 무반응을 표시할 경우, 로봇은 제어모 드를 PAUSE로 전환하고 치료사의 요청이 있기 전까지 일 정시간 동안 대기하도록 설계되었다.

2.5. 임상실험 구성

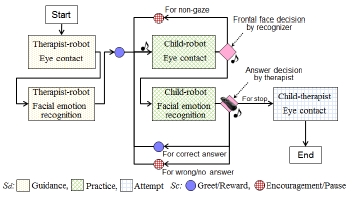

훈련프로그램은 제시된 DTT 프로토콜에 따라 삼자간 (치료사-로봇-아동) 상호작용을 통해 ASD를 가진 아동이 눈맞춤과 얼굴표정읽기 훈련을 용이하게 향상시킬 수 있 도록 구성하였다(Fig. 3).

먼저, 로봇은 자폐아동이 행동을 보고 따라 할 수 있도 록 과장된 표현을 통해 치료사와 마주보고 인사하고 얼굴 표정을 통해 감정을 표시하며 치료사가 정답을 말할 수 있도록 유도한다. 그런 다음, 정답에 대한 칭찬 발화를 수 행한다(Guidance). 그 이후 로봇은 아동이 위치한 곳을 지 향하고, 훈련시작 전 반갑게 인사하면서 심리적 친밀감을 형성하기 위한 상호작용을 수행한다. 그런 다음, 눈맞춤과 얼굴표정읽기를 순차적으로 제시하고, 전제자극에 수반되 는 아동의 행동반응을 평가한 후, 선정된 훈련모드와 지정 된 자극제 타입에 따라 로봇의 강화프로세스를 수행하게 된다(Practice). 여기서, 멜로디는 훈련요소의 시작과 종료를 알려주며, 아동은 두 가지 훈련요소를 지정된 횟수 동안 반복적으로 수행하게 된다. 그 이후, 훈련 프로그램 마지막 단계에서 로봇은 참가 아동에게 치료사와의 눈맞춤을 요청 (Attempt)함으로써, 로봇의 중재가 인간-인간 상호작용 형태 에 영향을 줄 수 있는지의 가능성을 탐색하고자 하였다.

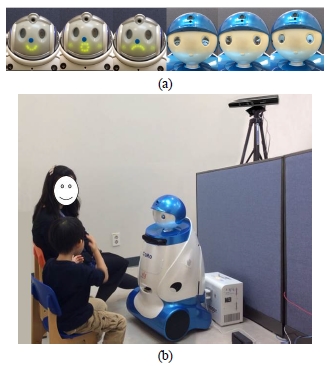

실험환경 구성과 관련하여, 우리는 자폐아동이 훈련에 전념할 수 있도록 파티션을 이용하여 훈련공간과 관측공 간을 구분하였다. 훈련공간에는 로봇이 중앙에 위치하고, 그 앞쪽에 두 개의 착석 가능한 의자를 위치하여 치료사 와 자폐아동이 자유롭게 착석할 수 있도록 구성하였다. 관 측공간에는 훈련공간 내 참가자의 행동을 인식할 수 있는 Kinect 센서를 설치하고, 훈련공간에 대한 관측과 로봇 제 어상태를 동시에 모니터링 할 수 있도록 구성하였다. 그리 고, 본 연구에서는 임상실험을 위해 제안한 시스템을 두 종류의 상호작용 로봇에 적용하였는데, 이는 앞서 제시한 인터랙션 아키텍처의 호환성을 점검하고 로봇 플랫폼 의 존성을 줄이는데 그 목적을 두고 있다. 먼저, 모바일 휴머 노이드 로봇인 iRobiQ는 ㈜유진로봇에서 개발한 상용제품 으로 매력적인 외형에 음성발화, 얼굴 표정 및 바디 율동 구동, 응시 제어, 립싱크, LED표시 기능 및 상당 수의 어린 이 동요 콘텐츠 구동을 수행할 수 있다. 다음으로, CARO(Clinical Assistive Robots)는 한국과학기술연구원에서 특별히 눈 감정 표현을 통해 행복, 놀람, 즐거움, 슬픔 등 의 감성적 상호작용을 수행할 목적으로 설계한 로봇으로 써, ASD를 가진 아동이 얼굴표정읽기 훈련에 보다 집중할 수 있도록 구성되었다. 그리고, 로봇의 크기는 착석한 아 동의 눈높이에 맞추어져 친밀감을 가지면서 상호작용을 수행할 수 있으며, 이동성을 감안하여 아동과 함께 율동에 맞추어진 동요 콘텐츠 수행이 가능하도록 구성되었다.Fig .4

Experimental setup for autism treatment: (a) robotic facial expressions, and (b) controlled clinical environments

실험참가자는 만 4-5세에 이르는 ASD를 가진 아동을 대 상으로 모집공고를 진행하였으며, 자폐장애의 진단도구인 ADOS(Autism Diagnostic Observation Schedule) 및 ADIR( Autism Diagnostic Interview-Revised)을 통해 타인과의 눈 맞춤에 어려움을 느끼며, 실험에 사용된 표정들을 이미 구 별할 수 있는 능력이 있고 어휘를 알고 있음에도 불구하 고 일상생활에서 자발적으로 자신의 감정을 표현하거나 상대방의 감정을 읽어내는 표현을 거의 보이지 않았던 것 으로 보고된 8명의 아동들을 대상으로 임상 실험을 수행 하였다. 실험은 각 참가자 별로 두 종류의 로봇에 대해 각 각 4회씩, 총 8번의 회기를 수행하도록 구성하였으며, 참 가 아동은 로봇에 의해 회기 당 총 10회에 걸쳐 제시한 두 가지 사회성 기능 훈련을 반복해서 수행하게 된다. 한 회 기당 대략 3-40분의 훈련시간이 소요되며, 주 1회씩 총 8 주에 걸쳐 실험이 진행되었다. 실험결과에 사용될 훈련요 소에 대한 아동 별 전체 시도횟수는 대략 80회 정도로 구 성되며, 치료사의 주관적인 판단에 일관성을 유지하기 위 해 모든 실험에는 동일한 치료사가 참여하였다.

3. 실험 결과

3.1. 휴먼 행동 인식 성능 평가

제안한 휴먼 행동 인식 알고리즘이 로봇시스템에 효과 적으로 적용되기 위해서는 인식 성능에 대한 신뢰성 점검 이 필요하다. 이를 위해, Fig. 5에서 보는 바와 같이, 실험환 경과 동일한 구성을 통해 촬영한 54개의 영상 시퀀스를 사용하여 치료사-아동 분류 알고리즘의 정확도를 측정하 였으며, 총 53개(98.15%)의 영상에서 치료사와 아동의 분 류 알고리즘이 정확히 인식됨을 확인하였다.

An example of a human classification process: (a) depth image, (b) foreground extraction, and (c) classification result

또한, 동일한 환경에서 획득한 3032장의 영상을 이용하 여 눈맞춤 검출 알고리즘의 적용가능성을 검증하였다. 각 영상은 눈맞춤 여부에 따라 정/오로 표시하고, 알고리즘으 로 분류한 결과 평균 85.7%의 정확도를 확인하였다. 이것 은 영상을 회전하지 않고, Haar-cascade 방식의 정면얼굴 검 출기만 사용하는 경우(평균 81.1%)와 비교해 4.6%p의 인식 개선의 효과가 입증되었다. 오인식이 발생되는 주요 요인 으로는 대상자가 얼굴을 옆으로 많이 기울이거나 로봇바 디에 장착된 모니터를 보기 위해 얼굴을 숙이는 포즈로 인해 발생하였다. 또한, 간혹 제한된 인식 영역에서 크게 벗어나는 경우에도 오인식이 발생하는 것이 관찰되었다.

3.2. 로봇시스템 성능 평가

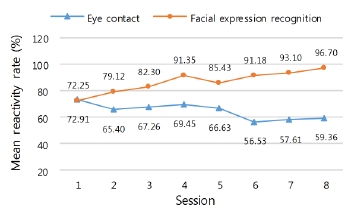

임상실험에서 앞서 평가한 인식모듈을 포함한 로봇시스 템의 자극효과를 검증하기 위해, 본 논문에서는 먼저 두 가지 훈련 요소에서 보인 아동의 훈련반응 정도를 측정하 였다. Figure 6은 임상실험의 회기 진행에 따른 아동-로봇간 눈맞춤과 얼굴표정읽기 훈련에 대한 아동의 평균 정 반응 비율을 표시한다.

눈맞춤 훈련의 경우, 아동이 iRobiQ와 CARO를 각각 처 음 접한 1회기와 5회기에 각각 72.91%와 66.63%의 높은 응시반응 보였고, 뒤따르는 훈련(2-4회기와 6-8회기)에서는 다소 감소하였지만, 평균 67.37±1.65%와 57.83±1.16%의 비 교적 일정한 수치의 정 반응 비율을 유지하고 있음을 확 인하였다. 이러한 결과는 아동이 처음 로봇을 접했을 때 상대적으로 높은 관심을 표시하지만, 회기가 진행될수록 점차 친숙함을 느끼며, 로봇과의 상호작용 경험을 치료사 와 공유하거나 심지어 일부로 회피하면서 발생하게 된 현 상으로 관측되었다.

얼굴표정읽기 훈련에서도 로봇 변경이 발생한 5회기의 아동 정답비율이 이전 회기 대비 소폭 감소(-5.93%p)하는 결과를 나타내고 있다. 이러한 결과는 로봇에 대한 아동의 선호도 문제와 얼굴표정변화에 대한 참가자의 민감성에 따른 것으로 분석되었다. 하지만, 주목할 점은 회기 진행 에 따른 아동의 정답 비율이 지속적으로 증가 추세를 보 인다는 점이며, 이는 아동의 적극적인 훈련참여를 유도하 기 위해 제공한 자극구성요소와 대응전략이 얼굴표정읽기 훈련에서 전반적인 아동의 성취도 향상에 영향을 주는 요 인으로 작용한 것으로 여겨진다.

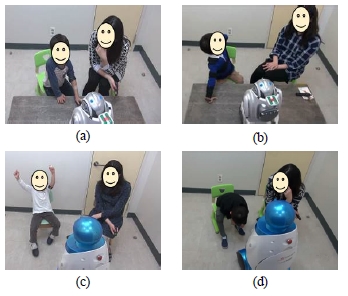

하지만, Figure 7에서 보는 바와 같이 동일한 훈련자극에 대해서 회기 진행 정도와 개인의 제한된 관심사로 인해 일 부에서는 상반된 반응을 보이는 사례들을 확인할 수 있었다.

개별 사례를 살펴보면, 다른 사람과의 눈맞춤에 어려움 을 느끼던 아이들이 로봇과의 상호작용을 통해 눈맞춤 요 청에 적극적으로 대응(Fig. 7(a))하고 로봇 동작이나 율동을 따라 하는 등 적극적인 활동 참여를 표현하였다. 하지만, 특정아동은 로봇에 대한 흥미감소로 인해 응시요청에 회 피하는 경우도 발생하였다(Fig. 7(b)). 그리고, 표정읽기 훈 련에서는 전체 참가자가 높은 정답률(평균 86.43%)을 보이 면서 적극적으로 참여했으나(Fig. 7(c)), 간혹 주의집중력이 떨어져 로봇의 질문에 제대로 대응하지 못하는 사례도 발 생하였다(Fig. 7(d)).

Scenes of children’s reactions for each training stimulation: (a) positive reaction to an eye contact request, (b) negative reaction to eye contact request, (c) positive reaction to a question about a facial expression, and (d) negative reaction to a question about a facial expression

참가자 행동을 관찰한 치료사 분석에 의하면, 일상생활 에서 자발적으로 감정을 읽어내는 표현을 하지 않던 아동 들이 로봇과의 상호작용 자체에 흥미를 가짐으로써 계획 된 훈련에 적극적으로 참여한 것으로 보이며, 참가자 중 한 아동은 실험에 참가하면서 일상생활에서도 타인의 표 정에 관심을 가지고, 이에 대해 부모에게 질문하는 모습을 보이며, 여러 가지 표정을 지어 보이는 연습을 하는 등 사 회성 행동관심의 일반화가 보고되기도 하였다.

따라서, 제안하는 행동 중재용 로봇시스템이 ASD를 가 진 아동의 자폐치료를 촉진하는데 효과적인 매개체로 활 용될 수 있음을 검증하였다. 하지만, 로봇을 향한 아동중 심의 일방적인 언어표현이나 자발적으로 대화를 시도하는 특정 행위에 대해 로봇이 적절하게 대응하지 못하는 한계 를 보이면서, 향후 Turn-taking 형태의 대화기술 훈련에 대 한 필요성을 확인하기도 하였다.

4. 결 론

본 논문에서는 ASD를 가진 아동을 대상으로 행동적 중 재를 수행하는 로봇시스템을 제시하였다. 특히, ASD를 가 진 아동의 행동 특성분석을 토대로 눈맞춤과 얼굴표정읽 기에 대한 훈련 프로그램을 구성하고, DTT이론을 바탕으 로 한 훈련강화절차와 로봇 상호작용기술을 포함하는 인 터랙션 아키텍처를 구축하였다. 그리고, 시스템 관점에서 구성된 휴먼행동의 인식성능을 검증하고 이를 이용한 체 계화된 로봇 훈련자극으로부터 임상실험에 참가한 아동의 긍정적인 반응효과를 확인함으로써, 제안한 로봇시스템이 자폐치료 개선에 효과적으로 적용 가능함을 검증하였다. 향후에는 개선된 상호작용 기술을 토대로 목표행동을 독 려하기 위한 강화물의 선정 및 제공방식에 있어 개별 아 동의 특정 관심사를 고려할 수 있는 방안을 마련할 계획 이다.

Acknowledgement

본 연구에서는 분당서울대병원의 유희정교수와 봉귀영 선생의 통찰력 있는 논의와 임상실험에 대한 협력 및 지 원에 감사드린다.

References

-

Allen, DA, “Autistic spectrum disorders clinical presentation in preschool children”, Journal of Child Neurology, (1988), 3, p48-56.

[https://doi.org/10.1177/088307388800300110]

- Center for Disease Control and Prevention, “Prevalence of autism spectrum disorder among children aged 8 years-autism and developmental disabilities monitoring network, 11 sites, United States, 2010,”, MMWR Surveillance Summaries, (2014), 63(2), p1-21.

-

Lovaas, OI, “Behavioral treatment and normal educational and intellectual functioning in young autistic children”, Journal of Consulting and Clinical Psychology, (1987), 55(1), p3-9.

[https://doi.org/10.1037/0022-006x.55.1.3]

- McEachin, JJ, Smith, T, Lovaas, OI, “Long-term outcome for children with autism who received early intensive behavioral treatment”, American J. of Mental Retardation, (1993), 97, p359-372.

-

Rogers, SJ, “Interventions that facilitate socialization in children with autism”, Journal of Autism and Developmental Disorders, (2000), 30(5), p399-409.

[https://doi.org/10.1023/a:1005543321840]

-

Odom, SL, Collet-Klingenberg, L, Rogers, SJ, Hatton, DD, “Evidence-based practices in interventions for children and youth with autism spectrum disorders”, Preventing School Failure, (2010), 54(4), p275-282.

[https://doi.org/10.1080/10459881003785506]

-

Scassellati, B, Admoni, H, Mataric, M, “Robots for use in autism research”, Annual Review of Biomedical Engineering, (2012), 14, p275-294.

[https://doi.org/10.1146/annurev-bioeng-071811-150036]

-

Cho, SH, “The effect of robots in education based on STEAM”, Journal of Korea Robotics Society, (2013), 8, p58-65.

[https://doi.org/10.7746/jkros.2013.8.1.058]

-

Kim, YA, Chae, KH, Sohn, YJ, Yang, JM, Koo, CD, “Teachers and students' recognition about learning with a humanoid robot in elementary school”, Journal of Korea Robotics Society, (2014), 9, p185-195.

[https://doi.org/10.7746/jkros.2014.9.3.185]

-

Dautenhahn, K, Werry, I, “Towards interactive robots in autism therapy: Background, motivation and challenges”, Pragmatics and Cognition, (2004), 12, p1-35.

[https://doi.org/10.1075/pc.12.1.03dau]

-

Diehl, JJ, Schmitt, LM, Villano, M, Crowell, CR, “The clinical use of robots for individuals with autism spectrum disorders a critical review”, Research in Autism Spectrum Disorders, (2012), 6(1), p249-262.

[https://doi.org/10.1016/j.rasd.2011.05.006]

-

Vismara, LA, Rogers, SJ, “Behavioral treatments in autism spectrum disorder: what do we know?”, Annual Review of Clinical Psychology, (2010), 6, p447-468.

[https://doi.org/10.1146/annurev.clinpsy.121208.131151]

-

McConnell, SR, “Interventions to facilitate social interaction for young children with autism: Review of available research and recommendations for educational intervention and future research”, J. Autism & Dev. Disorders, (2002), 32, p351-372.

[https://doi.org/10.1002/pits.20261]

-

Bass, JD, Mulick, JA, “Social play skill enhancement of children with autism using peers and siblings as therapists”, Psychology in the Schools, (2007), 44(7), p727-735.

[https://doi.org/10.1037/0012-1649.36.2.261]

-

Leekam, SR, Lopez, B, Moore, C, “Attention and joint attention in preschool children with autism”, Dev. Psychology, (2000), 36(2), p261-273.

[https://doi.org/10.1111/j.1469-7610.1989.tb00785.x]

-

Yirmiya, N, Kasari, C, Sigman, M, Mundy, P, “Facial expressions of affect in autistic mentally retarded and normal children”, Journal of Child Psychology and Psychiatry, (1989), 30, p725-735.

[https://doi.org/10.1007/s10209-005-0116-3]

-

Robins, B, Dautenhahn, K, Boekhorst, R, Billard, A, “Robotic assistants in therapy and education of children with autism can a small humanoid robot help encourage social interaction skills”, Universal Access in the Information Society, (2005), 4, p105-120.

[https://doi.org/10.1037/a0014124]

- Clark, TF, Winkielman, P, Mclntosh, DN, “Autism and the extraction of emotion from briefly presented facial expression stumbling at the first step of empathy”, Emotion, (2008), 8(6), p803-809.

- Lewis, JP, “Fast normalized cross-correlation”, Vision Interface, (1995), 10(1), p120-123.

- Zivkovic, Z, “Improved adaptive Gaussian mixture model for background subtraction”, in Proc. ICPR, (2004), 2, p28-31.

-

Stauffer, C, Grimson, WEL, “Adaptive Background Mixture Models for Real-Time Tracking”, in Proc. CVPR, (1999).

[https://doi.org/10.1109/cvpr.1999.784637]

-

Isard, M, Blake, A, “CONDENSATION conditional density propagation for visual tracking”, Int. J. Computer Vision, (1998), 29(1), p5-28.

[https://doi.org/10.1023/a:1008078328650]

-

Ojala, T, Pietikäinen, M, Harwood, D, “A Comparative Study of Texture Measures with Classification Based on Feature Distributions”, Pattern Recognition, (1996), 29(1), p51-59.

[https://doi.org/10.1016/0031-3203(95)00067-4]

- Yun, SS, Park, SK, Choi, JS, “A robotic treatment approach to promote social interaction skills for children with autism spectrum disorders”, in Proc. RO-MAN, (2014), p130-134.

-

Viola, P, Jones, MJ, “Robust real-time face detection”, International Journal of Computer Vision, (2004, May), 57(2), p137-154.

[https://doi.org/10.1023/b:visi.0000013087.49260.fb]

-

Sherwin, AC, “Reactions to music of autistic (schizophrenic) children”, American Journal of Psychiatry, (1953), 109, p823-831.

[https://doi.org/10.1176/ajp.109.11.823]

-

Zhai, J, Barreto, AB, Chin, C, Li, C, “Realization of stress detection using psychophysiological signals for improvement of human-robot interactions”, in Proc. Southeast Conf, (2005), p415-420.

[https://doi.org/10.1109/secon.2005.1423280]

-

Demetriou, A, Christou, C, Spanoudis, G, Platsidou, M, “The development of mental processing efficiency, working memory, and thinking”, Monographs of the Society for Research in Child Development, (2002), 67, p1-156.

[https://doi.org/10.1111/mono.2002.67.issue-3]