로봇 캐릭터와의 상호작용에서 사용자의 시선 배분 분석

© Korea Robotics Society. All rights reserved.

Abstract

In this paper, we develop a virtual experimental environment to investigate users’ eye gaze in human-robot social interaction, and verify it’s potential for further studies. The system consists of a 3D robot character capable of hosting simple interactions with a user, and a gaze processing module recording which body part of the robot character, such as eyes, mouth or arms, the user is looking at, regardless of whether the robot is stationary or moving. To verify that the results acquired on this virtual environment are aligned with those of physically existing robots, we performed robot-guided quiz sessions with 120 participants and compared the participants’ gaze patterns with those in previous works. The results included the followings. First, when interacting with the robot character, the user’s gaze pattern showed similar statistics as the conversations between humans. Second, an animated mouth of the robot character received longer attention compared to the stationary one. Third, nonverbal interactions such as leakage cues were also effective in the interaction with the robot character, and the correct answer ratios of the cued groups were higher. Finally, gender differences in the users’ gaze were observed, especially in the frequency of the mutual gaze.

Keywords:

Human-Robot Social Interaction, Social Eye Gaze, Eye Tracking, Robot’s Facial Expression1. 서 론

최근 개인 서비스 로봇이 확산되면서 훈련받지 않은 일반 인 로봇 사용자가 크게 증가하는 추세이며, 로봇 개발자들은 이에 대응하고자 마치 사람과 사람 사이의 의사소통처럼 자연 스러운 로봇과의 상호작용을 구현하는 것에 도전하고 있다. 사람 사이의 의사소통은 주로 언어를 통해 이루어지지만 대면 상황에서는 시선(eye gaze)이나 제스처(gesture)와 같은 비언 어적(nonverbal) 상호작용도 상당한 부분을 차지한다. 따라서 물리적인 접촉을 통해 서비스하는 것이 아니라 사회적 상호작 용(sHRI: human-robot social interaction)을 하는 로봇에 있어 서는 언어 못지않게 시선이 중요한 의사소통 요소가 된다. 또 한, 상호작용의 양방향성을 고려할 때, 로봇은 사람의 시선을 인지할 수 있어야 하며, 동시에 로봇은 상황과 의도에 따라 적 절하게 로봇 자신의 시선을 표현할 수도 있어야 한다. 이 중에 서 후자의 연구분야 즉, 로봇의 시선 표현에 대한 연구는 가상 에이전트(virtual agent)를 만드는 그래픽스 분야에서 먼저 발 달하였으며, 1990년대 말부터 로봇 연구자들, 특히 HRI (human-robot interaction) 커뮤니티에서 관심을 갖기 시작하였 다[1]. 그래픽스로 만드는 가상 캐릭터의 시선은 비현실적이고 과장된 방법으로 감정이나 의도를 표현할 수 있는 반면에, 모 터를 이용하여 실제 로봇의 눈을 제어할 때에는 물리적인 제 약이 따른다는 차이가 있다. 그러나 가상 캐릭터분야와 로봇 분야는 공통적인 목적, 즉, 사용자의 주의(attention)를 끌고, 관 심을 유지시키며(engagement), 상호작용을 풍부하게 만들기 위하여 시선 표현을 활용하고 있다는 점에서 다수의 결과를 상호 참조하며 발전하고 있다[1,2].

한편 로봇이 사용자의 시선에 적절히 반응하려면 상호작용 동안에 사람의 시선을 인식하여야 하는데, 전문적인 시선추적 기(eye tracker)는 일상적으로 활용하기에 상당히 고가라는 문 제가 있다. 이에 대한 합리적인 대안으로, 시선을 비교적 잘 반 영하고 있는 머리의 자세(head pose)를 이용하여 시선을 추정 하는 방법이 보편적으로 사용되어 왔으며[3], 최근에는 눈의 영 상으로부터 시선을 직접 계산하는 방법도 발전하고 있다[3-5]. 그러나 일반 카메라 영상을 이용한 시선 인식의 정확도 (accuracy) 및 분해능(resolution)에는 한계가 있으므로, 이런 방식은 주로 정교한 검출이 필요하지 않은 응용, 예를 들어 좌 우로 구분된 사물이나 사람 중 어느 쪽을 바라보는가를 판단 하는 시나리오에 사용되고 있다.

본 논문에서는 일반 카메라 기반의 방식보다 정교한 시선 검출이 가능하면서도 일상적 활용이 가능한 보급형 시선추적 센서를 이용하여 사용자가 로봇과 상호작용하는 동안에 사용 자가 로봇의 눈이나 입과 같은 세부적 신체 단위를 얼마 동안 응시하는지를 분석하고자 한다. 다만, 로봇이 움직이는 동안 에도 효과적으로 세부 신체 단위까지 시선을 구분하기 위하 여, 실제 로봇이 아닌 로봇의 디지털 모델을 활용하여 실험을 진행한다. 가상 공간의 로봇을 활용하는 이 연구 환경이 심화 된 sHRI 연구주제를 다루기에 적절한지를 확인하기 위하여, 본 논문은 기존 상호작용 연구의 대표적인 결과들을 확인하면 서 그 결과들에 포함된 시선 데이터를 분석하는 사전연구의 성격으로 진행하고자 한다.

sHRI의 맥락에서 의미를 갖는 대표적 시선의 유형은 다음 과 같다[1].

- 마주보기(mutual gaze) 또는 눈맞추기(eye contact): 서로의 눈이나 얼굴을 마주하여 바라보는 것으로 한 쪽이 일방적으 로 쳐다보는 것은 해당되지 않음.

- 눈으로 지시하기(referential gaze, deictic gaze): 공간 상의 물 체나 위치를 직접 바라보는 방법으로 가리키는 것으로, “저 사과 좀 봐!” 등 언어적 지시와 함께 사용하기도 함.

- 함께 보기(joint attention): 두 사람 이상의 시선이 하나의 물 체에 동시에 집중되어 있는 상태로, 보통 한 사람이 특정 사물 을 쳐다보거나 가리킬 때, 다른 한 쪽이 해당 시선의 방향으로 관심을 돌려 같은 사물을 바라보는 과정을 거침.

- 시선 피하기(gaze aversions): 주된 시선의 방향으로부터 다 른 쪽으로 시선을 옮기는 것으로, 예를 들면, 말을 하다가 상 대에게 대화의 주도권을 넘겨주고자 하는 의도를 표현하려 고 눈을 아래로 향하는 것이 이에 해당됨.

본 논문에서는 상호작용 과정에서 가장 빈번히 발생하는 시선 유형인 ‘눈맞추기’ 및 ‘눈으로 지시하기’가 포함된 OX 퀴 즈 시나리오를 구현하고 선행연구들에서 다루어진 주요 문제 들을 다루고자 한다. OX 퀴즈는 사용자와 로봇 캐릭터간의 1:1로 진행하였다. [6]과 [7]에서 선행연구를 정리한 바에 따르 면, 평균적으로, 말하는 이는 듣는 사람의 얼굴을 40% 정도 바 라보는 경향이 있고, 듣는 사람은 말하는 사람의 얼굴을 75% 정도 보는 경향이 있으며, 특히 ‘눈맞추기’는 약 30%를 차지한 다고 한다. 이러한 결과를 로봇과의 상호작용에서 비교하기 위하여 본 논문에서는 로봇 캐릭터가 지속적으로 ‘눈맞추기’ 를 시도할 때, 사용자의 시선이 로봇의 어느 신체 단위(눈, 입, 몸통 등)을 향하는지를 분석한다. 특히, 향후 로봇 및 sHRI 디 자인에 반영할 수 있도록 얼굴 애니메이션 유무에 따라 구체 적으로 시선이 머무는 위치의 차이도 분석한다.

한편, [8] 및 [9] 등에서는 로봇이 ‘눈으로 지시하기’를 이용 하여 힌트를 주거나 정보를 누설하는 동작이 사람과 사람 사 이의 상호작용에서와 같이 사용자가 답을 잘 찾는 데에 유효 하게 작동한다는 결과를 보고하고 있다. 이는 로봇의 시선이 사람의 시선과 달리 사람의 반사적인 반응을 유도하지 못한다 는 결과[10]와 일부 상충되어 흥미로운 연구주제가 되고 있다. 본 논문에서도 이 주제를 다루고자 하며, 이를 위해 로봇이 퀴 즈를 낸 후 소극적인 ‘눈으로 지시하기’ 동작으로 힌트를 주게 한 후에 이런 제스처가 사용자의 반응을 유도하는가에 대한 효과를 분석한다.

본 논문의 구성은 다음과 같다. 먼저 2장에서는 전술한 연 구문제를 다루기 위한 실험의 설계를 제시하며, 3장에서 시선 데이터에 대한 정량적 분석 결과를 요약한다. 마지막으로 4장 에서는 결론과 함께 향후 연구 방향을 제안한다.

2. 연구 방법

본 논문에서는 탐색하려는 바는 다음과 같다. 첫째, 로봇 캐 릭터와 상호작용할 때 사용자가 시선을 두는 방법은 사람 사 이의 상호작용에서와 유사한가? 둘째, sHRI 설계에서는 로봇 의 얼굴에도 많은 자원을 투자하고 있는데[11], 동적인 얼굴, 즉, 눈과 입을 움직여 의도나 감정을 표현할 수 있는 얼굴의 경우, 고정된 얼굴에 비하여 시선을 유도하는 데에 차이를 보이는 가? 셋째, 눈짓으로 힌트를 주는 것과 같이 사람 사이에서 통 용되는 사회적 상호작용이 로봇 캐릭터와의 상호작용에서도 유효한가? 마지막으로, 상호작용 연구에서는 문화적 배경이 나 성별에 따른 차이가 보고되고 있는데, 설계된 실험에서 남 성과 여성의 반응에 유의한 차이가 있는가?

이들 질문을 검증하는 실험의 진행을 위해, 본 연구실에서 개발한 소셜 로봇 MOCCA (My Own Cognitive Communication Agent)의 3D 모델을 이용하여 가상 트윈(virtual twin)을 구현 하고, MOCCA가 사용자를 대상으로 OX 퀴즈를 진행하는 동 안 사용자의 시선이 응시하는 로봇의 신체 부위를 [Fig. 1]과 같이 구분하여 기록한다. 사용자의 시선 검출은 합리적인 비 용으로 구매할 수 있는 게임용 시선추적기 ‘Tobii Eye Tracker 4C’[12]를 이용한다. 사용자의 시선을 효과적으로 추적하더라 도 로봇이 움직이고 있는 상황이라면, 로봇의 움직임을 반영 하여 응시하는 신체 부분을 대응시키기 어렵다. 그러나 가상 공간의 로봇을 이용하면 이 작업을 효과적으로 진행할 수 있 다는 장점이 있다. 로봇의 각 부위를 [Fig. 1]에 보인 바와 같은 투명한 3D 다면체 콜라이더(polygon collider)로 감싸고 이들 과 시선 모델간의 충돌을 검출함으로써, 로봇이 움직이는 상 황에서도 눈 , 입 , 손 등을 구분하여 저장할 수 있다.

다음은 본 논문에서 비교하고자 하는 요인들과 이를 관측하 기 위해 설계한 콘텐츠에 대하여 설명한다. 첫째는 표정 애니 메이션의 영향 분석으로, 로봇의 얼굴 변화에 따라 사용자의 시선 분포가 달라지는지 검증하고자 한다. 이를 위해 눈과 입에 고정된 이미지를 사용하는 유형과, 눈과 입의 움직임을 간단한 애니메이션으로 표현할 수 있는 두 가지 유형으로 구분하여 준 비한다. 두 번째, 비언어적 표현과 그 영향 및 효과 분석을 위해 서는, 로봇이 말로 퀴즈를 낸 직후 시선을 이용하여 짧게 힌트 를 주는 ‘눈으로 지시하기’ 동작을 추가한다. 이 때, 눈 애니메 이션이 가능한 유형의 경우에는 눈동자를 돌려 정답 쪽을 짧게 쳐다보도록 하지만, 표정이 고정되어 있는 로봇의 경우 눈짓을 할 수 없으므로 머리를 짧게 움직여 정답 쪽을 가리키게 한다.

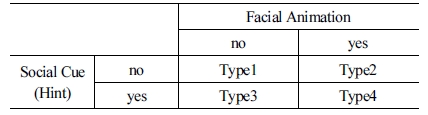

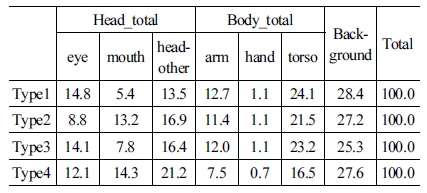

표정 애니메이션 포함 여부에 따라, 그리고 힌트 동작의 포 함 여부에 따라 [Table 1]에 보인 바와 같이 총 4가지 유형의 콘 텐츠를 준비하여 비교한다. [Fig. 2]에는 눈동자의 크기 변화를 이용한 간단한 눈 애니메이션이 제시되어 있으며, [Fig. 3]에는 입을 벌렸다가 다무는 간단한 립싱크(lip synchronization) 애 니메이션이 제시되어 있다. 또, 시선을 유추할 수 있는 머리를 이용하여 정답 쪽을 가리켜 힌트를 주는 ‘Type3’의 동작과, 눈 동자를 움직여 눈짓으로 힌트는 주는 ‘Type4’의 동작은 [Fig. 4] 에서 볼 수 있다.

3. 실험 결과

실험의 진행을 위하여 [Table 2]에 보인 바와 같이 유형별 30명씩, 총 120명의 대학생을 섭외하여 각각 5문제씩 똑같은 OX 퀴즈를 풀게 하였으며, 퀴즈를 푸는 상호작용동안 30Hz 속도로 모니터 위의 시선 좌표 및 로봇의 해당 부위를 기록하 였다. [Fig. 5]는 실험을 진행하는 모습을 보여준다.

3.1 상호작용 유형별 시선 배분 특성

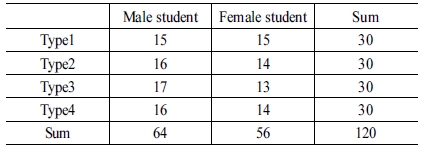

퀴즈를 푸는 동안 사용자가 정답을 선택하기 위하여 ‘O’나 ‘X’ 버튼을 바라 본 시간, 즉 사용자가 발화자(speaker)의 입장 이었던 기간을 제외하고, 사용자가 문제를 듣거나 로봇의 정 답 해설을 듣는 청취자(listener) 역할을 수행한 시간 동안 유형 별 시선의 평균 배분 비율을 [Table 3]에 요약하였다. 분석에서 정답을 선택하는데 소요된 시간을 제외한 이유는 다음과 같 다. 본 실험에서는 말로 답하는 대신 ‘O’나 ‘X’ 버튼을 바라보 는 방법으로 답을 선택하도록 구현하였는데, 해당 시간동안 사용자는 로봇을 보지 않고 버튼을 바라보기 때문에 이를 상 호작용 시선 데이터에 포함시키는 것은 불합리하다. 개인별 차이를 최소화하고 유사한 조건에서 비교분석하기 위해서는 로봇이 말하는 시간만을 분석 대상으로 하는 것이 적절하다고 판단된다.

상호작용 유형별로 시선을 배분하는 비율의 차이가 통계적 으로 유의한지 검증하기 위하여 SPSS를 이용하여 일원분산 분석(One-way ANOVA)을 시행하였다. 먼저 응시 대상을 크 게 세 부분, 즉 얼굴 주변(head_total), 몸체 주변(body_total), 그 리고 로봇이 아닌 배경(background)으로 단순화하여 구분하 고, 각 부분을 바라본 비율을 분석하여 [Fig. 6]에 제시하였다. Type4 (mean=47.6)에서 얼굴 주변을 응시한 비율이, 표정이나 힌트가 없는 Type1 (mean=33.7)보다 통계적으로 유의하게 (p = 0.060) 높은 것으로 나타났다. 이는 로봇이 주는 힌트를 보 기 위해 눈 주변을 자주 주목한 때문으로 판단된다. 이 점은 몸 체를 응시한 비율에도 반대로 반영되었는데, Type4의 경우 상 대적으로 얼굴을 오래 응시했기 때문에, Type1보다도 몸체를 응시한 비율이 낮으며(p=0.007), Type3보다도 낮게(p=0.022) 나타났다. 한편, 로봇을 응시하지 않은 비율, 즉 배경을 바라 본 비율에서는 각 유형별 유의한 차이가 없었다.

![[Fig. 6] [Fig. 6]](/xml/26141/JKROS-14-74_F6.jpg)

Mean gaze distribution toward three major target areas. A single asterisk indicates significant differences (p < 0.1), a double asterisk indicates (p < 0.05).

[Fig. 7]은 [Fig. 6]에서 첫 번째 그룹에 보인 얼굴 부위를 중 심으로 상세한 분석 결과를 보여준다. 눈을 응시한 비율은 모 든 유형 사이에서 통계적으로 유의한 차이가 없었지만, 입을 응시한 비율에서는 통계적으로 유의한 차이가 나타났다. 립싱 크 애니메이션이 있는 Type2 및 Type4 모두가 입이 고정되어 있는 Type1 및 Type3에 비하여 p<0.05 로 많은 시선을 받았다. 이는 로봇의 얼굴 표정이 주목(attention)을 끄는 데에 효과적 이며, 따라서 sHRI의 맥락에서 표정의 설계는 상당히 중요한 요소임을 나타낸다고 할 수 있다. 한편 이번 실험에서 눈의 경 우에 응시 비율에서 유의한 차이가 없었는데, 눈동자의 크기 만을 약간 조정하는 애니메이션을 유효한 눈의 표현으로 인지 하지 않은 것으로 해석할 수 있다. 또한, 눈짓으로 힌트를 주는 Type4의 경우만 Type1보다 통계적으로 유의하게(p = 0.007) 얼굴 응시 비율이 높은 것으로 나타났다. Type4의 경우 힌트 를 주는 눈짓을 보기 위해 눈 주변을 집중적으로 쳐다 본 반면, 머리를 움직여 힌트는 주는 Type3의 경우 상대적으로 동작이 커서 다른 곳을 응시해도 쉽게 시야에 들어오고, 이로 인해 머 리 주위에 시선이 집중되는 현상이 없었던 것으로 판단된다.

![[Fig. 7] [Fig. 7]](/xml/26141/JKROS-14-74_F7.jpg)

Mean gaze distribution around the head. A double asterisk indicates significant differences (p < 0.05), a triple asterisk indicates (p < 0.01).

[Fig. 6]의 결과를 사람 사이의 상호작용을 언급한 선행연구[6,7] 와 비교하는 것도 매우 흥미롭다. 이번 실험에서 사용자가 배경 이 아닌 로봇을 바라 본 전체 평균 비율은 72.9% 로, 듣는 사람 은 약 75% 정도 동안 말하는 사람을 바라본다는 결과와 유사 하다. 또, 힌트를 보기 위해 얼굴을 많이 쳐다 본 Type4를 제외 하면 약 37.0% 동안 얼굴 부분을 바라보았는데, 로봇은 말하 는 동안 계속 사용자를 응시하고 있었으므로, 이 시간이 ‘눈맞 추기’에 해당된다. 선행연구[7]에서 ‘눈맞추기’ 시간을 약 30% 로 언급한 것과 맥락을 같이 한다고 판단할 수 있다. 이러한 기 초 결과를 통하여, 로봇 캐릭터와의 상호작용이 사람 사이의 상호작용과 유사한 특성을 보이고 있으며, 이 결과를 실제 로 봇과의 상호작용에 확장하여 해석할 수 있다는 가능성을 확인 하였다.

3.2 힌트를 주는 소셜 큐(social cue) 효과 분석

힌트와 같은 사회적 상호작용의 효과는 객관적인 성취도로 측정하는 것이 일반적이므로, 본 논문에서도 [Fig. 8]과 같이 각 퀴즈의 정답률을 분석하였다. 실험에서 사용한 힌트의 표 현이 짧고 작은 움직임이었고, 힌트가 나오기도 전에 이미 답 을 정한 후 시선을 OX 버튼 쪽으로 옮긴 경우도 많았기 때문 에, 힌트를 알아차렸다는 응답은 Type3의 경우 2.6/5.0, Type4 의 경우 2.4/5.0로 높지 않았다. 그럼에도 불구하고 4번 및 5번 문제에서 힌트가 포함된 Type3 및 Type4의 정답률이 통계적 으로 유의하게(p<0.05) 높았다. 퀴즈의 후반후로 가면서 힌트 의 존재를 인지한 비율이 높아져서 힌트를 따라 응답한 결과 로 해석된다. 이는 시선으로 힌트를 준 선행연구들[8,9]에서 성 취도가 높아진 것과 일치한다.

3.3 성별에 따른 시선 특성 분석

본 실험은 로봇이 ‘눈맞추기’를 시도하는 동안 사용자의 시 선을 분석하는 것으로 해석할 수 있는데, 성별에 따라 응시하 는 패턴의 차이가 매우 현저하게 나타났다. 얼굴, 몸체, 배경의 세 부분으로 나눈 분석에서, 로봇을 보지 않고 배경을 응시한 비율에는 남녀 간 유의한 차이가 없었다. 그러나 [Fig. 9]에 보 인 바와 같이 여성(mean=47.1)은 남성(mean=33.1)보다 얼굴 부분을 유의하게 (p<0.01)많이 응시하였으며, 남성은 몸체를 많이 응시한 것으로 나타났다. 이를 세부적으로 분석한 [Fig. 10] 을 보면 여성(mean=17.8)이 눈을 응시한 비율은 남성(mean= 7.8) 대비 두 배가 넘어, 남성이 로봇의 눈을 직접 응시하는 데 에 특히 어색함을 나타낸 것을 알 수 있다.

![[Fig. 9] [Fig. 9]](/xml/26141/JKROS-14-74_F9.jpg)

Comparison of mean gaze distribution between gender: three major target areas. A double asterisk indicates significant differences (p < 0.05), a triple asterisk indicates (p < 0.01).

4. 결 론

본 논문에서는 시선추적 센서와 로봇 캐릭터의 3D 모델을 이용하여 로봇 캐릭터와 상호작용하는 동안 사용자의 시선을 세부적으로 분석하였다. 결과를 요약하면 다음과 같다. 첫째, 로봇 캐릭터와 상호작용할 때 사용자가 시선을 두는 패턴은 사람 사이의 대화 상황 통계와 유사한 비율을 나타냈다. 둘째, 표정이 없는 얼굴에 비하여 립싱크 하는 입에 더 오래 시선이 머물러, 상호작용 설계에서 로봇 표정의 역할을 확인할 수 있 었다. 셋째, 눈짓이나 고개로 힌트를 주는 비언어적 상호작용 이 로봇 캐릭터와의 상호작용에서도 유효하여, 힌트를 받은 그룹의 정답률이 상승하였다. 마지막으로, 성별에 따른 차이 가 현저하게 나타났는데, 남성이 로봇의 얼굴을 응시하는 비 율은 여성보다 통계적으로 유의하게 낮았으며, 특히 눈을 응 시한 비율은 여성의 절반 이하로 큰 차이를 보였다.

향후의 연구에서는 이번 실험에서 유의성을 찾지 못한 눈 의 애니메이션 유형을 수정하여 유의한 패턴을 확인하고, 말 과 표정의 동기화 또는 타이밍에 영향을 받는 예민한 상호작 용을 다루어 보고자 한다. 또한, 지속시간이 긴 콘텐츠를 통해, 비언어적 상호작용을 나눈 경험이 로봇에 대한 호감이나 사용 의도 등에 미치는 영향을 분석하고자 한다.

References

-

H. Admoni and B. Scassellati, “Social Eye Gaze in Human-Robot Interaction: A Review,” Journal of Human-Robot Interaction, vol. 6, no. 1, pp. 25-63, May, 2017.

[https://doi.org/10.5898/JHRI.6.1.Admoni]

-

K. Ruhland, C. E. Peters, S. Andrist, J. B. Badler, N. I. Badler, M. Gleicher, B. Mutlu, and R. McDonnell, “A Review of EyeGaze in Virtual Agents, Social Robotics and HCI: Behaviour Generation, User Interaction and Perception,” Computer Graphics Forum, vol. 34, no. 6, pp.299-326, Sept., 2015.

[https://doi.org/10.1111/cgf.12603]

-

O. Palinko, F. Rea, G. Sandini, and A. Sciutti, “Robot Reading Human Gaze: Why Eye Tracking Is Better Than Head Tracking for Human-Robot Collaboration,” 2016 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), Daejeon, Korea, Oct., 2016.

[https://doi.org/10.1109/IROS.2016.7759741]

-

A. George and A. Routray, “Real-time Eye Gaze Direction Classification using Convolutional Neural Network,” 2016 Int'l Conf. on Signal Processing and Communications, Bangalore, India, Nov. 2016.

[https://doi.org/10.1109/SPCOM.2016.7746701]

-

S. Sheikhi, V. Khalidov, D. Klotz, B. Wrede, and J.-M. Odobez, “Leveraging the Robot Dialog State for Visual Focus of Attention Recognition,” 15th ACM Int'l Conf. on Multimodal Interaction, Sydney, Australia, Dec., 2013.

[https://doi.org/10.1145/2522848.2522881]

-

R. Vertegaal, R. Slagter, G. van der Veer, and A. Nijholt, “Eye Gaze Patterns in Conversations: There is More to Conversational Agents Than Meets the Eyes,” SIGCHI Conference on Human Factors in Computing Systems, Seattle, USA, pp. 301-308, 2001.

[https://doi.org/10.1145/365024.365119]

-

.

[https://doi.org/10.1145/2882970]

-

B. Mutlu, F. Yamaoka, T. Kanda, H. Ishiguro, and N. Hagita, “Nonverbal Leakage in Robots: Communication of Intentions through Seemingly Unintentional Behavior,” 4th ACM/IEEE Int'l Conference on Human Robot Interaction, La Jolla, California, USA, pp 69-76, 2009.

[https://doi.org/10.1145/1514095.1514110]

-

E. Mwangi, E. I. Barakova, M. Diaz-Boladeras, A. C. Mallofre, and M. Rauterberg, “Directing Attention Through Gaze Hints Improves Task Solving in Human-Humanoid Interaction,” International Journal of Social Robotics, vol. 10, no. 3. Pp 343-355, Jun., 2018.

[https://doi.org/10.1007/s12369-018-0473-8]

- H. Admoni, C. Bank, J. Tan, M. Tonevaand, and B. Scassellati, “Robot gaze does not reflexively cue human attention,” 33rd Annual Conference of the Cognitive Science Society, pp.1983-1988, 2011.

- E. Ackerman, IEEE Spectrum, “What People See in 157 Robot Faces,” [Online], https://spectrum.ieee.org/automaton/robotics/humanoids/what-people-see-in-157-robot-faces, Accessed: Jun. 1, 2018.

- Tobii Gaming, “Tobii Eye Tracker 4C,” [Online], https://tobiigaming.com/product/tobii-eye-tracker-4c/, Accessed: Nov. 1, 2018.

2012 한성대학교 정보통신공학과(학사)

2012~2014 유니티 테크놀로지스 필드 엔지니어

2014~2017 IT 컨설턴트

2018~현재 한성대학교 교육로봇연구소 선임 연구원

관심분야: 컴퓨터 그래픽스, GUI 기반 프로그래밍, 로봇 교육

![[Fig. 1] [Fig. 1]](/xml/26141/JKROS-14-74_F1.jpg)

![[Fig. 2] [Fig. 2]](/xml/26141/JKROS-14-74_F2.jpg)

![[Fig. 3] [Fig. 3]](/xml/26141/JKROS-14-74_F3.jpg)

![[Fig. 4] [Fig. 4]](/xml/26141/JKROS-14-74_F4.jpg)

![[Fig. 5] [Fig. 5]](/xml/26141/JKROS-14-74_F5.jpg)

![[Fig. 8] [Fig. 8]](/xml/26141/JKROS-14-74_F8.jpg)

![[Fig. 10] [Fig. 10]](/xml/26141/JKROS-14-74_F10.jpg)