무인 지상 로봇의 실시간 원격 제어를 위한 3차원 시각화 시스템

© Korea Robotics Society. All rights reserved.

Abstract

In the midst of disaster, such as an earthquake or a nuclear radiation exposure area, there are huge risks to send human crews. Many robotic researchers have studied to send UGVs in order to replace human crews at dangerous environments. So far, two-dimensional camera information has been widely used for teleoperation of UGVs. Recently, three-dimensional information based teleoperations are attempted to compensate the limitations of camera information based teleoperation. In this paper, the 3D map information of indoor and outdoor environments reconstructed in real-time is utilized in the UGV teleoperation. Further, we apply the LTE communication technology to endure the stability of the teleoperation even under the deteriorate environment. The proposed teleoperation system is performed at explosive disposal missions and their feasibilities could be verified through completion of that missions using the UGV with the Explosive Ordnance Disposal (EOD) team of Busan Port Security Corporation.

Keywords:

Teleoperation, 3D Reconstruction, UGV, EOD Robot1. 서 론

지진 또는 방사능 유출로 인해 재난이 발생한 환경에서의 탐색 및 구조 임무와 전세계적으로 발생하고 있는 테러의 가 장 큰 위험 요소인 폭발물에 대한 탐지 및 제거에 사람이 투입 된 임무수행에는 인명 손실 등의 위험이 따른다. 이러한 인명 손실을 줄이기 위해 사람 대신 지상에서 운용 가능한 형태의 무인 로봇(Unmanned Ground Vehicle, UGV)을 투입하여 탐색 및 구조임무에 활용하고자 하는 연구가 많은 연구자들에 의해 진행되고 있다[1–3].

이러한 UGV에는 주변 환경 정보 획득을 위한 여러 대의 카 메라가 장착되어 있으며 카메라의 영상을 보며 UGV의 제어 및 임무를 수행한다. 그러나 제한된 시점으로 인해 원격 작업 자는 한정된 영역만 관찰할 수 있으며 이미 지나간 영역에 대 한 정보를 확인할 수 없으므로 원격 작업자의 기억에 의존하 여 임무를 수행하거나 다시 이전 위치로 되돌아 가야만 한다. 또한 로봇의 크기와 위치 및 자세 정보의 확인에 어려움이 따 르므로 로봇과 로봇 주위 환경과의 연관 관계를 확인하는데 많은 제약이 따른다. 특히 여러 대의 카메라를 관찰하며 임무 를 수행할 경우 원격 작업자의 집중력과 작업 수행 효율이 떨 어질 수 있다[1,4].

따라서 카메라 영상의 제약을 극복하고 효율적인 원격 제 어를 위해 3차원 공간 정보를 활용하는 연구가 진행되고 있다 [5–7]. 점(Point)으로 구성된 점군(Point Cloud) 형태의 3차원 공 간 정보는 레이저 스캐너 및 키넥트 센서와 같은 3차원 공간 센서를 통해 획득할 수 있으며 정합(Registration)을 통해 하나 의 기준 좌표계로 표현함으로써 3차원 공간 정보를 재구성할 수 있다[8]. 또한 3차원 공간 정보는 환경에 대한 실측 정보를 가지고 있으므로 GPS를 사용하지 못하는 실내환경에서도 로 봇의 위치 및 자세 정보를 획득할 수 있다.

레이저 스캐너는 2차원 라인 스캐너와 2차원 라인 스캐너 가 여러 개 적층된 3차원 스캐너로 구분된다[9,10]. 2차원 라인 스캐너를 통해 공간의 한 라인에 대한 실측 정보를 획득할 수 있으며 2차원 라인 스캐너를 임의의 회전축을 중심으로 회전시켜 3차원 정보를 획득할 수 있으나 대상물이 이동할 경우 정확한 데이터의 획득에 어려움이 있다. 3차원 스캐너 의 경우 채널 수에 따라 공간의 라인 스캔 정보를 실시간으 로 획득할 수 있으나 라인 사이의 간격이 넓으므로 넓은 환 경이나 큰 구조물의 판별에는 적합하나 작은 물체에는 적합 하지 않다.

따라서 동적인 환경 정보 획득을 위해 UGV 정면에 키넥트 센서를 장착하여 작업 대상물의 조작 상태와 같은 동적인 환 경 정보를 실시간으로 확인하도록 하였다. 레이저 스캐너로부 터 획득한 정적인 환경 정보와 동적인 환경 정보가 중복되어 출력되는 것을 방지하기 위해 GPU 프로그래밍을 통한 필터링 을 수행하였다[11]. 3차원 공간 정보에 기반한 원격 제어 시 UGV의 3차원 모델 정보를 함께 시각화함으로써 UGV와 주변 작업 환경 정보를 다양한 시점에서 관찰할 수 있다. UGV의 위 치 및 자세는 실시간으로 계산되어 UGV의 3차원 모델에 반영 되므로 안전한 경로 계획 및 장애물 회피를 통한 효율적인 임 무 수행이 가능하다. 본 연구를 통해 3차원 융합정보에 기반한 무인 지상 로봇의 실시간 원격 제어를 수행하였으며 부산항보 안공사의 폭발물 처리팀과의 폭발물 제거 훈련을 통해 제안하 는 방식을 검증하였다.

2. 관련 연구

2.1 UGV 원격제어를 위한 환경인식 기술

UGV 원격제어의 환경인식을 위해서 카메라가 많이 활용 되어 왔다. 최근 작은 크기에 화질이 뛰어난 카메라가 많이 출 시되어 로봇에 활용하기가 용이해졌다. 카메라의 영상정보는 원격지 상황을 운용자가 이해하기에는 좋지만 원격의 로봇에 명령을 내려 제어하기 위해 필요한 공간에 대한 정보를 제공 하기에 한계가 있다. 3차원 환경 정보 획득을 위해 스테레오 카메라를 활용한 사례도 있으나 공간정보 추출에 대한 많은 연산으로 인한 실시간 처리 문제, Field Of View (FOV)의 한계 및 생성된 3차원 정보의 낮은 정밀도 등과 같은 문제로 넓은 지역에서 원격으로 로봇을 주행하고 작업을 수행하기에 어려 움이 많은 것으로 알려져 있다[12-14].

로봇의 원격 제어에 작업 환경의 공간 정보를 활용하기 위 하여 LiDAR와 같은 3차원 센서를 이용한 연구도 있다[15]. 이 러한 센서를 사용할 경우 넓은 범위의 3차원 정보 획득이 가 능하다. LiDAR를 이용하여 3차원 정보를 얻는 방식은 2차원 센서를 회전하여 3차원 정보를 얻거나 3차원 센서를 통해 직 접 3차원 공간 정보를 획득할 수 있다. 2차원 센서를 회전할 경우 정밀한 3차원 정보 획득이 가능하나 실시간으로 변화 하는 환경정보에 대응이 어려운 문제가 있으며 3차원 센서 는 실시간으로 환경 정보를 얻기 위해 스캔 라인들의 간격이 넓게 설계되어 작은 물체나 가까이 있는 환경 정보의 식별이 어렵다.

2차원 레이저 센서를 회전할 경우 공간을 스캔하는 동안 로봇이 고정된 위치에 있어야 하며 이렇게 획득한 정보는 Iterative Closest Point (ICP) 알고리즘을 통해 넓은 지역에 대 한 정밀한 지도 작성이 가능하다[8]. ICP 알고리즘 외에도 M.Bosse[16]의 알고리즘은 대응되는 두 3차원 점들을 규정하 는 특징 벡터를 다수 사용함으로써 실내 및 실외 환경에서의 지도 작성이 가능하다. 그러나 대응되는 두 점들의 집합을 찾 을 때 연산 시간이 오래 걸리므로 실시간 연산에 어려움이 있 다. J.Zhang[17]은 공간의 모서리와 평면의 두 가지 특징을 이 용하여 실내 및 실외 공간에서 실시간 지도 작성을 수행하였 으며 K.Lee[18]는 실내 공간에서 획득 가능한 특징을 이용하여 실내 공간에 대한 3차원 지도 작성에 대한 연구를 수행하였으 나 M.Bosse의 알고리즘이 포함되어 있으므로 실시간 연산에 어려움이 있다.

환경의 3차원 정보는 X, Y, Z형식을 갖는 점들의 집합인 점 군 형태의 데이터로 구성되어있다. 이러한 점군 데이터는 OpenGL이나 Direct3D를 통해 가상의 3차원 공간에 출력할 수 있으며 다양한 시점으로 변경하여 출력된 결과를 관찰할 수 있다. 그러나 로봇 주위의 환경 관찰을 위해 가까운 시점으로 이동할수록 점들 사이의 빈 공간이 점점 커지므로 환경과 물 체의 식별에 어려움이 발생한다. 따라서 점군 데이터로부터 메쉬를 생성하고 환경의 이미지 정보를 융합하여 재구성 (Reconstruction)하는 연구가 진행되었다[19]. 메쉬의 생성은 Poisson Reconstruction 알고리즘[20]과 Ball Pivoting 알고리즘 [21]등을 적용할 수 있으나 입력되는 점군 데이터의 개수가 많 아질수록 긴 연산 시간이 소요된다. 많은 점군 데이터에 대한 연산 시간을 줄이기 위해 General-Purpose computing on Graphics Processing Units (GPGPU)를 적용한 알고리즘을 사용하거나 지오메트리 셰이더(Geometry Shader)를 적용하여 실시간으로 메쉬를 생성할 수 있다. 그러나 이는 하드웨어 성능에 크게 영 향을 받으므로 제한된 하드웨어 자원을 갖는 로봇 시스템에 이를 적용하기에는 어려움이 있다[22–24].

2.2 제안하는 방법

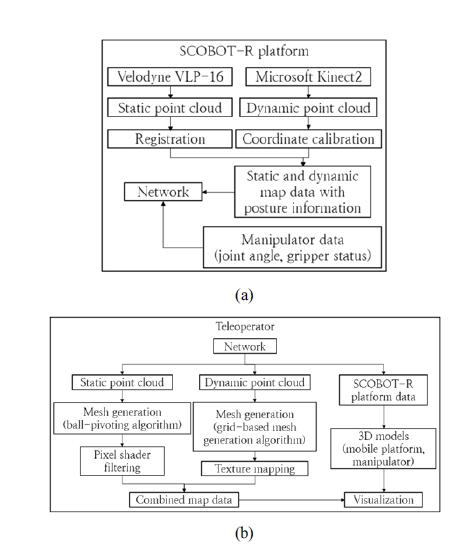

본 논문에서는 3차원 레이저 센서와 키넥트 센서로부터 획 득한 환경의 3차원 정보와 UGV의 3차원 모델과 융합함으로 써 무인 지상 로봇의 원격제어에 적용하는 3차원 정보 융합 기 술을 제안한다. [Fig. 1]은 제안하는 3차원 정보 융합 기술의 모 식도를 보여준다.

Block diagram of 3D based teleoperation process. (a) Environmental data acquisition process (b) 3D data visualization process

레이저 센서로부터 획득한 3차원 환경 정보는 실내 및 실 외 지형과 구조물 등의 정적인 환경 정보를 획득하며 키넥트 센서로부터 획득한 3차원 환경 정보는 로봇의 주행 시 발생할 수 있는 환경 변화 및 로봇 팔을 이용한 작업 시 작업 대상물 정보 등의 환경 정보를 획득한다. 레이저 센서로부터 획득한 정적인 환경 정보는 3차원 매핑 알고리즘[25]에 의해 서로 다 른 위치에서 얻은 정보가 하나의 기준 좌표계로 통합된다. 이 러한 환경 정보의 시각화를 위해서는 메쉬 정보가 필요한데 제안하는 시스템에서는 UGV의 원격조종을 위한 주변 5 m x 5 m면적에 대해서만 Ball-Pivoting 알고리즘을 적용함으로써 제한된 컴퓨팅 자원을 가진 로봇 시스템에서도 이를 실현할 수 있게 된다. 이와 함께 키넥트 센서를 통해 얻은 동적인 3차 원 환경 정보는 그리드 기반 실시간 폴리곤 생성 알고리즘[15] 에 의해 실시간으로 메쉬 정보를 생성하여 원격의 조종자에 게 제공한다.

3차원 레이저 센서의 인식 범위는 키넥트 센서보다 더 넓으 며 동일한 시점에 대한 3차원 정보이므로 한 화면에 동시에 출 력할 때 두 종류의 데이터가 중복되어 출력될 수 있다. 키넥트 센서 데이터와 레이저 센서의 데이터가 겹쳐서 출력되면 시각 정보가 복잡해져서 조종자에게 다소 혼란을 줄 수 있는데 이 를 위해 픽셀 셰이더(Pixel Shader)에서 중복되는 영역에 대한 데이터를 제거하도록 하였다[26].

UGV 주변 작업환경 외에도 원격 로봇 작업을 위해서는 로 봇의 3차원 모델을 이용한 시각화가 동반되어야 한다. 이를 위 해 로봇이 3D SLAM을 통해 자신의 위치와 자세를 추정하고 이 정보를 로봇 팔의 관절 정보와 함께 원격의 조종자에게 전 송되도록 하였다. 조종자의 화면에는 원격의 3차원 작업 공간 뿐만 아니라 UGV의 위치와 자세 그리고 로봇 팔의 관절각 정 보를 반영하여 3차원 모델로 시각화함으로써 UGV 및 주변 상 황을 다양한 시점에서 제공할 수 있도록 한다. 이러한 3차원 주변 환경 및 로봇의 시각화를 통해 원격에서의 안정적인 주 행과 로봇 팔 제어가 가능한 사용자 인터페이스를 제공함으로 써 UGV의 효율적인 운용을 지원할 수 있다.

3. 원격제어를 위한 3차원 정보 융합

3.1 정적 점군 데이터의 재구성

벨로다인 VLP-16 레이저 센서로부터 획득한 정적인 점군 데이터는 복셀 필터링을 수행한 후 새롭게 추가된 데이터를 원격 작업자에게 전송한다. 점군 데이터의 밀도가 낮은 경우 점들 사이의 빈 공간으로 인해 조종자가 주변 환경을 인지하 는 데 어려움이 있을 수 있다. 이럴 때 점들 사이에 메쉬를 생성 하여 점이 아닌 다각형으로 시각화함으로써 극복할 수 있는데 본 연구에서는 일반적으로 많이 사용되는 Ball-Pivoting 방법 을 활용하였다. 공간이 넓은 경우 모든 영역에서 Ball-Pivoting 알고리즘을 수행하여 시각화하면 많은 시간이 소요된다.

하지만 UGV의 원격 제어 시 주로 주변의 환경 정보를 이용 하여 이동 및 제어를 수행하므로 현재 UGV의 위치를 중심으 로 5 m x 5 m면적에 대해서 Ball-Pivoting 알고리즘을 적용하 여 메쉬를 생성하도록 하였다. 또한 Ball-Pivoting 알고리즘을 통해 생성된 메쉬의 표면이 고르지 않은 분포를 나타내어 Laplacian Smoothing을 통해 필터링하였다[27]. Ball-Pivoting 알고리즘을 통한 메쉬의 생성 및 Smoothing에 소요되는 시간 은 약 100 ms로서 실시간 원격 제어에 적용 가능할 것으로 확 인되었다.

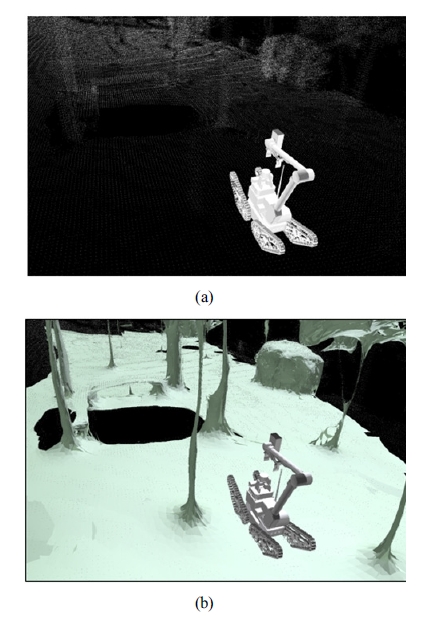

[Fig. 2]는 재구성된 환경의 정적 점군 데이터를 보여준다. [Fig. 2(a)]는 점군 데이터로만 출력된 환경 데이터와 UGV를 나타내는데 조종자가 주변 환경 정보를 파악하는데 어려움이 있다. [Fig. 2(b)]는 Ball-Pivoting 알고리즘을 통해 생성된 메쉬 에 의해 시각화된 주변 환경을 나타내는데 UGV 주변의 지형 정보와 장애물이 쉽게 식별되는 것을 확인할 수 있다.

3.2 동적 점군 데이터의 재구성

레이저 센서로부터 획득한 3차원 정보는 실내 및 실외 지형 과 구조물 등의 정적인 환경 정보이다. 키넥트 센서를 통해 제 공되는 정보는 로봇의 주행 시 발생할 수 있는 주변의 환경 변 화 또는 로봇 팔 작업 시 작업 대상물 정보 등과 같은 동적인 환 경 정보이다. 이러한 환경 정보는 UGV 정면의 동적인 데이터 이므로 원격 작업자가 환경의 변화를 빠르게 인지하기 위해서 는 메쉬 생성 및 시각화가 실시간으로 수행되어야 한다.

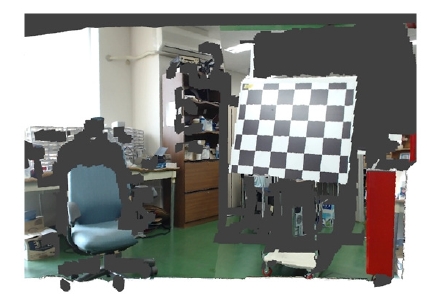

본 연구에서는 사전에 미리 정의된 점군 데이터 사이의 대 응 관계를 통해 메쉬 생성을 빠르게 수행 할 수 있는 이미지 그 리드 기반 실시간 폴리곤 생성 알고리즘[15]을 활용하여 10 ms 이내에 알고리즘 수행 및 시각화가 가능하도록 했다. [Fig. 3] 은 키넥트 센서로부터 얻은 정보에서 메쉬 생성 후 텍스쳐 맵 핑이 수행된 결과를 나타낸다.

3.3 무인 지상 로봇의 시각화

로봇의 원격 제어를 위해서는 작업 환경의 3차원 시각화뿐 만 아니라 그 곳에서 작업하는 로봇도 가상의 3차원 공간에 함 께 나타내야 한다. UGV 및 장착된 로봇 팔의 설계 모델로부터 3차원 시각화를 위한 모델을 추출하여 가상의 3차원 공간에 시각화하여 출력할 수 있다.

로봇의 이동 및 로봇 팔 움직임에 따라 원격의 조종자에게 전송되는 정보는 3D SLAM에 의해 얻게 되는 이동체의 6-DOF 위치 및 방향 정보와 로봇 팔의 관절 값 정보이다. 월드 좌표계를 기준으로 UGV의 위치와 방향 정보로 구성되는 동 차행렬을 HU라고 하면 로봇의 3차원 모델 중 몸체에 해당되 는 파트들의 3차원 위치는 식 (1)과 같이 HU행렬에 의해 변환 되어 표현된다.

| (1) |

여기서 Pg와 Pl은 각각 월드 좌표계 및 지역 좌표계로 표현 된 로봇 모델의 위치를 의미한다.

또한 로봇 팔을 구성하는 파트들은 각 관절간 기구학을 나 타내는 동차행렬 Hj로 구성된 식 (2)의 동차행렬 을 이용하 여 위치를 변환한다.

| (2) |

본 과제에서 활용한 UGV에 장착된 로봇 팔은 7개의 관절 과 그리퍼로 구성되어 있으며 로봇이 전송하는 팔의 각도 정 보 및 그리퍼 상태 정보를 받아 기구학을 해석한 후 식 (2)의 동 차행렬로 로봇 팔의 파트들을 변환하여 나타냄으로써 움직임 을 시각화할 수 있다.

3.4 3차원 정보의 융합

레이저 센서로부터 구성된 3차원 환경 데이터의 인식 영역 은 키넥트 센서보다 더 넓으며 동일한 시점에 대한 3차원 데이 터이므로 한 화면에 함께 출력하면 정보들이 겹쳐서 표현되어 조종자가 환경을 인지하는 데 혼란이 발생할 수 있다.

동적으로 변화하는 환경의 인지를 위해 중첩된 영역에서 동적 점군 데이터만을 출력해야 한다. 따라서 고급 셰이더 언 어(High Level Shader Language, HLSL)의 픽셀 셰이더(Pixel Shader)를 통해 정적 점군 데이터를 필터링 하였다[26]. 픽셀 셰 이더의 clip 함수는 조건을 만족하지 않을 경우 현재 연산중인 픽셀을 출력하지 않도록 한다. 따라서 UGV를 포함하는 Oriented Bounding Box(OBB)를 생성 한 후 픽셀 셰이더 연산 을 위해 입력된 정적 점군 데이터가 OBB의 내부 또는 외부에 있는지 검사하여 내부에 있을 경우 clip 함수를 적용하여 출력 하지 않도록 하였다. UGV의 위치 및 자세정보를 픽셀 셰이더 상수 버퍼의 입력값으로 설정하여 OBB에 반영하도록 하였으 며 레이저 스캐너를 이용한 실시간 지도 작성 알고리즘을 통 해 UGV의 위치 및 자세 정보가 획득된다.

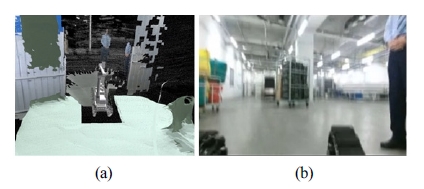

필터링이 적용된 정적 점군 데이터와 동적 점군 데이터 및 위치 및 자세 정보가 반영된 UGV 모델을 함께 출력함으 로써 UGV의 원격 제어에 적용할 수 있다. [Fig. 4(a)]는 3차 원 정보가 융합된 후 시각화하여 출력된 결과를 보여주며 [Fig. 4(b)]는 [Fig. 4(a)]의 재구성된 3차원 환경을 2차원 카메 라를 통해 바라본 결과를 보여준다. [Fig. 4(b)]에서 2차원 카 메라의 제한된 시점으로 인하여 한정된 영역의 환경의 정보 를 획득할 수 있으나 [Fig. 4(a)]의 재구성된 3차원 환경을 통 해 UGV와 주변 환경을 자유로운 시점에서 관찰하며 정보를 획득할 수 있다.

3.5 2차원 기반 원격 제어와 3차원 융합정보 기반 원격 제어 비교

3차원 정보가 융합된 환경 정보를 이용한 원격 제어를 통해 원활하고 효율적인 원격 제어가 가능함을 확인하기 위해 실험 실 환경에서 가상의 목표 지점을 설정한 후 환경의 장애물을 통과하여 목적지까지 이동하는 실험을 수행하였다.

[Fig. 5]는 실험실 환경에서 구현한 실험 환경을 보여주며 하얀색 원은 가상의 목표 지점이고 파란색 원은 UGV의 시작 위치이다. [Fig. 5]의 노란색 선은 목표 지점까지 이동하기 위 한 경로를 보여준다.

[Fig. 5]에서 목표 지점까지의 이동 과정 중 UGV를 회전시 켜 경로 변경을 해야 하는 상황이 발생하며 [Fig. 5]의 붉은색 원은 UGV의 회전을 위한 공간을 보여준다.

[Fig. 6]은 [Fig. 5]의 붉은색 원 영역에서 UGV를 제어하는 것을 보여주며 [Fig. 6(a)]는 융합정보에 기반한 원격 제어이며 [Fig. 6(b)]는 2차원 기반 원격 제어이다.

[Fig. 6(b)]에서 원격 작업자는 UGV와 환경과의 상대적인 위치 정보와 현재 UGV 의 위치를 확인할 수 없으므로 진행 경 로의 파악 및 UGV의 회전을 위한 여유 공간 확인에 어려움이 발생하여 환경과의 잦은 충돌이 발생하였다. 이러한 환경과의 충돌은 UGV의 운용 시 사고를 발생시킬 수 있는 원인이 될 수 있으며 특히 폭발물 처리를 위한 임무 수행 시 폭발물을 터트 릴 수 있는 위험이 존재한다.

[Fig. 6(a)]에서 원격 작업자는 환경과의 상대적인 거리와 UGV의 현재 위치 및 자세 정보를 실시간으로 파악할 수 있었 으며 목적지까지 이동하기 위한 전체 경로 및 UGV의 회전을 위한 여유 공간 파악을 위해 시점을 변경하여 원격 제어를 수 행할 수 있었다.

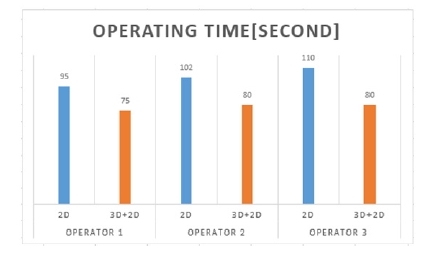

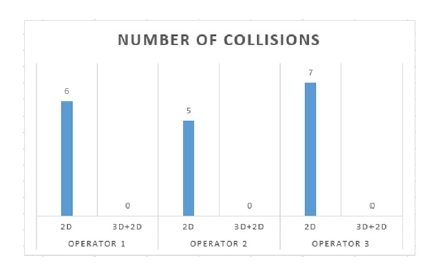

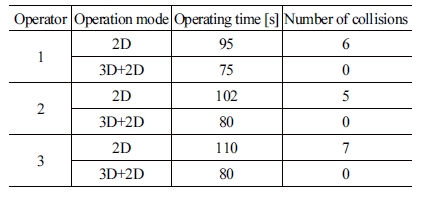

2차원 기반 원격 제어와 융합정보 기반 원격 제어의 비교를 위해 3명의 원격 작업자가 원격 제어 방식에 따라 각각 10회 실험을 수행하였다. [Table 1]은 2차원 및 융합정보 기반 원 격 제어를 수행한 결과이며 10회씩 수행한 결과의 평균값을 보여준다.

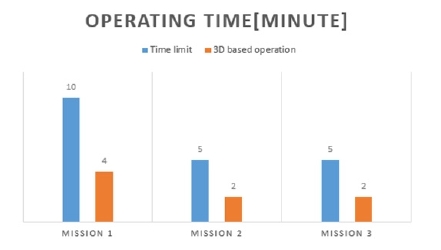

[Fig. 7]은 원격 제어 방식에 따른 임무 수행 시간을 비교한 결과를 보여주며 3차원 융합정보 기반 원격 제어가 2차원 기 반 원격 제어보다 더 적은 시간이 소요된 것을 확인할 수 있다.

[Fig. 8]은 원격 제어 방식에 따른 환경과의 충돌 횟수를 비 교한 결과를 보여주며 2차원 기반 원격 제어는 환경과의 빈번 한 충돌이 발생하였으나 3차원 융합정보 기반 원격 제어는 환 경과의 충돌이 발생하지 않은 것을 확인할 수 있다.

4. 실험 결과

4.1 실험 환경

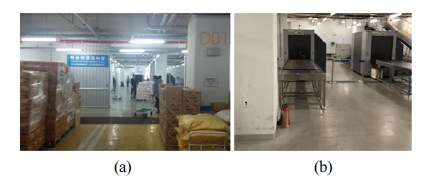

본 논문에서 제안하는 3차원 융합정보 기반 실시간 원격 제 어의 검증을 위해 부산항만 보안 담당기관인 부산항보안공사 의 폭발물 처리팀의 자문을 통하여 탁송화물 검사장 내 폭발 물 처리 시나리오를 계획한 후 폭발물 사고에 대한 원격 제어 실험을 수행하였다. 시나리오는 부산항 보안공사에서 분기별 로 실시하는 보안훈련 상황 중 부산 국제여객터미널내의 폭발 물 처리 훈련 시나리오를 기반으로 하며 폭발물의 탐색 및 처 리에 UGV를 운용할 수 있도록 하였다.

선행 연구를 통하여 2차원 기반 원격 제어는 환경과의 빈번 한 충돌이 발생하였으므로 폭발물 처리 시나리오에의 적용에 적합하지 않다. 따라서 UGV의 운용 중 발생할 수 있는 환경과 의 충돌 및 보행자의 예기치 못한 사고 등을 방지하기 위해 3 차원 융합정보 기반 원격 제어만을 수행하였으며 부산항보안 공사 폭발물 처리팀의 참관 하에 시나리오를 수행하였다.

시나리오를 수행하는 환경은 차량과 화물 등의 많은 장애 물이 존재하며 특히 벽으로 막힌 공간으로 인해 무선 네트워 크를 통한 통신에 장애가 발생한다. 따라서 상용 LTE망을 적 용하여 원활한 통신이 가능하도록 하였다.

4.2 시나리오 수행 - 탁송화물 검사장내 폭발물 신고 접수 상황

부산 국제여객터미널내의 탁송화물 검사장은 해외에서 여 객선에 선적한 중소규모의 화물을 검사하는 장소이며탁송화 물 검사장으로 입항된 화물 내에 폭발물 의심물체가 발견되어 신고가 접수된 상황을 가정한다. [Fig. 9(a)]는 탁송화물 검사 장 입구를 보여주며 [Fig. 9(b)]는 탁송화물 검사장 내부를 보 여준다.

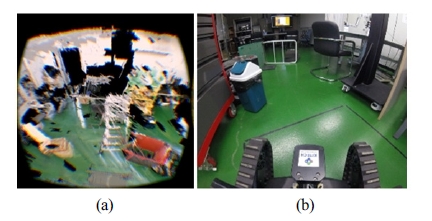

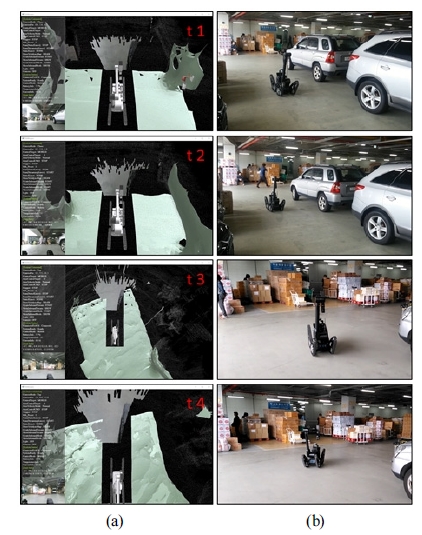

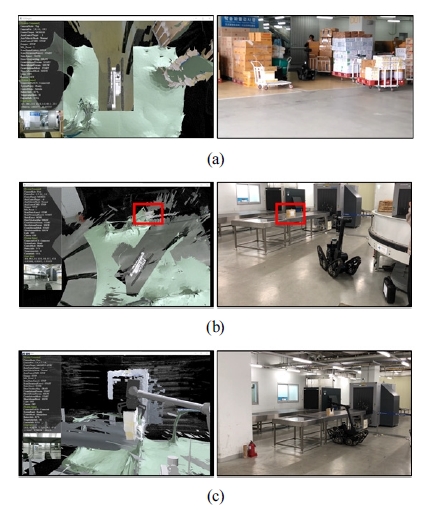

폭발물 의심 물체에 대한 신고가 접수된 후 폭발물 처리반 의 출동 대기실에서 UGV의 운용을 시작하여 탁송화물 검사 장까지 이동하였다. 출동명령이 떨어진 후 UGV 주위 환경 정 보의 획득을 위해 실시간 지도 작성을 시작한다. [Fig. 10]은 시 간 순서에 따른 실시간 지도 작성 과정을 보여준다. [Fig. 10(a)] 는 원격 조종자의 화면에 출력된 결과를 보여주며 [Fig. 10(b)] 는 외부의 카메라로 촬영한 영상을 보여준다. [Fig. 10(a)]와 [Fig. 10 (b)]는 시간 순서에 따라 각각 대응된다.

[Fig. 10(a)]에서 UGV 주변의 차량들은 메쉬로 모델링되어 출력되며 UGV 정면의 환경은 텍스쳐 맵핑을 수행한 후 출력 된다. UGV 정면에 장착된 카메라로부터 획득한 영상 정보는 원격 조종자의 화면 왼쪽 하단에 출력되도록 하였다. 탁송화 물 검사장 입구까지 이동하기 위해 화물 선적장을 통과해야 하며 [Fig. 11(a)]는 [Fig. 10]의 차량 사이를 통과한 후 화물 선 적장을 통과하여 이동하는 모습을 보여준다.

Cargo shipment passage (a) Movement from consignment cargo inspection area to explosive suspect object (b) Remote control of the manipulator to lift a suspicious object of explosive (c)

[Fig. 11(a)]에서 화물 선적장에 쌓여있는 화물들은 불규칙 적으로 놓여 있으며 화물들 사이의 좁은 통로를 통과해야 하 므로 주변 환경과의 충돌이 발생하지 않는 안전한 경로를 탐 색한 후 UGV를 이동시키는 것을 볼 수 있다.

[Fig. 11(b)]는 화물 선적장을 통과한 후 탁송화물 검사장 내 부의 검사대 위에 놓인 폭발물 의심 물체까지 이동하는 모습 을 보여주며 [Fig. 11(b)]의 붉은색 사각형은 폭발물 의심물체 이다.

[Fig. 11(c)]는 UGV에 장착된 로봇 팔을 제어하여 폭발물 의심 물체를 들어올리는 작업을 수행하는 모습을 보여준다. 로봇 팔의 3차원 모델에 로봇 팔의 각 관절값이 실시간으로 반 영되므로 효율적이고 직관적인 제어가 가능하다.

폭발물 의심 물체는 별도로 지정된 폭파에 안전한 위치로 이동시킨 후 물포총을 사용하여 폭파를 수행한다.

4.3 임무 수행 결과

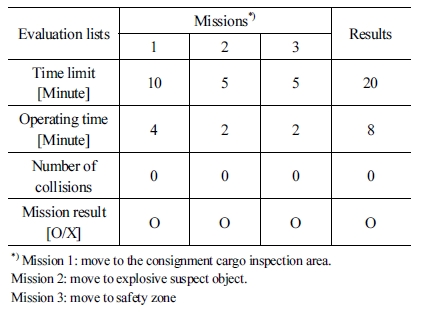

목표지점까지의 이동 및 폭발물 의심 물체의 운반에 대한 운용시간과 UGV의 이동 중 발생한 환경과의 충돌발생 여부 를 측정하였으며 임무의 성공 여부를 기록하였다. 안전 사고 에 대비하여 충돌 발생 위험이 있을 경우 안전요원이 강제로 UGV을 정지하도록 하였으며 이러한 상황 발생 시 충돌 횟수 에 포함하도록 하였다. 각각의 임무는 안전한 임무 종료를 위 한 제한 시간을 가지고 있으며 [Table 2]는 각각의 임무와 제한 시간 및 임무 수행 결과를 보여준다.

[Fig. 12]는 각각의 시나리오에 대한 운용 시간을 보여준다. 각각의 임무에 할당한 제한시간보다 빠르게 임무 수행이 가능 한 것을 확인할 수 있으며 특히 검사대에서 폭발물 의심 물체 를 들어 올릴 경우 로봇 팔의 자세와 폭발물 의심 물체의 위치 를 동시에 확인할 수 있으므로 신속히 작업을 수행할 수 있었 다. 또한 탁송화물 검사장으로 이동 및 외부 출입 게이트로의 이동 시 고가의 전자 제품 및 화물 상자 등이 쌓여있는 좁은 통 로를 통과해야 한다. 3차원 융합정보 기반 원격 제어를 통하여 주변 환경과의 충돌 발생 가능성을 여러 시점에서 살펴본 후 안전한 경로를 탐색할 수 있었으므로 충돌이 발생하지 않은 것을 확인할 수 있다.

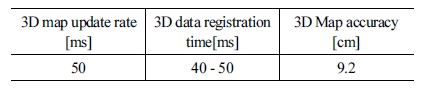

[Table 3]은 3차원 지도 생성에 대한 알고리즘 성능 평가 결 과를 보여준다. 환경의 점군 데이터는 벨로다인 VLP-16 레이 저 센서로부터 50 ms마다 획득할 수 있으며 ±3 cm의 오차를 가지고 있다. 제안하는 방식을 통한 3차원 지도의 생성은 40 ms -50 ms의 연산 시간을 보이므로 벨로다인 VLP-16 레이저 센 서로부터 획득한 데이터의 실시간 처리가 가능하며 공인인 증기관을 통해 수행한 생성된 지도의 정밀도 측정 결과는 9.2 cm 이다.

5. 결 론

본 논문에서는 3차원 융합정보에 기반하여 실시간으로 이 루어지는 UGV의 원격 제어를 수행하였으며 부산항보안공사 의 폭발물 처리팀과의 폭발물 제거 훈련을 통해 제안하는 방 식을 검증하였다.

지금까지의 UGV제어는 카메라 영상에 의존하여 수행되었 으나 제한된 시점으로 인해 한정된 영역만을 관찰할 수 있으 며 이미 지나간 영역에 대한 정보를 획득할 수 없으므로 원격 작업자의 기억에 의존하거나 이전 위치로 되돌아간 후 임무를 수행해야 한다. 따라서 본 논문에서는 UGV에 장착된 VLP-16 레이저 스캐너로부터 획득한 정적인 3차원 환경 정보와 키넥 트 센서로부터 획득한 동적인 3차원 환경 정보를 융합한 후 원 격 제어에 적용하였다. 정적인 점군 데이터는 Ball-pivoting 알 고리즘을 이용해 모델링 하였으며 동적인 점군 데이터는 그리 드에 기반한 실시간 폴리곤 생성 알고리즘을 이용해 모델링하 여 원격 작업자에게 제공하였다.

3차원 융합정보 기반 UGV의 원격 제어 검증을 위해 부산 항보안공사의 폭발물 처리팀의 자문을 통하여 탁송화물 검사 장내의 폭발물 신고 접수 시나리오를 계획한 후 폭발물 처리 훈련을 수행하였다. 실험실 환경에서 수행한 2차원 영상 정보 기반 원격 제어와 3차원 융합정보 기반 원격 제어를 수행한 결 과 2차원 영상 기반 원격 제어는 환경과의 빈번한 충돌 발생으 로 인하여 폭발물 신고 접수 시나리오의 수행에 적합하지 않 은 것을 확인하였다. 따라서 시나리오의 수행 시 3차원 융합정 보 기반 원격 제어만을 적용하여 실험을 수행하였으며 시나리 오의 완료까지 소요된 시간과 주변 환경과의 충돌 여부 및 임 무 성공 여부를 측정하여 결과를 비교하였다. 실험 결과 UGV 와 주변 환경과의 충돌이 발생하지 않았으며 안전한 경로를 통해 UGV의 신속한 이동을 수행하여 임무를 완수할 수 있었 다. 부산 국제여객터미널에서 실제 수행한 로봇에 의한 폭발 물 처리 시나리오를 통해 제안하는 3차원 융합정보 기반 원격 제어가 UGV의 실시간 원격 제어에 적합함을 확인하였으며 제안하는 방식을 검증할 수 있었다.

Acknowledgments

This research was financially supported by the Korea Institute of Industrial Technology (KITECH) through the In-House Research Program (UR180053).

References

- R. R. Murphy, “Unmanned Ground Vehicles,” Disaster robotics, 1st ed. MIT press, ch. 3, sec. 2, pp.42-60, 2014.

-

S. K. Cho, H. Z. Jin, J. M. Lee, and B. Yao, “Teleoperation of a mobile robot using a force-reflection joystick with sensing mechanism of rotating magnetic field,” IEEE/ASME Transactions On Mechatronics, vol. 15, no. 1, pp. 17–26, Feb., 2010.

[https://doi.org/10.1109/TMECH.2009.2013848]

-

Y.-D. Shin, J.-H. Park, G.-R. Jang, J.-S. Yoon, and M.-H. Baeg, “Interactive remote robot operation framework for rescue robot,” 2013 IEEE International Symposium on Safety, Security, and Rescue Robotics (SSRR), Linköping, Sweden, pp. 1–5, 2013.

[https://doi.org/10.1109/SSRR.2013.6719339]

- J. V. Draper and L. M. Blair, “Workload, flow, and telepresence during teleoperation,” IEEE International Conference on Robotics and Automation, Minnesota, USA, 1996, DOI: 10.1109/ROBOT. 1996.506844.

-

D. Huber, H. Herman, A. Kelly, P. Rander, and J. Ziglar, “Real-time photo-realistic visualization of 3D environments for enhanced tele-operation of vehicles,” 2009 IEEE 12th International Conference on Computer Vision Workshops, Kyoto, Japan, 2009, DOI: 10.1109/ICCVW.2009.5457431.

[https://doi.org/10.1109/ICCVW.2009.5457431]

-

F. Ferland, F. Pomerleau, C. T. Le Dinh, and F. Michaud, “Egocentric and exocentric teleoperation interface using real-time, 3D video projection,” 4th ACM/IEEE international conference on Human robot interaction, California, USA, pp. 37 –44, 2009.

[https://doi.org/10.1145/1514095.1514105]

-

R. B. Rusu, “Semantic 3D object maps for everyday manipulation in human living environments,” KI-Künstliche Intelligenz, vol. 24, no. 4, pp. 345–348, Nov., 2010.

[https://doi.org/10.1007/s13218-010-0059-6]

-

D. Chetverikov, D. Svirko, D. Stepanov, and P. Krsek, “The trimmed iterative closest point algorithm,” Object recognition supported by user interaction for service robots, Quebec, Canada, 2002, DOI: 10.1109/ICPR.2002.1047997.

[https://doi.org/10.1109/ICPR.2002.1047997]

- Velodyne, VLP-16, [Online], https://velodynelidar.com/vlp-16.html, Accessed: November 13, 2018.

- HOKUYO, UTM-30LX, [Online], https://www.hokuyo-aut.jp/search/single.php?serial=169, Accessed: November 13, 2018.

- Microsoft, HLSL, [Online], https://msdn.microsoft.com/ko-kr/library/windows/desktop/bb509561(v=vs.85).aspx, Accessed: November 13, 2018.

-

M. Ferre, S. Cobos, R. Aracil, and M. A. S. Urán, “3D-image visualization and its performance in teleoperation,” ICVR 2007: Virtual Reality, Beijing, China, vol. 4563, pp. 22–31, 2007.

[https://doi.org/10.1007/978-3-540-73335-5_3]

- B. Armstrong, T. Verron, L. Heppe, J. Reynolds, and K. Schmidt, “RGR-3D: simple, cheap detection of 6-DOF pose for teleoperation, and robot programming and calibration,” 2002 IEEE International Conference on Robotics and Automation, Washington D.C., USA, 2002, DOI: 10.1109/ROBOT.2002. 1013678.

-

A. Reveleau, F. Ferland, M. Labbé, D. Létourneau, and F. Michaud, “Visual representation of interaction force and sound source in a teleoperation user interface for a mobile robot,” Journal of Human-Robot Interaction, vol. 4, no. 2, pp. 1–23, Sept., 2015.

[https://doi.org/10.5898/JHRI.4.2.Reveleau]

-

G.-R. Jang, Y.-D. Shin, J-S. Park, J.-H. Park, J.-H. Bae, Y.-S. Lee, and M.-H. Baeg, “Real-time Polygon Generation and Texture Mapping for Tele-operation using 3D Point Cloud Data,” Journal of Institute of Control, Robotics and Systems, vol. 19, no. 10, pp. 928–935, 2013.

[https://doi.org/10.5302/J.ICROS.2013.13.8012]

-

M. Bosse and R. Zlot, “Continuous 3D scan-matching with a spinning 2D laser,” 2009 IEEE International Conference on Robotics and Automation, Kobe, Japan, 2009, DOI: 10.1109/ROBOT.2009.5152851.

[https://doi.org/10.1109/ROBOT.2009.5152851]

- J. Zhang and S. Singh, “LOAM: Lidar Odometry and Mapping in Real-time,” Robotics: Science and Systems 2014, CA, USA, vol. 2, pp. 1-9, Jul, 2014.

-

K. Lee, S.-H. Ryu, S. Yeon, H.G. Cho, C.H. Jun, J. Kang, H. Choi, J. Hyeon, I. Baek, W. Jung, H. Kim, N. Doh, “Accurate continuous sweeping framework in indoor spaces with backpack sensor system for applications to 3-D mapping,” IEEE Robotics and Automation Letters, vol. 1, no. 1, pp. 316–323, Jan., 2016.

[https://doi.org/10.1109/LRA.2016.2516585]

-

P. Henry, M. Krainin, E. Herbst, X. Ren, and D. Fox, “RGB-D mapping: Using depth cameras for dense 3D modeling of indoor environments,” Springer Tracts in Advanced Robotics, vol. 79, pp. 477-491, 2010.

[https://doi.org/10.1007/978-3-642-28572-1_33]

-

M. Kazhdan and H. Hoppe, “Screened poisson surface reconstruction,” ACM Transactions on Graphics (TOG), vol. 32, no. 3, Jun., 2013, DOI: 10.1145/2487228.2487237.

[https://doi.org/10.1145/2487228.2487237]

-

F. Bernardini, J. Mittleman, H. Rushmeier, C. Silva, and G. Taubin, “The ball-pivoting algorithm for surface reconstruction,” IEEE transactions on visualization and computer graphics, vol. 5, no. 4, pp. 349–359, Oct.-Dec., 1999.

[https://doi.org/10.1109/2945.817351]

-

R. A. Newcombe, S. Izadi, O. Hilliges, D. Molyneaux, D. Kim, A. J. Davison, P. Kohi, J. Shotton, S. Hodges, and A. Fitzgibbon, “KinectFusion: Real-time dense surface mapping and tracking,” 2011 10th IEEE International Symposium on Mixed and Augmented Reality, Basel, Switzerland, 2011, DOI: 10.1109/ISMAR.2011.6092378.

[https://doi.org/10.1109/ISMAR.2011.6092378]

-

M. Bolitho, M. Kazhdan, R. Burns, and H. Hoppe, “Parallel poisson surface reconstruction,” ISVC 2009: Advances in Visual Computing, Nevada, USA, pp. 678–689, 2009.

[https://doi.org/10.1007/978-3-642-10331-5_63]

- Microsoft, Geometry Shader Stage, [Online], https://msdn.microsoft.com/ko-kr/library/windows/desktop/mt787170(v=vs.85), Accessed: November 13, 2018.

-

E. Einhorn and H.-M. Gross, “Generic NDT mapping in dynamic environments and its application for lifelong SLAM,” Robotics and Autonomous Systems, vol. 69, pp. 28–39, Jul, 2015.

[https://doi.org/10.1016/j.robot.2014.08.008]

- Microsoft, Pixel Shader Stage, [Online], https://msdn.microsoft.com/ko-kr/library/windows/desktop/mt787171(v=vs.85), Accessed: November 13, 2018.

-

M. Zhihong, M. Lizhuang, Z. Mingxi, and L. Zhong, “A modified Laplacian smoothing approach with mesh saliency,” SG 2006: Smart Graphics, Vancouver, Canada, pp. 105-113, 2006.

[https://doi.org/10.1007/11795018_10]

2008 가천대학교 물리학과(이학사)

2018 고려대학교 디지털정보미디어공학과 (공학석사)

2011~현재한 국생산기술연구원 로봇그룹 연구원

관심분야: 3차원 정보 처리 및 3차원 시각화 기술

1999 명지대학교 전기전자공학과(공학사)

2001 명지대학교 전기전자공학과(공학석사)

2004 Ritsumeikan 대학교 로보틱스학과 (공학박사)

2009~현재한 국생산기술연구원 로봇그룹 수석연구원

관심분야: 양팔 로봇 작업, 로봇 손 제어

2008 성균관대 기계공학부(공학사)

2010 성균관대 메카트로닉스협동과정 (공학석사)

2015 성균관대 기계공학과(공학박사)

2017~현재한 국생산기술연구원 로봇그룹 선임연구원

관심분야: 로봇 매니퓰레이션, 로봇핸드, 촉각센서