딥러닝 기반의 운전자의 안전/위험 상태 인지 시스템 개발

© Korea Robotics Society. All rights reserved.

Abstract

In this paper, we propose Intelligent Driver Assistance System (I-DAS) for driver safety. The proposed system recognizes safety and danger status by analyzing blind spots that the driver cannot see because of a large angle of head movement from the front. Most studies use image pre-processing such as face detection for collecting information about the driver’s head movement. This not only increases the computational complexity of the system, but also decreases the accuracy of the recognition because the image processing system dose not use the entire image of the driver’s upper body while seated on the driver’s seat and when the head moves at a large angle from the front. The proposed system uses a convolutional neural network to replace the face detection system and uses the entire image of the driver’s upper body. Therefore, high accuracy can be maintained even when the driver performs head movement at a large angle from the frontal gaze position without image pre-processing. Experimental result shows that the proposed system can accurately recognize the dangerous conditions in the blind zone during operation and performs with 95% accuracy of recognition for five drivers.

Keywords:

Convolutional neural network, Driver’s head orientation, Intelligent diver assistance system1. 서 론

최근 자동차 산업에서 인공 지능과 관련된 기술을 차량에 적용한 인공 지능 시스템 기술에 많이 주목하고 있다. 그 중에 서 지능형 운전자 보조 시스템(Intelligent Driver Assistance system, I-DAS)은 운전자의 활동과 같은 상황 인식을 통하여 운전자의 안전 운전을 도울 수 있는 시스템이다[1]. 인공 지능 의 발달로 지능형 운전자 보조 시스템은 더욱 더 지능화된 차 량 제어 작업을 지원하여 운전자가 주행 중에 존재하는 위험 을 예측하고 방지하여 운전의 안전성을 개선할 수 있다[2].

주행 중에 운전자의 주의력 분산은 교통사고를 발생하는 중요한 원인 중의 하나이며 운전자의 주의력 분산은 안전과 위험에 대한 반응을 저하시킨다[3]. 이러한 주의력 분산의 인식 을 위하여 운전자가 정면 응시에서 머리가 이동할 때 눈을 통 해 볼 수 없는 사각지대를 방지할 수 있는 지능형 운전자 보조 시스템이 필요하다. 일반적으로 운전자의 시선의 위치 정보를 이용하여 시선의 위치를 추적하고 추적한 결과에 따라서 머리 가 정면 응시에서 이동하는 과정에서 눈이 볼 수 없는 사각지 대를 해소할 수 있다. 하지만 눈을 사용한 시선 위치 추적 방법 들의 대부분은 적외선 영상(Infrared imaging) 또는 가시 영상 (Visible imaging)을 사용하기 때문에[4] 운전자의 시선 위치는 이상적인 환경에서는 정확하게 추적할 수 있지만 현실에서는 햇빛, 내/외부 환경의 명암도 변화, 안경 등의 원인 때문에 시 선 위치 추적을 적용하지 못하는 단점이 있다[5].

최근에 운전자의 시선의 위치 정보를 얻기 위하여 운전자 머리의 움직임도 많이 사용되고 있다. 눈의 정보와 비교하면 머리의 방향에 대한 정보는 시선 위치 정보를 제공받을 수 있 고 운전자 머리의 움직임 추정, 차선 변화, 전방 충돌 경보 등의 상황에서 적용할 수 있는 장점으로 인해 시야의 사각 지대와 관련된 연구에서 더 많이 사용한다[6-8]. 이러한 연구들은 운전 자의 머리 운동의 정보를 이용하여 눈의 사각지대 해소의 문 제를 효율적으로 해결할 수 있지만 대부분의 연구들이 얼굴 추적(Face detection) 방법을 이용하여 운전자의 이미지 데이 터의 전처리를 한다. 또한 특징 추출과 특징 분류의 방법도 필 요로 한다. 이러한 방법은 시스템의 계산 복잡도가 증가할 뿐 만 아니라 정면 응시로부터 큰 각도로 머리를 돌린 경우에 대 하여 정확도가 떨어진다.

컨볼루션 신경망(Convolutional Neural Network, 이하 CNN) 방법은 딥러닝 기술 중에서 이미지 처리 및 분류 영역에 서 널리 사용되고 있는 대표적인 심층 신경망이다[9,10]. 특히 CNN 방법은 전처리 과정이 필요 없이 원시 이미지(Raw image) 데이터를 직접 사용할 수 있기 때문에 전처리 과정에서 가지고 있는 계산 복잡도 문제와 운전자가 정면 응시로부터의 큰 각도의 머리 회전에 대한 얼굴 추적의 고려가 필요 없다.

본 논문은 지능형 운전자 보조 시스템에 적용하기 위하여 운전자가 운전자석에 앉은 상체의 전체 이미지를 기반으로 CNN 방법을 이용하는 시스템을 제안한다. 제안한 시스템은 직진, 좌회전, 우회전, 후진 주차 등을 사용한 시나리오들을 이 용하여 운전자의 머리 운동에 대한 정보를 수집하고 설계한 응시 영역(Gaze zone)을 기반으로 데이터베이스를 수집한다. 수집된 데이터베이스를 기반으로 CNN 방법을 사용하여 운전 자의 안전한 상태와 위험한 상태를 인지한다. 제안한 방법은 5 명의 운전자에 대하여 실험하고 AlexNet 기반의 파라미터 (Parameter)와 레이어(Layer)를 조절한 CNN 구조의 실험결과 를 분석한다. 제안한 방법의 실험 결과는 지능형 운전자 보조 시스템에 CNN 방법을 성공적으로 사용이 가능하고 높은 정 확도(Accuracy)를 유지할 수 있다.

2. CNN 기반의 운전자 안전/위험 상태 인지 시스템

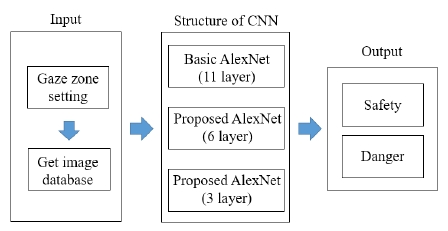

본 논문에서는 운전자가 주행 중에 운전자 눈의 사각 지대 에서 발생할 수 있는 운전자의 안전과 위험을 인지할 수 있는 지능형 운전자 보조 시스템을 개발하고 제안한 시스템의 구성 은 [Fig. 1]과 같다. 먼저 운전자의 시선의 영역이 고정되어 있 기 때문에 이러한 시야의 영역인 응시 영역을 설정한다. 다음 으로 설정한 응시 영역과 관련된 운전자석에 앉은 운전자의 머리 운동을 포함한 상체 이미지들을 카메라를 사용하여 수집 한다. 이렇게 수집된 운전자 머리 운동의 이미지 데이터베이 스를 기반으로 기본적인 AlexNet 방법과 제안한 파라미터와 레이어의 개수를 조절한 AlexNet 방법의 CNN 방법을 사용하여 주행 중에 일어날 수 있는 운전자의 안전한 상태와 위험한 상 태에 대하여 인지를 한다.

2.1 응시 영역 설정

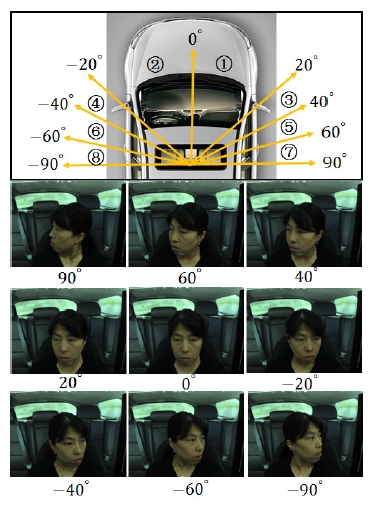

운전자가 응시하는 위치에 따라서 머리가 이동할 수 있기 때문에 운전자의 머리 운동 정보를 사용할 때 항상 응시 영역 의 설정이 필요하다[11,12]. 일반적으로 운전자의 응시 영역은 운전자의 정면과 백미러와 두 개의 양쪽 사이드 미러를 포함 한다. 운전자는 주행 중에 발생하는 위험을 감소시키기 위하 여 가능한 정면 응시를 하려고 한다. 따라서 정면 응시로부터 되도록 작은 각도 범위 안에서 머리를 이동하면서 도로의 상 황을 파악하고자 한다. 그러나 정면 응시로부터 큰 각도 범위 로 머리를 이동하는 경우에 도로의 상황을 신속히 파악하기 힘들다. 따라서 제안한 시스템은 운전자가 실제의 주행 과정 에서 발생할 수 있는 운전자의 머리의 움직임을 고려하여 [Fig. 2]와 같은 응시 영역을 설정한다.

응시 영역은 8개의 영역인 0° ‒ 20° (①), -20° ‒ 0° (②), 20°‒ 40° (③), -40°‒ -20° (④), 40°‒ 60° (⑤), -60°‒ -40° (⑥), 60°‒ 90° (⑦), -90°‒ -60° (⑧) 로 설정한다. 운전자의 머리의 움직임이 -90° 와 90° 보다 더 큰 각도를 나타낸 경우에도 -90° 또는 90° 로 설정하였다. 0° 는 직진으로 운전하는 경우로 운전자의 정 면 응시를 의미한다. -20° ‒ 20° 일 경우는 운전자가 직진 과정 에서 정면 응시로부터 양쪽 사이드미러를 응시하는 경우를 나 타난다. 우회전이나 좌회전, 전방의 차선 상태를 확인할 때는 20°‒ 40°와 -40°‒ -20°의 응시하는 경우이다. 40°‒ 60°와 -60°‒ -40°는 차선 변경과 유턴할 때 항상 나타난다. 60°‒ 90°와 -90°‒ -60°는 후진하여 주차를 하고자 하는 경우와 교차로의 합류 지 점에서 진입하고자하는 도로에 합류하는 경우에 나타난다.

2.2 이미지 데이터베이스의 작성

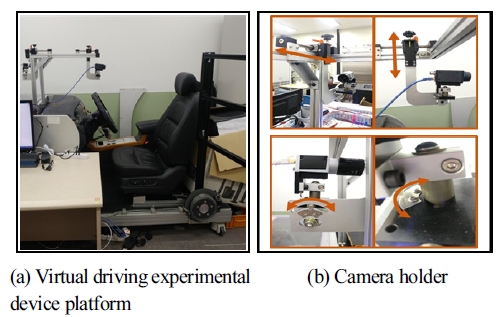

제안한 시스템은 운전자의 운전 상태의 이미지들을 수집하 기 위하여 [Fig. 3]과 같은 가상실험 장치 플랫폼을 사용한다. [Fig. 3]은 Basler회사의 Gige Vision C-Mount v01 카메라를 이 용하여 제안한 시나리오에 따라 운전자가 운전하는 모습을 촬 영한다. [Fig. 3 (a)]와 같이 운전자의 앉은 상태의 상체를 촬영 하기 위하여 운전자의 앞쪽에 카메라를 설치한다. [Fig. 3 (b)] 와 같은 촬영장비 거치대를 설치하여 운전자의 신장에 맞추어 조절이 가능하다. 카메라 거치대가 높이뿐만 아니라 운전자와 플랫폼과의 거리와 각도를 자유롭게 조절할 수 있기 때문에 최대한 운전자의 운전 상황에 맞는 데이터베이스를 구축하는 것이 가능하였다. 가상실험 장치 플랫폼에서 [Table 1]과 같은 시나리오들을 사용하여 -90° ‒ 90° 각도 범위의 운전자의 머리 운동에 관한 이미지들을 수집한다.

[Table 1]에서는 총 4개 시나리오를 제안하고 각각의 시나 리오 구성은 다음과 같다. 1번 시나리오는 (1)→(2)→(1)→(2) →(1)로 구성되어 있고 (1)과 (2)는 각각 직진과 우회전을 표시 한다. 1번 시나리오를 통해서 ①, ③, ⑤와 관련된 응시 영역의 운전자의 머리 운동 이미지들을 수집할 수 있다. 2번 시나리오 는 (1)→(3)→(1)→(3)→(1)로 표시하고 (3)은 좌회전을 나타낸 다. 2번 시나리오를 사용하여 ②, ④, ⑥과 관련된 응시 영역의 이미지들을 수집한다.

3번 시나리오는 (1)→(4)→(5)→(6)→(1)로 교차로에서 도로 에 합류하기 위하여 진입하는 경우를 나타낸다. 교차로에서 합류하고자 하는 도로에 차량들이 존재하면 운전자가 일단 정 지하고 합류하고자 하는 도로의 차량들의 흐름을 확인하여 합 류할 타이밍을 찾는다. 처음에는 (4)약한 좌측 응시(-40°‒ 0°) 범위로 좌측으로 응시하고 다음으로 (5)중간 좌측 응시(-60°‒ 0°)범위에서 좌측으로 응시를 한다. 마지막으로 (6)강한 좌측 응시(-90°‒ 0°)범위로 정면 응시로부터 큰 각도의 범위로 좌측 으로 응시를 하다가 직진하여 합류 도로로 진입하는 과정을 의미한다. 3번 시나리오를 사용하여 ②, ④, ⑥, ⑧의 응시 영역 과 관련된 이미지를 수집한다.

마지막으로 4번 시나리오는 후진하여 주차하는 경우로 (1) →(7)→(8)→(9)로 설정하였다. (7)은 후진을 의미하고 (8)은 정 면 응시를 나타내고 (9)는 정면 응시로부터 후면 응시를 하는 경우이다. 운전자가 주차를 하기 위하여 후진을 하면서 차량 의 뒤쪽도 확인하는 과정을 거쳐서 주차를 한다. 정면 응시로 부터 오른쪽으로 차량의 후면(0°‒ 90°)을 확인하는 행동을 거 쳐 운전자가 ①, ③, ⑤, ⑦ 의 영역을 응시하며 관련된 이미지 들을 수집한다.

제안한 시스템은 운전자의 머리 움직임에 따라서 운전자의 안전과 위험의 상태를 인지하기 위하여 수집된 -90° ‒ 90° 각도 범위의 이미지들을 안전과 위험으로 태깅(Tagging)한다. -60° ‒ 60° 범위에서 운전자가 백미러와 두 개 사이드 미러를 사용 하여 차량 주위의 도로 상황을 파악할 수 있기 때문에 ①, ②, ③, ④, ⑤, ⑥의 응시 영역에 있는 이미지들은 안전으로 표시 한다. 만약에 운전하는 과정에서 60°‒ 90°의 범위에 운전자의 응시 영역이 존재하면 눈으로 볼 수 없는 사각 지대인 -90°‒ -40° 범위의 도로 상황에 대하여 신속히 파악할 수 없다. 마찬 가지로 -90°‒ -60° 범위에서도 사각 지대인 40°‒ 90° 범위의 도 로 상황에 대하여 신속하게 파악할 수 없기 때문에 ⑦, ⑧의 응 시 영역에 있는 이미지들은 위험으로 표시한다. 다음으로 안 전과 위험으로 분류한 운전자의 상체 이미지들로 구성된 데이 터베이스를 사용하여 CNN 신경망에 대하여 학습(Train)한다.

2.3 컨볼루션 신경망 (CNN) 구조 설정

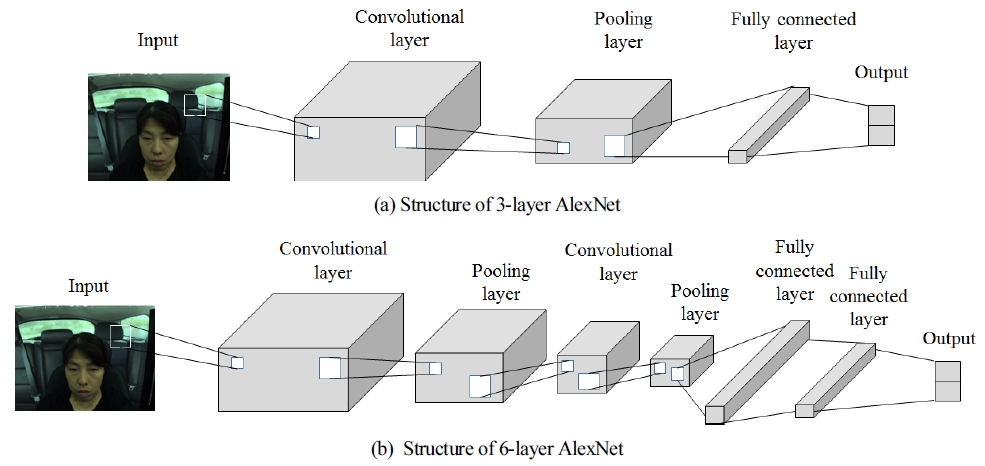

일반적으로 CNN 신경망의 구조는 컨볼루션 레이어 (Convolutional layer)와 풀링 레이어(Pooling layer)와 완전하 게 연결된 레이어(Fully connection layer) 등으로 구성한다. 각 각의 레이어의 수량의 조합 방식에 따라서 다양한 CNN 구조 를 만들 수 있다. CNN 신경망의 구조 중에서 AlexNet은 5개의 컨볼루션 레이어와 3개의 풀링 레이어와 3개의 완전하게 연결 된 레이어로 구성되어 있으며 이미지 인지에 대하여 일반적으 로 널리 사용되고 있는 CNN 신경망이다[10]. 기본적인 AlexNet 이 사용하는 데이터베이스는 ImageNet이며 ImageNet은 22,000개의 다른 유형의 이미지들로 구성되어 있다. 제안한 시 스템은 운전자 가상 실험 플랫폼에 설치된 카메라로부터 수집 된 운전자의 앉아있는 상체 이미지로 구성된 데이터베이스를 사용한다. 따라서 논문에서 제안한 시스템에 적합한 AlexNet 의 구조를 찾기 위하여 기본적인 AlexNet을 변화시켜서 [Fig. 4]와 같이 3개의 레이어로 구성된 AlexNet과 6개의 레이어로 구성된 AlexNet의 구조로 설정한다.

[Fig. 4 (a)]는 3개의 레이어 AlexNet의 구조를 나타내고 1개 의 컨볼루션 레이어와 1개의 풀링 레이어와 1개의 완전하게 연결된 레이어로 구성한다. 컨볼루션 레이어에서 사용한 커널 (Kernel)의 크기는 11×11이고 보폭(Stride)은 4이다. 풀링 레이 어의 커널의 크기는 3×3으로 설정하고 보폭은 2로 설정한다. 컨볼루션 레이어, ReLU (Rectified Linear Unit), LRN (Local Response Normalization), 풀링 레이어의 순서로 연결한다.

[Fig. 4 (b)]는 2개의 컨볼루션 레이어와 2개의 풀링 레이어 와 2개의 완전하게 연결된 레이어로 구성된 6개의 레이어 AlexNet 구조를 나타낸다. 첫 번째의 컨볼루션 레이어와 풀링 레이어의 파라미터의 설정은 3개의 레이어 AlexNet 구조와 같 다. 두 번째 컨볼루션 레이어의 파라미터 커널의 크기와 보폭 은 각각 5×5와 4이다. 기본적인 AlexNet 구조에서는 첫 번째의 완전하게 연결된 레이어의 입력데이터의 크기가 6×6이다. 따 라서 6개의 레이어 AlexNet 구조의 두 번째의 풀링 레이어와 완전하게 연결된 레이어를 연결하고 두 번째 풀링 레이어의 파라미터 커널과 보폭을 설정하기 위하여 식 (1)을 사용한다 .

| (1) |

여기에서 F는 출력 데이터의 크기를 나타내고 Fb는 이전 레이어에서 획득된 데이터의 크기를 나타낸다. k와 s는 각각 커널과 보폭의 값을 나타낸다. 6개의 레이어 AlexNet 구조에 서 식 (1)을 적용하여 두 번째의 컨볼루션 레이어의 출력 데이 터의 크기를 계산하고 그 결과 27×27 (F = 27) 크기의 이미지 를 얻을 수 있다. 다음으로 풀링 레이어에서 6×6 (F = 6) 크기 의 출력 데이터를 얻기 위하여 F와 Fb 의 값을 각각 6과 27로 설정한다. 그 결과 파라미터 커널과 보폭의 값들은 [7,2], [12,3], [7,4]로 계산될 수 있다. [Table 2]에서 나타난 바와 같이 6 개의 레이어 AlexNet 구조를 6_1, 6_2, 6_3과 같이 파라미터 값 들을 설정하였다.

3. 실험결과

제안한 시스템의 성능을 테스트하기 위하여 3명의 여성과 2명의 남성으로 구성된 총 5명의 운전자가 시나리오별로 촬영 한 운전자의 머리 운동 이미지들로 구성된 데이터베이스를 수 집한다. 각각의 운전자에 대하여 227×227의 크기의 1,000장 이미지들을 수집하고 안전과 위험으로 분류된 이미지들은 각 각 총 500장씩이다. 각각의 응시 영역에 대한 이미지 개수는 [Table 3]에서 나타낸다. 예를 들면 1번 운전자는 설정한 시나 리오들을 사용하여 ①과 ⑤번의 응시 영역에 대하여 각각 50 장과 96장 이미지들을 사용한 것을 알 수 있다. 실험에 사용한 AlexNet 기반의 CNN 신경망은 MATLAB 2017a Neural Network Toolbox에서 제공하는 것을 사용하였으며 딥러닝 과 정은 GPU 방식으로 진행한다. 실험 평가를 위하여 10-겹 교차 검증 방법(10-fold cross validation)으로 계산한다.

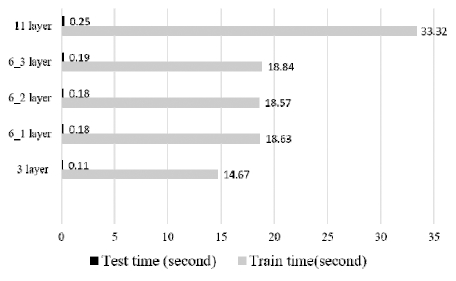

제안한 시스템은 [Table 4]에서 나타난 바와 같이 3개의 레 이어 AlexNet과 6개의 레이어 AlexNet과 기본적인 11개의 레 이어 AlexNet의 신경망을 사용하여 정확도에 대하여 비교한 다. Avg와 Var은 10-겹 교차 검증 방법의 정확도에 대한 평균 값(Average)과 분산 값(Variance)을 의미한다. 6개의 레이어 AlexNet의 결과는 6_3에서 사용한 파라미터 값이 6_1과 6_2 보다 높은 정확도를 나타내기 때문에 6_3의 결과를 6개의 레 이어 AlexNet의 대표로 사용한다. 본 시스템은 AlexNet을 사 용하여 95% 의 높은 성능을 얻을 수 있고, 특히 설정한 6개의 레이어 구조가 기본적인 11개의 레이어 AlexNet과 거의 비슷 한 정확도를 나타내는 것을 확인할 수 있다. 각각의 AlexNet 별로 훈련 시간과 테스트 시간에 대한 결과를 [Fig. 5]에서 나 타내고 있다. [Fig. 5]에서 회색 바는 훈련 시간을 나타내고 검 정색 바는 테스트 시간을 의미하며 시간의 측정 단위는 초 (Second)이다. 실험 결과를 분석하면 각각의 AlexNet 구조에 대한 테스트 시간은 비슷한 것을 알 수 있으나 훈련 시간은 제 안한 6개의 레이어 AlexNet이 기본적인 11개의 레이어 AlexNet보다 더 짧은 시간을 사용하는 것을 확인할 수 있다.

마지막으로 [Table 5]은 제안한 6개의 레이어 AlexNet의 안 전의 상태와 위험의 상태를 인지한 결과를 분석한 것을 나타 낸다. [Table 5]에서 True negatives는 정확하게 인지하는 확률 을 의미하고 False negatives는 오판하는 확률을 나타낸다. 먼 저 True negatives는 6개의 레이어 AlexNet의 안전한 상태와 위 험한 상태에 대하여 95%의 높은 정확률을 나타냄을 알 수 있 다. 다음으로 False negatives에서는 오판에 대하여 5%의 낮은 오판율을 유지할 수 있다. 또한 제안한 시스템은 0.001과 0.002 의 분산 결과로 안전성을 가지고 있는 것을 알 수 있다.

4. 결 론

본 논문은 딥러닝 기반을 기반으로 운전자의 안전한 상태 와 위험한 상태를 인식하는 시스템을 개발하였다. 제안한 6개 의 레이어 AlexNet 신경망을 이용하여 운전자의 눈의 사각지 대에 대한 안전한 상태와 위험한 상태에 대하여 95%의 높은 정확도로 인지할 수 있음을 알 수 있다. 또한 기본적인 11개의 레이어 AlexNet의 성능을 유지하면서 레이어 수량의 개선으 로 더 짧은 시간을 사용하기 때문에 운전자의 안전한 상태와 위험한 상태를 빠르게 인지할 수 있다. 개발된 시스템에 대하 여 추후 더 많은 시나리오에 대한 대용량 데이터베이스의 작 성이 필요하고 실시간의 실제 환경에서의 적용도 필요하다.

Acknowledgments

This work was supported by a National Research Foundation of Korea Grant funded by the Korean Government (No. 2016H1D5A 1911113).

References

-

S. Kannan, A. Thangavelu, R. Kalivaradhan, An intelligent Driver Assistance System (I-DAS) for vehicle safety modelling using ontology approach., International Journal of UbiComp, (2010), 1(3), p15-29.

[https://doi.org/10.5121/iju.2010.1302]

- N-N. Zheng, S. Tang, H. Cheng, Q. Li, G. Lai, F-W. Wang, Toward intelligent driver-assistance and safety warning system., IEEE Intell. Syst., (2004), 19(2), p8-11.

-

T. Horberry, J. Anderson, M.A. Regan, T.J. Triggs, J. Brown, Driver distraction: The effects of concurrent in-vehicle tasks, road environment complexity and age on driving performance., Accid. Anal. Prev., (2006), 38(1), p185-191.

[https://doi.org/10.1016/j.aap.2005.09.007]

-

Y.M. Cheung, Q. Peng, Eye gaze tracking with a web camera in a desktop environment., IEEE Trans. Hum. Mach. Syst., (2015), 45(4), p419-430.

[https://doi.org/10.1109/thms.2015.2400442]

-

X. Fu, X. Guan, , oAutomatic calibration method for driver's head orientation in natural driving environment., IEEE Trans. Intell. Transp. Syst., (2013), 14(1), p303-312.

[https://doi.org/10.1109/tits.2012.2217377]

-

A. Tawari, S. Martin, M.M. Trivedi, Continuous head movement estimator for driver assistance: Issues, algorithms, and on-road evaluations., IEEE Trans. Intell. Transp. Syst., (2014), 15(2), p818-830.

[https://doi.org/10.1109/tits.2014.2300870]

- S.Y. Cheng, M.M. Trivedi, Turn-intent analysis using body pose for intelligent driver assistance., IEEE Pervasive Comput., (2006), 5(4), p28-37.

- S.J. Lee, J. Jo, H.G. Jung, K.P. Park, J. Kim, Real-time gaze estimator based on driver ?(tm)s head orientation for forward collision warning system., IEEE Trans. Intell. Transp. Syst., (2011), 12(1), p254-267.

-

P.Y. Simard, D. Steinkraus, J.C. Platt, Best practices for convolutional neural networks applied to visual document analysis, 7th International Conference on Document Analysis and Recognition, Edinburgh, UK, p958-962, (2003).

[https://doi.org/10.1109/icdar.2003.1227801]

-

A. Krizhevsky, I. Sutskever, G.E. Hinton, ImageNet classification with deep convolutional neural networks., Commun. ACM, (2017), 60(6), p84-90.

[https://doi.org/10.1145/3065386]

-

S. Vora, A. Rangesh, M.M. Trivedi, On generalizing driver gaze zone estimation using convolutional neural networks, 2017 IEEE Intelligent Vehicles Symposium (IV), Los Angeles, USA, p849-854, (2017).

[https://doi.org/10.1109/ivs.2017.7995822]

-

I.H. Choi, S.K. Hong, Y-G. Kim, Real-time categorization of driver's gaze zone using the deep learning techniques, 2016 International Conference on Big Data and Smart Computing, Hong Kong, China, p143-148, (2016).

[https://doi.org/10.1109/bigcomp.2016.7425813]

2009 심양사범대학교 컴퓨터공학 학사

2013 경북대학교 기계공학과 석사

2013~현재 경북대학교 대학원 로봇공학과 박사과정

관심분야: 딥러닝, 인공지능, 자율주행차, 청소 로봇

2001 대구대학교 컴퓨터정보공학부 학사

2003 경북대학교 컴퓨터공학과 석사

2014 ~현재 경북대학교 기계공학과 박사과정

관심분야: 딥러닝, 인공지능, 기계학습, 자율주행차