유아의 생물 개념 발달 연구를 위한 인간형 로봇 플랫폼의 개발

© Korea Robotics Society. All rights reserved.

Abstract

In this paper, we describe a case of using robot technology in child studies to examine children’s judgement and reasoning of the life phenomenon on boundary objects. In order to control the effects of the appearance of the robot, which children observe or interact directly with, on the children's judgement and reasoning of the life phenomenon, we developed a robot similar to human. Unit experimental scenarios representing biological and psychological properties were implemented based on control of robot's motion, speech, and facial expressions. Experimenters could combine these multiple unit scenarios in a cascade to implement various scenarios of the human-robot interaction. Considering that the experimenters are researchers of child studies, there was a need to develop a remote operation console that can be easily used by non-experts in the robot field. Using the developed robot platform, researchers of child studies could implement various scenarios by manipulating the biological and psychological properties of the robot based on their research hypothesis. As a result, we could clearly see the effects of robot's properties on children’s understanding about boundary object like robots.

Keywords:

Children’s Biological Concepts, Boundary Objects, Judgement of the Life Phenomenon, Reasoning of the Life Phenomenon, Remote Operating Console, Humanoid Robot1. 서 론

인간은 유아기에 세 가지 핵심 지식(core knowledge) 을 가지고 무한한 자극들로 이루어진 세상을 이해한다. 구체적으로 마음 이론(theory of mind), 물리 이론(physical theory), 생물 이론(biological theory)으로 나눌 수 있다[1-3]. 이 가운데 생물 이론은 유아의 개념 발달을 연구하는 인지 발달 연구자들이 오랫동안 관심을 가져온 분야 중 하나이다. 어떤 대상이 살아 있다는 사실을 인식한다면, 대상의 다른 중요한 속성들을 추론할 수 있다[4]. 만약 유아가 성인과 구별되는 생물과 무생물의 구분 기준을 가진다면, 세상의 수많은 대상에 대하여 성인과는 다른 사고를 할 것이다. 이것이 유아의 생물 개념에 대하여 많은 연구자들이 관심을 가지고 연구해온 주요한 이유 이다.

유아가 선천적으로 생물 지식을 가지는지에 대해서는 생득주의 입장[5-8]과 구성주의 입장[1,9] 사이에서 이론적 논쟁이 계속되고 있다. 특히 논쟁의 중심이 되는 연령은 Piaget[9]의 개념 발달 단계 중 전조작기에 해당하는 3~5 세 유아이다. 따라서 생물 개념 발달에 대한 이론적 논쟁 을 규명하기 위해서는 이 시기 유아의 생물 개념 발달을 면밀히 살펴볼 필요가 있다.

생물 개념 발달과 관련된 선행 연구에 따르면 영아도 대상의 외양[10], 다리의 유무[11], 목표 지향적 움직임의 여부[12] 등을 근거로 동물과 사물을 구분하는 것으로 보 인다. 또한 초보 생물 이론(naive biology) 학자들은 유아 도 소멸, 성장, 재생과 같은 생물학적 속성을 근거로 생 물과 무생물을 분명하게 구분한다고 주장한다[13-R15]. 이 러한 연구 결과들은 생득주의 입장을 지지하는 증거로 볼 수 있다. 그러나 유아들의 생물에 대한 이해는 성인과 달리 여전히 직관적인 특성을 가지고 있어 연구 결과를 해석하는데 논란의 여지가 있다.

관련 선행 연구들은 대부분 명백한 생물이나 무생물 에 속하는 대상에 대한 유아의 이해를 살펴보았다. 따라 서 기존 연구를 통해서는 유아의 생물 개념과 지식을 생물과 무생물 영역의 어느 범위까지 적용할 수 있는지 설명하기 어렵다[16]. 과학 기술의 발달로 지능형 로봇과 같이 전통적인 존재론적 범주를 모호하게 만드는 새로 운 대상이 등장하였다. 지능형 로봇은 무생물의 속성을 가지고 있는 동시에 생물을 모방하고 있어 마치 살아 있는 것처럼 보이기도 한다. 이러한 경계선적 대상 (boundary object)은 유아가 기존에 가지고 있던 범주화 기제에 대한 갈등을 유발할 수 있어 유아의 생물에 대한 이해에 새로운 과제가 된다. 따라서 유아들이 경계선적 대상에 대한 인지적 갈등을 어떻게 해결하는지 살펴보 는 것은 유아의 생물 개념 발달을 확인할 수 있는 새로운 방법이 될 수 있다.

경계선적 대상을 사용하여 유아의 생명현상 이해를 살펴 본 연구는 많지 않다. 소수의 관련 선행 연구들에서 는 대부분 로봇 강아지(AIBO)와 같이 상용화된 동물 로 봇을 실험 도구로 사용하거나[17-19] 국내 연구에서는 아이 로비큐(iRobi Q)와 같은 교육용 로봇을 사용하였다[20,27]. 그러나 제품화되어 있는 로봇을 사용한 선행 연구에서 는 로봇의 외양을 비롯한 속성 및 동작 시나리오 등을 연구자의 가설 및 의도에 맞추어 조작하는데 한계가 있 다. 또한 상용화된 로봇을 사용하였기 때문에 유아의 사 전 경험이나 지식이 엄밀히 통제되지 못했다. 이러한 문 제를 해결하기 위해서 유아의 생물 개념 발달을 살펴보 는 연구 도구로 활용될 실험용 로봇을 직접 개발할 필요 가 있다. 본 연구에서는 인간 유사성 유추[21], 신체적 유 사성에 의한 귀납 추론[22]과 같은 유아의 발달 특성을 고려하여 기존 연구에서 사용한 로봇보다 더 정교하게 인간의 외형을 모방한 로봇을 제작하여 유아에게 제시 하고자 한다. 유아에게 이러한 인간형 로봇 플랫폼을 제 시하는 경우 이는 유아의 생물과 무생물 범주화 수행에 가장 도전적인 과제가 될 것이다. 또한 실험용으로 개발 된 로봇을 제시함으로써 대상에 대한 유아의 사전 경험 을 통제할 수 있다. 마지막으로 인간형 로봇을 사용할 경우 연구자가 유아의 생명 현상 판단과 추론에 영향을 미칠 것으로 보이는 변수들을 Wizard of OZ 기법[23]을 사용하여 실험 조작할 수 있다. 이에 따라 유아의 생물 개념의 구체적인 특성이 무엇인지 확인할 수 있고, 엄격 한 실험 스크립트를 사용하여 이를 측정할 수 있다는 연구 방법론적 의의가 있다.

유아의 생명 현상 판단과 추론에 영향을 미칠 수 있는 대표적인 요인으로 ‘자율적 운동성(autonomous movement)’[ 24-25]이 있다. 또한 대상을 마음을 가진 심리사회 적 존재(mentalistic agent)로 이해하는데 중요한 단서로 작용하는 것 중 하나가 대상의 ‘수반적 상호작용성 (contingent interaction)’[26]이다. 본 연구에 적용될 인간 형 로봇 플랫폼은 운동성과 같은 생물학적(biological) 속성과 수반된 정서 표현과 같은 심리적(psychological) 속성을 인위적으로 구현할 수 있다. 따라서 로봇을 사용 한 연구는 전조작기 유아의 생물 개념 발달에 영향을 미치는 요인을 밝히는데 효과적일 것으로 보인다. 또한 실험 연구를 통해서 대상이 가진 속성의 영향력이 첨예 하게 드러날 것으로 기대한다.

이상의 문제 제기에 따라 본 연구에서는 유아의 생물 과 무생물의 범주화에 있어서 가장 강력한 인지 갈등을 유발시킬 것으로 예상되는 인간형 로봇을 연구 도구로 개발하였다. 2장에서는 이러한 유아의 생물 개념 발달에 결정적인 영향을 미칠 것으로 보이는 대상의 형태학적 특성, 자율적 운동성, 수반적 상호작용성 등과 같은 연구 도구가 갖추어야 하는 속성들을 고려한 인간형 로봇 플 랫폼 개발의 요구사항에 대하여 기술한다. 3장에서는 이 러한 개발 요구사항을 기준으로 개발된 인간형 로봇 플 랫폼의 하드웨어 구성에 대해서 기술한다. 4장에서는 아 동학 연구자를 고려하여 개발된 LABVIEW 기반의 인간- 로봇 상호작용 시나리오 조작용 제어 패널 (control panel) 에 대해서 기술한다. 마지막으로 5장에서는 개발된 인간 형 로봇 플랫폼의 인간-로봇 상호작용 실험의 활용 결과 및 의의에 대해서 기술한다.

2. 개발 요구사항 분석

본 연구에서 개발하는 로봇 플랫폼은 유아의 경계선 적 대상에 대한 생명현상 판단과 추론을 살펴보기 위한 연구에 적용된다. 유아가 관찰하거나 직접 상호작용할 대상인 로봇의 외양이 유아의 생명현상 판단 및 추론에 미치는 영향[17]을 통제하기 위해서 본 연구에서 개발할 로봇은 인간의 모습을 가지도록 한다. 구체적으로 로봇 은 얼굴, 눈, 눈썹이 있고, 팔, 다리, 몸통이 있으며, 동작, 표정, 발화를 통하여 유아와 직·간접적으로 상호작용할 수 있도록 개발될 필요가 있다. 특히 사전 예비 조사에서 타 인간형 로봇과 실험자의 상호작용 장면을 촬영한 동 영상을 3~5세 유아들에게 제시한 후 개별 유아를 인터뷰 한 결과, 유아들이 로봇의 정서 표현을 명확히 인식하지 못하거나 로봇이 발화의 주체임을 이해하지 못하는 경 우가 발견되었다. 예비 조사에서 사용한 인간형 로봇은 눈의 모양을 변화시킴으로써 정서를 표현하였지만 3~5 세 유아가 이를 인식하는데 어려움을 느끼는 것으로 확 인되었다. 또한 로봇의 입 모양이 점으로 표현되어 있고, 로봇이 발화를 할 때 입이 움직이지 않기 때문에 유아가 인간형 로봇이 말을 한다는 사실을 인식하지 못하는 경 우가 나타났다. 따라서 본 연구에서 개발할 인간형 로봇 은 정서가 더 명확히 전달되도록 눈썹과 눈꺼풀의 움직 임까지 정교하게 제어될 필요가 있다. 또한 발화의 주체 가 로봇임을 표현하기 위하여 로봇이 말을 할 때 입도 함께 움직이도록 설계되어야 한다.

경계선적 대상에 대한 유아의 생명현상 판단과 추론 에 영향을 미칠 것으로 보이는 속성들(‘운동성’과 같은 생물학적 속성, ‘정서 표현’과 같은 심리적 속성)의 조합 에 따라 여러 가지 유형의 실험 자극이 구현될 수 있도록 운영 콘솔도 함께 개발될 필요가 있다. 특히 인간-로봇 상호작용 실험에 외부의 자극을 차단하고, 실험 스크립 트 상의 변수들 이외의 로봇의 자율 반응으로 발생할 가능성이 있는 변수들을 통제하기 위하여 WoZ 기술을 기반으로 로봇을 조작할 필요가 있다. WoZ 기술을 사용 하여 원격조정자인 실험자가 실험 스크립트대로 로봇을 조정하며, 수집된 데이터는 로봇에 장착된 센서를 통해 서 실험자에게 전달되어 전반적인 실험 상황을 관찰할 수 있어야 한다. 따라서 로봇의 동작, 발화, 표정의 제어 를 기반으로 생물학적 속성 및 심리적 속성들을 표현하 는 단위 실험 스크립트들이 구현되어야 한다. 단위 실험 스크립트들을 구성하는 단위 동작, 표정, 발화의 구체적 인 예는 Table 1과 같다. 실험자는 이러한 다수의 단위 실험 스크립트들을 연쇄적으로 연결함으로써 인간-로봇 상호작용을 위한 전체 시나리오를 구현할 수 있다. 이 때 로봇 운영 콘솔의 사용자가 아동학 연구자들임을 감 안하여 로봇 분야의 비전문가도 손쉽게 시나리오를 구 현할 수 있는 개발환경을 제공해야 한다.

3. 하드웨어 구성 및 설계

본 장에서는 앞서 분석한 인간형 로봇의 개발 요구사 항에 따른 로봇 기구부 및 제어부의 하드웨어 구성 및 설계에 대해서 기술한다.

3.1. 기구부

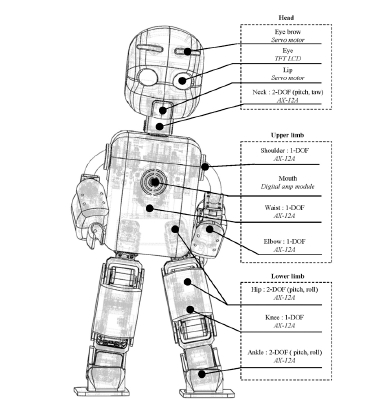

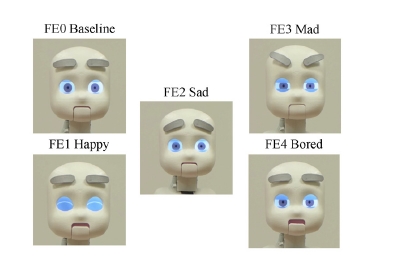

본 연구를 통하여 개발된 인간형 로봇은 얼굴형을 원 형으로 하고, 눈, 눈썹, 코, 입이 모두 나타나도록 제작하 였다. Fig. 1은 개발된 인간형 로봇의 기구부 구성을 나 타낸다. Table 1의 MO0부터 MO10까지의 미리 정의된 단위 동작들을 구현하기 위한 신체의 각 관절 자유도 구성은 목 2자유도, 어깨 1자유도, 팔꿈치 1자유도, 허리 1자유도, 고관절 2자유도, 무릎 1자유도 그리고 발목 2자 유도의 총 17자유도로 설계되었다. 그리고 FE0부터 FE4 까지의 단위 표정들을 표현하기 위한 눈썹과 입은 각각 1자유도이며 눈 부분에는 컬러 LCD를 적용하였다. 특히 기존 상용 로봇들과는 달리 로봇의 생명현상을 비롯한 정서 상태를 유아에게 명확히 전달하기 위하여 눈동자, 눈꺼풀, 눈 깜빡임을 구현하였고, 그 결과는 Fig. 6과 같다.

눈썹과 입을 제외한 나머지 모든 관절의 17축 구동 모터는 로보티즈(Robotis)의 Dynamixel AX-12A를 적용 하였으며, 몸체의 외형 중 얼굴 부분은 Wiki for iCub and Friends에 공개된 iCub 로봇의 캐드 모델을 활용하 여 3D 프린팅 되었다.

3.2. 제어부

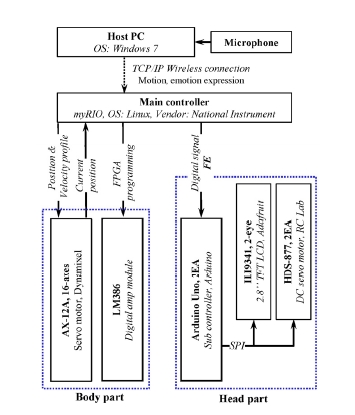

Fig. 2는 로봇에 적용된 제어 하드웨어의 구체적인 정 보를 나타내고 있다. 동작 제어, 실시간 음성 전송 및 표정 제어를 위하여 National Instruments 사의 실시간 제어기인 myRIO가 주 제어기로서 적용되었다. 정서 표 현을 위한 눈의 컬러 LCD와 눈썹의 1축 서보모터의 제 어를 위하여 2대의 Arduino Uno가 myRIO의 하위 제어 기로서 연결되었다. 인간-로봇 상호작용 실험에서 WoZ 구현을 위한 원격 운영 콘솔의 역할을 하는 호스트 PC는 모바일 기기 또는 노트북 PC 모두 가능하도록 하였고, 로봇에 설치된 myRIO의 무선 AP (access point)를 기반 으로 무선통신이 가능하도록 하드웨어를 구성하였다.

각 관절을 담당하는 AX-12A 모터는 16개가 모두 서 로 직렬 연결되어 있어 모터에 내장된 드라이버들을 1개 의 통신 채널을 이용하여 100 ms 이하 급으로 동시에 제어할 수 있다. 따라서 myRIO의 1개 UART 통신 채널 을 기반으로 각 모터의 원하는 속도 프로파일과 위치를 전송하고 각 모터의 상태를 수신 받는다. 2개의 Arduino Uno에는 Table 1에 기재된 5가지 표정(FE)에 해당하는 왼쪽 눈 과 오른쪽 눈 이미지가 각각 픽셀(pixel) 단위로 저장되어 있어 myRIO에서 필요한 눈의 이미지에 할당 된 인덱스 값을 Arduino uno로 전달하면 컬러 LCD에 해당하는 눈 모양이 출력된다. myRIO의 명령과는 독립 적으로 지속적인 눈꺼풀의 깜박임을 구현하였고, 2개의 컬러 LCD 출력 동기화를 위하여 2개의 Arduino 보드를 2 kHz 주기율의 디지털 신호를 사용하여 서로 동기화하 였다.

4. 원격 운영 콘솔 개발

본 장에서는 원격조정자인 실험자가 미리 정의된 인 간-로봇 상호작용의 단위 실험 스크립트들을 기반으로 하나의 완성된 시나리오를 프로그래밍하여 로봇의 동작, 발화, 표정을 제어할 수 있도록 개발된 원격 운영콘솔에 대하여 기술한다. 유아 대상 실험의 연속성 및 다양성을 고려하여 미리 정의된 단위 실험 스크립트들을 기반으 로 다양한 실험 시나리오를 생성할 필요가 있고 로봇 기술의 비전문가도 손쉽게 전체 시나리오를 구현할 수 있도록 하는 운영 콘솔이 개발될 필요가 제기되었다. 본 연구에서는 현재 상품화되어 보급될 예정인 지능형 서 비스 로봇들이 가지고 있는 지능 수준과 유사한 지능 수준으로 실험용 로봇을 조작하여 인간-로봇 상호작용 실험 스크립트에 따라 행동하는 인간형 로봇을 동영상 으로 촬영한 후 동영상 자극을 유아에게 제시하였다. 그 러나 추후의 확장 연구를 위해서 실제로 유아-로봇 상호 작용 실험을 위해서는 원격조정자인 실험자가 피실험자 인 아동의 반응을 살펴가며 실시간으로 로봇을 조정할 수도 있어야 한다.

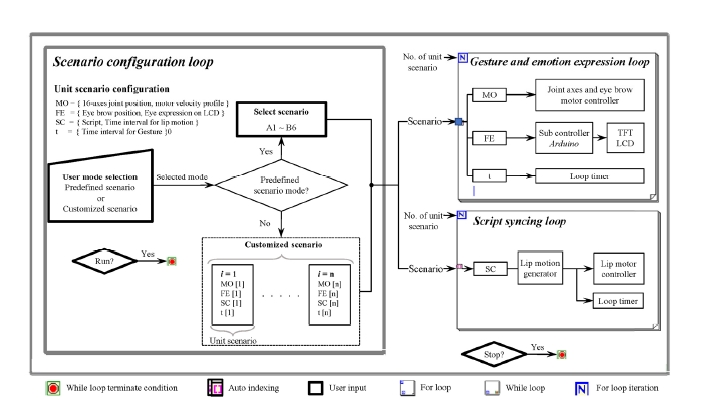

Fig. 3은 LABVIEW 기반으로 개발된 운영콘솔의 알 고리즘 블록 다이어그램이다. 시나리오 설정을 위한 루 프에서는 사전 정의 시나리오(predefined scenario)와 다 수의 단위 실험 스크립트들의 연쇄된 조합으로 정의되 는 맞춤형 시나리오(customized scenario)의 실행 모드를 결정할 수 있다.

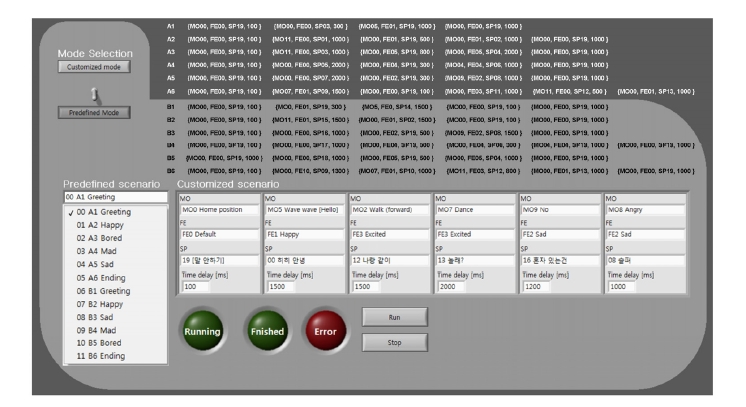

사전 정의 시나리오는 Table 1과 Fig. 4와 같이 여러 개 의 단위 실험 스크립트들로 구성되고, Fig. 4의 LABVIEW 프론트패널에서와 같이 드롭다운(drop-down) 방식의 리 스트 박스에서 선택할 수 있다. 선택된 사전 정의 시나리 오가 실행되면 상태표시 LED를 통하여 실행 상태를 확 인할 수 있고, 실행이 완료된 후 다음 입력을 대기하는 방식으로 설계되었다. 또한 맞춤형 시나리오는 여러 개 의 단위 실험 스크립트들로 구성되며, 각각의 단위 실험 스크립트는 단위 동작(MO), 표정(FE), 발화(SP) 및 단위 스크립트 소요시간(time delay)으로 구성된다. 단위 스크 립트의 수에는 제한이 없으며 리스트 박스에서 단위 동 작, 표정 및 발화를 선택하는 방식으로 1번부터 N번째까 지의 단위 실험 스크립트를 생성하고 조합할 수 있다.

이와 같이 생성된 시나리오들은 동작·정서 표현을 위 한 gesture & emotion expression 및 script syncing 루프 로 전달되어 1번부터 N번까지 차례대로 단위 시나리오 가 실행되도록 설계되었다. 최종적으로 모든 실험이 종 료되면 종료버튼을 누름으로써 입력 대기 모드가 종료 된다.

5. 실험 결과 토의

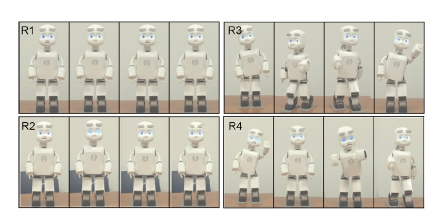

Fig. 6은 개발된 로봇의 눈의 모양 및 깜빡임, 눈썹 및 입의 동작의 제어를 통하여 표현한 5가지의 정서 표 현 결과이다. Fig. 5는 생물학적 속성인 운동성과 심리적 속성인 정서 표현 여부에 따라 4가지 조건으로 구성된 실험 시나리오를 로봇에 적용하여 작동한 결과이다. 로 봇과 인간(실험자) 사이의 상호작용 장면을 표현한 실험 시나리오는 ‘인사하기’, ‘자기 소개하기’, ‘이동 명령’ 등 의 세션들로 구성되며 각 세션에서 로봇은 실험 조건에 따라 다르게 반응한다.

Multiple snapshots of the developed robot operated in four different experimental scenarios: R1 (immobile and psychologically non-contingent condition), R2 (immobile and psychologically contingent condition), R3 (mobile and psychologically non-contingent condition), and R4 (mobile and psychologically contingent condition)

구체적으로 개발된 로봇 플랫폼은 다양한 생물학적 속성 중 유아의 생명현상 이해에서 중요한 요인으로 보 고되고 있는 운동성[25] 여부와 심리적 속성 중 로봇을 범주 경계선적 대상으로 만드는 강력한 요소 중 하나인 정서 표현 능력[28]의 보유 여부에 따라 네 가지 유형의 로봇으로 구현되었다. 다시 말해 생물학적 속성인 ‘운동 성’과 심리적 속성인 ‘정서 표현’이 나타나지 않는 인간 형 지능로봇(R1), 심리적 속성인 ‘정서 표현’만 나타나는 인간형 지능로봇(R2), 생물학적 속성인 ‘운동성’만 나타 나는 인간형 지능로봇(R3), 생물학적 속성과 심리적 속 성이 모두 나타나는 인간형 지능로봇(R4)으로 구분되며, 이 네 가지 유형의 로봇이 3~5세 유아들에게 제시되었 다. 유아는 각 로봇이 인간(실험자)과 상호작용하는 모 습을 관찰한 후 개별 면접을 통하여 각 로봇에 대한 생명 현상 판단과 추론 과제를 수행하였고, 그 결과 인간형 로봇에 대한 유아의 생명현상 판단과 추론이 연령 및 로봇의 속성에 따라 다르게 나타나는 것을 확인할 수 있었다.

본 연구에서 개발된 인간형 로봇 플랫폼은 예비 조사 에서 사용한 타 인간형 로봇과 비교했을 때 눈썹, 눈꺼 풀, 눈의 모양, 입의 움직임을 통하여 유아에게 로봇의 심리적 속성인 정서 표현 능력을 더욱 명확하게 전달할 수 있었다. 앞서 언급한 유아의 인간-로봇 상호작용 관찰 실험 연구를 통해서 로봇의 심리적 속성 구현이 5세 유 아와 같이 연령이 높은 유아의 경우에도 인공물인 로봇 을 생명현상을 가지는 존재로 인식하도록 하는데 영향 을 미침을 확인할 수 있었다.

또한 로봇 비전문가가 단위 실험 스크립트들을 기반 으로 원하는 실험 시나리오를 손쉽게 생성할 수 있도록 개발된 운영콘솔을 통하여 연구자가 연구 가설을 바탕 으로 선정한 변수들을 간편하게 실험 조작할 수 있었다. 이를 통해 로봇의 속성들(생물학적 속성, 심리적 속성) 이 유아의 생명현상 판단과 추론에 미치는 영향을 명확 하게 비교할 수 있었다. 구체적으로 경계선적 대상에 대 한 유아의 생명현상 판단과 추론에 로봇의 속성이 미치 는 영향은 유아의 연령에 따라 차이가 나타났다. 3세 유 아는 대상의 속성과 상관없이 인간형 로봇을 생물로 이 해하는 경향이 나타났으나 4세 유아는 인간형 로봇에게 ‘운동성’과 같은 생물학적 속성이 나타날 때, 5세 유아는 인간형 로봇에게 ‘정서 표현’과 같은 심리적 속성이 나타 날 때 경계선적 대상인 인간형 로봇을 생명현상이 있는 존재로 인식할 가능성이 높아진다는 사실을 확인하였다.

마지막으로 이 연구에서는 개별 유아와 인간형 로봇 간의 상호작용 효과를 통제하기 위하여 영상을 매체로 인간-로봇 상호작용 장면을 유아가 관찰하는 연구 방법 을 사용하였다. 그러나 실제로 유아가 구체물인 인간형 로봇과 상호작용을 하는 경험이 유아의 생명현상 판단 과 추론의 형태를 변경시킬 가능성도 있다[19]. 따라서 후 속 연구에서는 본 연구에서 개발된 인간형 로봇과 유아 가 실제 상호작용을 할 수 있도록 실험 연구를 설계하고 수행함으로써 이러한 가능성을 확인해 볼 필요가 있다.

References

-

Carey, S., Conceptual change in childhood, MIT Press, (1985).

[https://doi.org/]

-

Spelke, E.S., Initial knowledge: Six suggestions, Cognition, (1994), 50(1), p431-445.

[https://doi.org/10.1016/0010-0277(94)90039-6]

-

Wellman, H.M., Gelman, S.A., Cognitive development: Foundational theories of core domains, Annu. Rev. Psychol, (1992), 43(1), p337-375.

[https://doi.org/10.1146/annurev.ps.43.020192.002005]

-

Keil, F.C., The origins of an autonomous biology., Modularity and constraints in language and cognition: The Minnesota symposia on child psychology, Hillsdale, NJ, Erlbaum, (1992), Vol. 25, p103-137.

[https://doi.org/]

-

Fordor, J.A., Precis of the modularity of mind, Behav. Brain Sci, (1985), 8(1), p1-5.

[https://doi.org/]

-

Gopnik, A., Meltzoff, A.N., Bryant, P., Words, thoughts and theories, Cambridge, MA, MIT Press, (1997), Vol. 1.

[https://doi.org/]

-

Keil, F.C., Lockhart, K.L., Explanatory understanding in conceptual development., Conceptual development: Piaget’s legacy, Scholnick, E.K., Nelson, K., Gelman, S., Miller, P., Mahwah, NJ, Lawrence Erlbaum Associates, Inc., (1999), p103-130.

[https://doi.org/]

-

Wellman, H.M., Gelman, S.A., Knowledge acquisition in foundational domains., Cognition, perception, and language, Damon, W., Kuhn, D., Siegler, R.S., Handbook of child psychologyHoboken, NJ, John Wiley & Sons, Inc., (1998), p523-573.

[https://doi.org/]

-

Piaget, J., The children’s conception of the world, London, Kegan Paul, (1929).

[https://doi.org/]

-

Scherf, K.S., Behrmann, M., Humphreys, K., Luna, B., Visual category‐selectivity for faces, places and objects emerges along different developmental trajectories, Dev. Sci, (2007), 10(4), pF15-F30.

[https://doi.org/10.1111/j.1467-7687.2007.00595.x]

-

Rakison, D.H., Butterworth, G.E., Infants’ use of object parts in early categorization, Dev. Psychol, (1998), 34(1).

[https://doi.org/10.1037/0012-1649.34.1.49]

-

Rakison, D.H., Cicchino, J.B., Hahn, E.R., Infants’ knowledge of the path that animals take to reach a goal, Br. J. Dev. Psychol, (2007), 25(3), p461-470.

[https://doi.org/10.1348/026151006x171893]

-

Backscheider, A.G., Shatz, M., Gelman, S.A., Preschoolers’ ability to distinguish living kinds as a function of regrowth, Child Dev, (1993), 64(4), p1242-1257.

[https://doi.org/10.2307/1131337]

-

Inagaki, K., Hatano, G., Young children’s recognition of commonalities between animals and plants, Child Dev, (1996), 67(6), p2823-2840.

[https://doi.org/10.2307/1131754]

-

Rosengren, K.S., Gelman, S.A., Kalish, C.W., McCormick, M., As time goes by: Children’s early understanding of growth in animals, Child Dev, (1991), 62(6), p1302-1320.

[https://doi.org/10.2307/1130808]

-

Erickson, J.E., Keil, F.C., Lockhart, K.L., Sensing the coherence of biology in contrast to psychology: Young children’s use of causal relations to distinguish two foundational domains, Child Dev, (2010), 81(1), p390-409.

[https://doi.org/10.1111/j.1467-8624.2009.01402.x]

-

Jipson, J.L., Gelman, S.A., Robots and rodents: Children’s inferences about living and nonliving kinds, Child Dev, (2007), 78(6), p1675-1688.

[https://doi.org/10.1111/j.1467-8624.2007.01095.x]

-

Melson, G.F., Kahn, P.H., Beck, A., Friedman, B., Roberts, T., Garrett, E., Gill, B.T., Children’s behavior toward and understanding of robotic and living dogs, J. Appl. Dev. Psychol, (2009), 30(2), p92-102.

[https://doi.org/10.1016/j.appdev.2008.10.011]

-

Okita, S.Y., Schwartz, D.L., Young children’s understanding of animacy and entertainment robots, International Journal of Humanoid Robotics, (2006), 3(3), p393-412.

[https://doi.org/10.1142/s0219843606000795]

-

Hyun, E., Son, S., Is robot alive?: Young children’s perception of a teacher assistant robot in a classroom, Korean Journal of Child Studies, (2011), 32(4), p1-14.

[https://doi.org/10.5723/kjcs.2011.32.4.1]

-

Gutheil, G., Vera, A., Keil, F.C., Do houseflies think? Patterns of induction and biological beliefs in development, Cognition, (1998), 66(1), p33-49.

[https://doi.org/]

-

Springer, K., Children’s awareness of the biological implications of kinship, Child Dev, (1992), 63(4), p950-959.

[https://doi.org/10.2307/1131246]

-

Kahn, P.H. Jr, Kanda, T., Ishiguro, H., Freier, N.G., Severson, R.L., Gill, B., Ruckert, J.H., Shen, S., Robovie,you’ll have to go into the closet now: Children’s social and moral relationships with a humanoid robot, Dev. Psychol, (2012), 48(2), p303.

[https://doi.org/10.1037/a0027033]

-

Dolgin, K.G., Behrend, D.A., Children’s knowledge about animates and inanimates, Child Dev, (1984), 55, p1546-1650.

[https://doi.org/10.2307/1130034]

-

Margett, T.E., Witherington, D.C., The nature of preschoolers’ concept of living and artificial objects, Child Dev, (2011), 82(6), p2067-2082.

[https://doi.org/10.1111/j.1467-8624.2011.01661.x]

-

Johnson, S.C., Booth, A., O’Hearn, K., Inferring the goals of a nonhuman agent, Cogn. Dev, (2001), 16(1), p637-656.

[https://doi.org/10.1016/s0885-2014(01)00043-0]

-

Lee, K., Lee, B., The influence of educational robot experience on children’s robot image and relationship recognition, Journal of Korea Robotics Society, (2015), 10(2), p70-78.

[https://doi.org/10.7746/jkros.2015.10.2.070]

-

Turkle, S., Authenticity in the age of digital companions, Interact. Stud, (2007), 8(3), p501-517.

[https://doi.org/10.1075/is.8.3.11tur]

2006 서울대학교 아동가족학과(생활과학사)

2009 서울대학교 사범대학원 유아교육협동 과정(교육학석사)

2010~현재서 울대학교 생활과학대학 아동 가족학과 박사수료

관심분야: 아동 인지발달, Child-Robot Interaction

1974 서울대학교 가정관리학과(문학사)

1982 서울대학교 대학원 소비자아동학과 (문학석사)

1986 서울대학교 대학원 소비자아동학과 (문학박사)

1989~현재 서울대학교 생활과학대학 아동가족학과 교수 겸 생활과학연구소 연구원

관심분야: 아동학