비전 카메라 기반의 무논환경 자율주행 로봇을 위한 중심영역 추출 정보를 이용한 주행기준선 추출 알고리즘

© Korea Robotics Society. All rights reserved

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

In this paper, we propose a new algorithm of the guidance line extraction for autonomous agricultural robot based on vision camera in paddy field. It is the important process for guidance line extraction which finds the central point or area of rice row. We are trying to use the central region data of crop that the direction of rice leaves have convergence to central area of rice row in order to improve accuracy of the guidance line. The guidance line is extracted from the intersection points of extended virtual lines using the modified robust regression. The extended virtual lines are represented as the extended line from each segmented straight line created on the edges of the rice plants in the image using the Hough transform. We also have verified an accuracy of the proposed algorithm by experiments in the real wet paddy.

Keywords:

Agricultural Robot, Autonomous Robot, Guidance Line, Vision Camera, Crop row detection1. 서 론

최근 농업현장에서 농업인구의 고령화와 인력감소 그리 고 생산성 저하가 큰 사회적 문제로 대두되고 있다. 이에 대한 대안으로 등장한 것이 정밀농업(Precision Agriculture) 이며 현대 로봇기술의 발달로 정밀농업의 핵심적인 역 할을 로봇이 수행하리라 기대되고 있다. 농업용 로봇 역시 여타 다른 로봇 응용분야와 마찬가지로 로봇의 작업 자 율화 및 자율주행에 많은 연구가 진행 중이다. 그 중 특 히 농업용 로봇의 자율주행의 큰 특징은 기계에 의해 규칙적 간격으로 심어진 작물을 피해 없이 주행해야 한 다는 것이다. 일반적인 서비스 로봇의 경우 장애물을 회 피하면서 목표점까지 주행하는 방식인 반면 농업용 로 봇의 경우 야외 불규칙 지형에서 작물열(Crop row)을 기준선으로 삼아 추종하는 방식으로 자율주행이 이루어 진다.

현재 농업용 로봇의 자율주행 분야의 많은 연구들은 비전카메라(Vision canera)를 이용한 객체인식(Object perception) 기반의 방법들이 주를 이루고 있는 상태이 다. 비전센서 기반의 정밀 방제용 로봇의 자율주행은 크 게 작물인식(Crop perception), 주행기준선 추출(Guidance line extraction), 로봇 모션제어(Robot motion control) 단 계로 구분할 수 있다. 그 중 주행기준선 추출은 인식된 작물열(Crop row) 이미지에서 로봇의 주행 기준선을 추 출하는 단계로 작물의 손상 없이 로봇이 정확하게 작물 열을 추종할 수 있도록 하는 중요한 과정이다.

이런 주행기준선의 정확도에 큰 영향을 미치는 요소 는 곡물의 잎, 줄기의 길이, 굵기, 방향, 밀집도 등과 같은 것들이 있다. 따라서 이렇게 주행 정확도에 영향을 미칠 수 있는 요소를 극복하는 주행기준선 추출 방법이 요구 된다고 할 수 있다. 특히 논농사에서 모(Rice)의 경우 여러 갈래의 가는 잎이 많은 형태로 인해 작물 열 영상에 서 주행기준선 추출의 정확도 확보가 어렵다. 이에 따라 정확한 주행기준선 추출을 위해서는 모의 형태학적 특 징에 의한 영향요소를 최소화 할 수 있는 주행기준선 추출 알고리즘이 필요하다[1-2].

주행기준선 추출을 위한 기존연구는 그 동안 매우 다 양한 접근방법이 제시되어왔다. 그 이유는 연구대상 작 물의 형태에 적합한 특성화된 방법들이 다양하게 제시 었기 때문이다. 이들 접근법은 다음과 같이 크게 3가지 로 구분할 수 있는데 영상의 픽셀 값 분포를 이용한 방법, 허프변환(Hough transform)을 이용한 방법 그리고 선형 회귀분석을 이용한 방법이다.

Søgaard[3]는 영상을 수평방향 영역으로 분할하여 수 평 띠(Strips)를 획득한 후 각 수평 띠를 하나의 띠로 합하 여 회색조 값의 합을 구한 후 원형 띠로 다시 표현하여 무게중심 결정을 통해 열의 위치로 투영시키는 방법을 사용하였다. Hana[4]는 작물열의 이진영상(Binary image) 에서 중심점과 방향각을 계산하여 주행기준선을 표현하 였다. 이런 방법들은 잎이 가는 작물의 경우 회색조 값 분포의 최대값이 항상 작물의 중앙에 놓이지 않아 이에 따른 오차를 발생시킬 수 있다. 대체적으로 이 방법론은 인식된 작물 영상의 형태가 전체적으로 균일하고 넓은 면적을 가지고 있을 경우 유리한 방법이라 할 수 있다.

다음은 대표적인 직선추출방법인 허프변환을 이용한 방법으로 Rovira-Ma[5]는 허프변환의 효율성을 높이기 위해 작물열 픽셀들의 중앙점을 연결한 골격화 선(Midpoint encoder)을 먼저 적용한 후 허프변환에 이용하여 기준선 을 획득하였다. Bakkera[6]는 작물열이 있는 공간을 사각 영역으로 분할하여 각 영상을 하나로 융합하여 회색조 값의 밀도를 높인 후 허프변환을 실시하여 영상 처리시 간을 단축하고자 했다. Ronghua Ji[7] 역시 Randomized 허프변환을 통해 계산시간 증가 문제를 해결하고자 했 다. 이런 접근법들은 인식된 작물의 중심점을 정확하게 인식하기 어렵다면 적용하기 어려운 방법으로 가늘고 긴 잎이 무성한 작물에서는 주행기준선의 정확도가 떨 어질 수 있다. 각 작물의 중심점의 정확도가 허프라인의 정확도에 큰 영향을 미치기 때문이다.

다음은 선형회귀분석을 이용한 방법으로 Billingsley[8] 는 정해진 영역(Window)안에 인식된 작물을 하나의 점 으로 가정하여 이 점들의 회귀선을 주행기준선으로 결 정하였다. Romeo[9]는 작물열 이진영상에서 최소제곱 선 형회귀(Least squares linear regression) 방법을 이용하였 으며, 모든 픽셀의 하단 열에서부터 모든 가능한 라인을 추적하여 추적된 직선 중에서 누적 녹색 픽셀수가 최대 가 되는 직선을 주행기준선으로 결정하였다. 이 방법은 선형 회귀선 추출을 위한 데이터 변화에 주행기준선의 정확도가 민감하게 반응하여 변한다는 단점이 있다[1-2].

선행연구에서 살펴본 바와 같이 주행기준선의 정확도 는 결국 각 작물의 중심점 또는 중심부위의 탐지정확도 에 큰 영향을 받는다. 특히 모와 같이 형태적으로 균일한 모양을 가지지 않는 작물의 경우 기존의 방법으로 정확 한 중심영역을 찾기 어려워 새로운 방법론이 요구된다. 본 논문에서는 무논환경에서 운용되는 제초작업용 로봇 의 주행기준선 정확도를 향상시키는 새로운 주행기준선 추출 알고리즘을 제안하고자 한다. 본 논문 중 2장에서 는 정밀 방제용 자율주행 로봇의 소개, 3장에서는 자율 주행 알고리즘, 4장에서는 실험결과를 제시하며, 5장에 서는 결론에 대하여 기술하였다[1-2].

2. 농업용 자율주행 로봇(K-Weedbot)

2.1. 로봇 시스템 소개

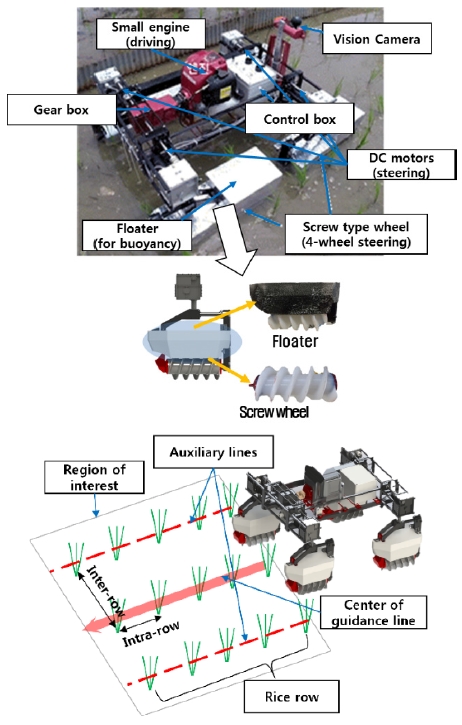

로봇의 형상은 Fig. 1과 같이 스크루(Screw) 형태의 전방향 조향(4-wheel steering), 소형 엔진 구동부, 제어 부 등으로 구성되어 있다. 이 로봇은 비전카메라를 통해 인식된 모열을 따라가며 스크루 형태의 바퀴를 이용하 여 모열 사이의 주간(Inter-row) 잡초를 제거하고 진행하 는 방식의 로봇이다. 이 로봇의 주요 특징은 전방향 조향 방식으로 모열간 상하좌우 이동이 용이하고 소형 엔진 의 사용으로 운용시간의 효율성을 높인 점이다[10].

자율주행 시스템 아키텍처는 영상획득 및 분할(Image acquisition and segmentation), 주행기준선 추출(Guidance line extraction) 그리고 로봇 제어(Robot motion control) 로 나눌 수 있다. 본 연구에서는 3열을 탐지할 시 중앙기 준선을 로봇의 주행 기준값으로 사용하고 좌우 기준선 을 주행기준선의 채택여부를 결정하는 보조기준선으로 사용하였다[10].

3. 주행기준선 추출 알고리즘

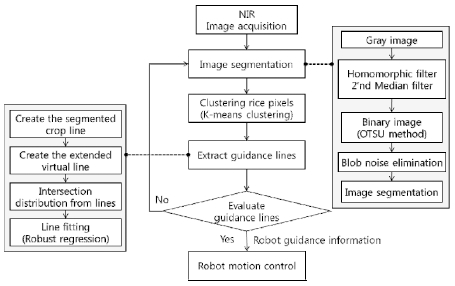

3.1. 영상분할(Image Segmentation)

근적외선 이미지는 기존에 많은 연구에서 사용된 방 법으로 곡물과 토양의 구분이 용이하다는 장점을 가지 고 있다. 특히 모의 경우 가시광선 대역 보다 근적외선 대역에서 배경이 되는 진흙과 큰 분광반사율을 차이를 지니고 있어 근적외선 이미지를 이용하는 것이 컬러 이 미지를 이용하는 것 보다 유리하다. 곡물과 배경간 분

광반사율의 차는 이미지 밝기 차이를 만들어 객체간 의 영상분할을 용이하게 만들어 준다.

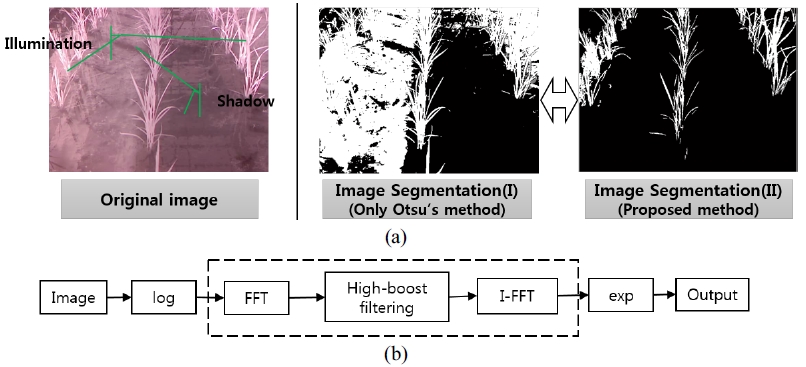

또한 해당 로봇은 야외에서 주로 운용되며, 높은 함수 율을 가진 진흙 지반에서 운용되는 로봇으로 다양한 경 로에서 이미지 노이즈가 발생되게 된다. 특히 햇빛(조명 변화), 그림자 그리고 물에 의한 난반사 등이 대표적이 며, 본 논문에서는 조명변화에 효과적인 호모모픽 필터 (Homomorphic filter)와 2차 중앙값 필터(Median filter) 를 적용하여 제거하고자 했다. 이 후 가변 문턱값 처리 방법 중에 하나인 Otsu 방법을 적용하여 이미지를 분할 하였다. 또한 물 표면에 의해 발생되는 난반사에 의한 물방울 형태의 노이즈 제거를 위해 이진영상 처리방법 을 응용하여 Fig. 3(a)와 같이 제거하였다. 이 방법은 식 (1)과 같이 분할된 이미지의 연결성을 가진 면적을 계산 하여 일정면적(δ=20)이하를 노이즈로 가정하여 제거하 는 방법으로 그 결과는 Fig. 3과 같이 보여진다[10].

Elimination of an image noise using homomorphic filter (a) Image segmentation result after image noise elimination, (b) diagram of homomorphic filtering

| (1) |

3.2. 중심영역 추출 정보 획득

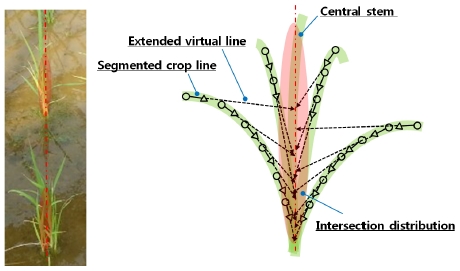

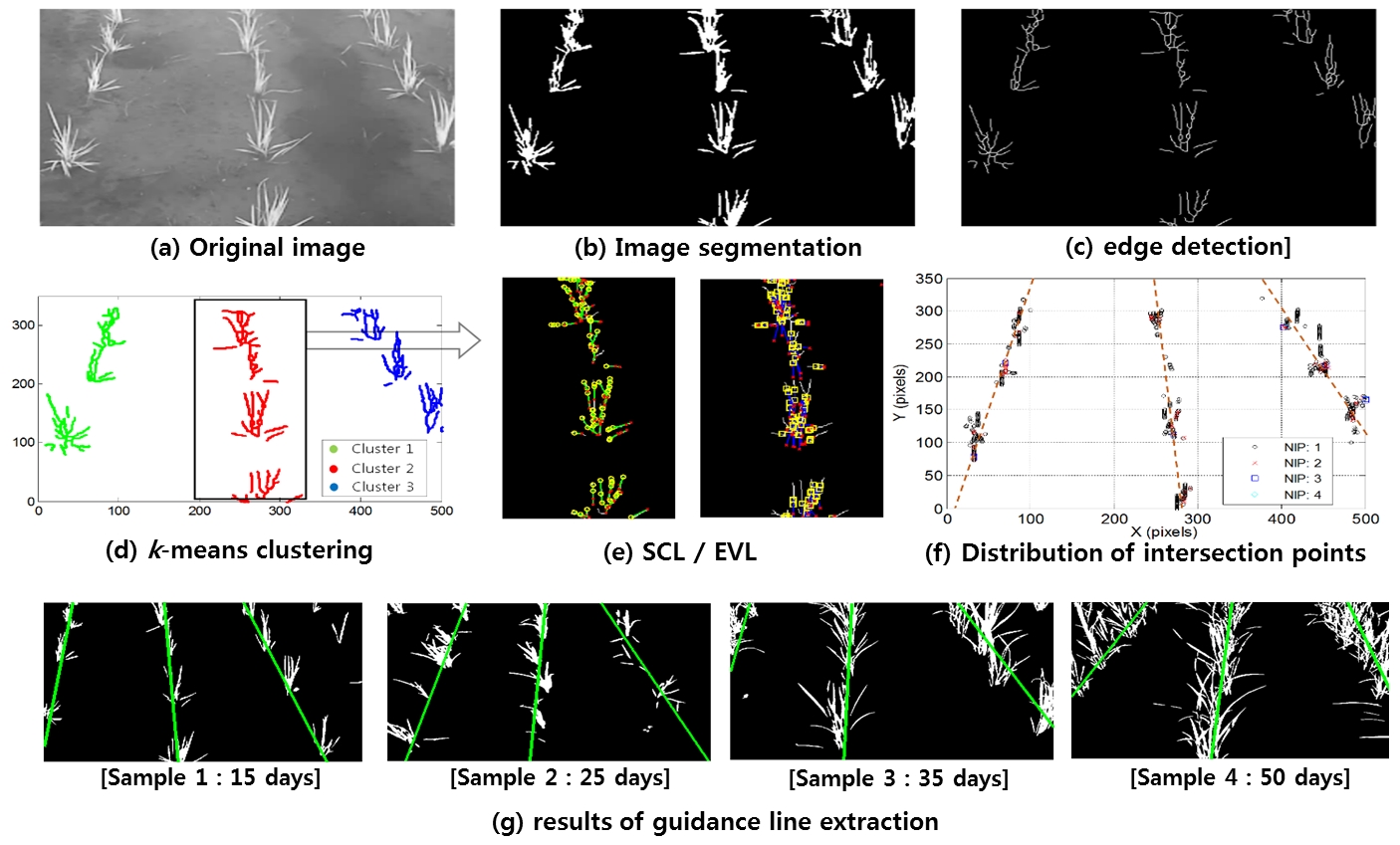

모 이미지의 형태적 특징은 가늘고 곡선형이며, 모 잎 은 중앙 줄기를 중심축으로 좌우측 펼쳐져 있어 중앙 줄기 하단영역으로 수렴성을 갖는 것을 볼 수 있다. 제안 된 알고리즘은 Fig. 4와 같이 이런 모 형태의 수렴성을 표현하여 중심영역를 찾고자 하는 알고리즘이다. 이 특 징을 이용 모의 중심영역을 추출하여 정확성 높은 주행 기준선을 찾고자 하였다. 제안된 알고리즘의 구체적 단 계는 다음과 같다.

- Step 1. Extract the segmented crop lines (SCL)

- Step 2. Create the extended virtual lines (EVL)

- Step 3. Compute the intersection points from EVL

- Step 4. Extract the guidance lines

주행기준선 추출 이전에 사전과정으로 3개의 모열간 의 데이터 혼재를 방지하기 위하여 k-means 클러스터링 방법을 수정 적용하여 이진영상에서 각 모열 데이터를 구분하였다. 인식된 이진영상은 골격화(Skeletonization) 하여 모 형상의 에지(Edge)를 추출하였다. 골격화는 빠 른 처리속도와 곡선의 연결성을 잘 나타낼 수 있는 Zahng- Suen방법을 사용하였다. 이렇게 추출한 에지는 곡선 또는 직선의 형태를 가지고 있기 때문에 추출된 에지는 분절 된 직선(Segmented crop line, SCL)들의 결합으로 표현 할 수 있다. 이 후 분절된 직선들을 연장하여 가상의 연 장직선(Extended virtual line, EVL)을 만들고 각 이미지 픽셀에서의 연장직선간 교점을 구하여 모의 중심영역을 추출하였다. 이렇게 계산된 교점분포는 주행기준선의 추출의 중요한 데이터가 되게 된다.

분절된 직선을 추출하기 위해 본 연구에서는 허프변 환(Hough transform)방법을 적용하였다. 골격화 영상의 특징점들은 허프변환에서 이미지 픽셀의 연결성을 표현하 는 임계치 조정을 통해 분절된 직선의 결합으로 표현할 수 있게 된다. 그 다음 단계는 추출된 분절직선을 중심방 향으로 길이를 연장하여 가상직선(Virtual line)을 만드는 과정이다. 연장 길이 (le)는 이미지 좌표를 기준으로 분절 된 직선의 기울기가 라고 할 때 식 (2)와 같이 결정된다.

| (2) |

| (3) |

여기서 ls는 분절된 직선(SCL)의 길이이며, 분절된 직 선의 시점에서 모의 중심선까지의 x축 길이(lr)는 모 잎의 곡선형 형상을 고려하여 식 (3)과 같이 지수함수로 가정 하였으며 계수(τ)는 사전에 수집된 실제 모의 영상을 이 용하여 실험적 방법으로 결정하였다. 그리고 분절된 직선 의 기울기가 수직에 근접할 경우(α=(π/2)±ε, ε=5°) 수직 방향으로의 높이(ln)만큼 직선을 연장하였다. 연장 된 가상 직선의 시점(Pts)은 허프변환을 통해 추출된 분 절직선의 종점(Pce)이 되며 가상 직선의 종점(Pte)은 분절 직선의 종점으로부터 길이 le만큼 아래 방향으로 직선의 기울기 α에 따라 좌우측으로 방향으로 연장된다. 이 때 분절직선의 종점이 시점에 비하여 위쪽에 있을 경우 연 장된 가상 직선의 시점은 분절직선의 시점이 된다. 이에 대한 관계식은 식 (4)에서 보여지는 바와 같다.

| (4) |

다음으로 각 직선간의 교점을 구하기 위해 같은 간단 한 영상처리의 화소 단위 처리를 이용하여 계산하였다. 연장된 가상 직선이 지나게 되는 픽셀에 값 1을 할당하 고 각 픽셀에서는 할당된 값을 모두 합하여 누적된 값을 계산한다. 이렇게 계산된 누적 값이 2 이상 되는 픽셀은 교점이 있는 픽셀이 되며 해당 누적 값에서 1을 뺀 값이 교점수가 되게 된다.

3.3. 주행기준선 추출

주행기준선은 계산된 교점분포를 기반으로 로버스트 회귀 방법(Robust regression)을 수정 적용하여 추출하였다. 로버스트 회귀 방법은 전통적인 선형회귀(Linear regression) 방법이 이상치(Outlier)에 민감하게 반응하여 회귀직선 의 정확성이 떨어지는 점을 보완하기 위해 고안된 방법 이다. 이 방법을 적용하게 됨으로써 영상의 노이즈 또는 교점 오차 등을 통해 발생되는 이상치로 부터 오차를 줄일 수 있어 주행기준선의 정확도를 높일 수 있게 된다. 본 연구에서는 가중치 함수의 수정을 통해 교점수에 따 른 가중치 부여가 가능하여 정확성을 더욱 높일 수 있게 하였다. 로버스트 회귀 방법의 일반적인 모델은 식 (5)로 정의되며, 회귀변수 추정량를 결정하기 위한 추정식(M estimator)는 식 (6), (7)과 같다.

| (5) |

| (6) |

| (7) |

식 (8)은 수정된 가중치 함수를 나타내며 함수를 지수 함수로 표현하여 이상치의 영향성을 크게 줄였으며, 교 점수가 큰 부분에 큰 가중치가 부여되도록 가중치 함수 를 수정 적용하였다. 여기서 n은 교점수를 ζ은 문턱값을 나타낸다.

| (8) |

| (9) |

| (10) |

4. 실험 결과

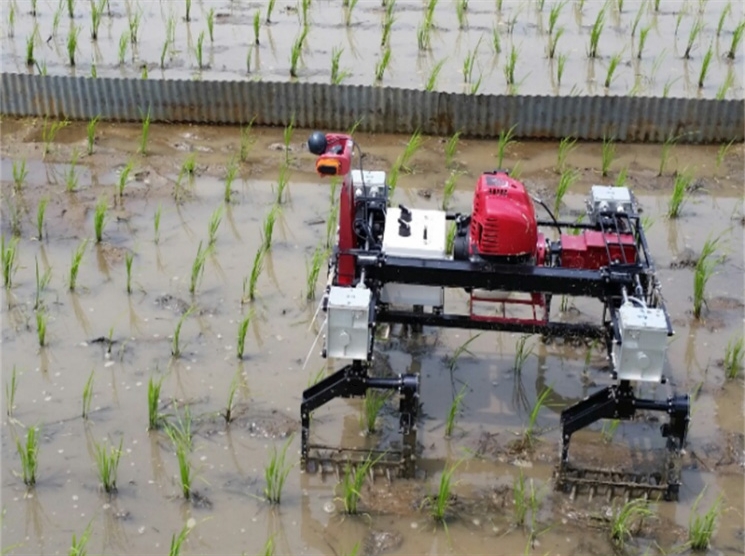

카메라는 알고리즘 검증 실험을 위하여 적외선 카메 라는 저가형 CCD 카메라(Logitech®, 모델명)에 IR bandpass 필터(>780 nm)를 카메라 내부에 장착하여 적외선 영상(640×480)을 획득하였다. 실험은 경기도 평택의 실 제 무논 환경에서 2014년 2월 ~ 5월 사이 실시되었다. 실험을 위한 샘플은 Fig. 5와 같이 로봇이 약 0.1 m/s의 속도로 무논을 기동함에 따라 전방에 설치된 적외선 카 메라를 통해 확보하였다. 샘플 영상은 총 4개 샘플에 400 개의 이미지들이며 각 샘플은 생장시기에 따라 모의 크 기 및 형상이 다르다. Fig. 6

영상 샘플에서 추출된 주행기준선의 정확도 측정 결 과는 Table 1과 같다. 주행기준선의 정확도에 대한 평가 는 이미지 좌표계를 기준으로 추출된 주행기준선의 기 울기와 초기 시작점의 차이를 가지고 평가하고자 하였 다. 실험은 벼의 생장기간별 형태변화에 따른 알고리즘 의 영향성을 검증을 중심으로 실시되었다. 총 400개의 이미지 샘플에 대한 실험결과 Table 1의 결과와 같이 중앙기준선의 경우 각도 오차는 0.62도에서 0.96도로 매 우 좋은 정확도를 나타낸 것을 확인할 수 있다. 벼의 생 장시기별 형태변화에 따른 주행기준선의 각도 및 시점 오차는 각도 오차는 매우 적으나 시점 오차의 경우 약간 의 증가추세를 보였다. 제안된 알고리즘의 경우 종합적 으로 중앙기준선의 경우 0.81도 이내 초기 시작점의 경 우 2.77픽셀(약 6 mm) 이내로 좋은 정확도를 나타내었 다. 특히 중앙기준선의 경우 모의 형태변화에도 큰 변화 없이 일정한 정확도를 유지함으로써 로봇이 제초작업에 투입되는 시기(이앙 후 15일 ~ 50일)에 운용이 가능할 것으로 판단된다. 이미지 처리 시간은 2.8 GHz의 노트북 컴퓨터(Intel® Core i-7, 32-bit CPU, 4 GB of RAM)에서 0.1 ~ 0.2 s/frame 정도의 속도를 보였으며, 로봇의 속도 가 0.4 m/s임을 고려시 로봇운용의 실시간성 확보에는 문제가 없을 것으로 판단된다.

5. 결 론

주행기준선 추출은 농업용 로봇의 자율주행을 위해 매우 중요한 과정이다. 특히 모의 경우 여러 갈래의 가는 잎이 많은 형태로 인해 이미지상에서 주행기준선을 추 출하기 어려운 작물이다. 따라서 본 논문에서는 무논환 경에서 정확성 높은 주행기준선 추출 방법을 제안하고 자 하였다. 이를 위하여 모의 중심영역 추출에 기반한 새로운 주행기준선 추출 알고리즘을 제안하였으며, 실 험결과 중앙기준선의 정확도는 1도 이내로 매우 정밀한 결과를 보였다. 또한 벼의 성장에 따른 형태변화에도 큰 오차를 보이지 않은 좋은 결과를 보였다. 하지만 로봇탑 재 실험 등을 통해 알고리즘 검증을 위한 추가적인 실험 이 필요하다고 생각된다.

Notes

References

- Keun, Ha Choi, Sang, Kwon Han, Kwang-Ho, Park, Kyung-Soo, Kim, Soohyun, Kim, “Vision camera based autonomous guidance algorithm using extraction data of central region for precision weeding robot”, The 10 Korea Robotics Society Annual Conference, (2015), p1-4.

-

Keun, Ha Choi, Sang, Kwon Han, Sang, Hoon Han, Kwang-Ho, Park, Kyung-Soo, Kim, Soohyun, Kim, “Guidance line extraction for autonomous weeding robot based-on rice morphology characteristic in wet paddy”, Journal of Korea Robotics Society, (2014), 9(3), p147-153.

[https://doi.org/10.7746/jkros.2014.9.3.147]

-

Søgaard, HT, Olsen, HJ, “Determination of crop rows by image analysis without segmentation”, Computers and Electronics in Agriculture, (2003), 38, p141-158.

[https://doi.org/10.1016/S0168-1699(02)00140-0]

-

Hana, S, Zhang, Q, Nic, B, Reid, JF, “A guidance directrix approach to vision-based vehicle guidance systems”, Computers and Electronics in Agriculture, (2004), 43, p179-195.

[https://doi.org/10.1016/j.compag.2004.01.007]

-

Rovira-Ma´s, F, Zhang, Q, Reid, JF, Will, JD, “Hough-transform-based vision algorithm for crop row detection of an automated agricultural vehicle”, Proc. ImechE, (2005), 219, p999-1010.

[https://doi.org/10.1243/095440705X34667]

-

Tijmen, Bakkera, Hendrik, Woutersa, Kees, van Asselta, Jan, Bontsemab, Tangc, Lie, Joachim Mu, ller d, Gerrit van, Stratena, “A vision based row detection system for sugar beet”, Computers and Electronics in Agricultur, (2008), 60, p87-95.

[https://doi.org/10.1016/j.compag.2007.07.006]

-

Ronghua, Ji, Lijun, Qi, “Crop-row detection algorithm based on Random Hough Transformation”, Mathematical and Computer Modelling, (2011), 54, p1016-1020.

[https://doi.org/10.1016/j.mcm.2010.11.030]

-

Billingsley, J, Schoenfisch, M, “The successful development of a vision guidance system for agriculture”, Computers and Electroncis in Agriculture, (1997), 16, p147-163.

[https://doi.org/10.1016/s0168-1699(96)00034-8]

-

Romeo, J, Pajares, G, Montalvo, M, Guerrero, J M, Guijarro, M, Ribeiro, A, “Crop row detection in maize fields inspired on the human visual perception”, The Scientific World Journal, (2012), p1-10.

[https://doi.org/10.1100/2012/484390]

-

Keun, Ha Choi, Sang, Kwon Han, Sang, Hoon Han, Kwang- Ho, Park, Kyung-Soo, Kim, Soohyun, Kim, “Morphologybased guidance line extraction for an autonomous weeding robot in paddy fields”, Computers and Electronics in Agriculture, (2015), 113, p266-274.

[https://doi.org/10.1016/j.compag.2015.02.014]

2002 육군사관학교 무기공학과(공학사)

2007 한국과학기술원 기계공학과(공학석사)

2007 ~ 2012 방위사업청

2012 ~ 현재 한국과학기술원 기계공학과 박사과정

관심분야: 로봇 자율주행, 비전 알고리즘 등

2013 한양대학교 기계공학부(공학사)

2015 한국과학기술원 로봇학제(공학석사)

2015 ~ 현재 한국과학기술원 기계공학과 박사과정

관심분야: 로봇 보행, 비전 알고리즘 등

1984 충북대학교 농과대학 농학과(농학사)

1986 경북대학교 대학원 농학과(농학석사)

1991 필리핀대학교 대학원 농학과(농학박사)

1997 ~ 현재 국립 한국농수산대학 교수

관심분야: Mechatronics in Agronomy 등

1993 한국과학기술원 기계공학과(공학사)

1995 동 대학원 기계공학과(공학석사)

1999 동 대학원 기계공학과(공학박사)

2007 ~ 현재 한국과학기술원 기계공학과 교수

관심분야: 강인제어, 로봇핸드, 재활로봇 등