논 잡초 방제용 자율주행 로봇을 위한 벼의 형태학적 특징 기반의 주행기준선 추출

†Corresponding author: kh5008@korea.kr

© KROS

Abstract

In this paper, we proposed a new algorithm of the guidance line extraction for autonomous weeding robot based on infrared vision sensor in wet paddy. It is the critical process for guidance line extraction which finds the central point or area of rice row. In order to improve accuracy of the guidance line, we are trying to use the morphological characteristics of rice that the direction of rice leaves have convergence to central area of rice row. Using Hough transform, we were represented the curved leaves as a combination of segmented straight lines on binary image that has been skeletonized and segmented object. A slope of the guidance line was gotten as calculate the average slope of all segmented lines. An initial point of the guidance line was determined that is the maximum pixel value of the accumulated white columns of a binary image which is rotated the slope of guidance line in the opposite direction. We also have verified an accuracy of the proposed algorithm by experiments in the real wet paddy

Keywords:

Autonomous Weeding Robot, Guidance Line Extraction, Robot Vision, Rice Morphology1. 서 론

최근 친환경 농법에 대한 관심 증가와 농촌사회에서 대 두되고 있는 고령화에 따른 일손부족, 생산성 감소 등이 심각한 사회문제로 대두되면서 고된 농작업을 대신 수행 하는 무인로봇의 필요성이 부각되고 있다. 특히 다양한 농 작업 중 잡초방제는 작물의 생산성을 좌우하는 중요한 작 업인 반면 기계화율이 낮아 로봇을 이용한 방제작업이 더 욱 요구되는 분야이다. 이런 잡초방제용 로봇의 경우 인간 을 대신하여 자율적으로 작업을 할 수 있는 자율주행 기 술이 필수적이며 최근 많은 연구들이 진행되고 있다. 대부 분의 연구들은 비전센서(vision sensor)를 이용한 객체인식 (object perception) 기반의 방법들을 많이 적용하고 있다. 잡 초방제로봇의 비전센서 기반 자율주행은 작물열 인식(crop row perception), 주행기준선(guidance line) 추출, 로봇의 작물 열 추종(robot motion control) 단계로 크게 구분할 수 있다. 그 중 주행기준선 추출은 인식된 작물열 영상에서 로봇이 추종해야 하는 기준선을 추출하는 단계로 작물의 손상 없 이 로봇이 안전하고 정확하게 작업을 수행하게 하는 중요 한 과정이다. [1]

주행기준선 추출을 위한 기존연구는 크게 영상의 픽셀 값(pixel value) 분포를 이용한 방법과 허프변환(Hough transform)을 이용한 방법으로 구분할 수 있다. Olsen[2]의 경우 영상 픽셀의 회색조 값(gray value)을 수직 축 방향으 로 영역단위로 합하여 회색조 값의 합이 가장 큰 곳에 주 행기준선이 결정되도록 하였다. Pla[3]는 회색조 영상을 골 격화 영상으로 변환하여 골격화 선의 최대 교차 소실점을 찾아 작물열에서 주행기준선을 추출하였다. Slaughter[4]는 작물 열의 수직 방향으로 분할된 영역에서 그레이 값이 축척된 공간적 분포(spatial distribution)의 중앙값에 해당하 는 열을 주행기준선으로 결정하는 접근법을 제안하였다. Søgaard[5]는 영상을 수평방향 영역으로 분할하여 수평 띠 (strips)를 획득한 후 각 수평 띠를 하나의 띠로 합하여 회 색조 값의 누적 합을 구한 후 원형 띠로 다시 표현하여 무 게중심(CoG) 결정을 통해 열의 위치로 투영시키는 방법을 사용하였다. Hana[6]는 작물열의 이진영상(binary image)에서 중심점(centroid point)과 방향각(orientation angle)을 계산하여 주행기준선을 표현하였다. 이런 방법들은 로봇 자세 변화 에 따른 영상의 회전이 있을 경우 인식된 작물열의 회색 조 값은 수직형태의 분포가 아닌 기울기를 가진 분포형태 를 가지므로 픽셀 값 분포의 최대값을 구하고자 할 때 오 차가 발생한다는 단점이 있다. 또한 잎이 가는 작물의 경 우 그레이 값 분포의 최대값이 항상 작물의 중앙에 놓이 지 않을 경우가 있어 큰 오차를 발생시킬 수 있다.

다음으로 허프변환을 이용한 연구로서 Marchant[7]는 인 식된 근적외선 이진영상에서 허프변환을 이용하여 주행기 준선을 추출하였다. Rovira-Más[8]는 허프변환의 효율성을 높이기 위해 작물열 영상의 중앙점을 연결한 골격화 선을 허프변환에 적용하여 기준선을 획득하였고, Bakkera[9]는 작 물열이 있는 공간을 사각 영역으로 분할한 후 각 영상을 하나로 융합하여 그레이 값의 밀도를 높인 후 허프변환을 실시하여 영상 처리시간을 단축하고자 했다. Ronghua Ji[10] 역시 Randomized-허프변환을 통해 계산시간 증가 문제를 해결하고자 했다. 허프변환 역시 인식된 작물의 중앙점을 정확하게 인식하기 어렵다면 정확도가 떨어지는 문제가 여전히 존재한다.

기타 다른 방법으로 Billingsley[11]는 정해진 영역(Window) 안에 인식된 작물을 하나의 점으로 가정하여 이 점들의 회귀선에서(regression line) 주행기준선을 추출하고자 했다. Romeo[12]는 작물열 이진영상에서 최소제곱 선형회귀(least squares linear regression) 방법을 이용하였으며, 모든 픽셀의 하단 열에서부터 모든 가능한 라인을 추적(Trace)하여 추 적된 직선 중에서 누적 녹색 픽셀수가 최대가 되는 직선 을 주행기준선으로 결정하였다. 회귀선을 추출하는 방법은 매우 간단하게 적용할 수 있다는 장점이 있으나 주행기준 선의 정확도가 특이치(outlier)에 민감하여 영상의 노이즈가 많을 때 정확도가 크게 떨어진다는 단점을 가진다.

결국 주행기준선의 정확도는 작물의 중심점 또는 영역 을 얼마나 정확하게 추정하는가에 따라 결정된다. 따라서 본 논문에서는 기존의 방법으로 정확도 높은 주행기준선 을 추출하기 어려운 모열(Rice row)의 생태학적 특성을 이 용한 새로운 주행기준선 추출방법을 제안하고자 한다. 물 론 주행기준선은 노이즈가 적은 우수한 품질의 모열 영상 에 따라서도 정확도에 영향을 받으나 본 연구에서는 이미 인식된 모열 영상에서 주행기준선의 정확도를 높이는 방 향에 초점을 맞추어 연구를 진행하였다. 본 연구에서는 모 열의 중심영역 추출 정확도를 높이기 위해 모 잎이 중심 방향으로 수렴하는 형태학적 특징을 이용하였으며, 이를 구현하기 위해 간단한 이미지 처리를 통해 알고리즘의 실 시간성을 높였다. 2장에서는 알고리즘이 적용되는 논 잡초 방제용 로봇 시스템에 대해 소개하고, 3장에서는 주행기준 선 추출 알고리즘, 4장에서는 실험 결과, 5장에서 결론 순 으로 기술하였다.

2. 논 잡초방제 로봇 시스템

2.1. 로봇 시스템 소개

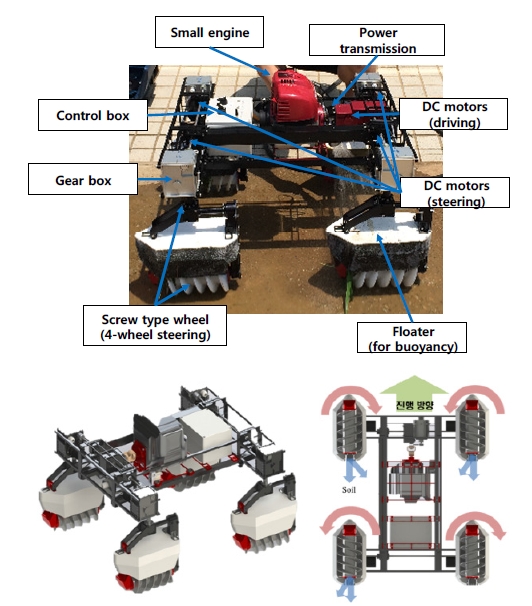

로봇의 형상은 그림 1과 같이 스크루(screw) 형태의 전 방향 조향(4-wheel steering) 전기 모터 구동부, 소형 엔진, Floater, 제어부 등으로 구성되어 있다. 이 로봇은 적외선 비전카메라를 통해 인식된 모열을 따라가며 스크루 형태 의 바퀴를 이용하여 모열 사이의 주, 조간(inter-row, Intrarow) 잡초를 제거하고 진행하는 방식의 로봇이다. 이 로봇 의 주요 특징은 전방향 조향 방식으로 모열간 상하좌우 이동이 용이하고 소형 엔진의 사용으로 전기 배터리에 비 해 운용의 효율성을 높인 것이다. 또한 진흙 환경에서 로 봇이 주행간 아래 방향으로 침하되는 문제를 방지하기 위 해 Floater를 스크루 상부에 장착하여 부력 유지를 통해 침 하현상을 방지하고자 하였다.

2.2. 시스템 아키텍처(architecture)

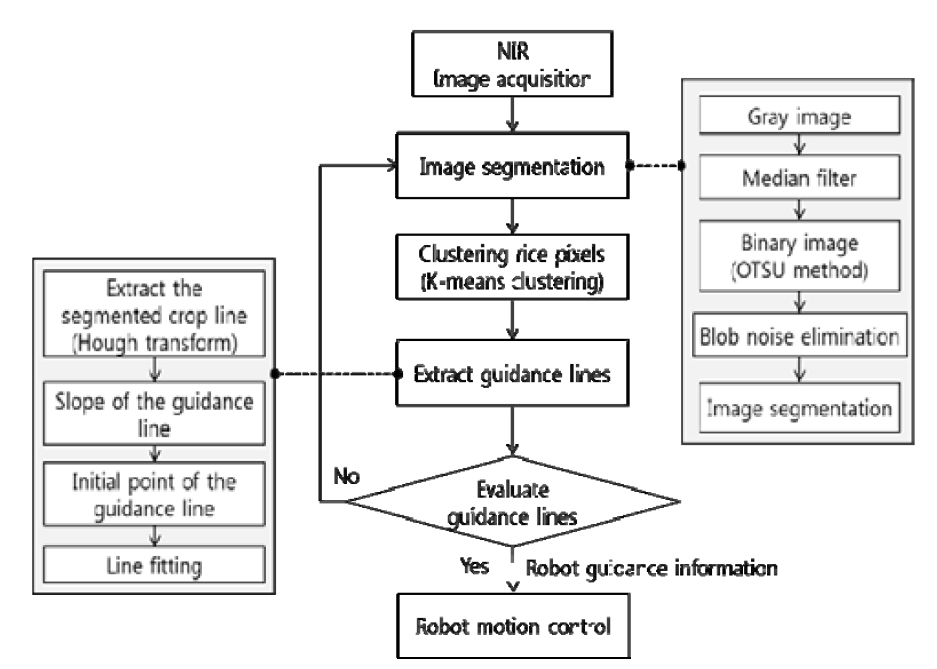

잡초 방제로봇의 자율주행 시스템 아키텍처는 그림2와 같이 영상획득 및 분할(image acquisition and segmentation), 주행기준선 추출 및 평가(guidance line extraction and evaluation) 그리고 로봇 제어(robot motion control)로 나눌 수 있다.

3. 주행기준선 추출

3.1. 영상획득(Image acquisition)

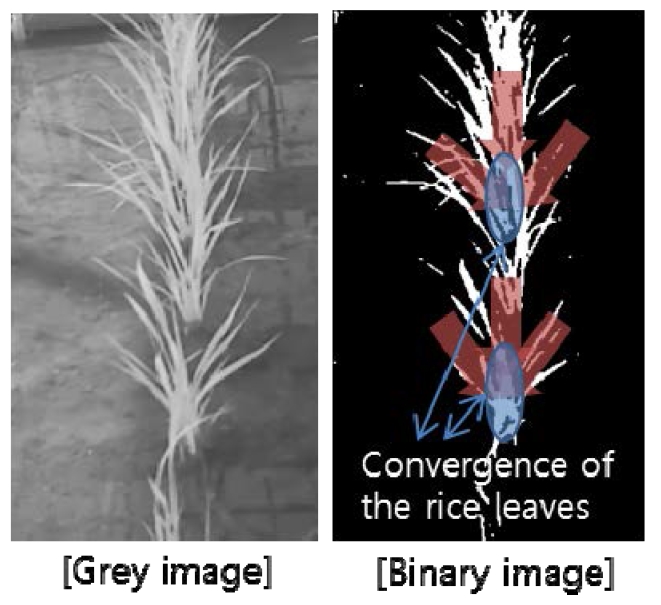

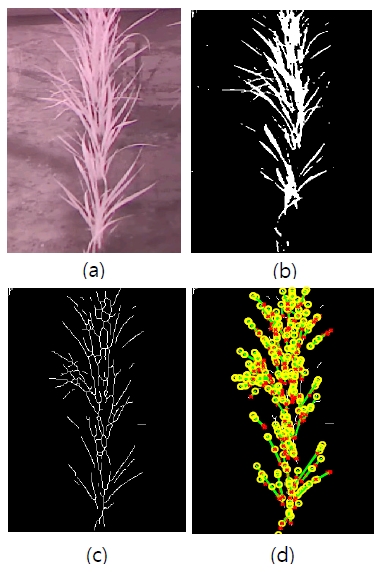

주행기준선 추출을 위해 영상은 근적외선(near infrared ray) 영상을 활용하였다. 근적외선 영상은 컬러 영상에 비 하여 무논(wet paddy) 환경에서 모와 배경 사이의 분할에 유리하여 작물열 인식에 많이 활용되고 있는 방법이다. 이 렇게 획득된 근적외선 영상은 그림3와 같이 그레이 스케 일(grey scale) 영상으로 변환하고 문턱값 처리(thresholding) 를 통해 배경으로부터 모열을 인식해내는 영상분할(image segmentation) 과정을 거쳐 이진영상 형태의 모열 영상을 획득하게 된다. 이 때 야외환경에서의 조명변화로 인한 영 상 노이즈(image noise)의 영향성을 최소화하기 위해 2차 중 앙값 필터(median filter)를 적용하였으며 대표적인 가변 문 턱값 처리 방법 중에 하나인 Otsu method(Otsu, 1979)를 적 용하여 이미지 분할(Image segmentation)을 실시하였다. 추 가적으로 수면 위강한 빛에 의한 경면반사로 발생되는 작 은 크기의 노이즈를 제거하기 위해 식(1)과 같은 이미지 프로세싱 과정을 수행하였다. 이 과정은 인식된 모열 영상 내 연결성(connective)이 떨어지는 작은 blob 형태의 노이즈 제거를 위해 인접한 픽셀의 점유면적(P(i,j)area)이 임계치(ε) 이하가 되면 해당 픽셀의 이진 값을 0으로 설정하여 제거 되도록 하였다.

| (1) |

이렇게 획득한 모열 영상의 특징을 살펴보면 다음과 같다. 모의 잎은 가늘고 중앙 줄기를 중심으로 좌우측으로 길게 잎이 펼쳐져 있어 픽셀 값의 분포를 이용한 주행기준선 추 출 방법을 적용하기 어려우며 허프변환을 통해 하나의 중심 선을 획득하기가 제한된다는 특징을 가지고 있다.

3.2. 주행기준선 추출 알고리즘

앞서 설명하였듯이 모열 영상(m×n image)을 보면 각 모 가 구분되어 y 축 방향으로 연속성 없이 배치되어 있고 잎 이 가는 곡선의 형태를 가지고 있어 허프변환을 이용하여 정확한 하나의 직선을 추출하기 어려운 특성을 가지고 있 다. 따라서 이런 단점을 보완하기 위해 본 연구에서는 곡 선형의 모열 영상을 허프변환을 통해 얻어진 분절된 직선 (segmented line)형태로 표현하여 주행기준선을 추출하고자 하였다. 모열 영상의 형태적 특징을 살펴보면 그림 3에서 보는 바와 같이 곡선형태의 잎이 중앙 줄기 방향으로 수 렴하는 것을 볼 수 있다. 이는 벼가 외떡잎 식물으로 생장 점이 땅속에 있으면서 어미줄기와 똑같은 놈이 나와 포기 가 점점 불어나는 모습을 가지기 때문이다. 이 수렴성을 이용하여 모의 중앙 줄기부분을 기준으로 주행기준선을 식(2)와 같은 직선의 방정식 형태로 결정하고자 하였다. 먼 저 주행기준선의 기울기를 계산하기 위해 인식된 이진 모 열 영상을 골격화 (skeletonization) 한 후 허프변환을 수행 하였다. 골격화는 빠른 처리속도와 곡선의 연결성을 잘 나 타낼 수 있는 Zahng-Suen(Zhang and Suen, 1984) 방법을 적 용하였다. 이렇게 추출한 에지는 곡선의 형태를 가지고 있 기 때문에 곡선형태의 잎은 분절된 직선들의 결합으로 표 현할 수 있고, 모의 잎이 좌우대칭의 형태를 가지므로 분 절된 각 직선의 기울기(αk) 평균을 식(3)과 같이 구하여 모 중앙 줄기의 기울기(θtfinal)를 추정하고자 하였다. 여기 서 모 잎의 일부 끝부분의 경우 불규칙적으로 지면방향으 로 쳐지므로 주행기준선의 기울기 평균을 구하기 위한 대 상을 식(3)과 같이 범위를 한정하였다.

| (2) |

| (3) |

| (4) |

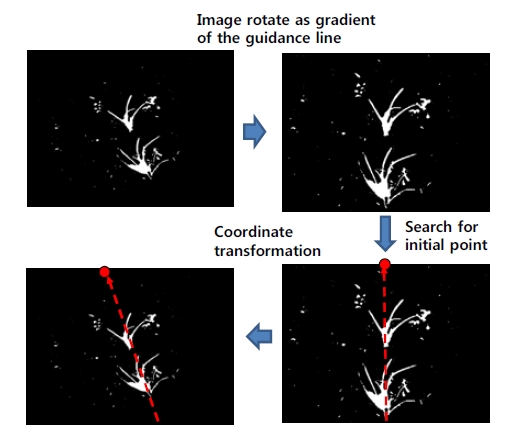

si = the sum of white picxels in the row

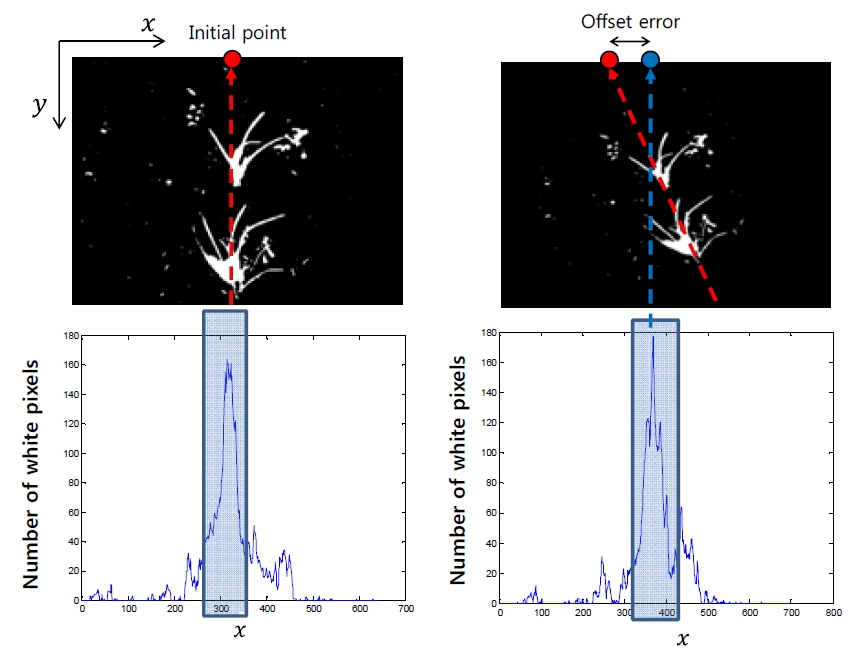

주행기준선의 시점(initial point, xt)은 그림 4(a)과 같이 이진영상에서 수직방향으로 누적된 화이트 픽셀 값이 최 대치를 가지는 열의 x 좌표를 시점으로 정하였다. 하지만 로봇자세의 흔들림이나 방향변경으로 인해 인식된 모열이 수직선의 형태가 아닌 기울기를 가진 형태를 가지게 된다 면 누적 값의 최대치가 되는 시점에 그림 4(b)와 같은 오 차가 발생하게 된다. 따라서 오차보정을 위해 앞서 구한 주행기준선의 기울기 값을 활용하여 시점을 식(4)과 같이 재결정하였다. 그림 5에 보는 바와 같이 영상에서 기울어 진 모열 영상을 계산된 주행기준선의 기울기(θtfinal)만큼 반 대로 영상을 회전 시킨 후 누적 값이 최대치를 가지는 열 의 시점을 구하였다. 이렇게 결정된 열의 시점은 다시 회 전행렬를 통해 원본 영상의 시점으로 투영시키게 됨으로써 기울어진 영상의 시점 오차를 보정하고자 하였다. 이 알고 리즘은 모와 같이 잎이 가는 작물열에서 주행기준선을 추출 하거나 로봇 자세변화에 따른 주행기준선의 오차를 줄일 수 있는 장점을 보유한 알고리즘이라 할 수 있겠다.

4. 실험 결과

카메라는 Webcam(Logitech®)에 NIR Bandpass 필터를 장 착하여 근적외선 영상(640×480)을 획득하였다. 실험은 한 국농수산대학 온실내(PTC) 설치된 무논환경에서 실시되었 으며 로봇은 약 0.1 m/s로 구동되도록 하였다.

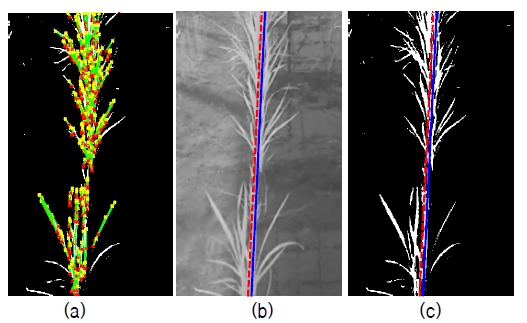

그림 6은 모열 이진영상에서 분절된 직선을 추출한 영 상으로 분절된 직선들이 중앙줄기 방향으로 수렴하는 것 을 확인 할 수 있다. 또한 그림 7(b), (c)의 파란색 직선은 추정된 주행기준선으로 빨간색 점선의 실제 모열과 큰 오 차를 보이지 않는 것을 관찰할 수 있다. 표 1에서 보이듯 이 모열이 인식된 총 102개의 영상 샘플을 대상으로 실제 모열과 주행기준선과의 RMS 각도오차는 0.67°로 로봇의 주행오차를 고려할 때 정확하였다. 다만 이는 모열 영상이 분명할 경우이며 모열이 인식되지 않거나 영상의 노이즈 가 많을 경우 오차가 증가될 수 있다. 따라서 특히 조명, 바람 등 환경적 영향에서도 모열 영상의 우수한 품질이 전제되어야 할 것으로 판단된다.

5. 결 론

본 논문에서는 논 잡초방제용 자율로봇의 모열인식 기 반의 주행기준선 추출을 위한 방법을 제안하였다. 인식된 모열 영상에서 모의 잎이 모의 중앙줄기 부분으로 수렴하 는 형태학적 특징을 이용하기 위하여 골격화된 이진영상 을 허프변환을 이용하여 분절된 직선으로 나타내었다. 이 렇게 추출한 분절된 각 직선들의 기울기 평균을 계산하여 주행기준선의 기울기로 적용하였고 또한 모열 영상에서 각 열의 누적 화이트 픽셀 값의 최대지점을 시점으로 정 하였다. 이 때 로봇자세에 의해 회전된 영상의 오차 보정 을 위하여 계산된 주행기준선의 기울기 값만큼 영상을 회 전 시켜 시점을 재계산하여 오차를 보정하였다. 그리고 실 험을 통해 제안한 알고리즘의 우수한 정확도를 검증하였 다. 향후에는 바람, 조명 등 다양한 환경변화에도 강인한 알고리즘에 대한 연구가 추가적으로 필요하다고 판단된다.

REFERENCES

-

Keun Ha, Choi, Sang Kwon, Han, Sang Hoon, Han, Kwang-Ho, Park, Kyung-Soo, Kim, Soohyun, Kim, “Guidance Line Extraction for Autonomous Guidance of Vision Sensor -based Weeding robot in Wet Paddy”, (2014), Korean Robotics of Society Annual Conference.

[https://doi.org/]

-

Olsen, HLJ, “Determination of row position in smallgrain crops by analysis of video images”, Computers and Electronics in Agriculture, (1995), 12, p147-162.

[https://doi.org/10.1016/0168-1699(94)00044-q]

-

Pla, F, Sanchiza, JM, Marchant, JA, Brivot, R, “Building perspective models to guide a row crop navigation vehicle”, Image and Vision Computing, (1997), 15, p465-473.

[https://doi.org/10.1016/s0262-8856(96)01147-x]

-

SLAUGHTER, D. C, CHEN, P, CURLEY, R. G, “Vision Guided Precision Cultivation”, Precision Agriculture, (1999), 1, p199-216.

[https://doi.org/]

-

Søgaard, H.T, Olsen, H.J, “Determination of crop rows by image analysis without segmentation”, Computers and Electronics in Agriculture, (2003), 38, p141-158.

[https://doi.org/10.1016/s0168-1699(02)00140-0]

-

Hana, S, Zhang, Q, Nic, B, Reid, JF, “A guidance directrix approach to vision-based vehicle guidance systems”, Computers and Electronics in Agriculture, (2004), 43, p179-195.

[https://doi.org/10.1016/j.compag.2004.01.007]

-

Marchant, J.A, Renaud, Brivot, “Real-time Tracking of Plant Rows Using a Hough Transform”, Real-Time Imageing, (1995), 1, p363-371.

[https://doi.org/10.1006/rtim.1995.1036]

-

Rovira-Ma´s, F, Zhang, Q, Reid, J. F, Will, J. D, “Hough-transform-based vision algorithm for crop row detection of an automated agricultural vehicle”, Proc. IMechE, (2005), 219, p999-1010.

[https://doi.org/10.1243/095440705x34667]

-

Tijmen, Bakkera, Hendrik, Woutersa, Kees van, Asselta, Jan Bontsemab, Lie, Tangc, Joachim Mu, ller, d, Gerrit van, Stratena, “A vision based row detection system for sugar beet”, Computers and Electronics in Agriculture, (2008), 60, p87-95.

[https://doi.org/10.1016/j.compag.2007.07.006]

-

Ronghua, Ji, Lijun, Qi, “Crop-row detection algorithm based on Random Hough Transformation”, Mathematical and Computer Modelling, (2011), 54, p1016-1020.

[https://doi.org/10.1016/j.mcm.2010.11.030]

-

Billingsley, J, Schoenfisch, M, “The successful development of a vision guidance system for agriculture”, Computers and Electroncis in Agriculture, (1997), 16, p147-163.

[https://doi.org/10.1016/s0168-1699(96)00034-8]

-

Romeo, J, Pajares, G, Montalvo, M, Guerrero, J. M, Guijarro, M, Ribeiro, A, “Crop Row Detection in Maize Fields Inspired on the Human Visual Perception”, The Scientific World Journal, (2012), p10.

[https://doi.org/10.1100/2012/484390]

-

Jeongdae, Kim, Yongtae, Do, “Human Detection in the Images of a Single Camera for a Corridor Navigation Robot”, Journal of Korea Robotics Society, (2013), 8(4), p238-246.

[https://doi.org/10.7746/jkros.2013.8.4.238]

-

Heo, Jung-Hun, Lee, Min-Cheol, “Building Recognition using Image Segmentation and Color Features”, Journal of Korea Robotics Society, (2013), 8(2), p082-091.

[https://doi.org/10.7746/jkros.2013.8.2.082]