천장 영상지도 기반의 전역 위치추정

†Corresponding author: Mechanical Engineering, Korea University, Anamdong, Seongbuk-gu, Seoul, Korea ( jbsong@korea.ac.kr)

© KROS

Abstract

This paper proposes a novel upward-looking camera-based global localization using a ceiling image map. The ceiling images obtained through the SLAM process are integrated into the ceiling image map using a particle filter. Global localization is performed by matching the ceiling image map with the current ceiling image using SURF keypoint correspondences. The robot pose is then estimated by the coordinate transformation from the ceiling image map to the global coordinate system. A series of experiments show that the proposed method is robust in real environments

Keywords:

Global localization, Ceiling image map, Upward-looking camera, Mobile robot1. 서 론

이동로봇의 자율주행은 현재 위치를 기준으로 목표점까 지 효율적으로 이동하는 것을 목적으로 한다. 따라서 로봇 의 위치를 추정하는 기술은 주행에 있어서 필수적이다. 로 봇이 처음 탐사하는 환경에서 위치추정을 수행하며 지도 를 작성하는 SLAM(simultaneous localization and mapping) 방 법이 제안되었는데[1,2], 이를 통해 작성된 지도를 활용하여 로봇이 주행하기 위해서는 위치추정 기법 중에서 초기 위 치를 찾는 전역 위치추정(global localization)을 수행해야 한다.

전역 위치추정을 수행하기 위해 다양한 센서를 이용한 방법이 개발되었다. 먼저 거리센서를 이용한 전역 위치추 정 방법으로 MCL(Monte Carlo localization) 기법을 이용한 연구가 있었는데[3], 확률적인 갱신을 위해 로봇의 추가적 인 움직임이 필요하다. 이를 개선하기 위해 전방 카메라를 이용하여 환경에 대한 정보를 사전에 저장하여 위치를 찾 는 방법이 제안되었다[4]. 이 방법은 특징이 많은 환경에서 는 강인하게 작용하지만, 환경 변화가 큰 장소에서는 적합 하지 않다. 환경 변화에 강인하게 작용하기 위해서 천장 지향 카메라를 이용한 영상정합(scene matching) 기반 전역 위치추정 방법이 제안되었다[5]. 실내 천장은 구조적 변화 가 없으므로 천장 정보를 활용하면 동적 환경에서도 강인 한 전역 위치추정이 가능하지만, 특정 패턴이 반복되는 천 장인 경우 실제와 다른 위치에서 추출된 특징점들이 정합 되어 다른 위치의 영상들이 유사 영상으로 판단되는 문제 점이 있다. 이보다 앞서 천장 영상지도를 작성하고 전역 위치추정에 사용한 연구가 있는데[6], 유사한 패턴이 반복 되는 환경에서 강인한 전역 위치추정 성능을 가지는 장점 이 있다. 여기서 천장 영상지도는 영상정보로 구성된 천장 환경 지도이며, 로봇이 사전에 주변 환경을 탐사하며 획득 한 천장 영상들을 하나의 영상으로 통합하여 작성한다. 기 존의 방법은 모자이크 기법을 이용하여 영상지도를 작성 하였는데 작성된 지도의 정확성이 떨어지는 문제점이 있 었다. 또한, 천장 영상지도를 통해 얻은 위치정보가 로봇 의 추가적 움직임이 필요한 MCL 기법에 사용되었으며, 거리센서의 보조적 역할을 수행하는 한계점이 있다.

본 논문에서는 저가의 카메라를 이용한 천장 영상지도 기반의 전역 위치추정 방법을 제안한다. 천장 영상지도는 파티클 필터(particle filter)를 이용한 영상 통합 과정을 통해 작성하는데, 저가의 카메라를 이용하여 기존의 방법보다 작성된 지도의 정확성을 향상시킨다. 전역 위치추정은 현 재 영상과 천장 영상지도 간의 일대일 정합을 수행한다. 따라서 특정 패턴이 반복되는 환경에서 기존의 영상정합 기반 전역 위치추정 방법의 문제점인 유사 영상 오판단에 기인한 위치추정 실패가 발생하지 않는다. 이를 통해 저가 의 카메라를 이용하여 동적이고 특정한 천장 패턴이 반복 되는 환경에서 강인한 전역 위치추정을 수행한다.

본 논문은 다음과 같이 구성된다. 2장에서 천장 영상지 도 작성에 대하여 설명하며, 3장에서는 천장 영상지도를 이용한 영상정합 기반 전역 위치추정에 대하여 설명한다. 4, 5장에서는 실험 결과 및 결론을 도출한다.

2. 천장 영상지도 작성

본 논문에서는 특정 환경에 대해서 SLAM을 통하여 수 집한 천장 영상을 하나의 통합 영상으로 만들고, 이를 천 장 영상지도라고 정의하였다. 제안한 방법에서는 초기 SLAM 과정에서 얻은 천장 환경에 대한 영상정보와 로봇 의 위치정보를 이용하여 천장 영상지도를 작성한다. 천장 영상지도는 파티클 필터(particle filter)를 이용하여 각각의 영상을 정확하게 통합한다. 본 장에서는 천장 영상지도를 작성하는 방법을 상세하게 설명한다.

2.1. 천장 영상 및 좌표정보 획득을 위한 SLAM

천장 지도를 작성하기 위해서는 초기 데이터 수집 과정 이 필요하다. 이는 로봇의 이동 중에 일정한 간격마다 천 장 영상정보와 그 위치정보를 저장하는 작업을 통해 수행 되며, 저장된 정보를 정합하여 천장지도를 작성할 수 있다. 천장 영상의 위치정보는 추후 전역 위치추정에 사용하므 로 정확한 로봇의 위치정보가 필요하다. 따라서 본 연구에 서는 먼저 레이저 센서의 거리정보를 활용하여 ICP (iterative closest point) 기법으로 SLAM을 수행한다[7].

2.2. 영상 통합

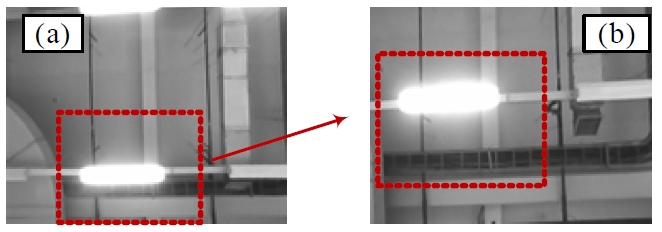

저장된 천장 영상들은 하나의 천장 영상지도로 통합한 다. 기존에 천장 영상지도를 작성하는 연구에서는 중첩되 는 영역을 포함하는 서로 다른 영상을 정합하여 하나의 영상으로 이어 붙이는 모자이크 기법을 이용하였다[8]. 이 방법에서는 천장 구조물간의 높이 차이가 없는 단순한 환 경에서 천장 영상지도를 작성하였다. 그러나 Fig. 1(a)와 (b) 에 나타난 형광등과 주변 배경과 같이 천장 구조물 간의 높이 차이가 있는 경우에는 로봇이 이동함에 따라 카메라 영상간의 시점 변화가 발생하고 출력 영상이 달라진다.

이러한 환경에서 저가의 카메라를 사용할 때, 기존의 영 상 통합 방법은 시점 변화에 따른 영상 변화와 영상 왜곡 으로 인해 영상 통합이 부정확하게 수행되는 한계가 있다. 이는 두 영상의 통합 지점을 정확하게 찾지 못하여 발생 한다. 3장에서 설명하는 영상정합 과정에서 영상지도에서 특징 추출 시 통합된 영상의 높은 정확성이 요구된다. 본 논문에서 제안하는 파티클 필터를 이용한 영상 통합 방법 은 다양한 위치에서 두 영상간의 유사도를 비교하여 최적 의 통합지점을 탐색하므로 기존의 방법보다 정확성이 향 상된 영상 통합이 가능하다.

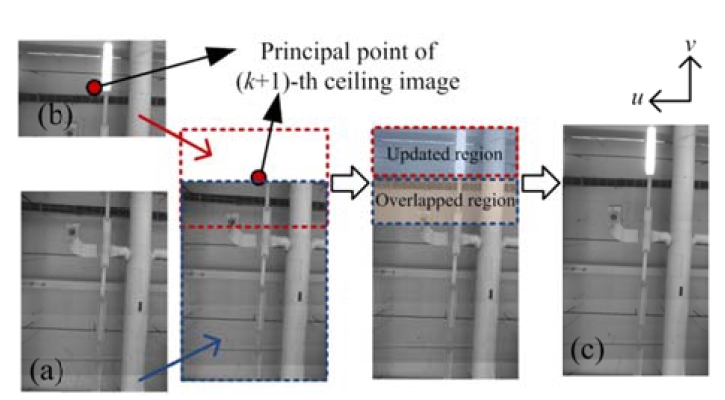

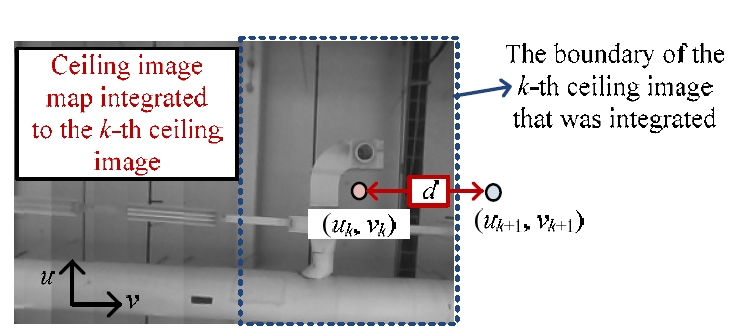

영상 통합은 천장 영상을 저장한 순서대로 순차적으로 수행한다. 처음 획득한 천장 영상에 두 번째 천장 영상을 통합하고, 통합된 영상에 다시 세 번째 영상을 순차적으로 통합해 가는 방식으로 천장 영상지도를 작성한다. Fig. 2에 서와 같이, 영상 통합 작업은 k번째 영상까지 통합된 천장 영상지도에 k + 1번째 영상을 통합하는 방식으로 진행된 다. 먼저, k번째 천장 영상까지 통합된 천장 영상지도에서 k + 1번째 천장 영상의 주점(principal point)이 위치할 좌표 를 탐색한다. 천장 영상지도에 중첩되지 않는 영역에 한해 탐색한 주점을 중심으로 k + 1번째 천장 영상정보를 갱신 한다. 본 논문에서는 주점의 위치를 탐색하는 작업을 영상 통합지점 탐색이라 정의한다. 영상 통합지점 탐색은 SIR (sampling importance re-sampling) 파티클 필터 알고리즘[9]을 사용하였다.

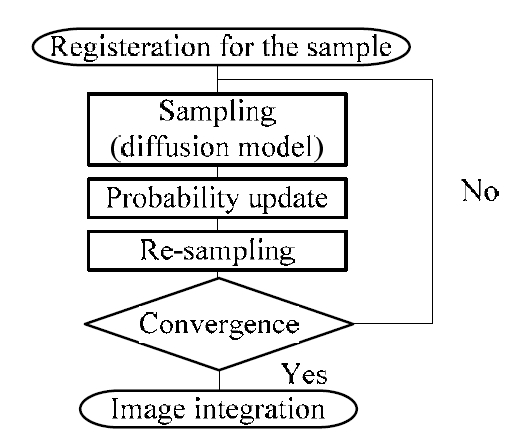

Fig. 3에 영상 통합지점 탐색 과정을 나타내었다. 영상 통합지점을 탐색하기 위해서 먼저 예상되는 영상 통합지 점 근처에 샘플들을 분포시킨다. 다음 단계에서는 확산 모 델을 적용하고, 확률 갱신 및 샘플 재추출 과정을 반복한 다. 위의 과정을 통해 샘플들의 위치는 특정 좌표에 수렴 하게 되며, 수렴된 위치가 영상 통합지점이 된다. 이 과정 은 아래에 자세하게 설명한다.

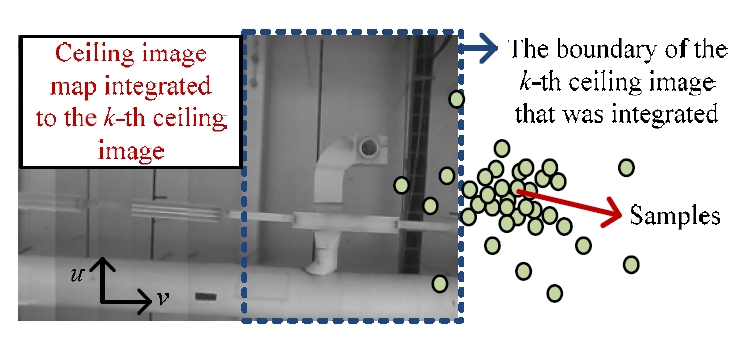

파티클 필터 기반 영상 통합 알고리즘에서 가장 먼저 수행되는 작업은 천장 영상지도에서 영상 통합지점으로 예상되는 위치 주변에 샘플들을 등록하는 것이다. Fig. 4는 천장 영상지도에 k + 1번째 천장 영상을 통합할 때 초기 샘플의 등록을 보여준다.

영상지도에서 k + 1번째 영상의 주점의 위치는 로봇에 장착한 카메라의 위치를 의미한다. 따라서 로봇의 전역좌 표 정보를 활용하면 k + 1번째 영상의 주점의 좌표를 예 측할 수 있는데, 이 때 로봇의 전역좌표 정보 외에도 천장 높이 정보가 추가로 필요하다. 천장 높이 hceiling는 다음과 같이 영상들의 삼각 측량을 통해 계산할 수 있다.

| (1) |

| (2) |

여기서 fu 및 fv 는 카메라의 초점거리를 나타낸다. (uk, vk)는 천장 영상지도에서 k 번째 영상의 주점 좌표, (xk, yk)는 k번째 영상을 저장할 때의 로봇의 전역 위치를 나 타낸다. (k − q)번째 영상은 k번째 영상보다 q번째 먼저 저장된 천장 영상을 나타낸다. hq 는 k 번째 영상과 (k − q) 번째 영상을 삼각 측량해서 얻은 천장 높이이다. fceiling 는 k번째 영상과 앞서 저장된 5개의 천장 영상들을 삼각 측량하여 얻은 평균 천장 높이를 의미한다.

Fig. 5에는 예측한 (k + 1)번째 천장 영상의 주점의 위치 (uk+1, vk+1) 및 k번째 천장 영상의 주점의 위치 (uk, vk) 가 나타나 있다. 두 지점 간의 거리 d는 다음과 같이 계산 할 수 있다.

| (3) |

| (4) |

| (5) |

샘플은 천장 영상지도상에서 예측한 (k + 1) 번째 주점 을 중심으로 반경 2d 영역의 임의의 위치에서 추출된다. 추출된 샘플들은 영상좌표상의 위치정보 (us, vs) 뿐만 아 니라, 영상의 회전각 θs 정보도 포함한다. 등록하는 샘플 의 개수 N은 다음과 같이 결정한다.

| (6) |

여기서 p는 양의 정수인데, 샘플의 개수가 증가할수록 영상 통합 과정의 수행 시간이 증가함을 고려하여 실험을 통해 최적의 값을 얻을 수 있다. 제안한 방법에서는 p값을 10으로 결정하였다.

확산 모델은 샘플들의 위치 변화에 대한 가중치를 계산 하는 모델로, 샘플의 위치에 오차를 적용하여 보다 다양한 샘플의 위치에서 센서 모델을 통한 유사도 비교가 가능하 도록 돕는다. 또한, 확산 모델에서는 영상에 대한 관측오 차와 천장 영상 저장 시 로봇의 움직임으로 발생하는 영 상의 블러(blur)에 대한 오차를 고려하여, 각 오차를 확산 모델의 분산으로 설정하여 샘플들에게 적용한다. 각 샘플 들은 확산 모델을 통해 샘플의 위치오차에 대한 가중치를 적용하는데, 갱신된 샘플의 위치

| (7) |

여기서 σu, σv 는 us, vs 에 대한 위치 표준편차, σθ는영 상 회전에 대한 표준편차를 각각 나타낸다. R(us), R(vs), R(θs)는 각각 us, vs 및 θs 에 대한 랜덤함수이며, -1과 1 사이의 실수 값을 가진다. σb는 영상 블러에 대한 표준편 차를 나타내는데, 로봇이 최대속력에서 블러 효과로 인해 최대 p 픽셀 정도의 영상 오차를 나타내는 경우 다음과 같은 선형 근사식을 통해 결정한다.

| (8) |

여기서 v는 영상을 저장할 때의 로봇의 속력을, vmax는 로 봇의 최대속력을 나타낸다. 오차가 적용된 샘플들은 오차 가 적용되기 전의 위치를 기준으로 가우시안 확률분포를 적용한 값을 확률로 가진다. 오차가 적용된 n번째 샘플의 확률 wn 은 다음과 같다.

| (9) |

| (10) |

| (11) |

| (12) |

여기서 wmin 와 wmax 는 wn 이 0.2~0.8의 범위 내의 값으 로 정규화시켜 주기 위해 사용하며, 각각 0.2와 0.8의 값을 가진다. G(e, σe)는 가우시안 확률분포를 나타낸다. 는 샘 플의 위치오차를 나타내며, σe는 전체 샘플의 e에 대한 표 준편차이다.

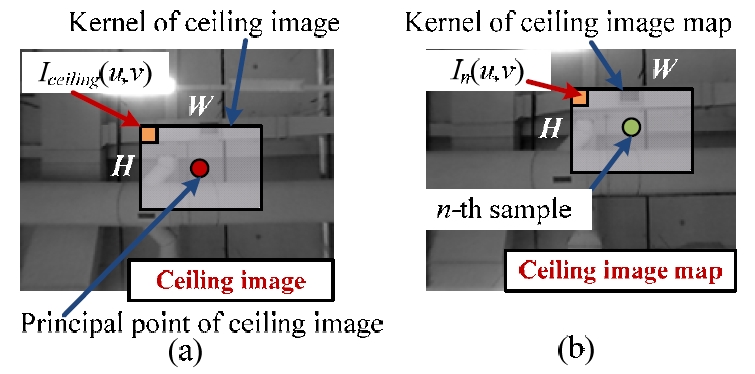

샘플의 확률은 통합할 천장 영상과 각 샘플 주위의 일 정 영역에 대한 유사도를 비교한 후 상대적인 확률로 정 규화하여 갱신한다. Fig. 6과 같이 천장 영상에서 주점을 중 심으로 일정 영역과 전역 천장 영상지도에서 n번째 샘플 을 중심으로 일정 영역에 대한 유사도를 구하는데, 유사도 는 영역간 밝기의 차이를 이용하여 얻는다.

갱신된 샘플의 확률 w'n는 식 (12)를 이용하여 다음과 같 이 구할 수 있다.

| (13) |

| (14) |

| (15) |

여기서 H와 W는 일정 영역의 폭과 너비, Iceiling 는 천장 영상의 밝기, In는 천장 영상지도의 밝기를 각각 나타낸다. n번째 샘플이 중심인 영역과 현재 천장 영상의 주점이 중 심인 두 영역을 비교할 때,

샘플 재추출 과정은 확률이 높은 샘플 주변에 샘플을 재배열하는 과정이다. 즉, 확률이 높은 샘플들은 다음 단 계에서 많이 추출하고, 확률이 낮은 샘플에서는 적게 추출 하거나 추출하지 않는다. 이와 같은 과정을 반복하면 확률 이 작은 샘플은 점차 소거되고, 확률이 높은 샘플의 개수 가 증가하게 된다.

3. 영상정합 기반 전역 위치추정

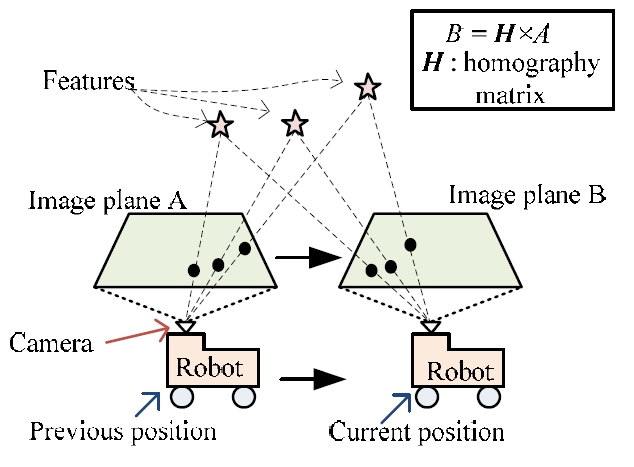

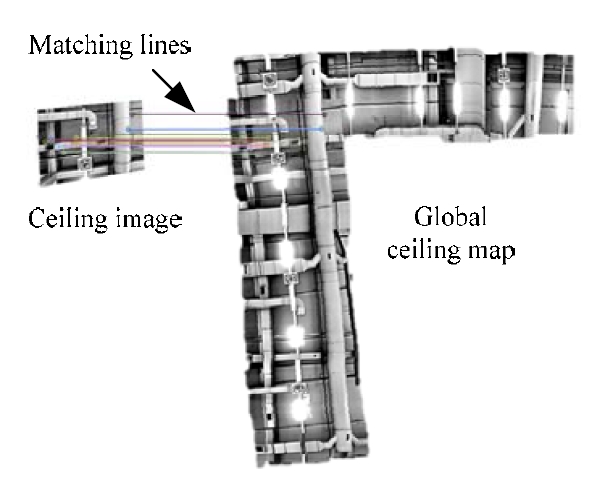

전역 위치추정은 작성된 천장 영상지도와 현재 위치에 서 얻은 천장 영상을 정합하여 수행한다. 두 영상에서 SURF(speeded up robust features) 기반의 특징점 및 서술자를 추출하고 정합한다[10]. 영상정합 과정을 통해 얻은 호모그 래피(homography) 행렬[11]을 이용하면 천장 영상지도에서 현재 영상의 주점이 위치해 있는 좌표를 얻을 수 있다. 획 득한 호모그래피 행렬의 시점 변화가 적절한지 여부를 검 사하여 시점 변화가 적절할 경우 획득한 영상좌표를 로봇 의 전역좌표로 변환한다.

3.1. SURF 기반 영상정합

SURF 알고리즘을 이용하면 영상에서 크기 및 시점에 강인한 특징점 및 서술자를 추출할 수 있다[10]. 추출된 특 징점들은 서술자의 벡터 차를 비교하여 같은 쌍끼리 정합 한다. 영상정합 결과에는 잘못 정합된 이상점(outlier)이 존 재할 수 있는데, 보다 정확한 정합 결과를 얻기 위해서는 RANSAC[12] 알고리즘을 이용하여 이상점을 제거한다.

3.2. 전역 위치 후보 선정

천장 영상과 천장 영상지도를 정합하여 얻은 특징점들 의 쌍을 이용하면 천장 영상의 평면과 천장 영상지도의 평면간의 변환행렬인 호모그래피 행렬을 얻을 수 있다. Fig. 7과 같이 로봇의 위치가 다른 경우 같은 특징점을 바라보 는 시점이 다르지만, 호모그래피 행렬을 통해 두 개의 다 른 시점을 같은 시점으로 일치시킬 수 있다. 이런 평면 변 환을 통해 천장 영상지도에서 천장 영상의 주점이 위치한 좌표를 얻을 수 있다.

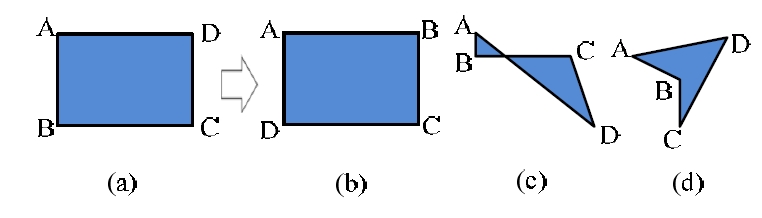

획득한 좌표정보는 영상정합의 신뢰성이 보장되는 경우 에 한해서 전역 위치 후보로 선정한다. 호모그래피를 이용 한 시점 변환 시, 기하학적 변화가 정상적인 경우 영상정 합 결과를 신뢰할 수 있다고 판단한다. Fig. 8에 나타난 그 림과 같이, 호모그래피 행렬의 기하학적 변환이 적절하지 않은 경우들을 찾을 수 있다[11]. 시점의 비정상적인 변환의 예로써 뒤집힘(b), 뒤틀림(c), 그리고 오목(d)의 경우가 있다. Fig. 9에는 신뢰할 수 있는 변환행렬을 이용하여 천장 영상 의 시점을 천장 영상지도의 시점과 일치시킨 결과가 나타 나 있다.

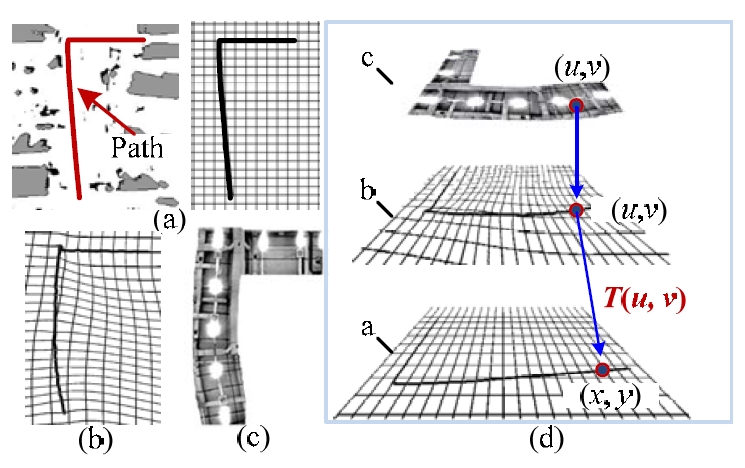

3.3. 전역 위치추정

천장 영상지도에서 선정된 전역 위치 좌표는 영상좌표 계 상의 위치이다. 전역좌표계 상의 로봇의 위치는 영상지 도 좌표를 전역좌표계로의 변환을 통해 구할 수 있다. 좌 표변환은 천장 영상을 얻기 위해 SLAM을 할 때 저장해 두었던 로봇의 전역좌표와 그 지점에 대응되는 천장 영상 지도 좌표 정보들의 보간법을 통해 수행한다. 천장 영상지 도 작성 시 영상의 왜곡이나 영상 통합 시 발생한 오차로 인해 천장 영상지도 평면에 왜곡이 발생할 수 있는데, 이 를 보상해야 정확한 로봇의 위치를 알 수 있으며, 본 논문 에서는 선형 특징 기반 보간법을 통해 왜곡을 보상한다[13]. 여기서 천장 영상을 저장한 순서대로 연속된 로봇의 두 좌표를 연결한 직선들과 영상 통합 지점을 연결한 직선들 을 선형 특징으로 사용하였다. Fig. 10(a)에는 로봇이 30m를 주행했을 때 작성된 격자지도와 로봇의 경로가 나타나 있 다. 격자지도는 각도 분해능이 0.25°, 거리 분해능이 10mm 인 레이저 센서를 이용한 SLAM을 통해 작성되었으며, 경 로의 시작점과 끝점은 실제 경로(ground truth) 대비 15cm 이내의 위치오차 및 3° 이내의 각도오차를 가졌다. Fig. 10(b)는 미리 저장된 로봇의 전역 좌표상의 경로와 그에 대응되는 천장 영상지도 (c)의 점들의 보간법을 통해 영상 지도 평면에 전역좌표 평면의 왜곡이 반영된 영상이다.

천장 영상지도 평면에서 전역좌표 평면으로의 변환을 이용하면 천장 영상지도 상의 좌표 (u, v)에 대응되는 전역 좌표를 다음과 같이 알 수 있다.

| (16) |

여기서 (x, y) 는 로봇의 전역좌표를 나타내며, T 는 (u, v) 에서 전역좌표 평면으로의 보간법 기반 좌표변환을 나타낸다. Fig. 10(d)는 영상지도의 (u, v) 점이 전역좌표상 의 (x, y)점으로 변환되는 과정이 나타나 있다. 이처럼 두 평면상의 위치정보들의 보간법을 통해 전역 위치 후보에 서 로봇의 전역좌표 정보를 획득할 경우 천장 구조물간의 높이 차이가 심한 환경에 강인한 장점이 있다. 식 (2)와 같 이 삼각 측량을 통해 얻은 천장 높이정보는 입력영상 오 차 및 특징점 정합 시 이상점 존재로 인한 오차를 포함하 고 있다. 따라서 천장 높이정보를 활용하지 않으면 천장 높이정보 오차의 영향을 받지 않고 정확한 전역 위치 결 정이 가능하다.

4. 전역 위치추정 실험 결과

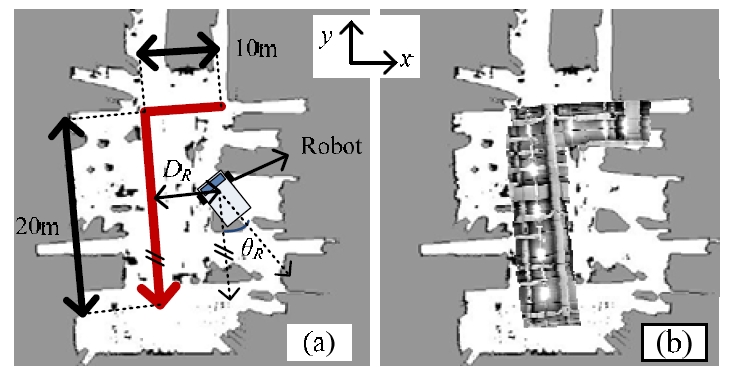

제안한 방법은 실제 공장환경에서의 실험을 통해 검증 하였다. 가로 10m, 세로 20m의 ‘ㄱ’자 모양의 경로 상에서 천장 영상 및 좌표정보를 저장하고, 천장 영상지도를 작성 한 후 전역 위치추정을 수행하였다. Fig. 11(a)는 로봇이 처 음 환경을 탐색하며 작성한 점유 격자지도 상에서 로봇이 탐색한 경로를 나타낸다. Fig. 11(b)는 격자지도 상에 작성 한 전역 천장지도를 나타낸 모습이다.

Fig. 11(a)에서 로봇에서 경로까지의 거리 DR 와 경로를 기준한 로봇의 회전각 θR에 따라서, Table 1에 나타난 4가 지 경우에 대하여 각각 20회씩 실험을 수행하였다.

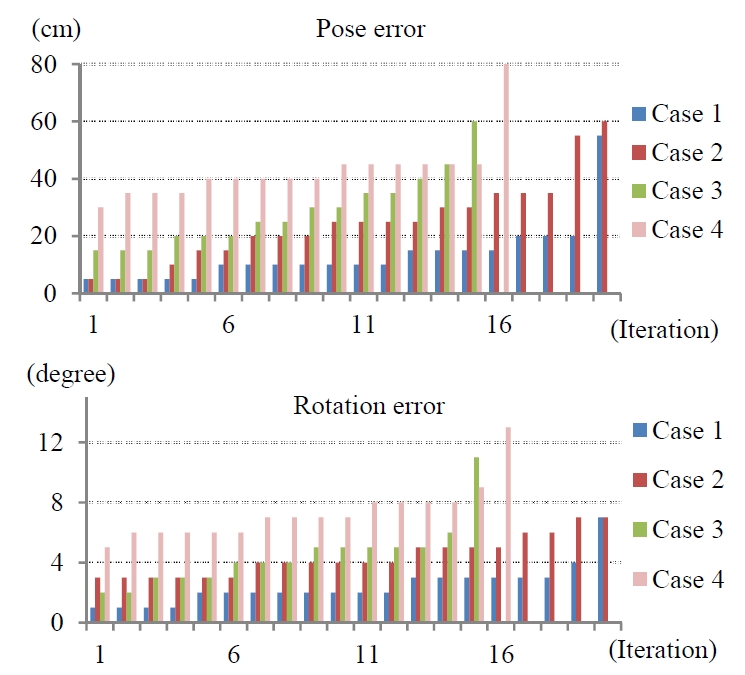

제안한 방법은 천장 영상지도와 추정하는 위치에서 얻 은 천장 영상 간의 정합 결과가 전역 위치추정 성능에 영 향을 준다. 따라서 영상정합 결과 영상 주점의 위치가 10 픽셀 이하의 오차를 가지는 경우를 영상정합 성공이라 정 의할 때, 영상정합 성공률을 통해 전역 위치추정 성능을 평가할 수 있다. Table 2는 각 실험에서의 영상정합 성공률 을 나타낸다.

로봇이 경로로부터 1m 이상 떨어지게 되면 영상정합 성 공률이 감소하였다. 이는 경로로부터 멀어질수록 로봇이 위치추정을 수행하는 위치에서 획득한 천장 영상과 천장 영상지도가 일치하는 영역이 50% 이하로 줄어들기 때문 이다. 실제로 경로로부터 1m 이내에서 벗어난 위치에서의 영상정합 결과는 100%의 성공률을 나타냄을 알 수 있다. 영상정합이 성공했을 때, 추정된 전역 위치의 오차는 Fig. 12에 나타나 있다.

영상정합이 성공했을 때, 실험 조건 1에서 4까지의 평균 위치오차는 순서대로 13.5cm, 24.75cm, 28.67cm, 42.8cm였고, 평균 각도오차는 각각 2.45°, 4.4°, 4.47°, 7.31° 였다. 경로를 기준으로 로봇의 회전각이 증가할수록 평균 위치오차 및 각도오차가 커짐을 알 수 있는데, 이는 카메라의 중심과 로봇의 중심과 수평축이 정확하게 일치하지 않기 때문이 다. 실험 결과, 경로로부터 1m 이내의 거리에서 제안한 전 역 위치추정을 수행하면 25cm 이하의 위치오차와 5° 이하 의 각도오차를 가진다.

5. 결 론

본 논문에서는 파티클 필터에 기반하여 작성한 천장 영 상지도를 이용하여 전역 위치추정을 수행하는 방법을 제 안하였다. 제안된 전역 위치추정의 성능은 실제 공장 환경 에서 검증하였다. 제안한 전역 위치추정 방법은 천장 영상 정보를 이용하므로 공장처럼 주변 수화물의 이동이 잦은 동적 환경에서도 전역 위치추정이 가능하며 저가의 카메 라를 사용하는 장점이 있다. 실험 결과 로봇의 천장 영상 과 작성된 전역 천장지도의 정보가 50% 이상 일치하는 영 역에서는 25cm 이하의 평균 위치오차와 5° 이하의 평균 각도오차를 나타내었다. 추후 연구에서는 더욱 넓은 영역 에 전역 천장지도 작성 및 강인한 위치추정이 가능한 방 법을 제안하고자 한다.

REFERENCES

-

Zhang, G, Suh, I.H, "Loop Closure in a Line-based SLAM", Journal of Korea Robotics Society, (2012), 7(2), p120-128.

[https://doi.org/10.7746/jkros.2012.7.2.120]

-

Nam, C, Kang, J, Doh, N.L, "A New Observation Model to Improve the Consistency of EKF-SSLAM Algorithhm in Large-scale Environmments", Journal of Korea Robotics Society, (2012), 7(1), p29-34.

[https://doi.org/10.7746/jkros.2012.7.1.029]

-

Thrun, S, Fox, D, Burgard, W, Dellaert, F, "Robust Monte Carlo Localizaation for Mobile Robot", Artificial Intelligence, (1999), 128(1), p99-141.

[https://doi.org/]

-

Se, S, Lowe, D, Little, J, "Vision-based Global Localization and Mapping for Mobile Robots", IEEE Trans. Robotics, (2005), 221(3), p364-375.

[https://doi.org/10.1109/tro.2004.839228]

-

Jung, M.K, Song, J.B, "Ceiling Image-based Global Localization Using SIFT and CP Matching", (2013), The Annual Fall Conference of Korean Society of Mechanical Engineers, p1171-1173.

[https://doi.org/]

-

Thruun, S, Bennewitz, M, Burgard, W, Cremers, A.B, , "MINERVA: A Second-generation Museum Tour- guide Robot", (1999), IEEE Proc. International Conference on Robotics and Automation.

[https://doi.org/]

-

Rusinkiewicz, R, Levoy, M, "Efficient Variants of the ICP Algorithm", (2001), International Conference on 3D Digital Imaging and Modeling, p145-153.

[https://doi.org/10.1109/im.2001.924423]

-

Delllaert, F, Thrrun, P.S, Thhorpe, C, "Mosaicing a Large Number of widely Dispersed, Noisy, and Distorted Images: A Bayesiaan Approach", Technical report, computer Science Department, Carnegie Mellon University, (1999).

[https://doi.org/]

-

Carpenter, J, Clifford, P, Fernhead, P, "An Improved Particle Filter for Non-linear Problems", Tech. Rep. Department of Engineering, University of Cambridge, (1998).

[https://doi.org/]

-

Bay, H, Ess, A, tuytelaars, T, Gool, L.V, "Speeded- Up Robust Features (SURF)", Computer Vision and Image Understanding, (2008), 110(3), p346-359.

[https://doi.org/10.1016/j.cviu.2007.09.014]

-

Fischeler, M.A, Bolles, R.C, "Random Sample Consensus: A Paradigm for Model Fitting with Applications to mage Analysis and Automated Cartography", Communication of thee ACM, (1981), 24(6), p381-395.

[https://doi.org/]

-

Hartley, R, Zisserman, A, "Multiple Viiew Geometry in Computer Vision", (2000), Cambridge Univ. Press.

[https://doi.org/]

-

Beier, T, Neely, S, "Feature-Based Image Metamorphosis", ACM GRAPH Computer Graphics, (1992), 26(2), p35-42.

[https://doi.org/10.1145/133994.134003]