센서 융합을 통한 환경지도 기반의 강인한 전역 위치추정

†Corresponding author: Mechanical Engineering, Korea University

© KROS

Abstract

Global localization is one of the essential issues for mobile robot navigation. In this study, an indoor global localization method is proposed which uses a Kinect sensor and a monocular upwardlooking camera. The proposed method generates an environment map which consists of a grid map, a ceiling feature map from the upward-looking camera, and a spatial feature map obtained from the Kinect sensor. The method selects robot pose candidates using the spatial feature map and updates sample poses by particle filter based on the grid map. Localization success is determined by calculating the matching error from the ceiling feature map. In various experiments, the proposed method achieved a position accuracy of 0.12m and a position update speed of 10.4s, which is robust enough for realworld applications.

Keywords:

Global Localization, Mobile Robot, Environment Map, Mapping, Sensor Fusion서 론

로봇의 자율주행을 위해서는 위치추정, 경로계획, 모션 제어 등이 필요하다[1]. 이러한 주행은 로봇의 위치 정보를 바탕으로 수행되므로 로봇의 정확한 초기 위치를 알아내 는 전역위치추정 과정이 필요하다. 현재 전역위치추정과 관련된 다양한 연구가 진행 중이며, 그 중에서 거리정보 기반의 파티클 필터(particle filter) 기법을 이용한 위치추정[2] 과 천장영상을 기반으로 하는 EKF 기반의 위치추정[3-5,13-14] 이 주로 사용되었다. 하지만 거리정보 기반의 위치추정 방 법은 고가의 레이저 센서가 이용되며, 단순한 패턴의 거리 정보가 관측되는 곳에서는 적합하지 않다. 천장을 향하는 단안 카메라 기반의 위치추정 방법은 천장의 특징을 이용 한 지역 위치추정이나 SLAM 작업에는 적합하지만, 단순 한 특징을 이용하므로 비슷한 특징이 계속 반복되는 환경 에서는 적합하지 않다[6]. 이 방법 이외에도 보조지도와 SIFT 인공표식을 이용하여 전역위치를 추정하는 방법이 있다[9]. 이 방법은 전역 위치추정 소요시간이 짧으며, 정확 성을 갖지만, 대칭적인 환경, 일부 환경이 변경된 장소, 특 징이 존재하지 않는 장소에서는 정확한 위치를 찾을 수 없다. 영상정보의 불확실성을 개선하기 위하여 wifi를 이용 한 전역 위치추정 방법도 제안되었다[10]. 이 방법의 경우 통신환경 변화에 따라 성능이 달라지므로 모든 환경에 강 인하게 작용하지는 못한다.

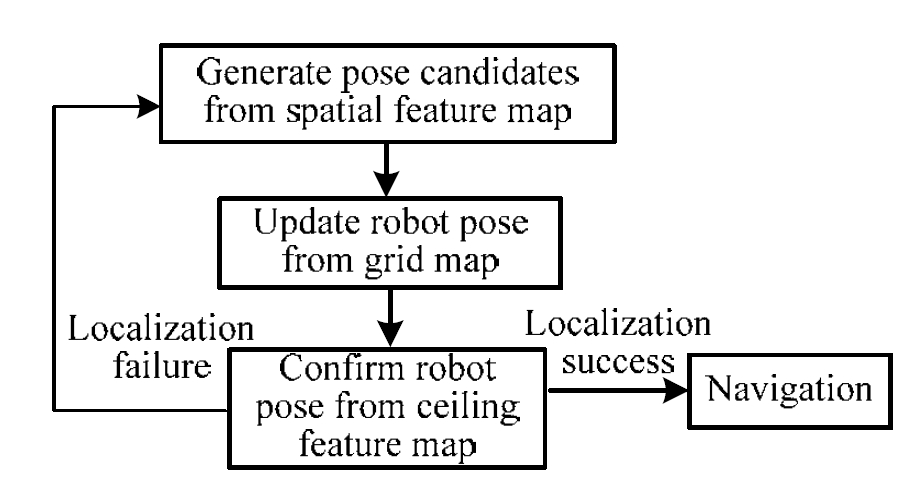

본 논문에서는 대칭적이거나, 일부 환경이 변경된 장소, 특징 검출이 어려운 지역 등의 다양한 환경에서 전역 위 치추정을 성공적으로 수행하기 위해 천장 지향 카메라와 키넥트 센서를 이용한 방법을 제안한다. 제안한 방법은 초 기 지도작성 작업을 통해 격자지도, 공간 특징지도, 천장 특징지도가 통합된 환경지도를 작성하고, 작성된 환경지도 에서 로봇의 초기 위치를 추정하는 방법이다. 격자지도는 거리정보만을 가진 2D지도이며, 천장 특징지도는 천장에 대한 특징정보를, 공간 특징지도는 공간에 대한 특징정보 와 거리정보를 가진다. 전역 위치추정 과정은 공간 특징지 도로부터 로봇의 후보지를 선정하고, 격자지도로부터 로봇 의 위치를 갱신하며, 천장 특징지도로부터 로봇의 최종 위 치를 판별하는 순으로 수행된다. 격자지도를 이용한 로봇 의 위치 갱신은 파티클 필터 기반으로 수행되었으며, 실제 환경에서 강인하게 동작한다[2]. 이 과정에서 실제 환경에 서 얻어오는 넓은 범위의 거리정보를 필요하므로 가상지 도의 개념을 활용하였다. 또한 제안한 방법은 Fig. 1과 같 이 강인한 특징이 추출될 수 있는 일부 물체(예, 액자)가 사라지더라도 환경지도를 이용하여 위치를 추정할 수 있 는데, 이는 공간 특징지도가 유사하지 않더라도 격자지도 와 천장 특징지도를 이용하여 자신의 위치를 파악할 수 있기 때문이다.

다른 경우로 Fig. 2와 같이 큰 가구가 사라져서 격자지도 에 얻어지는 정보가 다르더라도 환경지도를 이용하여 로 봇의 위치를 추정할 수 있다. 결과적으로, 본 논문에서 제 안한 환경지도를 이용한 위치추정 방법은 다양한 지도 정 보를 이용하여 환경의 일부가 변하더라도 강인한 위치추 정이 가능하다.

본 논문은 다음과 같이 구성된다. 2장에서는 환경지도작 성에 대하여 설명하며, 3장에서는 공간 특징지도를 이용한 후보지 선정에 대하여 설명한다. 4장에서는 격자지도와 천 장지도를 이용한 전역 위치추정에 대한 설명을 한다. 5, 6 장에서는 실험 결과 및 결론을 도출한다.

환경지도 작성

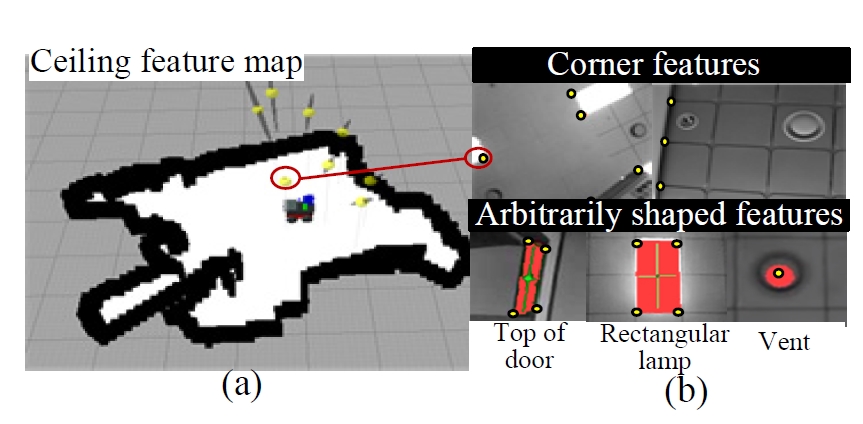

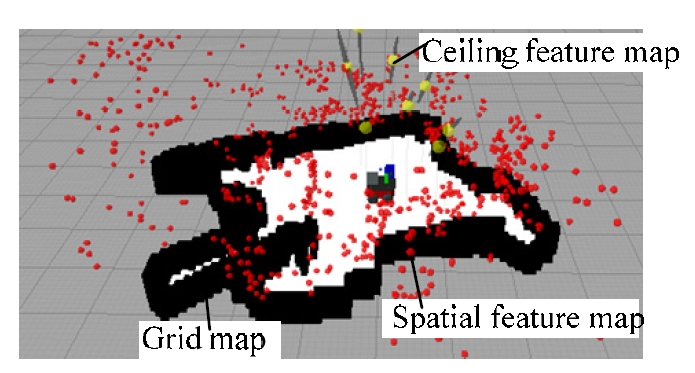

본 논문에서 제안한 환경지도는 격자지도, 천장 특징지 도 및 공간 특징지도로 구성된다. 천장 특징지도는 천장 지향 모노카메라를 이용하여 천장으로부터 영상특징을 추 출하여 작성한 지도이다. 격자지도는 키넥트 센서로 측정 한 거리정보를 이용하여 작성하며[11,12], 공간 특징지도는 키넥트 센서로 얻은 영상에서 추출한 특징의 좌표와 정보 로 구성된다. 지도작성 중 로봇의 위치는 천장지도를 이용 하여 추정한다. 한편, 키넥트 센서의 감지범위의 제한이 있으므로, 정확한 격자지도를 작성하기 위해 로봇이 지그 재그로 움직이면서 지도를 작성한다.

격자지도 작성

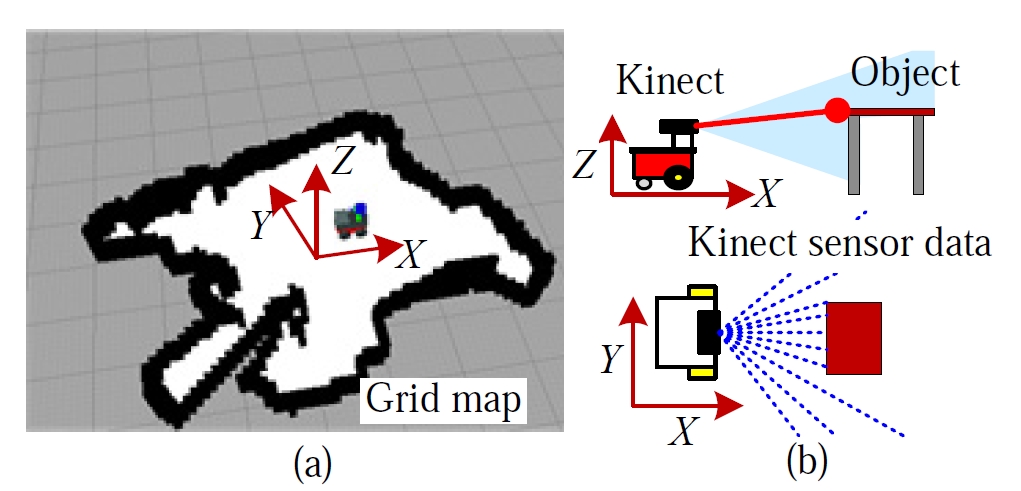

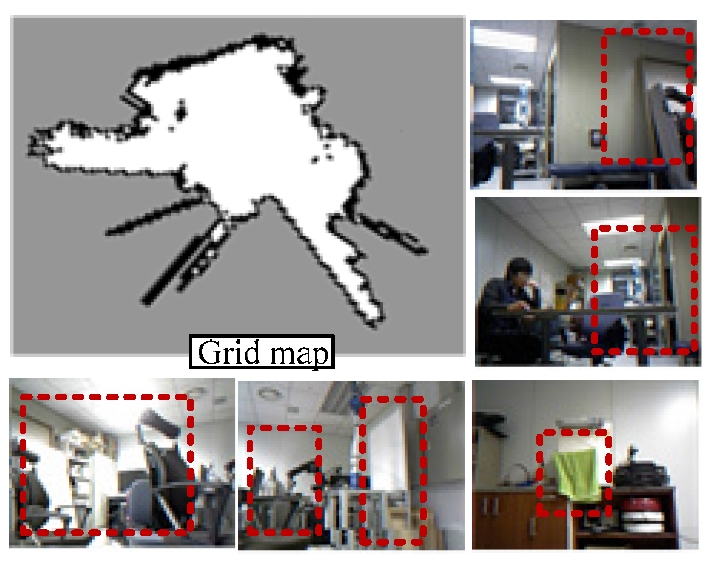

Fig. 3(a)에 나타낸 격자지도는 키넥트 센서의 3D 거리정 보를 XY 평면에 투영하여 얻을 수 있는 2D 거리정보를 이 용하여 작성된다. Fig. 3(b)와 같이 장착한 키넥트 센서의 거 리정보는 레이저 스캐너, 적외선 스캐너와 같은 2D 거리 센서로 탐지할 수 없는 영역도 관측할 수 있으므로 장애 물과의 충돌 위험을 줄일 수 있다.

공간 특징지도를 이용한 로봇 위치후보지 선정

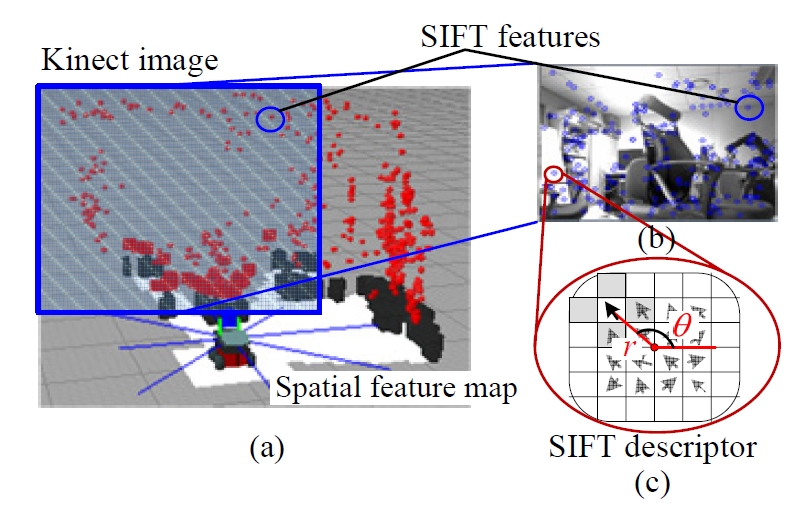

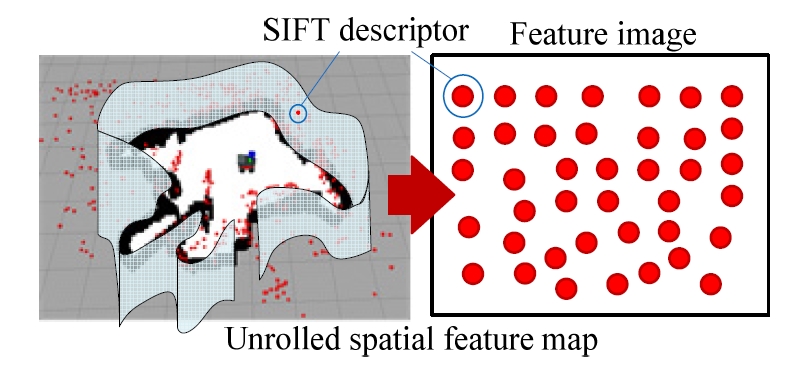

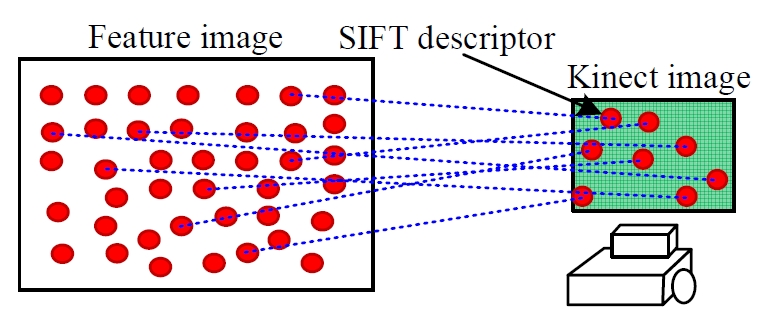

공간 특징지도는 전방 키넥트 센서를 이용하여 작성한 3D지도이다. 지도 상의 각 특징들은 현재 키넥트 영상에 서 추출된 SIFT 특징들과의 정합을 통하여 로봇의 위치 후보지를 선정하는데 이용된다. 로봇은 주변을 둘러 봄으 로써 자신의 위치에 대한 후보지를 대략적으로 추정할 수 있으므로, 전역 위치추정 과정에는 초기 주변환경에 대한 정보를 받아오기 위하여 제자리 회전을 통한 환경정보 수 집이 필요하다. 이 때 환경에 대한 모든 특징들을 추출하 며, 많은 특징들과의 정합을 통하여 좀 더 신뢰성 있는 후 보지를 추출할 수 있다. Fig. 6과 같이 로봇 주변의 공간 특 징지도를 연결하여 하나의 특징영상(Feature image)을 만들 고, 정합은 특징영상과 현재 키넥트로 관측한 영상을 이용 하여 수행하였다.

Fig. 7은 현재 키넥트 영상 (Kinect image)과 특징영상과의 정합을 나타낸 것이다. 여기서 정합에 성공한 특징들을 이 용하여 로봇의 위치를 추정할 수 있다.

특징들의 정합 결과를 이용하면 로봇의 상대 좌표를 구 할 수 있다[8]. 먼저 공간 특징지도에서의 특징점들의 3D 좌표를 S(x, y, z), 현재 키넥트 영상에서의 특징점들의 3D 좌표를 K(x, y, z)로 나타내면, 각각의 무게 중심 μS, μK는 다음과 같다.

| (1) |

여기서 N는 정합에 성공한 일치점의 개수, i는 정합 인덱스 이다. 식 (1)로 구한 무게중심을 이용하면 특징들의 S, K 에 대한 편차를 다음과 같이 구할 수 있다.

| (1) |

이 편차를 다음과 같이 연산하여 행렬 W을 구한다.

| (3) |

SVD(singular value decomposition) 기법을 사용하여 다음과 같이 행렬 W를 분해한다.

| (4) |

여기서 Σ는 행렬 W의 특이값(singular value)이며, 행렬 U와 V을 이용하여 병진 및 회전에 대한 행렬 R과 T를 각각 구 할 수 있다.

| (5) |

계산된 행렬 R, T을 적용하면 오차는 다음과 같다.

| (6) |

여기서 ε는 로봇의 위치오차이다. 로봇의 후보지의 크기는 오차를 이용하여 다음과 같이 구한다.

| (7) |

여기서 r은 로봇 후보지의 반지름, α는 비례상수이다. 오차 가 클수록 로봇 후보지의 반지름 r이 커진다.

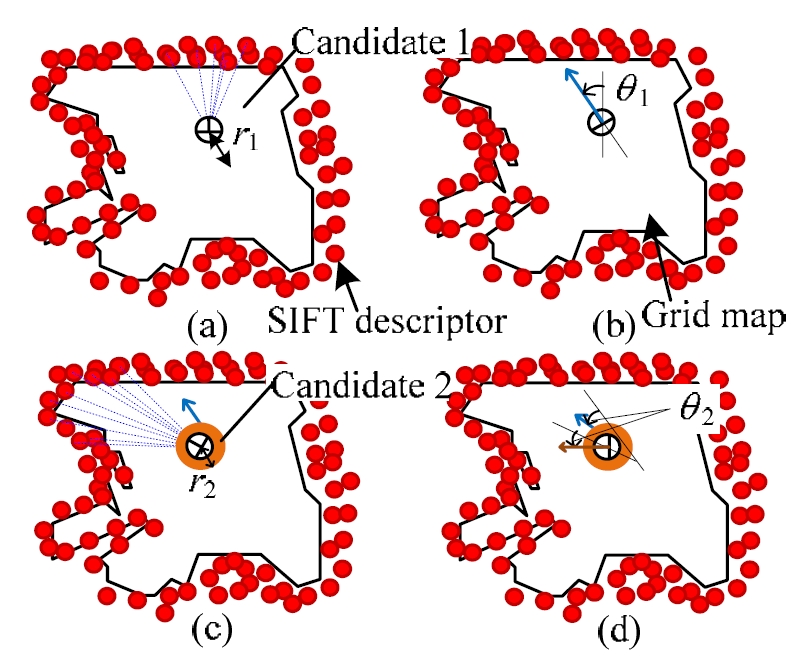

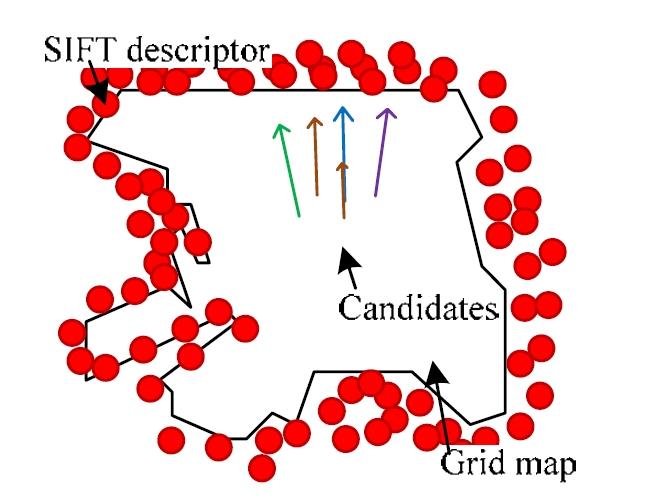

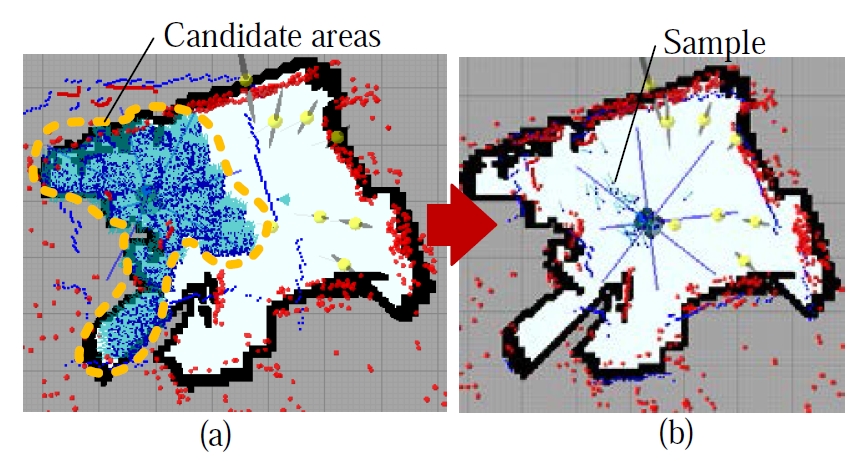

현재 로봇이 관측하는 한 영역만을 이용하여 위치를 추 정할 경우, 영상에서 특징이 추출되지 않거나 센서의 오차 및 거리의 한계로 불확실한 로봇의 위치가 추정될 수 있 다. 따라서 로봇은 제자리 회전 과정을 통해 다수의 후보 지를 선정하는데, 그 과정은 Fig. 8과 같다.

Fig. 8(a)는 공간 특징지도로부터 정합한 특징을 이용하 여 로봇의 위치를 추정한 것이다. 계산된 정합 오차에 따 라 로봇의 위치 후보지의 크기는 r1으로 나타난다. 로봇은 제자리 회전을 하면서 다음 키넥트 영상과 특징영상간의 정합을 수행한다. 여기서 로봇의 회전을 고려하여, 로봇의 회전각 θ1만큼 추출된 후보지도 회전시킨다. 이렇게 함으 로써 로봇의 회전이 완료되었을 때, 실제 로봇과 같은 방 향을 갖는 후보지가 선정된다. 후보지 1의 방향은 Fig. 8(b) 와 같이 움직이게 된다. 회전한 로봇의 위치에서부터 키넥 트 영상과 특징영상 간의 정합을 통하여 Fig. 8(c)와 같은 후보지 2가 결정된다. 정합 오차가 Fig. 8(a)의 오차보다 작 으면, 후보지 크기 r2는 r1보다 작게 나온다. 다시 로봇이 회전하면 회전각도 θ2만큼 움직이게 되고 후보지 1과 2도 θ2만큼 이동하게 된다. 로봇이 제자리 회전하여 선정된 후 보지는 Fig. 9와 같이 나타낼 수 있다. 각각의 정합 오차에 따라 로봇 후보지의 크기가 다르게 나타난다. 또한, 후보 지는 로봇의 회전을 반영하므로 모두 비슷한 방향을 가지 며, 크기에 상관없이 동일한 개수의 샘플들을 가진다. 따 라서 정확하게 정합된 후보지일수록 면적당 샘플의 개수 가 증가되며, 실제 로봇 위치를 포함한 후보지에 많은 수 의 샘플들이 분포시킬 수 있다. 부정확하게 정합된 후보지 는 넓은 범위에 샘플들이 분포됨으로 파티클 필터의 갱신 과정에서 쉽게 제거된다.

전역 위치추정

가상지도를 이용한 파티클 필터 기법

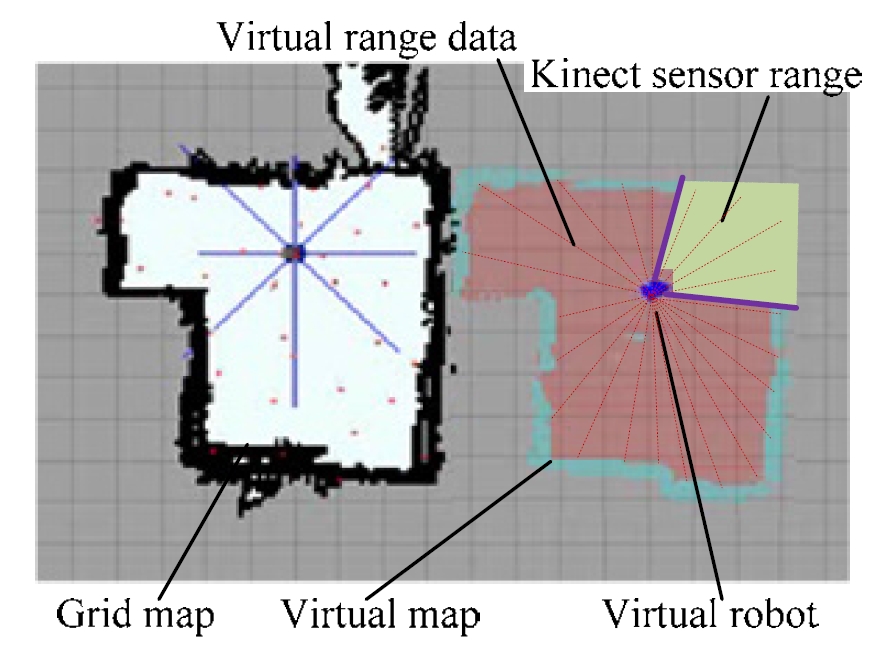

본 논문에서는 파티클 필터를 이용하여 정해진 후보지 에 샘플을 분포시켜 로봇의 위치를 갱신하는 방법을 이용 하였다[2]. 그러나 키넥트 센서를 이용한 파티클 필터 기법 은 키넥트 센서의 좁은 FOV로 인하여 부정확하게 위치를 추정하는 문제점이 있다. 이를 개선하기 위하여 본 논문에 서는 후보지 선정 과정에서 키넥트 센서로부터 획득한 360°거리정보를 이용하였다. 이 과정을 위하여 가상지도를 작성하고, 작성된 가상지도로부터 거리 값을 받아온다. 가 상지도는 실제 환경에서 얻어오는 거리정보를 획득하기 위하여 사용되는 지도로서, 현재 로봇의 진행 방향에 대한 실시간 거리정보를 가진다. 또한, 현재 키넥트 센서 범위 내에 들어오지 않는 장소의 거리 정보는 이전 센서정보로 작성된 가상지도로부터 획득할 수 있다. 이렇게 함으로써 로봇을 기준으로 로봇 주변의 모든 거리정보를 획득할 수 있다. 여기서 로봇이 현재 관측하고 있는 거리를 제외한 나머지 거리는 이전 임의의 시간에 관측한 정보이므로 현 시간 때의 정보라고 판단하기 어렵다. 따라서 본 논문에서 는 이러한 거리정보를 가상 거리정보라고 표현한다.

가상의 센서정보와 샘플들이 가지는 거리정보를 비교하 면 각 샘플이 가지는 확률을 계산할 수 있다. 먼저, 거리정 보 간의 유사도를 측정하기 위하여 두 거리간의 차이를 계산한다. Fig. 10.

| (8) |

거리오차 e는 로봇이 가상지도로부터 획득한 거리정보 zt와 격자지도에서 예측한 위치에서 지도로부터 획득한 거 리정보 ot의 차이다. 이 때, ray-tracing 방법을 이용하여 가 상지도와 격자지도에서 거리정보를 추출한다. 식 (8)은 각 1도마다의 zt와 ot의 차이를 제곱한 값들의 합을 오차로 계 산한 것이며, K는 360을 나타낸다. 확률밀도함수는 오차 e 와 가우시안 확률에 의해 다음과 같이 정의된다.

| (9) |

여기서 σ은 거리 간의 표준편차를 나타낸다. 확률 Pσ는 두 거리의 차이가 클수록 작아진다. 각각의 샘플들은 이 과정 을 통해 자신의 확률을 갱신하며, 반복적인 과정을 통하여 로봇의 위치가 추정된다.

천장 특징지도를 이용한 위치 판별법

로봇이 자율적인 전역 위치추정을 수행하기 위해서는 성공적인 위치추정 여부를 판단하는 것이 필요하다. 일반 적으로 로봇이 정적인 환경에서 동작하는 것이 아니므로 항상 작성한 지도와 실제 환경이 일치하지 않는다. 따라서 추정된 로봇의 위치는 실제 로봇의 위치와 다를 수 있다. 본 논문에서는 이를 개선하기 위해서 상대적으로 환경 변 화가 작은 천장 특징지도를 이용하여 전역 위치추정 성공 여부를 판단한다.

로봇의 추가적인 이동을 통하여 작성된 천장 특징지도 와 현재 천장 영상의 특징이 정상적으로 정합되고 있는지 의 여부를 판별한다[7].

| (10) |

여기서 Rloc는 위치추정 신뢰성을 나타낸다. 로봇의 위치 를 정확하게 추정하였는지를 판단하기 위해 추가적인 이 동이 필요하며, 이 과정에서 로봇이 이동한 거리를 d라 표 현하였다. 즉, d는 로봇의 위치를 판별하기 위해 움직인 총 이동거리이다. dfail는 위의 과정에서 천장 특징정합에 실패 한 상태로 이동한 거리를 나타낸다. 로봇이 천장 특징정합 을 하지 못한 상태로 이동한 거리가 길수록 Rloc가 작아진 다. 본 논문에서는 전역 위치추정 실패를 Rloc가 0.25보다 작은 경우로 판단하였다. 0.25는 실험을 통하여 선정된 임 계 값이다.

전역 위치추정 과정

전역 위치추정 과정은 후보지 선정과 로봇의 위치 갱신, 위치추정 성공 판단의 순으로 이루어진다. 먼저, 로봇의 초기 위치 후보지를 선정하는 과정에서는 로봇의 제자리 회전으로 주변환경에 대한 정보를 획득하여 로봇의 위치 를 대략적으로 판별한다. 각 후보지들이 결정되면 해당 영 역에 로봇의 샘플을 분포시키고 360° 거리정보를 이용하 여 샘플들의 위치를 갱신한다. 샘플이 수렴하여 로봇의 위 치가 결정되면, 로봇의 추가적인 이동을 통하여 천장 특징 지도와 실제 환경을 비교하여 성공 여부를 확인한다. 로봇 의 위치가 정확한 위치라고 판단되었을 때, 로봇의 주행을 시작한다. 천장환경을 검사하여 로봇의 위치가 부정확하다 고 판단되면, 위의 과정을 다시 반복한다. Fig. 11은 위의 과 정을 간단히 도식화한 것이다.

실험 결과

본 논문에서는 환경에 대한 환경지도를 작성하고 변화 된 환경에서 강인하게 위치추정이 가능한지를 실제 환경 에서의 실험을 통해 검증하였다. 실험환경은 크기 10m x 10m이며, 로봇에는 전방의 키넥트 센서와 천장을 관측하 는 모노카메라를 장착하였으며, 2.4GHz CPU를 탑재한 임 베디드 컴퓨터를 이용하였다. 전역 위치추정을 실험하기에 앞서, Fig. 13과 같은 사무실 환경을 실험환경으로 하여 Fig. 12와 같이 환경지도를 작성하였다.

제안한 전역 위치추정 알고리즘의 강인함을 실험하기 위해서 시간 및 환경에 변화를 주었다. 변경된 환경은 Fig. 14와 같으며, 천장 환경은 동일한 환경을 사용한다. 변경 된 부분은 붉은 색으로 점선으로 표시하였다.

로봇의 초기 회전을 통하여 환경에 대한 정보를 획득하 여 후보지를 선정한 결과가 Fig. 15(a)에 나타나 있다. 각 샘플의 확률은 거리정보와 위치 움직임을 이용해서 갱신 되었으며, Fig. 15(b)와 같이 확률이 높은 쪽으로 수렴하였 다. 수렴이 완료되면 천장정보로 위치추정 성공 여부를 판 별하였다. 초기 환경정보를 획득하기 위한 로봇의 회전속 도는 30deg/s로 설정하였으며, 이동속도는 400mm/s로 설정 하였다. 위치추정 시간이 1분을 초과하거나 추정된 위치가 실제 위치와 30cm, 10° 이상 차이가 나는 경우는 실패로 간 주하여 성공률에 반영하였다.

제안한 방법을 시간에 무관하게 전역 위치추정 성공률 을 측정하면, 반복적으로 알고리즘을 수행하여 모든 경우 에 대하여 성공할 수 있다. 그러나 실제 환경에서 사용하 기 위해서는 수행시간도 매우 중요하므로 시간을 한정하 여 성공률을 결정하였다. 위치추정 정확성은 추정된 로봇 의 위치와 실제 로봇의 위치를 비교하여 측정하였다.

표 1은 환경을 조금씩 변경하면서 50번 실험한 결과를 나타낸 것이다. 수행시간과 정확성은 전역 위치추정이 성 공했을 때를 기준으로 측정한 것이다. 격자지도만을 이용 하여 전역 위치추정을 할 경우 후보지 선정과정이 없으므 로 성공률이 68%로 감소하는 것을 볼 수 있다. 실패로 판 단하는 경우는 위치추정의 정확성보다는 정해진 시간을 초과하는 경우가 많았다. 격자지도와 공간 특징지도를 이 용한 경우에는 천장 특징지도를 검색할 필요가 없으므로 실제 전역 위치추정 시간은 5.2s로 감소하지만, 환경 변화 가 심할 경우 키넥트 센서만으로는 판단하기 어려우므로 성공률이 저하되는 것을 알 수 있다. 반면에, 환경지도를 사용하는 경우에는 제한된 시간 내에 정확한 위치를 추정 할 수 있다. 실제로 전역 위치추정에 소요되는 총 시간은 회전시간 12.3초와 위치추정에 걸리는 시간 10.4초의 합에 해당한다. 다수의 후보지를 선정하여 로봇의 위치를 추정 하는 방법은 정확한 후보지에 더 많은 샘플을 분포시킬 수 있으므로 전역에 샘플을 분포하는 것에 비해 빠르게 위치를 수렴할 수 있다. 여기서 추정된 로봇의 위치는

12cm, 8.4°정도로 작은 오차를 가진다. 위치오차는 레이저 거리계와 자이로 센서를 이용하여 측정하였다. 또한, Fig. 13과 Fig. 14의 변화처럼 구조 및 특징들이 변화하더라도 환경변화에 강인하게 작용할 수 있다.결 론

본 논문에서는 천장 지향 카메라와 키넥트 센서를 이용 하여 환경지도를 작성하고, 이를 이용한 전역 위치추정 방 법에 대하여 제안하였다. 제안된 전역 위치추정 방법의 효 용성은 실험을 통하여 입증하였으며, 다음과 같은 결론을 도출하였다.

- 격자지도, 공간 특징지도, 천장 특징지도로 구성된 환 경지도를 사용하여 환경이 일부 변화하더라도 강인하 게 위치를 추정할 수 있었다.

- 제안한 방법을 사용한 로봇 위치추정 시간은 1분 이내, 정확성은 90% 이상, 위치추정 정확도는 12cm, 8.4°의 성능을 보여주었다.

- 저가센서의 융합을 통하여 기존의 단일 센서를 사용하 는 방법에 비해서 다양한 환경에서도 안정적으로 전역 위치추정이 가능하다.

본 연구에서는 일부 영역이 키넥트 센서 감지범위 내에 있다는 가정하에 센서융합을 이용한 전역 위치추정 방법 을 제안하였다. 그러나 키넥트 센서의 감지거리보다 넓은 환경의 경우, 제자리 회전을 반복적으로 수행해야 하므로 전역 위치추정에 많은 시간이 소요되는 단점이 있다. 따라 서 추후 연구에서는 로봇이 이동하는 중에도 후보지를 추 가할 수 있는 알고리즘을 연구할 예정이다. 이 과정을 통 하여 넓은 환경에서도 빠르고 강인한 위치추정이 가능할 것이라고 판단한다.

REFERENCES

- Siegwart, R, Nourbakhsh, I. R, “Introduction to Autonomous Mobile Robots”, (2004), Cambridge, MIT Press.

-

Fox, D, Bugard, W, Thrun, S, “Active Markov Localization for Mobile Robots”, Robotics and Autonomous Systems, (1998), 25, p195-207.

[https://doi.org/10.1016/s0921-8890(98)00049-9]

-

Hwang, S. Y, Song, J. B, “Clustering and probabilistic matching of arbitrarily shaped ceiling features for monocular vision-based SLAM”, Advanced Robotics, (2013), 27(10), p739-747.

[https://doi.org/10.1080/01691864.2013.785377]

- Montemerlo, M, Thrun, S, Koller, D, Wegbreit, B, “FastSLAM 2.0: An improved particle filtering algorithm for simultaneous localization and mapping that provably converges”, (2003), Proc. of the 16th Int. Joint Conf. on Artificial Intelligence.

-

Xu, D, Han, L, Tan, M, Li, Y. F, “Ceiling-Based Visual Positioning for an Indoor Mobile Robot With Monocular Vision,”, IEEE Trans. on Industrial Electronics, (2009), 56(5), p1617-1628.

[https://doi.org/10.1109/tie.2009.2012457]

-

Hwang, S. Y, Song, J. B, “Monocular Vision-based Global Localization Using Position and Orientation of Ceiling Features,”, (2013), Proc. of the IEEE Int. Conf. on Robotics and Automation.

[https://doi.org/10.1109/icra.2013.6631109]

-

Lowe, D. G, "Distinctive image features from scaleinvariant keypoints", Int. Journal of Computer Vision, (2004), 60(2), p91-110.

[https://doi.org/10.1023/b:visi.0000029664.99615.94]

-

Rusinkiewicz, R, Levoy, M, “Efficient Variants of the ICP Algorithm,”, (2001), Int. Conf. on 3D Digital Imaging and Modeling, p145-153.

[https://doi.org/10.1109/im.2001.924423]

-

Se, S, Lowe, D. G, Little, J. J, “Vision-based global localization and mapping for mobile robots,”, IEEE Trans. on Robotics, (2005), 21(3), p364-375.

[https://doi.org/10.1109/tro.2004.839228]

-

Ocana, M, Bergasa, LM, Sotelo, MA, Flores, R, Llorca, DF, Schleicher, D, “Automatic training method applied to a WiFi + ultrasound POMDP navigation system,”, Robotica, (2009), p1049-1061.

[https://doi.org/10.1017/s0263574709005463]

-

Elfes, A, “Using Occupancy grids for mobile robot perception and navigation”, IEEE Journal of Computer, (1989), 22, p46-57.

[https://doi.org/10.1109/2.30720]

- Thrun, S, Burgard, W, Fox, D, Probabilistic Robotics, (2005), Cambridge, The MIT Press.

-

Nam, C, Kang, J, Doh, N. L, “A new Observation Model to Improve the Consistency of EKF-SLAM Algorithm in Large-scale Environments”, Journal of Korea Robotics Society, (2012), 7(1), p29-34.

[https://doi.org/10.7746/jkros.2012.7.1.029]

-

Kim, S, Lee, J, “EKF based Mobile Robot Indoor Localization using Pattern Matching”, Journal of Korea Robotics Society, (2012), 7(1), p45-56.

[https://doi.org/10.7746/jkros.2012.7.1.045]