다층 실내 환경에서 계단 극복이 가능한 궤도형 로봇의 신뢰성 있는 자율 주행 정찰 시스템

CopyrightⓒKROS

Abstract

This paper presents a robust autonomous navigation and reconnaissance system for tracked robots, designed to handle complex multi-floor indoor environments with stairs. We introduce a localization algorithm that adjusts scan matching parameters to robustly estimate positions and create maps in environments with scarce features, such as narrow rooms and staircases. Our system also features a path planning algorithm that calculates distance costs from surrounding obstacles, integrated with a specialized PID controller tuned to the robot’s differential kinematics for collision-free navigation in confined spaces. The perception module leverages multi-image fusion and camera-LiDAR fusion to accurately detect and map the 3D positions of objects around the robot in real time. Through practical tests in real settings, we have verified that our system performs reliably. Based on this reliability, we expect that our research team’s autonomous reconnaissance system will be practically utilized in actual disaster situations and environments that are difficult for humans to access, thereby making a significant contribution.

Keywords:

Autonomous Robot, Localization, Path-Planning, Control, Sensor Fusion1. 서 론

최근 자율주행 기술의 비약적인 발전과 함께 자동화시스템에 대한 수요증가는 무인 로봇 시스템에 대한 관심을 크게 증가시켰다[1]. 음식점에서의 서빙, 건물 내 배달, 물류 등 다양한 영역에서 자율주행 로봇이 활용되고 있고[2-5], 특히 원자력 발전소 내부나 화재상황 등 사람이 직접 접근하기 어려운 위험지역이나 재난 환경에서 정찰을 위해 무인 로봇이 많이 활용되는 추세이다[6-9].

실내환경에서 자율주행 로봇의 활용 범위를 확장하기 위해서는 층간 이동이 필수적이다. 로봇의 층간 이동을 위해 IoT를 활용하여 엘리베이터와 연동하거나, 매니퓰레이터를 사용하여 직접적으로 엘리베이터와 상호작용하는 등의 연구들이 활발히 진행되고 있지만, 네트워크 지연 및 불안정으로 통신의 신뢰성을 잃거나 엘리베이터가 없는 다층환경에서는 적용할 수 없는 한계점이 존재한다[10-12].

이에 본 연구진은 계단을 극복할 수 있는 궤도로봇[Fig. 1]의 다층 실내 환경에서 신뢰성 있는 자율주행 정찰 시스템을 제안한다. 실내 환경에서 GPS 정보 사용이 제한적임을 고려하여, 로봇의 자체적인 위치 추정을 위해 본 연구진은 기존 연구에서 제안한 방법[13]을 활용하였다. 이 방법은 적응형 키프레임 생성을 활용하는 LIO (LiDAR Inertial Odometry)알고리즘으로 실내 지도 구축과 위치 추정을 3차원 라이다 센서를 사용하여 수행한다. 주변 환경크기에 맞게 스캔 매칭에 사용될 하이퍼파라미터들을 결정하여 홀과 같은 넓은 공간과 계단 및 복도와 같은 좁은 환경에서도 강인한 위치추정이 가능하다. 또한, 좁은 방문사이를 충돌없이 통과하기 위해 Distance map 개념을 활용한 Modified A* 알고리즘[14]을 활용하였다. 본 알고리즘은 기존의 최단거리 경로를 추출하는 A* 알고리즘 비용함수에 경로와 장애물과의 거리 비용을 함께 고려하여 좁은 길과 방문과 같은 로봇이 충돌할 위험성이 있는 환경에서 안정적인 경로계획이 가능하다. 구동모터의 제어는 평지와 계단을 구분하여 적용하였다. 평지에서는 Differential Kinematics기반의 Pure Pursuit 알고리즘을 활용하였고, 이를 모터의 PID제어를 통해 수행하였다. 계단의 경우에는 로봇의 횡방향 동역학적 특성을 고려하여 일반적인 평지 주행과 상이하게 PID gain을 튜닝하여, 계단에서 불안정한 거동 없이 안정적으로 주행이 가능하도록 구성하였다. 또한, 초음파센서를 사용하여 계단의 종료지점을 판단하고 Flipper를 로봇 몸체의 아래쪽으로 이동시켜 로봇에 가해지는 충격을 최소화하였다.

![[Fig. 1] [Fig. 1]](/xml/40705/JKROS_2024_v19n2_149_f001.jpg)

Our autonomous tracked robot performs reconnaissance, successfully navigating stairs in a multi-level building

무인 실내 정찰을 위한 인식 모듈에는 카메라-LiDAR 퓨전 알고리즘을 활용하였다. YOLO[15]와 같은 one-stage 객체 인식 모델의 등장으로 자율 정찰 로봇에서 카메라 센서가 많이 활용되는 추세이지만, 카메라 센서는 대상 물체의 깊이 정보를 알기 어렵고 시야각이 제한되어 주변 목표 물체의 3차원 위치를 빠르게 파악하기 어렵다. 반면 360도의 시야각을 갖는 LiDAR 센서의 경우 PointPillars[16]와 같은 3D 객체 인식 모델을 활용하여 실시간 위치 추정이 가능하지만, 다양한 목표 물체에 대한 포인트 클라우드 데이터셋 확보를 필요로 한다. 최근 Grounding DINO[17]와 같은 zero-shot 객체 인식 모듈을 기반으로 한 auto labelling 기술의 발전으로 인하여, 카메라 기반 객체 인식 모듈의 학습 편의성이 크게 증가하였고, TensorRT와 같은 최적화 기술을 통해 고해상도 이미지에 대한 객체 인식 연산량을 크게 줄일 수 있게 되었다. 이러한 카메라 기반 객체 인식 모델의 장점과 LiDAR 센서 데이터의 깊이 정보를 활용한 카메라-LiDAR 센서 퓨전 기술을 이용하면 실시간으로 주변 물체의 3차원 위치추정이 가능하다[18]. 본 연구에서는 3개의 카메라와 LiDAR 센서 퓨전을 통해 넓은 화각에서의 주변 목표 물체에 대한 실시간 3차원 위치 추정을 구현하였다. 따라서 본 연구진의 주된 기여는 다음과 같다.

- · 신뢰성 있는 위치추정 및 경로계획 알고리즘과 계단을 고려한 제어 알고리즘이 적용된 궤도형 로봇의 자율주행 시스템을 구축하였다.

- · 카메라와 LiDAR 센서 퓨전을 통해 다층 환경에서 사람, 소화기, 계단, 폭발물 등 다양한 목표 물체의 3차원 위치를 실시간으로 추정하는 정찰 시스템을 구축하였다.

- · 자율주행 시스템과 객체 탐지를 위한 Perception 모듈을 통합하고 좁은 방문과 계단이 존재하는 여러 환경에서 전체 시나리오를 검증하였다.

2. 알고리즘

다층 실내 환경에서의 자율주행 및 정찰을 위해서는 좁은 복도, 계단, 넓은 홀 등 다양한 환경에서도 강인한 위치추정 알고리즘과 좁은 문 통과 시의 충돌 없는 경로계획 알고리즘, 임무 수행 가능성을 고려한 임무 계획 알고리즘, 안전하고 정확한 계단 극복을 위한 제어 알고리즘, 목표 물체의 정확한 위치 탐지를 위한 인식 알고리즘이 필요하다. 이를 위해 본 연구진은 Localization, Planning, Control, Perception 4개의 모듈로 구성된 자율주행 정찰 시스템을 구축하였다. 전체 시스템 아키텍처는 [Fig. 2]에 명시되어 있다.

2.1 시스템 아키텍처

전체 시스템 진행 순서는 다음과 같다. 먼저 Localization 모듈에서 로봇 근처 환경의 지도 작성과 로봇의 정확한 위치추정을 수행하고 추정된 로봇의 위치를 기반으로 Planning 모듈에서 로봇의 최적 경로를 결정하게 된다. 결정된 경로에 대해서는 Control 모듈의 Pure Pursuit 제어 알고리즘이 수행되며 로봇이 경로를 따라 자율 주행하게 된다. Perception 모듈에서는 YOLO v7[19] 모델을 이용해 폭발물이나 소화기 등 특정 물체를 감지하는 알고리즘이 동작하고, 감지된 특정 물체는 카메라-LiDAR 센서 퓨전을 통해 3차원 지도에 표시된다.

본 연구진이 제안하는 하드웨어 플랫폼 특징은 [Fig. 1]과 같다. 구동부는 Flipper를 포함하는 궤도형태로서 계단 등 험난한 지형을 극복할 수 있고, 자율주행에 필요한 센서와 장비를 롤케이지 중앙에 위치시켜 백 플립 등의 상황에서 메인 센서들을 보호하도록 설계하였다. 자율주행을 위한 메인 센서로는 계단과 같이 기하학적 특징이 부족한 환경에서 정확한 위치 추정을 위해 반구형 128채널 Ouster Dome LiDAR 센서를 사용했다. 그리고 Localization과 Planning 및 Control과 같이 자율주행에 필요한 알고리즘들은 Intel NUC에서 수행되었다. 사람, 폭발물 등 특정 물체 감지를 위해 사용한 카메라 센서는 Realsense d435i로 로봇의 전면과 측면에 배치하여 전략적으로 넓은 시야각을 확보하여 사각지대를 최소화했다. 객체 감지는 YOLO v7 모델을 사용하여 NVIDIA Jetson 온보드 컴퓨터에서 실시간으로 수행되었다. 구동 모터와 Flipper모터는 MCU (Micro Controller Unit)에서 각 모터의 엔코더 값을 기반으로 PID 제어를 통해 구동되었다. 또한 MCU는 원격 컨트롤러로부터 PPM(펄스 위치 변조) 신호를 수신하도록 구성되어 제안하는 궤도로봇을 수동으로도 제어가 가능하다. 초음파 센서는 계단을 극복할 때, 로봇과 지면사이의 거리를 측정하기 위해 로봇의 앞쪽에 부착되었고, 실시간으로 측정된 거리 값을 바탕으로 로봇이 계단 끝에 도달했는지 여부를 판단한다.

2.2 위치 추정

로봇의 자율주행 시스템에서는 강력하고 안정적인 로봇의 위치 추정이 매우 중요하다. 위치 추정을 통해 지도에서 로봇의 정확한 위치를 찾고, 정확한 위치를 기반으로 경로 계획, 객체 탐지 등의 후속 작업을 수행할 수 있기 때문에 정확한 위치 추정이 중요하다. 하지만 좁은 복도와 넓은 홀, 계단이 공존하는 건물에서는 위치 추정이 부정확해질 수 있다. 이러한 어려운 환경에서의 강인한 위치 추정을 위해서 적응형 키프레임 기반의 LIO (Lidar Intertial Odoemtry)알고리즘[13]을 활용했다. 이 알고리즘은 각 환경의 규모에 따라 하이퍼파라미터들을 적응적으로 조절이 가능하기에 위치 추정에 대해 높은 신뢰성과 견고성을 유지할 수 있다. [Fig. 3]은 실제 다층환경에서 적응형 키프레임 기반 LIO 알고리즘의 지도생성 결과이다.

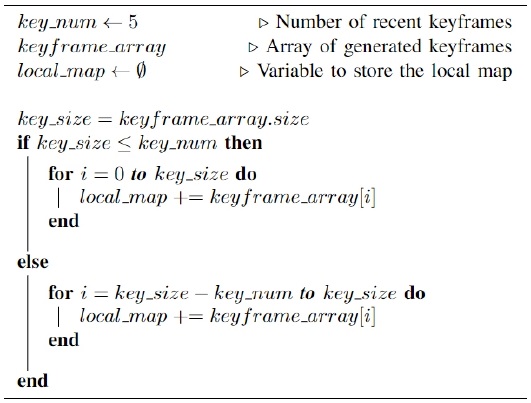

하지만 이 알고리즘은 정적 실내 환경을 위해 설계되어 보행중인 사람과 같은 동적 장애물이 존재할 경우 Local map에 불필요한 Point Cloud가 남게 되는 한계점이 존재한다. 이는 실제로 통과 가능한 경로가 생성되는 것을 막아 로봇의 경로 계획의 효율성을 감소시킬 수 있다. 이러한 상황을 방지하기 위해 본 연구진은 일정 수의 최근 키프레임들을 사용하여 Local map을 생성하도록 알고리즘을 개선하였고, 생성된 Local map을 기반으로 경로 계획을 수행하여 동적 장애물에 대해 일시적으로 막힌 공간에 대해서도 경로가 생성될 수 있도록 하였다.

실시간으로 취득되는 스캔 데이터만을 사용하여 경로를 찾을 수 있지만 그렇게 되면, 필요 이상으로 길거나 복잡한 경로가 생성될 수 있다. 반면, 최근에 획득한 일정 개수의 키프레임들로 만든 Local map을 사용하면, 보다 넓은 맵 정보를 사용하기 때문에 효율적인 경로계획이 가능해진다. 이에 해당되는 Pseudo 코드는 [Algorithm 1]과 같다. 로봇이 움직임에 따라 계속해서 생성되는 키프레임들은 keyframe_array배열에 저장된다. 배열에 저장된 키프레임들을 대상으로 원하는 키프레임 개수(key_num)만을 이용하여 local_map을 만든다.

2.3 경로 및 임무 계획

자율주행 로봇의 경로 계획에서는 목표 지점까지의 최단 경로를 찾는 것이 배터리 절약 및 소요시간 최소화의 측면에서 유리하다. 최단 경로를 탐색하는 주요 알고리즘 중 A* 알고리즘은 연산의 경량성 및 효율성을 중시하는 경우에 일반적으로 사용된다. 그러나 이 알고리즘을 사용하여 문과 같은 좁은 통로를 통과하는 경로를 생성할 때, 로봇이 문틀과 같은 장애물에 충돌하는 경우가 많이 발생한다. 이러한 문제를 피하기 위해 A* 알고리즘에서 장애물과의 거리를 일정 수준 이상으로 유지하도록 강제하면 좁은 통로를 통과하는 경로가 생성되지 않아 로봇이 물리적으로 통과할 수 있는 문을 자율적으로는 통과하지 못하는 경우가 발생할 수 있다.

이에 따라 본 연구진은 경로 계획을 위해 Modified A* 알고리즘을 활용하였다[14]. 본 알고리즘은 기존 A* 알고리즘의 핵심 원리를 유지하면서 식 (1)에 따라 각 노드에 대한 비용 계산을 진행하여 비용을 최소화하는 경로를 탐색한다. 여기서 JA*는 기존 A* 알고리즘의 비용이고 Jd는 노드에서 가장 가까운 장애물까지의 거리와 관련된 비용이며, ω1및 ω2는 각 비용의 가중치 매개변수이다.

| (1) |

기존 A*의 비용함수는 그대로 사용할 것이므로 ω1의 값은 고정시킨 상태에서 장애물과의 거리 비용 가중치 매개변수인 ω2를 변화시켰을 때, 생성되는 경로는 [Fig. 4]와 같다. [Fig. 4]의 (a)는 ω2값이 0일 때, 생성된 경로이다. ω2값이 0이므로 장애물과의 거리 비용함수 값을 사용하지 않는 상태로서 A* 알고리즘만 사용했을 때 생성되는 경로와 같게 된다. [Fig. 4]의 (b), (c), (d)는 ω2값을 점점 키웠을 때, 생성되는 경로로 ω2의 값을 크게 줄수록 생성되는 경로는 distance map과 점점 일치되는 것을 볼 수 있다. ω2값이 클수록 장애물들과 멀리 떨어진 경로가 생성되어 로봇의 충돌 안전성을 충분히 확보할 수 있지만 그만큼 비효율적인 경로가 생성된다. 그러므로 본 연구진은 경로의 효율성과 안전성을 적절히 고려하여 ω2의 값은 [Fig. 4]의 (c)값으로 결정하였다. 결정된 값을 사용하여 실제 좁은 환경에서 [Fig. 5]와 같이 주변 장애물로부터 안전한 경로가 생성되는 것을 확인할 수 있다.

![[Fig. 4] [Fig. 4]](/xml/40705/JKROS_2024_v19n2_149_f004.jpg)

Paths generated by varying the weight parameters in the path planning algorithm. (a) ω2 = 0, (b) Low value ω2, (c) Moderate value ω2, (d) High value ω2

본 알고리즘을 통해 로봇은 장애물과의 거리를 유지하면서 좁은 통로를 통과할 수 있는 경로를 계획할 수 있다. 특히 본 알고리즘은 문 통과에 좋은 성능을 발휘하는데, 이는 문틀의 한쪽 면에 너무 가깝게 경로를 생성하는 기존 A*와 달리 문의 중앙을 수직으로 통과하는 경로를 생성하여 로봇의 안정적인 통행이 가능하기 때문이다.

건물 내부를 정찰할 때 방 문이 닫혀 있는 상황이 발생할 수 있다. 이 경우 로봇의 경로계획 모듈은 방 안에 미리 정의된 목표지점에 도달하기 위해 여러 방향으로 경로 생성을 시도하지만 닫힌 문과 벽으로 인해 그 주변을 끝없이 배회하게 된다. 이 문제를 해결하기 위해 임무 계획 알고리즘에 현재 로봇의 위치와 목표지점 사이의 유클리드 거리를 활용하는 임무 취소 모듈을 추가했다.

본 모듈은 앞서 살펴본 Modified A* 알고리즘이 생성한 경로의 길이와, 로봇과 목표지점 사이의 유클리드 거리의 비율을 식 (2)에 따라 계산한다. 이 비율이 특정 임계 값을 초과함은 곧 목적지까지의 유클리드 거리는 짧으나 Modified A* 알고리즘이 주변의 장애물 등으로 인해 길고 우회적인 경로를 생성했음을 의미한다. 따라서 식 (3)에 의해 현재 목적지로 갈 수 있는 경로가 없다고 판단하고, 이에 따라 해당 방에 대한 임무를 취소하고 다음 임무로 넘어가도록 구성하였다.

| (2) |

| (3) |

2.4 모터 제어

Flipper는 궤도로봇의 ‘팔’ 역할을 수행하여 계단과 같이 높은 장애물들을 극복 가능하게 해준다. Flipper 모터 제어는 기본적으로 PID 기반 위치 제어로 수행된다. 계단을 통과하기 위해 계단에 도달하기 직전에 Flipper을 전개하여 계단 진입 시 로봇의 앞부분이 계단에 의해 자연스럽게 올라가게 된다. 마찬가지로, 로봇이 계단 끝에 도달하여 로봇의 앞쪽이 건물 바닥면과 부딪히기 직전에 Flipper를 먼저 낮춰 충격을 완화한다. 이는 로봇 앞부분의 손상을 방지할 뿐만이 아니라 위치추정의 강인함을 위해서도 중요하다. 이때 계단의 끝에 도달했다는 판단은 로봇 전면 상판에 부착된 초음파 센서를 통해 바닥과의 거리를 측정하여 수행한다. 이는 계단 종료지점에 로봇이 접근할 경우 초음파 센서는 계단 및 계단 이후의 지면 모두를 인식하지 못함을 활용한 것이다. 그 후, Flipper는 기존 위치로 복귀한다.

계단 극복 시 Flipper의 각도는 법정 계단의 단 높이[20,21]를 기준으로 계단의 단 높이를 최대 180 mm로 고려하여 결정하였다. 여기에 궤도 바퀴 및 Flipper 구조 또한 고려하여 계단 극복 시 Flipper 각도는 25도로 선정하였다. 계단 종료 여부를 판단하는 초음파 센서 측정값의 기준은 초음파 센서로부터 계단의 디딤면까지의 거리와 초음파 센서 자체의 지연시간 등을 고려하여 700 mm로 결정하였다.

계획된 경로의 추종을 위해 미리 정의된 Lookahead 거리를 사용하여 계획된 경로상에서 Waypoint를 선택한다. 로봇 기준으로 Waypoint의 상대 위치는 Differential Kinematics 기반의 Pure Pursuit 제어에 사용되며, 이는 식 (4)를 따른다[22]. 여기서 γ는 로봇이 이동할 경로의 곡률이고, ω는 로봇의 Yaw Rate이며, ν는 종방향 속도이다. xg와 yg는 각각 로봇 기준으로 앞쪽 방향과 왼쪽 방향 거리에 해당된다.

| (4) |

이 결과를 사용하여 모터를 제어하는 MCU는 식 (5)의 방정식을 사용하여 각 트랙의 기준 속도를 계산한다[23]. 여기서 B는 양쪽의 궤도 중심 사이의 거리이고 νl은 왼쪽 궤도의 속도, νr은 오른쪽 궤도의 속도이다. 이 결과는 PID 기반 속도 제어를 활용하는 궤도의 모터 제어에 사용되었으며, 각 궤도의 속도는 양쪽 구동모터의 인코더를 활용하여 추정하였다.

| (5) |

계단 상황에서 궤도형 로봇의 횡방향 동작은 평지에서의 동작과 많은 차이를 보인다. 이는 식 (6) 및 식 (7)과 같이 궤도형 로봇의 동적 모델을 공식화하여 설명할 수 있다[24]. 여기서 I2는 로봇 회전축에 대한 로봇의 관성 모멘트이고, TO는 로봇의 회전축을 중심으로 궤도가 로봇에 가하는 토크, m은 로봇의 질량, g는 중력 가속도, dCG는 로봇의 회전축에서 무게 중심까지의 거리, α는 계단의 기울기, θ는 계단 방향에 대한 로봇의 x축의 각도, Mr은 로봇의 회전 저항, μ는 마찰계수이다.

| (6) |

| (7) |

계단에서 로봇의 무게중심이 로봇 회전축보다 앞에 있을 경우 식 (6)의 mgdCGsin(α)sin(θ)항에 의해 로봇의 횡방향 동역학적 특성이 매우 불안정해질 수 있음을 알 수 있다. 또한 식 (7)에 의해 계단과 같은 빗면에서는 회전 저항 Mr이 감소함을 알 수 있다. 따라서 로봇이 계단에 있을 때 사용하는 궤도 모터의 제어는 평지 상황과는 별도로 구성되어야 한다. 이에 본 연구진은 계단에서는 궤도 모터의 PID 기반 제어기에 대해 다른 매개변수를 사용하였다.

[Fig. 6]은 평지와 같은 제어기 매개변수를 사용했을 때 계단 위에서의 heading 오차와 계단에서는 다른 매개변수를 사용하여 제어기를 개선했을 때 계단 위에서의 heading 오차를 나타낸 그래프이다. 위쪽 그래프 2개는 계단을 정상적으로 극복하는 상황, 아래쪽 그래프 2개는 인위적으로 외란을 왼쪽과 오른쪽으로 가했을 때 극복하는 상황이다. 보이는 바와 같이, 정상적인 계단 극복과 외란을 가하는 상황 모두에서 개선된 제어기가 안정적으로 계단을 극복함을 확인할 수 있다. 특히, 평지와 같은 제어기 매개변수를 활용한 경우, 외란에 의해 진동이 크게 발생하였으나, 개선된 제어기는 그러한 상황이 발생하지 않은 것 또한 확인할 수 있다.

2.5 3차원 객체인식 및 위치 추정

다층 건물 내부 환경에서 목표 물체의 위치를 정확하게 추정하고 탐지 지도를 구축하기 위한 인식 모듈의 구성은 [Fig. 7]과 같다.

복잡한 실내환경에서 신속한 목표물 탐지를 위해 로봇의 전방 및 양 측방에 탑재된 3개의 카메라와 중앙에 탑재된 1개의 LiDAR 센서를 활용하였다.

로봇 주변의 세 방향에 있는 목표 물체의 존재 여부를 실시간으로 판단하기 위해 먼저 세 개의 카메라에서 추출한 이미지를 하나의 이미지로 병합한다. 이미지 평면의 x축을 따라 1280 × 720 해상도의 각 이미지를 연결하여 3840 × 720 해상도의 합성 이미지를 생성한다.

합성된 단일 이미지에 경량화된 객체 인식 모델을 적용하여 [Fig. 8]과 같이 이미지 프레임 내의 목표 물체에 대한 Bounding Box 정보를 실시간으로 추출하였다. 2D 객체 인식 모델은 로봇에 내장된 Jetson Orin 컴퓨터에 대해서 목표물 최대 탐지거리, 연산량, 실시간성을 고려하여 YOLO v7으로 선택하였다. 또한 TensorRT 최적화를 적용하여 합성 이미지와 같은 고해상도 이미지에 대한 인식 정확도를 유지하면서 연산량을 줄였다.

![[Fig. 8] [Fig. 8]](/xml/40705/JKROS_2024_v19n2_149_f008.jpg)

The process of 2D object detection and the projection of LiDAR points onto the camera image. (a) The concatenation result of three images (left, front, right). (b) 2D bounding box detection results for the target object: explosive (left), person (front), fire extinguisher (right). (c) Projection of LiDAR points onto the camera image within three different FOVs

합성 이미지에서 추출된 2D 바운딩 박스는 목표 물체의 3차원 위치를 곧바로 추정하기 어렵다. 이를 해결하기 위해 바운딩 박스 내의 물체에 해당되는 LiDAR 포인트의 깊이 정보를 활용하였다.

먼저 추출된 raw LiDAR 포인트 클라우드를 로봇의 몸체 내부 영역 및 장거리 영역의 불필요한 데이터를 제거하는 전처리 과정을 거친다. 처리된 포인트 클라우드를 [Fig. 9]와 같이 각 3개의 카메라의 Field of View (FoV)에 해당하는 세 영역으로 분할하여 카메라-LiDAR 매칭을 진행한다. 매칭된 포인트 클라우드는 카메라의 Intrinsic Parameter와 카메라-LiDAR간의 Extrinsic Parameter를 이용하여 각 카메라 프레임 내부의 이미지 픽셀 포인트로 변환된다. 각 카메라의 Intrinsic Parameter와 Extrinsic Parameter는 카메라-LiDAR 캘리브레이션을 통해 계산하였다.

![[Fig. 9] [Fig. 9]](/xml/40705/JKROS_2024_v19n2_149_f009.jpg)

The process of 3D object localization using depth information from LiDAR points. (a) Captured raw LiDAR points by the OSDome sensor. (b) Segmentation of point clouds into 3 regions based on the camera’s FOV. (c) Points projected onto the camera image. (d) Estimation of depth information for target objects (indicated by blue markers)

이미지 프레임에 LiDAR 포인트가 매칭되면 목표 객체 별 관심 영역(Region Of Interest; ROI)을 추출하여 클러스터링을 진행한다. 각 클러스터 내의 포인트 중 로봇과의 거리가 최소인 포인트를 선택하여 해당 포인트의 위치를 최종 목표 객체의 3차원 위치로 설정한다. 목표 객체의 3차원 깊이 추정 과정은 [Fig. 9]에서 확인할 수 있다.

3. 실험결과

본 논문에서 제안한 자율주행 정찰 시스템의 신뢰성을 검증하기 위해 한국과학기술원(KAIST) N1 건물 환경에서 다층 간 자율주행 및 정찰 시나리오를 구성하여 테스트를 진행하였다. 본 건물 1층 복도에서 출발하여 방 2개를 정찰한 뒤 계단을 통해 2층으로 이동하여 좁은 복도 및 넓은 홀을 지나 도착지점까지 주행하는 시나리오이다. 자율주행 중 탐지해야 할 목표 물체는 인물 동상 2개, 폭발물 3개, 소화기 11개, 계단 5개이며, 인식 모듈을 통해 추정된 목표 물체의 위치는 3차원 지도에 마커로 각기 다른 색상으로 표기하였다(인물 동상: 빨간색, 폭발물: 파란색, 소화기: 초록색, 계단: 노란색).

전체 시나리오를 7분 4초에 완주하였고, 1층과 2층을 포함한 다층 맵이 왜곡 없이 성공적으로 생성되었 다. 실험결과는 [Fig. 10]에 나와있다. 지도에서 로봇의 이동 경로는 하늘색 점들로 표시되었는데, 이 점들은 로봇이 이동하며 만든 키프레임에 대한 odometry 정보이다. 환경이 좁은 곳에서는 이 점들이 조밀하게, 넓은 곳에서는 드물게 생성되었음을 확인할 수 있는데, 이는 주변 환경 크기에 맞게 Localization 모듈의 스캔 매칭을 위한 하이퍼파라미터들이 적절히 설정되어 Localization 모듈이 효과적으로 동작했음을 나타낸다. 결과적으로, 다양한 환경으로 구성된 실내에서 정확하고 강인한 지도작성과 위치추정이 성공적으로 이루어졌음을 시사한다.

![[Fig. 10] [Fig. 10]](/xml/40705/JKROS_2024_v19n2_149_f010.jpg)

Results of a full scenario. White points indicate the global map, and sky blue points indicate the robot’s odometry. As shown in the bird’s eye view, the tracked robot arrived at the destination after navigating through various indoor environments

로봇의 이동경로를 나타내는 하늘색 점들은 [Fig. 11]에서 볼 수 있듯이 좁은 방과 문 틈사이를 주변환경에 대해 안전이 확보된 가운데의 길로 간 것임을 확인할 수 있었다. 이는 A* 경로 계획 알고리즘에 주변 환경과의 거리 비용이 반영되었기에 로봇이 안전한 경로로 선택할 수 있었음을 보여준다. 또한, 생성된 경로를 로봇이 정밀하게 추종할 수 있도록 제어가 적절하게 이루어진 것을 확인할 수 있다.

![[Fig. 11] [Fig. 11]](/xml/40705/JKROS_2024_v19n2_149_f011.jpg)

(a) Results for the first floor in the full scenario. (b) Results for the second floor in the full scenario. Pink triangles indicate the robot’s position when objects are detected. Each marker represents a detected object: blue markers for explosives, green markers for fire extinguishers, yellow markers for staircases, and red markers for human statues

총 21개의 목표 물체 중 19개 물체의 위치 추정에 성공하였고, 실패한 목표물의 경우 가까이 있는 두 개의 인물 동상이 하나의 객체로 인식되거나 소화기와 같은 색의 배경의 위치가 추정되는 경우였다. 나머지의 경우 물체의 3차원 위치 추정이 LiDAR의 스캔 속도와 같은 10 hz로 실시간으로 수행됨을 확인할 수 있었고, 이는 로봇의 세 방향에 위치한 물체를 고려한 고해상도 병합 이미지 기반 객체 인식과 LiDAR 데이터의 퓨전이 적절히 이루어져 넓은 시야각 내 목표 물체의 실시간 위치추정이 가능했음을 보여준다. 본 자율주행 정찰 시스템의 목표 물체 위치 추정에 대한 성능 평가 지표인 Confusion Matrix는 [Fig. 12]와 같고, 식 (8)에 따른 F1 Score는 [Table 1]에 나타난다. Precision은 로봇이 추정한 목표물의 위치 중 실제로 정확히 추정된 비율이고, Recall은 실제 목표물의 위치 중 로봇이 정확히 추정한 경우이다.

| (8) |

본 자율주행 시스템으로 ‘국방부 장관배 드론봇 챌린지’ 대회의 ‘건물내부정찰로봇’부문에 참가하여 제안하는 시스템과 알고리즘의 우수성을 입증할 수 있었다. 해당 대회는 지하 1층과 지상 1층을 포함한 다층 환경에서 자율 및 수동 주행 시나리오를 평가하였으며, 본 시나리오는 지하시설 및 계단 극복과 1층의 세 개 방을 순회한 후 건물 밖으로 복귀하는 과제로 구성되었다. 본 팀은 참가한 팀 중 유일하게 완전 자율주행으로 참가하여 약 12분 15초 만에 성공적으로 완주하였고, 이를 통해 알고리즘의 우수성을 입증하며 ‘기술혁신상’을 수상하였다. 한국과학기술원(KAIST)에서 실시한 실험 영상과 드론봇 챌린지 대회의 영상은 링크[25,26]를 통해 확인할 수 있다.

4. 결 론

본 논문에서는 계단이 포함된 다층환경에서 자율주행 및 정찰이 가능한 궤도로봇의 전반적인 시스템을 소개하였다. 환경의 크기에 맞게 스캔 매칭 파라미터를 결정하는 Localization 알고리즘으로 좁은 방과 계단과 같이 특징점이 적은 어려운 환경에서도 강인하게 위치추정 및 지도작성이 가능하였고, 주변환경과의 거리 비용을 고려한 Path planning 알고리즘과 궤도로봇의 Differential Kinematics에 맞게 설계된 모터의 PID 제어기로 좁은 통로나 문틈과 같은 환경에서도 안전하게 주행이 가능하였다. 또한, 계단과 같이 특수한 주행환경에서 궤도로봇의 횡방향 동역학적 특성을 고려한 차별화된 PID 제어와 초음파센서의 활용으로 신뢰성 있고 안전하게 다층환경에서 궤도로봇의 운용이 가능했다. Perception 모듈의 경우 다중 이미지 병합 및 카메라-LiDAR 퓨전을 통해 로봇의 전면 뿐 아니라 측면에 존재하는 목표 물체의 3차원 위치를 실시간으로 추정하고 이를 3차원 지도에 융합할 수 있었다. 마지막으로 Perception 모듈을 자율주행 시스템과 통합한 뒤, 실제 다층 환경에서 정찰 시나리오를 수행함으로써 제안된 시스템이 강인하고 신뢰성 있게 동작함을 검증하였다. 이러한 신뢰성을 바탕으로 본 연구진의 자율주행 정찰 시스템이 실제 재난 상황 및 사람이 접근하기 어려운 환경에 활용되어 실질적인 기여를 할 수 있을 것으로 기대한다.

Acknowledgments

This project was financially supported by the Institute of Civil Military Technology Cooperation funded by the Defense Acquisition Program Administration and Ministry of Trade, Industry and Energy of Korean government under grant No.UM22206RD2.

References

- C. Kang, “Intelligent mobile robot technology and application,” vol. 70, no. 2, pp. 9-13, Feb., 2021, [Online], https://www.dbpia.co.kr/journal/articleDetail?nodeId=NODE10525417, .

-

Y. Sun, L. Guan, Z. Chang, C. Li, and Y. Gao, “Design of a low-cost indoor navigation system for food delivery robot based on multi-sensor information fusion,” Sensors, vol. 19, no. 22, Nov., 2019.

[https://doi.org/10.3390/s19224980]

-

T. Kim, G. Kang, D. Lee, and D. H. Shim, “Development of an Indoor Delivery Mobile Robot for a Multi-Floor Environment,” IEEE Access, vol. 12, pp. 45202-45215, 2024.

[https://doi.org/10.1109/ACCESS.2024.3381489]

-

K. Thamrongaphichartkul, N. Worrasittichai, T. Prayongrak, and S. Vongbunyong, “A Framework of IoT Platform for Autonomous Mobile Robot in Hospital Logistics Applications,” 2020 15th International Joint Symposium on Artificial Intelligence and Natural Language Processing (iSAI-NLP), Bangkok, Thailand, pp. 1-6, 2020.

[https://doi.org/10.1109/iSAI-NLP51646.2020.9376823]

-

G. Fragapane, R. de Koster, F. Sgarbossa, and J. O. Strandhagen, “Planning and control of autonomous mobile robots for intralogistics: Literature review and research agenda,” European Journal of Operational Research, vol. 294, no. 2, pp. 405-426, 2021.

[https://doi.org/10.1016/j.ejor.2021.01.019]

-

S. Narayan, M. Aquif, A. R. Kalim, D. Chagarlamudi, and M. H. Vignesh, “Search and Reconnaissance Robot for Disaster Management,” Machines, Mechanism and Robotics, Springer, Singapore, 2021, pp. 187-201.

[https://doi.org/10.1007/978-981-16-0550-5_17]

-

S. Li, C. Feng, Y. Niu, L. Shi, Z. Wu, and H. Song, “A fire reconnaissance robot based on SLAM position, thermal imaging technologies, and AR display,” Sensors, vol. 19, no. 22, Nov., 2019.

[https://doi.org/10.3390/s19225036]

-

H. Miura, A. Watanabe, M. Okugawa, T. Miura, and T. Koganeya, “Plant inspection by using a ground vehicle and an aerial robot: lessons learned from plant disaster prevention challenge in world robot summit 2018,” Advanced Robotics, vol. 34, no. 2, pp. 104-118, 2020.

[https://doi.org/10.1080/01691864.2019.1690575]

-

Y. Kobayashi, S. Kanai, C. Kikumoto, and K. Sakoda, “Design and fabricate of reconnaissance robots for nuclear power plants that underwent accidents,” Journal of Robotics and Mechatronics, vol. 34, no. 3, pp. 523-526, Jun., 2022.

[https://doi.org/10.20965/jrm.2022.p0523]

-

D. Lee, G. Kang, T. Kim, D. H. Shim, H. Jung, and E. Kim, “Route Planning and Elevator Boarding Algorithms for Last Mile Delivery Service in Multi-floor Environments,” The Journal of Korea Robotics Society, vol. 18, no.1, pp. 10-17, Feb., 2023.

[https://doi.org/10.7746/jkros.2023.18.1.010]

-

Z. Zhao, J. Zhao, and Y. Lou, “Autonomous operation of elevator buttons for multi-floor navigation,” Proceedings of 2020 Chinese Intelligent Systems Conference: Volume II, Springer Singapore, 2021, pp. 161-170.

[https://doi.org/10.1007/978-981-15-8458-9_18]

-

S. Shin, J. Lee, J. Noh, and S. Choi, “Robust Detection for Autonomous Elevator Boarding Using a Mobile Manipulator,” Asian Conference on Pattern Recognition, Kitakyushu, Japan, pp. 15-28, 2023.

[https://doi.org/10.1007/978-3-031-47634-1_2]

-

B. Kim, C. Jung, D. H. Shim, and A. Agha–mohammadi, “Adaptive Keyframe Generation based LiDAR Inertial Odometry for Complex Underground Environments,” 2023 IEEE International Conference on Robotics and Automation (ICRA), London, United Kingdom, pp. 3332-3338, 2023.

[https://doi.org/10.1109/ICRA48891.2023.10161207]

-

B. Kim, S. Lee, J. Park, and D. H. Shim, “3D Costmap Generation and Path Planning for Reliable Autonomous Flight in Complex Indoor Environments,” The Journal of Korea Robotics Society, vol. 18, no. 3, pp. 337-345, Aug., 2023.

[https://doi.org/10.7746/jkros.2023.18.3.337]

-

J. Redmon, S. Divvala, R. Girshick, and A. Farhadi, “You only look once: Unified, real-time object detection,” arXiv:1506.02640, 2016.

[https://doi.org/10.48550/arXiv.1506.02640]

-

A. H. Lang, S. Vora, H. Caesar, L. Zhou, J. Yang, and O. Beijbom, “Pointpillars: Fast encoders for object detection from point clouds,” arXiv:1812.05784, 2018.

[https://doi.org/10.48550/arXiv.1812.05784]

-

S. Liu, Z. Zeng, T. Ren, F. Li, H. Zhang, J. Yang, C. Li, J. Yang, H. Su, J. Zhu, and L. Zhang, “Grounding dino: Marrying dino with grounded pre-training for open-set object detection,” arXiv:2303.05499, 2023.

[https://doi.org/10.48550/arXiv.2303.05499]

-

I. de L. Páez-Ubieta, E. Velasco-Sánchez, S. T. Puente, and F. A. Candelas, “Detection and depth estimation for domestic waste in outdoor environments by sensors fusion,” IFAC-PapersOnLine, vol. 56, no. 2, pp. 9276-9281, 2023.

[https://doi.org/10.1016/j.ifacol.2023.10.211]

-

C.-Y. Wang, A. Bochkovskiy, and H.-Y. M. Liao, “Yolov7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors,” arXiv:2207.02696, 2022.

[https://doi.org/10.48550/arXiv.2207.02696]

- South Korea, Ministry of Land, Infrastructure and Transport, “Regulations on Housing Construction Standards”, Article 16(Stairs), Paragraph 1, 2024.

- South Korea, Ministry of health and welfare, “Enforcement Rule of the Act on Guarantee of Promotion of Convenience of Persons with Disabilities, the Elderly, and Pregnant Women”, Annex 1, 2023.

-

J. Morales, J. L. Martínez, M. A. Martínez, and A. Mandow, “Pure-pursuit reactive path tracking for nonholonomic mobile robots with a 2D laser scanner,” EURASIP Journal on Advances in Signal Processing, May, 2009.

[https://doi.org/10.1155/2009/935237]

-

Z. Y. Chen, G. Z. Chen, L. Z. Qi, F. Yin, D. D. Li, and M. J. Shi, “Steering dynamic performance analysis of the tracked mobile robot,” IOP Conference Series: Materials Science and Engineering, vol. 392, no. 6, 2018.

[https://doi.org/10.1088/1757-899X/392/6/062038]

-

A. I. Mourikis, N. Trawny, S. I. Roumeliotis, D. M. Helmick, and L. Matthies, “Autonomous stair climbing for tracked vehicles,” The International Journal of Robotics Research, vol. 26, no. 7, pp. 737-758, Jul., 2007.

[https://doi.org/10.1177/0278364907080423]

- Reliable Autonomous Reconnaissance System for a Tracked Robot, [Online], https://youtu.be/PvutVRnyGuY?si=TOpW0Y_56Cmj3P-G, , Accessed: May 23, 2024.

- Tracked Robot’s Autonomous Exploration and Object Detection in Complex Multi-Floor Environments, [Online], https://youtu.be/ua-bf6es4ac?si=J2Jqw-md5zouD9Vl, , Accessed: May 23, 2024.

2022 광운대학교 로봇학부 정보제어전공(학사)

2023~현재 KAIST 로봇공학학제전공 석사과정

관심분야: 로보틱스, 항법, UGV, 자율탐사, 경로계획

2017 인하대학교 전자공학(학사)

2019 KAIST CCS 모빌리티 대학원(석사)

2024 KAIST 전기 및 전자공학부(박사)

관심분야: 로보틱스, 항법, UAV, 자율탐사, 경로 계획

2023 한양대학교 전기공학전공(학사)

2023~현재 KAIST 미래자동차학제전공 석사과정

관심분야: 로보틱스, 자율주행차, 제어, 경로 계획

2023 한양대학교 전기·생체공학부(학사)

2023~현재 KAIST 전기 및 전자공학부 석사과정

관심분야: 로보틱스, 자율주행차, 컴퓨터 비전, 센서 퓨전

1991 서울대학교 기계공학(학사)

1993 서울대학교 기계공학(석사)

2000 University of California, Berkeley Mechanical Engineering(박사)

관심분야: 로보틱스, 드론, 자율로봇, 자율주행차

![[Fig. 2] [Fig. 2]](/xml/40705/JKROS_2024_v19n2_149_f002.jpg)

![[Fig. 3] [Fig. 3]](/xml/40705/JKROS_2024_v19n2_149_f003.jpg)

![[Algorithm 1]](../img/npr_tablethum.jpg)

![[Fig. 5] [Fig. 5]](/xml/40705/JKROS_2024_v19n2_149_f005.jpg)

![[Fig. 6] [Fig. 6]](/xml/40705/JKROS_2024_v19n2_149_f006.jpg)

![[Fig. 7] [Fig. 7]](/xml/40705/JKROS_2024_v19n2_149_f007.jpg)

![[Fig. 12] [Fig. 12]](/xml/40705/JKROS_2024_v19n2_149_f012.jpg)