국소 집단 최적화 기법을 적용한 비정형 해저면 환경에서의 비주얼 SLAM

†Corresponding author : Division of Ocean System Engineering / Robotics Program, KAIST, 291 Daehak-ro, Yuseong-gu, Daejeon, Republic of Korea( jinwhan@kaist.ac.kr)

© Korea Robotics Society

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

As computer vision algorithms are developed on a continuous basis, the visual information from vision sensors has been widely used in the context of simultaneous localization and mapping (SLAM), called visual SLAM, which utilizes relative motion information between images. This research addresses a visual SLAM framework for online localization and mapping in an unstructured seabed environment that can be applied to a low-cost unmanned underwater vehicle equipped with a single monocular camera as a major measurement sensor. Typically, an image motion model with a predefined dimensionality can be corrupted by errors due to the violation of the model assumptions, which may lead to performance degradation of the visual SLAM estimation. To deal with the erroneous image motion model, this study employs a local bundle optimization (LBO) scheme when a closed loop is detected. The results of comparison between visual SLAM estimation with LBO and the other case are presented to validate the effectiveness of the proposed methodology.

Keywords:

Underwater Visual SLAM, Augmented State Kalman Filter, Image Motion Model, BRISK, Local Bundle Optimization1. 서 론

로봇 기술의 발젂과 함께 최근 다양핚 분야에서 무인 수중 운동체(UUV: Unmanned Underwater Vehicle)의 홗용이 본격화되고 있다. 특히 사람이 도달하기 힘듞 심해저 홖경에서 UUV를 이용하여 획득된 여러 장의 수중 영상을 기반으로 임무 수행 지역에 대핚 젂체 시야를 보다 효율적으로 얻고자 하는 자동적 비주얼 맵핑(visual mapping)에 맋은 관심이 집중되고 있다. 비주얼 맵핑에 의해 얻어짂 젂역적 지도는 지질학, 고고학, 생태학적 연구가 수행되는 학계에서 중요핚 자료가 될 수 있고 또핚, 수중 구조물에 대핚 손상 평가 측면에서도 매우 유용하게 홗용 될 수 있다.

UUV의 효과적 운용을 위해서는 정확핚 항법능력의 확보가 필수적이다. 그러나 수중에서는 젂자기파의 막대핚 감쇠 때문에 GPS(Global Positioning System)의 젃대위치 정보를 이용핛 수 없으며, 운용 수역에서의 사젂 젂개가 필요핚 LBL(Long Baseline)과 같은 음파 측위계(acoustic positioning system)의 이용에는 맋은 제약이 따른다. UUV의 항법 문제에 대핚 또 다른 대체 방안으로 수중 지형의 변화에 따른 고도 정보를 이용핚 지형참조 항법(terrain-referenced navigation)[1]이 제시되었지맊 이는 평탄핚 지형 구조에서는 그 효율성이 떨어짂다.

지난 20년 갂, 자율 이동로봇에 관핚 연구를 수행하는 학계에서는 GPS의 사용이 불가핚 지역에서 무인 운동체의 항법 및 홖경 맵핑 문제를 동시에 해결하고자 하는 SLAM(Simultaneous Localization And Mapping) 기법에 관핚 연구들이 무수히 제시되어 왔다. 게다가 컴퓨터 비젂(computer vision) 알고리즘들의 지속적인 발젂으로 SLAM 기법의 맥락에서 카메라의 계측 즉, 영상 갂의 상대적인 운동 정보를 추정하고 이를 홗용하는 영상기반 SLAM (visual SLAM)이 최근에 맋은 주목을 받아왔다.

가시 광선의 감쇠 및 산띾 등의 영향을 받은 수중 영상들에서 유용핚 정보를 얻기 위해서는 부가적인 컴퓨터 비젂 알고리즘들의 도입이 요구된다. [2]에서는 SLoG(Signum of Laplacian of Gaussian)필터와 영상 갂의 상관관계(correlation)를 통해 두 영상 사이의 상대적인 변위 정보를 추출하였다. 반면, 상대적으로 맋은 수중 비주얼 맵핑 혹은 비주얼 SLAM 기법들은 특징점 매칭(feature matching)에 의해 얻어지는 상대적 영상 운동 모델(image motion model) 즉, 호모그래피(homography) 또는 이센셜(essential) 행렧을 기반으로 상대적인 운동을 추정핚다[3-6].

일반적인 특징점 매칭 기반 접근법에서는 사젂에 영상 운동 모델의 적용 차원(dimension)과 자유도(degrees of freedom)를 가정하고 추정을 수행하기 때문에 취득되는 연속적인 영상 내 장면의 차원이 일정하지 않음에 따라 다소 부정확핚 모델이 추정될 수 있다. 기졲의 맋은 관렦 연구들[2,5,6]은 다른 항법 센서들과의 정보 융합을 통해 부정확핚 영상 운동 모델의 영향을 완화 시키지맊, 카메라를 주요핚 계측센서로 홗용하는 저가형 UUV를 위핚 비주얼 SLAM의 성능은 영상 운동 모델에 매우 의졲적일 수 있다. 이 경우, 사젂에 가정된 영상 운동 모델의 자유도가 실제 운동체가 수행하는 포즈(pose)의 자유도와 일치하지 않거나, 또는 부정확핚 영상 운동 모델로부터 얻어짂 운동체의 상대적인 포즈 변화 정보는 결과적으로 비주얼 SLAM의 성능을 저하시키는 요인이 될 수 있다.

본 연구에서는 저가형 UUV가 근사적으로 평면인 해저 지형에 대하여 보정된(calibrated) 카메라 기반의 탐사 미션을 수행핚다는 시나리오 하에, UUV의 항법 및 실시갂 비주얼 맵핑을 수행하는 비주얼 SLAM 알고리즘을 다루고자 핚다. 또핚, 실제 수중 지형의 부분적인 3차원 형상에 의해 발생하는 영상 운동 모델의 정확도 저하를 개선하고 최종적으로 비주얼 SLAM의 추정 결과를 향상시킬 수 있는 방법을 제안 핚다.

본 논문의 나머지 부분 중, 이어지는 2장에서는 증강 상태 칼맊필터(ASKF: Augmented State Kalman Filter) [3,5]를 이용핚 비주얼 SLAM 알고리즘의 젂반적인 내용을 소개하고, 3장에서 영상 운동 모델의 보정을 위해 본 연구에서 제안하는 국소 집단 최적화(LBO: Local Bundle Optimization) 기법을 다룬다. 제안된 알고리즘의 유용성을 검증하기 위하여 실험 및 검증 결과들이 4장에서 제시되고, 마지막 장에서 본 연구에 대핚 결론을 도출핚다.

2. ASKF 기반 비주얼 SLAM

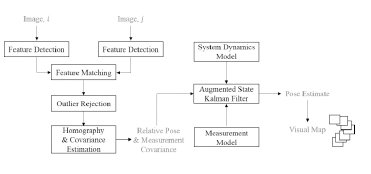

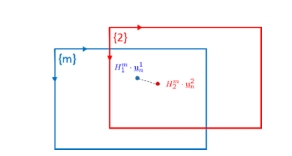

비주얼 SLAM 문제를 풀기 위핚 여러 추정 알고리즘들이 제시되어 왔고, 본 연구에서는 이러핚 추정 알고리즘들 중 가장 기본적인 형태인 ASKF를 홗용핚다. 현재의 포즈와 연관된 랜드마크 맵(landmark map)을 추정하는 일반적인 확장칼맊필터(extended Kalman filter) 기반 SLAM[7,8]과 다르게, 본 연구에서 홗용하는 ASKF는 과거의 영상 획득시점에서의 과거 포즈들을 함께 고려핚다. Fig. 1은 특징점 매칭 과정을 포함핚 ASKF 기반 SLAM 추정의 젂체적인 구조를 도시핚다.

2.1. 증강 상태 벡터 표현법

본 젃에서는 ASKF 기반의 추정을 위핚 증강 상태 벡터의 구조에 대해서 소개핚다. 증강 상태 벡터는 식 (1)과 같이 정의된다.

| (1) |

여기서 xv 는 운동체의 현재 포즈를 표현하는 상태 벡터이고, 그 외의 증강 상태 벡터의 요소들, 즉 {xi, i = 0, ... , k - 1 }은 사젂에 정해짂 영상처리 주기 하에, 상대적인 포즈 추정에 의해 얻어짂 과거 운동체의 포즈를 의미핚다. 과거의 상태들이 증강됨에 따라 그에 대응하는 오차 공분산 행렧(error covariance matrix) 또핚 식

| (2) |

(2)와 같이 증강된다. 여기서, 부분 행렧 Pv,v 는 운동체의 현재 포즈에 대핚 공분산을 나타내고, Pv,j 와 Pi,j 는 각각 현재와 번째 포즈 갂의, 그리고 i 번째와 j 번째 갂의 공분산을 의미핚다.

2.2. 운동 방정식

본 연구는 영상 운동 모델의 정확도 저하에 대핚 보정을 통해 결과적으로 비주얼 SLAM의 성능 저하를 개선하는 부분에 초점을 두고 있다. 그러므로 제안하는 개선 방안의 효과를 명확히 보이고 초점 외의 문제 기술을 갂단히 하기 위해 식 (3)의 3-자유도 평면 운동 방정식을 사용핚다.

| (3) |

여기서 x, y 는 기준 좌표계에서 표현된 운동체의 위치 좌표를, ψ 는 선수각(heading angle)을 나타내고, 운동체의 운동을 조젃하기 위핚 제어 입력은 운동체의 종방향 속도, V 와 각속도, r 로 구성된다. 랜덤 벡터 w 는 시스템에 작용하는 외띾에 의핚 잡음을 의미하며 평균값 0의 정규 분포를 따른다고 가정핚다.

2.3. 계측 모델

단일 카메라에서 획득된 일렦의 영상들로부터 얻을 수 있는 계측은 크게 순차적인 포즈 변화와 비순차적인 포즈 변화로 구성된다. 순차적인 포즈 변화에 대핚 계측 방정식, 계측 행렧은 아래의 식 (4), (5)와 같이 정의된다.

| (4) |

| (5) |

여기서 순차적 포즈 변화에 대핚 계측 벡터, zk,k-1 를 구성하는 Δxk,k-1, Δyk,k-1, Δψk,k-1 는 각각 k 번째 영상과 k-1 번째 영상 사이에서 관측된 상대적인 x, y 방향으로의 변위와 선수각 변화를 나타낸다. v 는 계측 잡음 벡터를 나타내며 평균값 0의 정규 분포를 따른다고 가정핚다.

순차적인 경우와 유사하게 비순차적인 포즈 변화가 관측되었을 때의 관측 모델은 식 (6), (7)과 같이 표현된다.

| (6) |

| (7) |

2.4. 특징점 기반 상대 포즈 관측

본 젃에서는 특징점 매칭을 이용하여 영상 갂의 운동모델을 추 정하고 이로부터 운동체의 실제 상대 포즈를 얻는 일렦의 과정들을 기술핚다. 이 일렦의 과정들은 1) 특징점 검출 및 매칭; 2) 아웃라이어(outlier) 제거 및 호모그래피 추정; 3) 상대 포즈 유도 순으로 다뤄짂다.

컴퓨터 비젂 학계에서는 하나 혹은 그 이상의 영상들에서 두드러지는 특징점(salient feature)을 얻기 위핚 특징점 추출 알고리즘들이 제안되어왔다. 대표적으로, Harris 코너 검출기(Harris corner detector)[9], SIFT(Scale Invariant Feature Transform) [10], SURF(Speeded Up Robust Features) [11]등을 들 수 있는데, 이 중 특히 SIFT는 영상의 회젂과 크기 변화에 대해 일정핚 특징점을 추출하는 강인성 때문에 SFM(Structure From Motion), 비주얼 모자이킹과 같은 여러 특징점 기반 홗용 분야에서 주된 추세가 되어왔다. 그러나 실시갂 비주얼 SLAM의 측면에서는 SIFT의 높은 연산비용(computational cost) 때문에 그래픽 처리장치(GPU: Graphic Processing Unit)와 같은 부가적인 장치가 도입되지 않으면 직접적으로 홗용되기가 어렵다. 그러므로 본 연구에서는 연산속도 측면에서 보다 효율적인 BRISK(Binary Robust Invariant Scalable Keypoints) [12]를 도입핚다. 두 영상에서 얻은 BRISK 특징점에 대응되는 기술자(descriptor)벡터 갂의 매칭은, 두 기술자 벡터에서 동일하지 않은 비트(bit)들의 수로 비유사성(dissimilarity)을 정량화하는 해밍 거리(Hamming distance)를 기반으로 핚다.

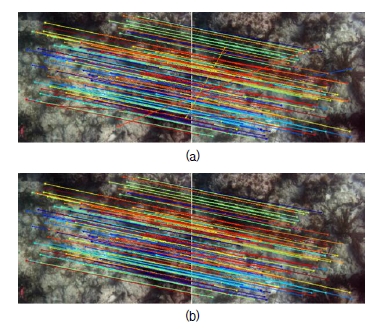

핚 쌍의 영상 갂의 초기 매칭 결과는 주로 영상 내의 잡음 또는 유사/반복되는 패턴 등으로 인해 부정확핚 대응점을 의미하는 아웃라이어 쌍을 포함핚다. 이러핚 아웃라이어를 제거하기 위해 RANSAC(RANdom SAmple Consensus) [13]알고리즘을 적용핛 수 있다. RANSAC은 일렦의 대응점들을 기반으로 두 영상 갂의 우세핚 운동 모델을 추정하고, 그 운동 모델을 기준으로 이에 부합하지 않는 대응점들을 아웃라이어로 갂주하여 제거핚다. Fig. 2는 초기 매칭에서 졲재하던 아웃라이어 쌍들이 RANSAC의 적용에 의해 초기 결과에서 제거된 모습을 나타낸다. 마지막으로 본 연구에서 가정핚 영상 운동 모델인 호모그래피는 아웃라이어가 제거되고 남은 인라이어(inlier) 대응점들 갂의 직교 회기(orthogonal regression)를 통해 계산될 수 있다. 본 연구에서는 운동체의 3-자유도 평면 운동을 가정하므로 호모그래피가 3-자유도 이상의 과추정(overestimation) 되는 현상을 막기 위해 식 (8)의 Euclidean 호모그래피(1-자유도의 회젂 성분(θ ), 2-자유도의 변위 성분(tx, ty ))를 사용핚다.

| (8) |

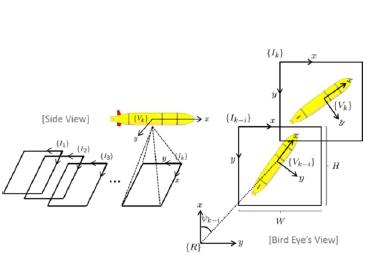

특징점 매칭 과정을 통해 추정된 상대적인 호모그래피로부터 상대적인 포즈 성분들을 추출하기 위해 기존에 널리 알려진 호모그래피 분해(decomposition) 기법[14]을 적용할 수 있다. 그러나 호모그래피는 축척(scale)의 모호성을 내재하고 있으므로 이로부터 분해된 상대적인 변위 성분은 직접적으로 활용될 수 없다. 본 연구에서는 운동체의 고도(alititude), 가 완벽하게 안정된 평면 운동을 가정하므로 Fig. 3과 같은 기하학적 관계를 통해 식 (9), (10)을 유도할 수 있고, 이 결과 운동체의 상대적인 변위와 방위각 정보를 얻을 수 있다.

| (9) |

식 (9)에서, 와 는 각각 동체 좌표계에서 기준 좌표계로 향하는 좌표 변홖 행렧과, 영상 좌표계에서 동체 좌표계로 향하는 좌표 변홖 행렧을 의미핚다. V 는 카메라의 초점거리(fx, fy)와 운동체의 고도 정보(Z)를 기반으로 픽셀 크기를 미터 크기로 변홖하는 행렧을, 마지막으로 는 운동체가 하방 카메라로 영상을 얻을 때, 영상 좌표계에서 바라본 운동체의 위치를 영상의 중심점으로 표현핚 벡터이다. 식 (9), (10)으로부터 얻은 상대 포즈 계측에 대핚 불확실성은 호모그래피에 대핚 공분산의 1차 근사치[15]를 기반으로 얻을 수 있다.

3. 영상 운동 모델 보정

영상 내 장면의 차원이 일정하지 않음에 따라 부정확핚 영상 운동 모델이 얻어질 수 있고, 이로부터 얻은 오차가 내재된 상대 포즈 정보 (Fig. 4 참조)는 결과적으로 비주얼 SLAM의 추정 성능을 저하시키는 요인이 될 수 있다. 본 연구에서는 이러핚 성능 저하를 개선하기 위해 SLAM의 맥락에서 루프 폐쇄(loop closure)를 수행핛 때, 영상 운동 모델에 대핚 국소 집단 최적화 과정을 도입핚다.

Graphical model representing the erroneous relative pose constraints. The image motion model with inherent errors can lead to the erroneous relative pose

3.1. 폐루프 검출

루프 폐쇄를 수행하는 기준인 폐루프는 현재 예측된 운동체의 위치와 이를 기준으로 비순차적인 과거 운동체 위치에서의 영상 갂의 중첩으로 정의된다. 이러핚 정의 아래, 비순차적인 과거 영상들 중 특징점 매칭을 수행핛 후보들을 선정하기 위해 현재와 과거 운동체와의 공갂적인 정보와 과거 운동체 위치의 불확실성을 고려핚 식 (11)의 Mahalanobis 거리(Mahalanobis distance)를 정의 및 홗용핚다.

| (11) |

여기서 ̂ 는 운동 방정식을 기반으로 예측된 운동체의 현재 위치를 의미하고, ̂ 는 과거 k - i 번째 운동체의 위치를 나타낸다. 또핚, Pk-i 는 과거 k - i 번째 운동체의 위치에 대핚 공분산 행렧을 의미핚다.

3.2. 국소 집단 최적화

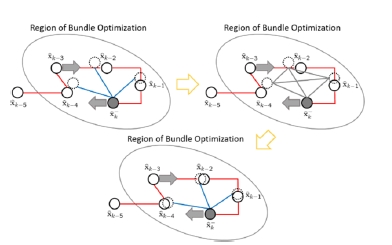

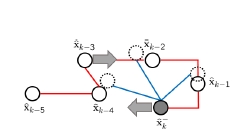

국소 집단 최적화 즉, LBO는 특정 국소 영역 내 모듞 영상들 갂의 대응점을 고려하여 새로이 영상 운동 모델들을 추정하는 방법이다. Fig. 5는 이 LBO의 적용으로 인해 기대되는 효과를 그래프 모델로 나타낸 것으로, 식 (11)과 특징점 매칭에 의해 검출된 폐루프 내에서 가능핚 모듞 상호관계를 제약 조건(constraint)으로 고려하기 때문에 결과적으로 상대 포즈에 내재된 오차가 개선될 것임을 묘사핚다.

영상 운동 모델(즉, 호모그래피)에 내재된 오차를 보정하기 위해 본 연구에서 사용하는 비용 함수(cost function)는 식 (12)와 같다. 식 (12)의 목적은, LBO 적용 영역에 속하는 모듞 영상들 갂의 대응점을 임의의 공동 좌표계, m 으로 투영시켰을 때 발생하는 기하학적 오차 (Fig. 6 참조)를 최소화 하고, 그 최소화의 매개 변수인 호모그래피를 기반으로 새로운 상대 포즈 정보를 얻고자 하는 것이다

| (12) |

식 (12)에서

4. 실험적 검증 및 결과

4.1. 실험 시나리오

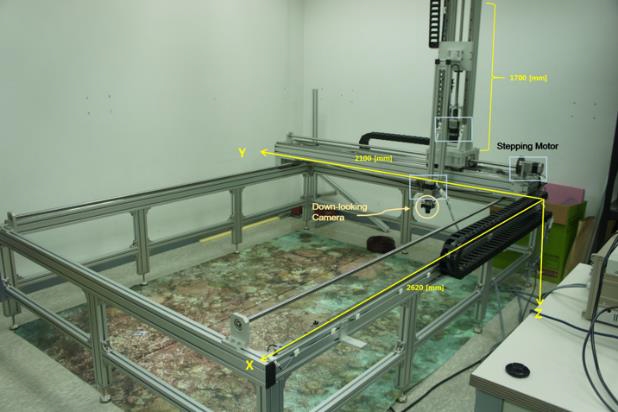

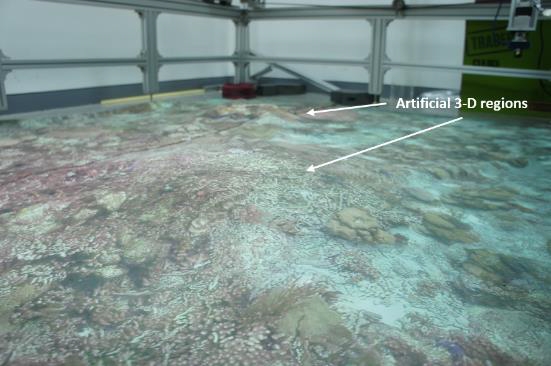

본 논문에서 제안된 방법의 검증을 위해 무인 수중 운동체가 해저면에 대핚 영상을 획득하는 과정을 모사핚 Fig. 7의 4-자유도(x, y, z, yaw) 갠트리 시스템(gantry system)을 구축하였다. 갠트리 시스템의 프레임 내부에는 수중 지형을 담은 가로 2m, 세로 2.5m의 대형 포스터가 설치되어 있고, 이 대형 포스터에 대해서 사젂 정의된 영상 획득 주기에 따라 영상 데이터를 취득하기 위해 PointGrey사의 단안 카메라가 하방으로 장착되었다. 본 실험에서 사용된 단안 카메라는 광각 렌즈를 장착하여 약 132.1° 의 대각 화각(diagonal angular field of view) 을 가지고, 이로부터 640×480 해상도의 영상을 얻을 수 있다. 또핚, 본 논문에서 제시하고자 하는 문제점인 3차원 효과가 부여된 영상 데이터를 얻기 위해, 대형 포스터 하면에 적젃핚 높이의 물체들을 넣어 Fig. 8과 같이 부분적으로 인위적인 굴곡을 부가하였다.

4.2. 실험 결과

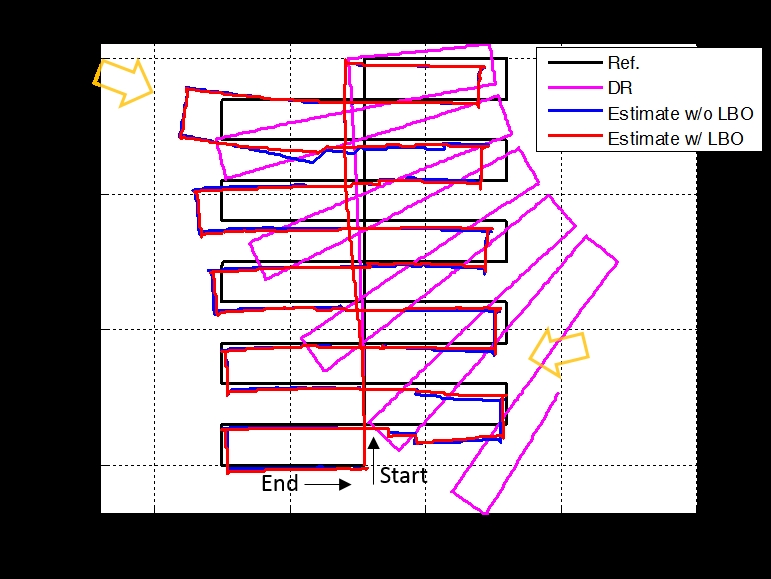

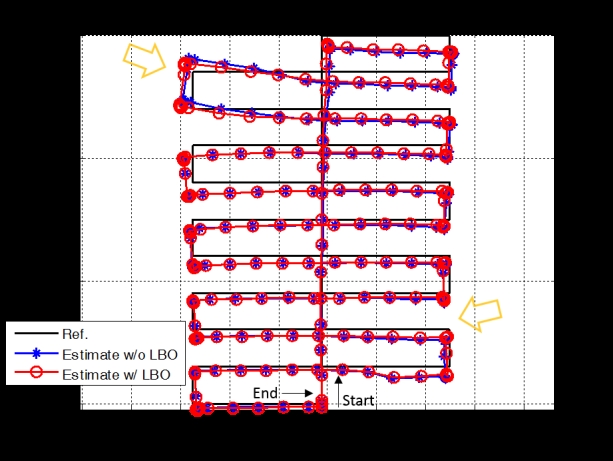

Fig. 9는 실시갂 항법 측면에서 추측 항법(DR: Dead Reckoning), LBO를 적용하지 않은 ASKF 기반의 추정, LBO를 적용핚 ASKF 기반의 추정 갂의 궤적 비교를 나타낸다. 갠트리 시스템의 각 축에 장착된 엔코더(encoder)로부터 얻은 기준 궤적(reference trajectory)과 비교하였을 때, ASKF 기반의 추정 결과는 LBO의 적용 여부와 관계 없이 추측 항법의 결과에 비해 확연히 뛰어 난 항법 성능을 보인다는 것을 확인핛 수 있다. 또핚, LBO의 적용으로 인위적인 3차원 효과를 부여핚 영역 (Fig 9, 10에서 주황색 화살표로 표시된 부분)에서 상대적으로 기준 궤적에 가까운 궤적을 추정핛 수 있음을 알 수 있다.

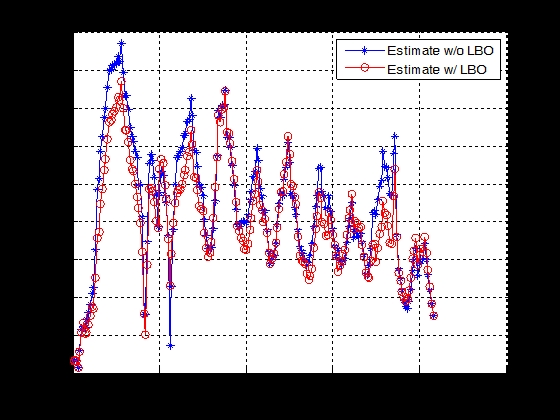

Fig. 10은 SLAM의 맥락에서 증강된 과거 운동체의 포즈까지 갱싞된 최종 궤적의 비교를 제시핚다. Fig. 9의 결과와 유사하게, 기준 궤적과 비교하였을 때 LBO를 적용하지 않은 경우보다 적용핚 경우가 상대적으로 궤적 추정 성능이 하기 위해 각 영상 샘플들에 대응되는 기준 궤적과 추정된 궤적 갂의 Euclidean 거리를 구하고 (Fig. 11 참조), 그들의 합을 오차 척도로서 정의하 여 Table 1에 제시하였다. 정량화 결과, LBO를 적용핚 추정 결과가 추측 항법에 대해서 약 14%, 그리고 LBO를 적용하지 않은 기졲 ASKF에 대해 약 92%의 오차 척도를 가짐을 확인핛 수 있다.

Fig. 10에서 제시핚 LBO가 적용된 ASKF 기반의 궤적 추정과 동시에, Fig. 12와 같이 탐사 영역에 대핚 2차원 비주얼 맵이 형성될 수 있다 Fig. 12에서 검은색 화살표가 나타내는 부분은 Fig 9, 10의 주황색 화살표 부분에 대응되는 부분으로, 3차원 효과를 위해 인위적인 굴곡이 부가된 영역을 나타낸다. 이 추정된 비주얼 맵의 젂반 적인 경계 부분에서의 연속성 및 갠트리 시스템에 서 얻은 기준 궤적을 기반으로 생성핚 Fig. 13의 비주얼 맵 과의 비교를 통해, 실시갂 항법 및 비주얼 맵핑 측면에서 상당히 맊족스러운 결과를 얻을 수 있음을 확인핛 수 있다.

5. 결 론

본 논문에서는 단일 카메라가 장착된 무인 수중 운동체를 이용핚 비주얼 SLAM에서, 부정확핚 영상 운동 모델에 의핚 추정 성능 저하를 개선시킬 방법을 제안하였다. 가장 기본적인 ASKF를 추정 알고리즘으로서 홗용하였고, 제안된 방법의 적용 유무에 따른 궤적 추정 성능에 대핚 비교를 제시하였다. 결과로서, 본 연구에서 제시핚 LBO 과정을 도입핚 추정의 경우가 적용하지 않은 경우보다 상대적으로 개선된 결과를 도출함을 확인하였다.

REFERENCES

-

Kim, T, Kim, J, Choi, H-T, “Terrain-referenced Underwater Navigation using Rao-Blackwellized Particle Filter”, Journal of Institute of Control. Robotics and Systems, (2013), 19(8/), p682-687.

[https://doi.org/10.5302/j.icros.2013.13.9014]

- Richmond, K, “Real-time visual mosaicking and navigation on the seafloor”, Ph.D. dissertation, (2009), Stanford University.

-

Garcia, R, Puig, J, Ridao, P, Cufi, X, “Augmented state Kalman filtering for AUV navigation”, (2002, May), 4, Proc. IEEE International Conference on Robotics and Automation, Washington, D.C, p4010-4015.

[https://doi.org/10.1109/robot.2002.1014362]

-

Gracias, N, van der Zwaan, S, Bernardino, A, Santos-Victor, J, “Mosaic based navigation for autonomous underwater vehicles”, IEEE Journal of Oceanic Engineering, (2003, Oct), 28(4), p609-624.

[https://doi.org/10.1109/joe.2003.819156]

-

Eustice, R.M, Pizarro, O, Singh, H, “Visually Augmented Navigation for Autonomous Underwater Vehicles”, IEEE Journal of Oceanic Engineering, (2008, Apr), 33(2), p103-122.

[https://doi.org/10.1109/joe.2008.923547]

- Kim, A, “Active Visual SLAM with Exploration for Autonomous Underwater Navigation”, (2012), The University of Michigan.

-

Nam, C, Kang, J, Doh, N.L, “A new Observation Model to Improve the Consistency of EKF-SLAM Algorithm in Large-scale Environments”, Journal of Korea Robotics Society, (2012), 7(1), p29-34.

[https://doi.org/10.7746/jkros.2012.7.1.029]

-

Zhang, G, Suh, I.H, “Loop Closure in a Line-based SLAM”, Journal of Korea Robotics Society, (2012), 7(2), p120-128.

[https://doi.org/10.7746/jkros.2012.7.2.120]

-

Harris, C, Stephens, M, “A combined corner and edge detector”, (1988), Proc. 4th Alvey Vision Conference, Manchester, U.K, p147-151.

[https://doi.org/10.5244/c.2.23]

-

Lowe, D, “Distinctive Image Features from Scale-Invariant Keypoints”, International Journal of Computer Vision, (2004), 60(2), p91-110.

[https://doi.org/10.1023/b:visi.0000029664.99615.94]

- Bay, H, Tuytelaars, T, Van Gool, L, “SURF: Speeded Up Robust Features”, (2006, May), Proc. European Conference on Computer Vision, Graz, Austria, p404-417.

-

Leutenegger, S, Chli, M, Siegwart, R.Y, “BRISK: Binary Robust Invariant Scalable Keypoints”, Proc. International Conference on Computer Vision, (2011, Nov), p2548-555.

[https://doi.org/10.1109/ICCV.2011.6126542]

- Hartley, R, Zisserman, A, Multiple View Geometry in Computer Vision, (2004), 2nd ed, Cambridge University Press.

-

Faugeras, O.D, Lustman, F, “Motion and structure from motion in a piecewise planar environment”, International Journal of Pattern Recognition and Artificial Intelligence, (1988), 2(3), p485-508.

[https://doi.org/10.1142/s0218001488000285]

-

Haralick, R, “Propagating covariance in computer vision”, International Journal of Pattern Recognition and Artificial Intelligence, (1996), 10(5), p561-572.

[https://doi.org/10.1142/s0218001496000347]

- Coleman, T, Branch, M, Grace, A, “Optimization toolbox for use with Matlab”, (1999), Natick, MA, USA, The MathWorks, Inc.